均值、中值和众数

从一组数字中我们可以学到什么?

在机器学习(和数学)中,通常存在三中我们感兴趣的值:

- 均值(Mean) - 平均值

- 中值(Median) - 中点值,又称中位数

- 众数(Mode) - 最常见的值

例如:我们已经登记了 13 辆车的速度:

speed = [99,86,87,88,111,86,103,87,94,78,77,85,86]

什么是平均,中间或最常见的速度值?

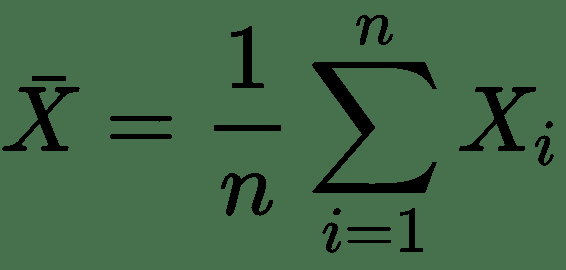

均值

均值就是平均值。

要计算平均值,请找到所有值的总和,然后将总和除以值的数量:

(99+86+87+88+111+86+103+87+94+78+77+85+86) / 13 = 89.77

NumPy 模块拥有用于此目的的方法:

实例

请使用 NumPy mean() 方法确定平均速度:

import numpy

speed = [99,86,87,88,111,86,103,87,94,78,77,85,86]

x = numpy.mean(speed)

print(x)

中值

中值是对所有值进行排序后的中间值:

77, 78, 85, 86, 86, 86, 87, 87, 88, 94, 99, 103, 111

在找到中位数之前,对数字进行排序很重要。

NumPy 模块拥有用于此目的的方法:

实例

请使用 NumPy median() 方法找到中间值:

import numpy

speed = [99,86,87,88,111,86,103,87,94,78,77,85,86]

x = numpy.median(speed)

print(x)

如果中间有两个数字,则将这些数字之和除以 2。

77, 78, 85, 86, 86, 86, 87, 87, 94, 98, 99, 103

(86 + 87) / 2 = 86.5

实例

使用 NumPy 模块:

import numpy

speed = [99,86,87,88,86,103,87,94,78,77,85,86]

x = numpy.median(speed)

print(x)

众数

众值是出现次数最多的值:

99, 86, 87, 88, 111, 86, 103, 87, 94, 78, 77, 85, 86 = 86

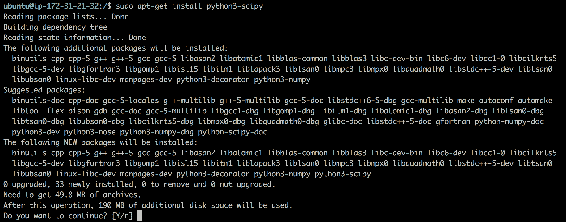

SciPy 模块拥有用于此目的的方法:

实例

请使用 SciPy mode() 方法查找出现次数最多的数字:

from scipy import stats

speed = [99,86,87,88,111,86,103,87,94,78,77,85,86]

x = stats.mode(speed)

print(x)

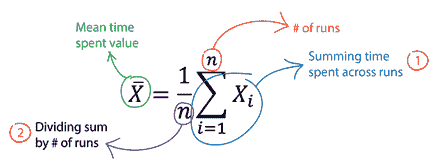

什么是标准差?

标准差(Standard Deviation,又常称均方差)是一个数字,描述值的离散程度。

低标准偏差表示大多数数字接近均值(平均值)。

高标准偏差表示这些值分布在更宽的范围内。

例如:这次我们已经登记了 7 辆车的速度:

speed = [86,87,88,86,87,85,86]

标准差是:

0.9

意味着大多数值在平均值的 0.9 范围内,即 86.4。

让我们对范围更广的数字集合进行处理:

speed = [32,111,138,28,59,77,97]

标准差是:

37.85

这意味着大多数值都在平均值(平均值为 77.4)的 37.85 范围内。

如您所见,较高的标准偏差表示这些值分布在较宽的范围内。

NumPy 模块有一种计算标准差的方法:

实例

请使用 NumPy std() 方法查找标准差:

import numpy

speed = [86,87,88,86,87,85,86]

x = numpy.std(speed)

print(x)

实例

import numpy

speed = [32,111,138,28,59,77,97]

x = numpy.std(speed)

print(x)

方差

方差是另一种数字,指示值的分散程度。

实际上,如果采用方差的平方根,则会得到标准差!

或反之,如果将标准偏差乘以自身,则会得到方差!

如需计算方差,您必须执行以下操作:

\1. 求均值:

(32+111+138+28+59+77+97) / 7 = 77.4

\2. 对于每个值:找到与平均值的差:

32 - 77.4 = -45.4

111 - 77.4 = 33.6

138 - 77.4 = 60.6

28 - 77.4 = -49.4

59 - 77.4 = -18.4

77 - 77.4 = - 0.4

97 - 77.4 = 19.6

\3. 对于每个差异:找到平方值:

(-45.4)2 = 2061.16

(33.6)2 = 1128.96

(60.6)2 = 3672.36

(-49.4)2 = 2440.36

(-18.4)2 = 338.56

(- 0.4)2 = 0.16

(19.6)2 = 384.16

\4. 方差是这些平方差的平均值:

(2061.16+1128.96+3672.36+2440.36+338.56+0.16+384.16) / 7 = 1432.2

幸运的是,NumPy 有一种计算方差的方法:

实例

使用 NumPy var() 方法确定方差:

import numpy

speed = [32,111,138,28,59,77,97]

x = numpy.var(speed)

print(x)

标准差

如我们所知,计算标准差的公式是方差的平方根:

√1432.25 = 37.85

或者,如上例所示,使用 NumPy 计算标准差:

实例

请使用 NumPy std() 方法查找标准差:

import numpy

speed = [32,111,138,28,59,77,97]

x = numpy.std(speed)

print(x)

符号

标准差通常用 Sigma 符号表示:σ

方差通常由 Sigma Square 符号 σ2 表示

什么是百分位数?

统计学中使用百分位数(Percentiles)为您提供一个数字,该数字描述了给定百分比值小于的值。

例如:假设我们有一个数组,包含住在一条街上的人的年龄。

ages = [5,31,43,48,50,41,7,11,15,39,80,82,32,2,8,6,25,36,27,61,31]

什么是 75 百分位数?答案是 43,这意味着 75% 的人是 43 岁或以下。

NumPy 模块有一种用于找到指定百分位数的方法:

实例

使用 NumPy percentile() 方法查找百分位数:

import numpy

ages = [5,31,43,48,50,41,7,11,15,39,80,82,32,2,8,6,25,36,27,61,31]

x = numpy.percentile(ages, 75)

print(x)

实例

90% 的人口年龄是多少岁?

import numpy

ages = [5,31,43,48,50,41,7,11,15,39,80,82,32,2,8,6,25,36,27,61,31]

x = numpy.percentile(ages, 90)

print(x)

数据分布(Data Distribution)

在本教程稍早之前,我们仅在例子中使用了非常少量的数据,目的是为了了解不同的概念。

在现实世界中,数据集要大得多,但是至少在项目的早期阶段,很难收集现实世界的数据。

我们如何获得大数据集?

为了创建用于测试的大数据集,我们使用 Python 模块 NumPy,该模块附带了许多创建任意大小的随机数据集的方法。

实例

创建一个包含 250 个介于 0 到 5 之间的随机浮点数的数组:

import numpy

x = numpy.random.uniform(0.0, 5.0, 250)

print(x)

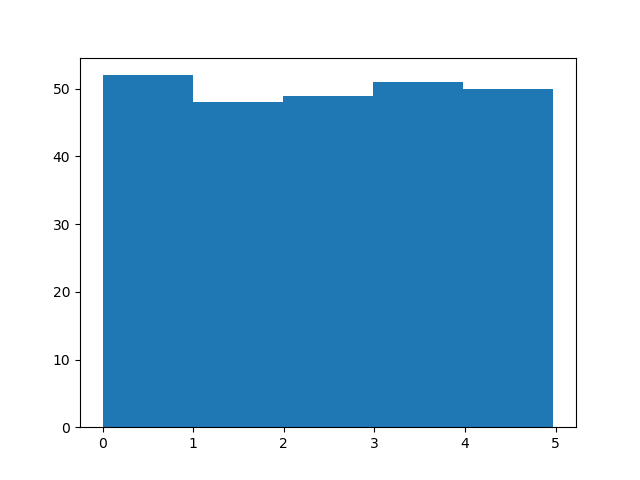

直方图

为了可视化数据集,我们可以对收集的数据绘制直方图。

我们将使用 Python 模块 Matplotlib 绘制直方图:

实例

绘制直方图:

import numpy

import matplotlib.pyplot as plt

x = numpy.random.uniform(0.0, 5.0, 250)

plt.hist(x, 5)

plt.show()

结果:

直方图解释

我们使用上例中的数组绘制 5 条柱状图。

第一栏代表数组中有多少 0 到 1 之间的值。

第二栏代表有多少 1 到 2 之间的数值。

等等。

我们得到的结果是:

52 values are between 0 and 1

48 values are between 1 and 2

49 values are between 2 and 3

51 values are between 3 and 4

50 values are between 4 and 5

**注释:**数组值是随机数,不会在您的计算机上显示完全相同的结果。

大数据分布

包含 250 个值的数组被认为不是很大,但是现在您知道了如何创建一个随机值的集,并且通过更改参数,可以创建所需大小的数据集。

实例

创建一个具有 100000 个随机数的数组,并使用具有 100 栏的直方图显示它们:

import numpy

import matplotlib.pyplot as plt

x = numpy.random.uniform(0.0, 5.0, 100000)

plt.hist(x, 100)

plt.show()

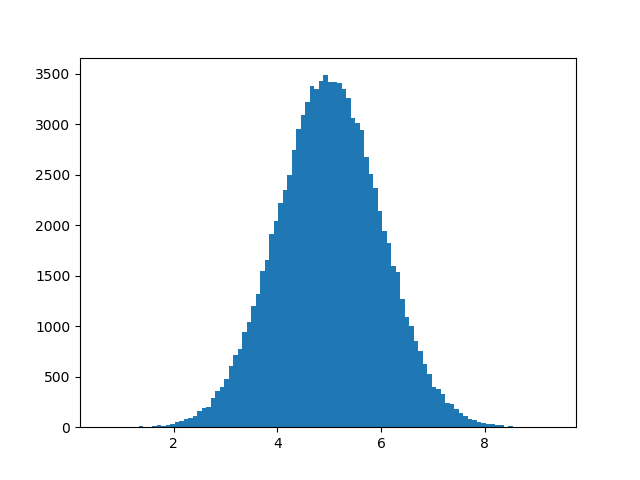

正态数据分布(Normal Data Distribution)

在上一章中,我们学习了如何创建给定大小且在两个给定值之间的完全随机数组。

在本章中,我们将学习如何创建一个将值集中在给定值周围的数组。

在概率论中,在数学家卡尔·弗里德里希·高斯(Carl Friedrich Gauss)提出了这种数据分布的公式之后,这种数据分布被称为正态数据分布或高斯数据分布。

实例

典型的正态数据分布:

import numpy

import matplotlib.pyplot as plt

x = numpy.random.normal(5.0, 1.0, 100000)

plt.hist(x, 100)

plt.show()

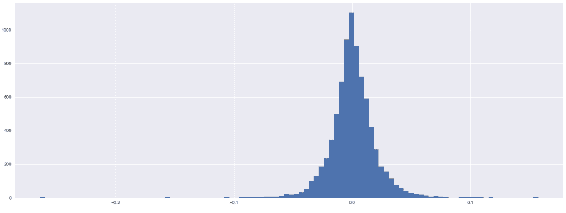

结果:

**注释:**由于正态分布图具有钟形的特征形状,因此也称为钟形曲线。

直方图解释

我们使用 numpy.random.normal() 方法创建的数组(具有 100000 个值)绘制具有 100 栏的直方图。

我们指定平均值为 5.0,标准差为 1.0。

这意味着这些值应集中在 5.0 左右,并且很少与平均值偏离 1.0。

从直方图中可以看到,大多数值都在 4.0 到 6.0 之间,最高值大约是 5.0。

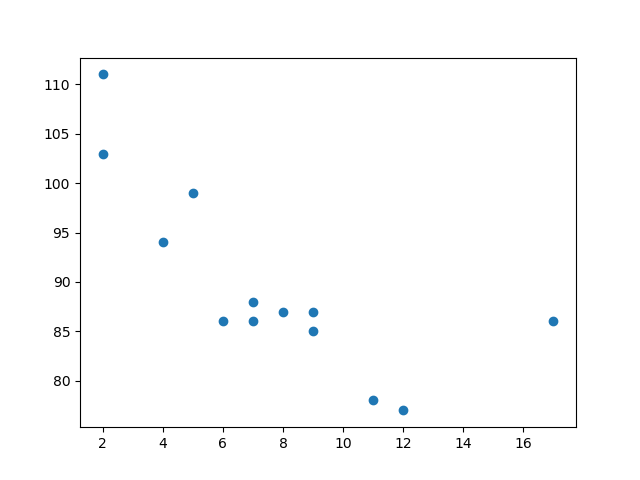

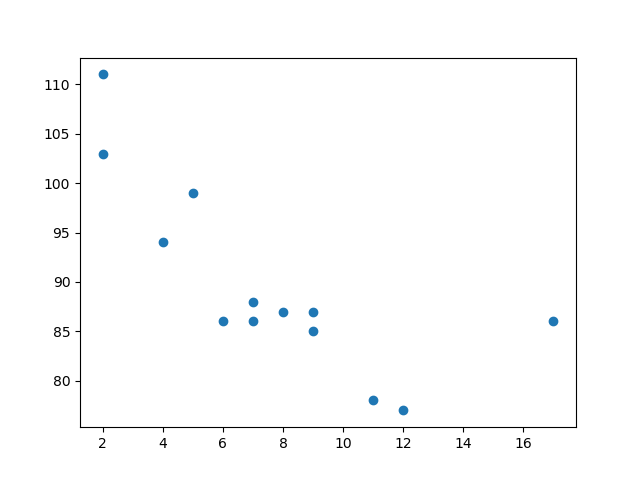

散点图(Scatter Plot)

散点图是数据集中的每个值都由点表示的图。

Matplotlib 模块有一种绘制散点图的方法,它需要两个长度相同的数组,一个数组用于 x 轴的值,另一个数组用于 y 轴的值:

x = [5,7,8,7,2,17,2,9,4,11,12,9,6]

y = [99,86,87,88,111,86,103,87,94,78,77,85,86]

x 数组代表每辆汽车的年龄。

y 数组表示每个汽车的速度。

实例

请使用 scatter() 方法绘制散点图:

import matplotlib.pyplot as plt

x = [5,7,8,7,2,17,2,9,4,11,12,9,6]

y = [99,86,87,88,111,86,103,87,94,78,77,85,86]

plt.scatter(x, y)

plt.show()

结果:

散点图解释

x 轴表示车龄,y 轴表示速度。

从图中可以看到,两辆最快的汽车都使用了 2 年,最慢的汽车使用了 12 年。

**注释:**汽车似乎越新,驾驶速度就越快,但这可能是一个巧合,毕竟我们只注册了 13 辆汽车。

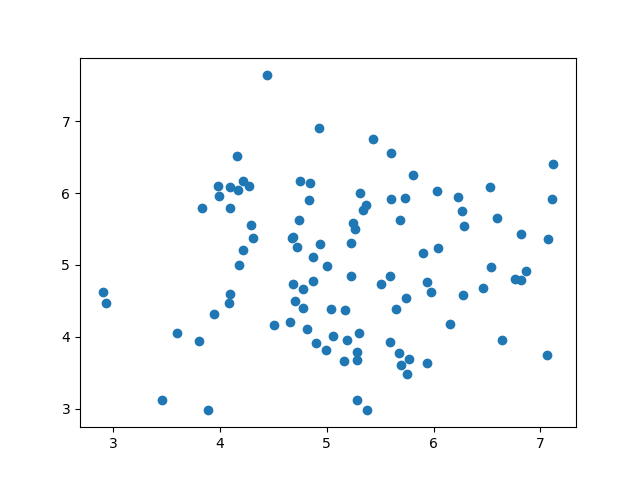

随机数据分布

在机器学习中,数据集可以包含成千上万甚至数百万个值。

测试算法时,您可能没有真实的数据,您可能必须使用随机生成的值。

正如我们在上一章中学到的那样,NumPy 模块可以帮助我们!

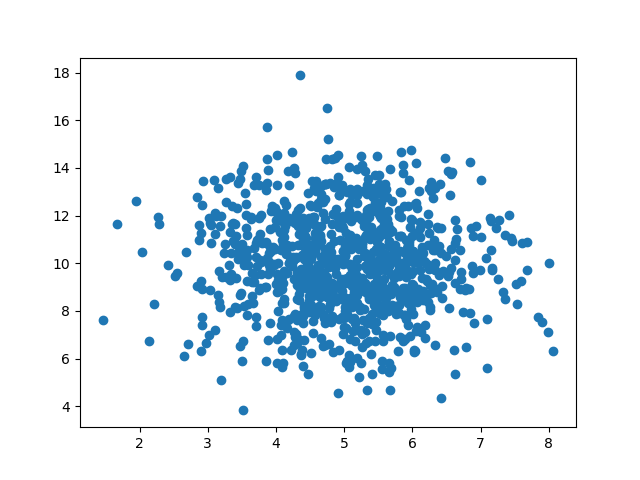

让我们创建两个数组,它们都填充有来自正态数据分布的 1000 个随机数。

第一个数组的平均值设置为 5.0,标准差为 1.0。

第二个数组的平均值设置为 10.0,标准差为 2.0:

实例

有 1000 个点的散点图:

import numpy

import matplotlib.pyplot as plt

x = numpy.random.normal(5.0, 1.0, 1000)

y = numpy.random.normal(10.0, 2.0, 1000)

plt.scatter(x, y)

plt.show()

结果:

散点图解释

我们可以看到,点集中在 x 轴上的值 5 和 y 轴上的 10 周围。

我们还可以看到,在 y 轴上扩散得比在 x 轴上更大。

回归

当您尝试找到变量之间的关系时,会用到术语“回归”(regression)。

在机器学习和统计建模中,这种关系用于预测未来事件的结果。

线性回归

线性回归使用数据点之间的关系在所有数据点之间画一条直线。

这条线可以用来预测未来的值。

在机器学习中,预测未来非常重要。

工作原理

Python 提供了一些方法来查找数据点之间的关系并绘制线性回归线。我们将向您展示如何使用这些方法而不是通过数学公式。

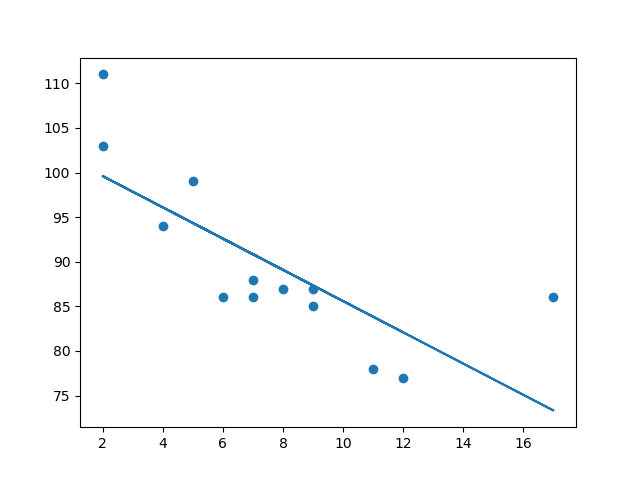

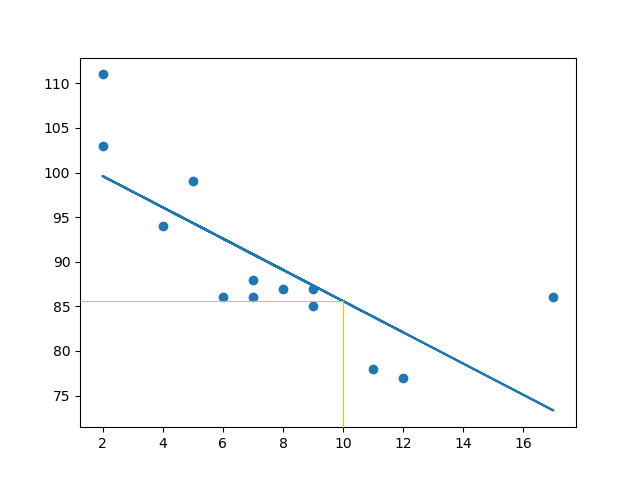

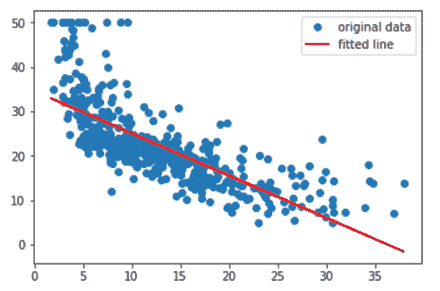

在下面的示例中,x 轴表示车龄,y 轴表示速度。我们已经记录了 13 辆汽车通过收费站时的车龄和速度。让我们看看我们收集的数据是否可以用于线性回归:

实例

首先绘制散点图:

import matplotlib.pyplot as plt

x = [5,7,8,7,2,17,2,9,4,11,12,9,6]

y = [99,86,87,88,111,86,103,87,94,78,77,85,86]

plt.scatter(x, y)

plt.show()

结果:

实例

导入 scipy 并绘制线性回归线:

import matplotlib.pyplot as plt

from scipy import stats

x = [5,7,8,7,2,17,2,9,4,11,12,9,6]

y = [99,86,87,88,111,86,103,87,94,78,77,85,86]

slope, intercept, r, p, std_err = stats.linregress(x, y)

def myfunc(x):

return slope * x + intercept

mymodel = list(map(myfunc, x))

plt.scatter(x, y)

plt.plot(x, mymodel)

plt.show()

结果:

例子解释

导入所需模块:

import matplotlib.pyplot as plt

from scipy import stats

创建表示 x 和 y 轴值的数组:

x = [5,7,8,7,2,17,2,9,4,11,12,9,6]

y = [99,86,87,88,111,86,103,87,94,78,77,85,86]

执行一个方法,该方法返回线性回归的一些重要键值:

slope, intercept, r, p, std_err = stats.linregress(x, y)

创建一个使用 slope 和 intercept 值的函数返回新值。这个新值表示相应的 x 值将在 y 轴上放置的位置:

def myfunc(x):

return slope * x + intercept

通过函数运行 x 数组的每个值。这将产生一个新的数组,其中的 y 轴具有新值:

mymodel = list(map(myfunc, x))

绘制原始散点图:

plt.scatter(x, y)

绘制线性回归线:

plt.plot(x, mymodel)

显示图:

plt.show()

R-Squared

重要的是要知道 x 轴的值和 y 轴的值之间的关系有多好,如果没有关系,则线性回归不能用于预测任何东西。

该关系用一个称为 r 平方(r-squared)的值来度量。

r 平方值的范围是 0 到 1,其中 0 表示不相关,而 1 表示 100% 相关。

Python 和 Scipy 模块将为您计算该值,您所要做的就是将 x 和 y 值提供给它:

实例

我的数据在线性回归中的拟合度如何?

from scipy import stats

x = [5,7,8,7,2,17,2,9,4,11,12,9,6]

y = [99,86,87,88,111,86,103,87,94,78,77,85,86]

slope, intercept, r, p, std_err = stats.linregress(x, y)

print(r)

**注释:**结果 -0.76 表明存在某种关系,但不是完美的关系,但它表明我们可以在将来的预测中使用线性回归。

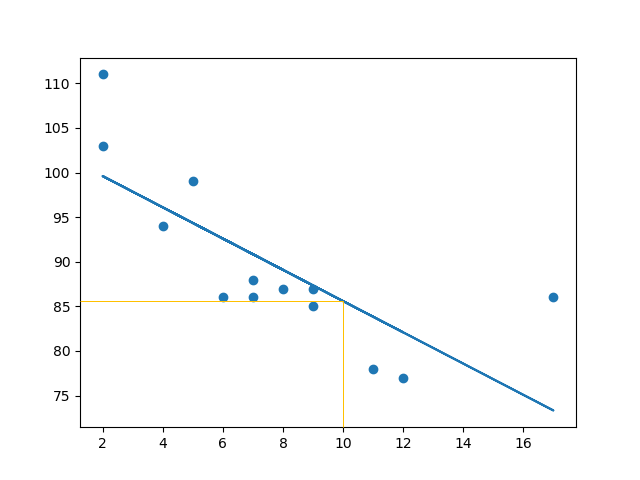

预测未来价值

现在,我们可以使用收集到的信息来预测未来的值。

例如:让我们尝试预测一辆拥有 10 年历史的汽车的速度。

为此,我们需要与上例中相同的 myfunc() 函数:

def myfunc(x):

return slope * x + intercept

实例

预测一辆有 10年车龄的汽车的速度:

from scipy import stats

x = [5,7,8,7,2,17,2,9,4,11,12,9,6]

y = [99,86,87,88,111,86,103,87,94,78,77,85,86]

slope, intercept, r, p, std_err = stats.linregress(x, y)

def myfunc(x):

return slope * x + intercept

speed = myfunc(10)

print(speed)

该例预测速度为 85.6,我们也可以从图中读取:

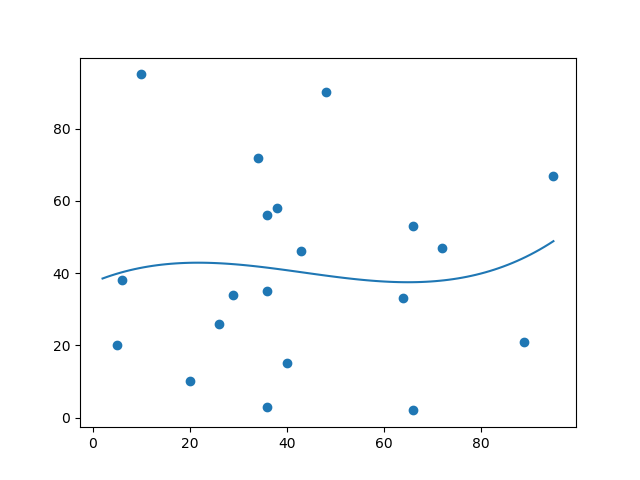

糟糕的拟合度?

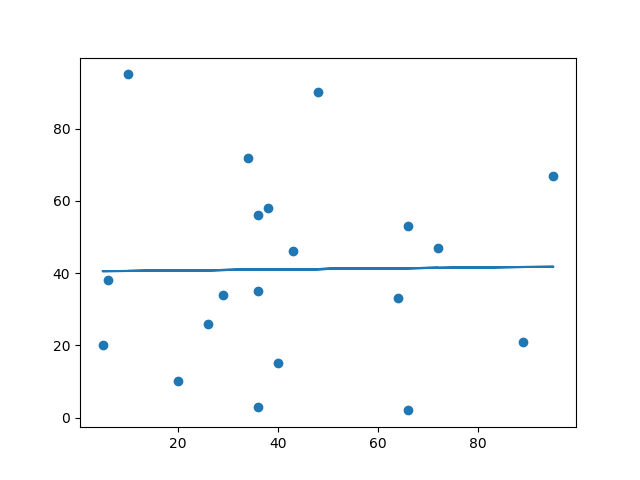

让我们创建一个实例,其中的线性回归并不是预测未来值的最佳方法。

实例

x 和 y 轴的这些值将导致线性回归的拟合度非常差:

import matplotlib.pyplot as plt

from scipy import stats

x = [89,43,36,36,95,10,66,34,38,20,26,29,48,64,6,5,36,66,72,40]

y = [21,46,3,35,67,95,53,72,58,10,26,34,90,33,38,20,56,2,47,15]

slope, intercept, r, p, std_err = stats.linregress(x, y)

def myfunc(x):

return slope * x + intercept

mymodel = list(map(myfunc, x))

plt.scatter(x, y)

plt.plot(x, mymodel)

plt.show()

结果:

以及 r-squared 值?

实例

您应该得到了一个非常低的 r-squared 值。

import numpy

from scipy import stats

x = [89,43,36,36,95,10,66,34,38,20,26,29,48,64,6,5,36,66,72,40]

y = [21,46,3,35,67,95,53,72,58,10,26,34,90,33,38,20,56,2,47,15]

slope, intercept, r, p, std_err = stats.linregress(x, y)

print(r)

结果:0.013 表示关系很差,并告诉我们该数据集不适合线性回归。

多项式回归(Polynomial Regression)

如果您的数据点显然不适合线性回归(穿过数据点之间的直线),那么多项式回归可能是理想的选择。

像线性回归一样,多项式回归使用变量 x 和 y 之间的关系来找到绘制数据点线的最佳方法。

工作原理

Python 有一些方法可以找到数据点之间的关系并画出多项式回归线。我们将向您展示如何使用这些方法而不是通过数学公式。

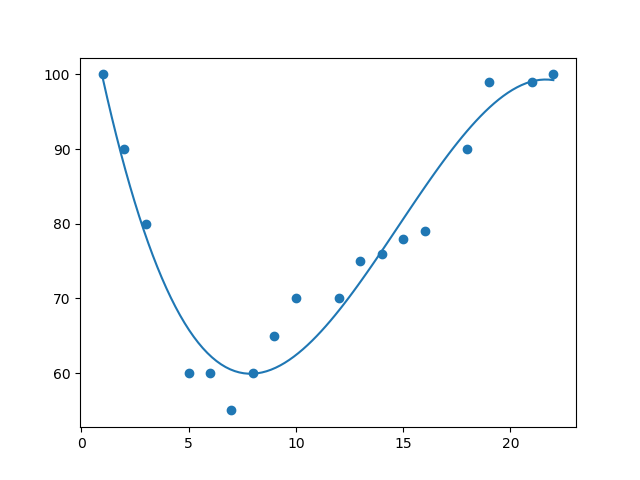

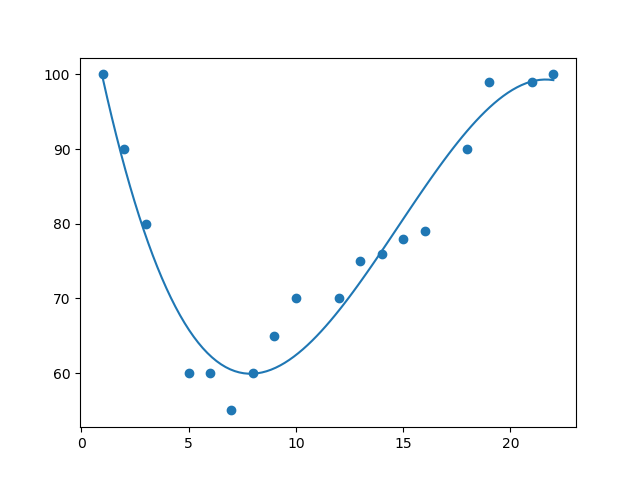

在下面的例子中,我们注册了 18 辆经过特定收费站的汽车。

我们已经记录了汽车的速度和通过时间(小时)。

x 轴表示一天中的小时,y 轴表示速度:

实例

首先绘制散点图:

import matplotlib.pyplot as plt

x = [1,2,3,5,6,7,8,9,10,12,13,14,15,16,18,19,21,22]

y = [100,90,80,60,60,55,60,65,70,70,75,76,78,79,90,99,99,100]

plt.scatter(x, y)

plt.show()

结果:

实例

导入 numpy 和 matplotlib,然后画出多项式回归线:

import numpy

import matplotlib.pyplot as plt

x = [1,2,3,5,6,7,8,9,10,12,13,14,15,16,18,19,21,22]

y = [100,90,80,60,60,55,60,65,70,70,75,76,78,79,90,99,99,100]

mymodel = numpy.poly1d(numpy.polyfit(x, y, 3))

myline = numpy.linspace(1, 22, 100)

plt.scatter(x, y)

plt.plot(myline, mymodel(myline))

plt.show()

结果:

例子解释

导入所需模块:

import numpy

import matplotlib.pyplot as plt

创建表示 x 和 y 轴值的数组:

x = [1,2,3,5,6,7,8,9,10,12,13,14,15,16,18,19,21,22]

y = [100,90,80,60,60,55,60,65,70,70,75,76,78,79,90,99,99,100]

NumPy 有一种方法可以让我们建立多项式模型:

mymodel = numpy.poly1d(numpy.polyfit(x, y, 3))

然后指定行的显示方式,我们从位置 1 开始,到位置 22 结束:

myline = numpy.linspace(1, 22, 100)

绘制原始散点图:

plt.scatter(x, y)

画出多项式回归线:

plt.plot(myline, mymodel(myline))

显示图表:

plt.show()

R-Squared

重要的是要知道 x 轴和 y 轴的值之间的关系有多好,如果没有关系,则多项式回归不能用于预测任何东西。

该关系用一个称为 r 平方( r-squared)的值来度量。

r 平方值的范围是 0 到 1,其中 0 表示不相关,而 1 表示 100% 相关。

Python 和 Sklearn 模块将为您计算该值,您所要做的就是将 x 和 y 数组输入:

实例

我的数据在多项式回归中的拟合度如何?

import numpy

from sklearn.metrics import r2_score

x = [1,2,3,5,6,7,8,9,10,12,13,14,15,16,18,19,21,22]

y = [100,90,80,60,60,55,60,65,70,70,75,76,78,79,90,99,99,100]

mymodel = numpy.poly1d(numpy.polyfit(x, y, 3))

print(r2_score(y, mymodel(x)))

**注释:**结果 0.94 表明存在很好的关系,我们可以在将来的预测中使用多项式回归。

预测未来值

现在,我们可以使用收集到的信息来预测未来的值。

例如:让我们尝试预测在晚上 17 点左右通过收费站的汽车的速度:

为此,我们需要与上面的实例相同的 mymodel 数组:

mymodel = numpy.poly1d(numpy.polyfit(x, y, 3))

实例

预测下午 17 点过车的速度:

import numpy

from sklearn.metrics import r2_score

x = [1,2,3,5,6,7,8,9,10,12,13,14,15,16,18,19,21,22]

y = [100,90,80,60,60,55,60,65,70,70,75,76,78,79,90,99,99,100]

mymodel = numpy.poly1d(numpy.polyfit(x, y, 3))

speed = mymodel(17)

print(speed)

该例预测速度为 88.87,我们也可以在图中看到:

糟糕的拟合度?

让我们创建一个实例,其中多项式回归不是预测未来值的最佳方法。

实例

x 和 y 轴的这些值会导致多项式回归的拟合度非常差:

import numpy

import matplotlib.pyplot as plt

x = [89,43,36,36,95,10,66,34,38,20,26,29,48,64,6,5,36,66,72,40]

y = [21,46,3,35,67,95,53,72,58,10,26,34,90,33,38,20,56,2,47,15]

mymodel = numpy.poly1d(numpy.polyfit(x, y, 3))

myline = numpy.linspace(2, 95, 100)

plt.scatter(x, y)

plt.plot(myline, mymodel(myline))

plt.show()

结果:

r-squared 值呢?

实例

您应该得到一个非常低的 r-squared 值。

import numpy

from sklearn.metrics import r2_score

x = [89,43,36,36,95,10,66,34,38,20,26,29,48,64,6,5,36,66,72,40]

y = [21,46,3,35,67,95,53,72,58,10,26,34,90,33,38,20,56,2,47,15]

mymodel = numpy.poly1d(numpy.polyfit(x, y, 3))

print(r2_score(y, mymodel(x)))

结果:0.00995 表示关系很差,并告诉我们该数据集不适合多项式回归。

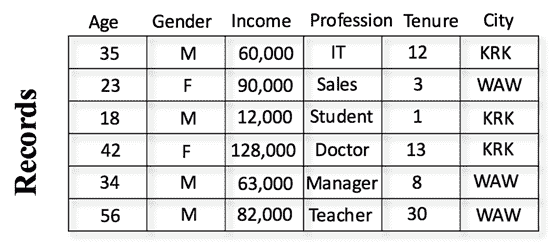

多元回归(Multiple Regression)

多元回归就像线性回归一样,但是具有多个独立值,这意味着我们试图基于两个或多个变量来预测一个值。

请看下面的数据集,其中包含了一些有关汽车的信息。

| Car | Model | Volume | Weight | CO2 |

|---|---|---|---|---|

| Toyota | Aygo | 1000 | 790 | 99 |

| Mitsubishi | Space Star | 1200 | 1160 | 95 |

| Skoda | Citigo | 1000 | 929 | 95 |

| … | … | … | … | … |

我们可以根据发动机排量的大小预测汽车的二氧化碳排放量,但是通过多元回归,我们可以引入更多变量,例如汽车的重量,以使预测更加准确。

工作原理

在 Python 中,我们拥有可以完成这项工作的模块。首先导入 Pandas 模块:

import pandas

Pandas 模块允许我们读取 csv 文件并返回一个 DataFrame 对象。

此文件仅用于测试目的,您可以在此处下载:cars.csv

df = pandas.read_csv("cars.csv")

然后列出独立值,并将这个变量命名为 X。

将相关值放入名为 y 的变量中。

X = df[['Weight', 'Volume']]

y = df['CO2']

**提示:**通常,将独立值列表命名为大写 X,将相关值列表命名为小写 y。

我们将使用 sklearn 模块中的一些方法,因此我们也必须导入该模块:

from sklearn import linear_model

在 sklearn 模块中,我们将使用 LinearRegression() 方法创建一个线性回归对象。

该对象有一个名为 fit() 的方法,该方法将独立值和从属值作为参数,并用描述这种关系的数据填充回归对象:

regr = linear_model.LinearRegression()

regr.fit(X, y)

现在,我们有了一个回归对象,可以根据汽车的重量和排量预测 CO2 值:

# 预测重量为 2300kg、排量为 1300ccm 的汽车的二氧化碳排放量:

predictedCO2 = regr.predict([[2300, 1300]])

实例

请看完整实例:

import pandas

from sklearn import linear_model

df = pandas.read_csv("cars.csv")

X = df[['Weight', 'Volume']]

y = df['CO2']

regr = linear_model.LinearRegression()

regr.fit(X, y)

# 预测重量为 2300kg、排量为 1300ccm 的汽车的二氧化碳排放量:

predictedCO2 = regr.predict([[2300, 1300]])

print(predictedCO2)

结果:

[107.2087328]

我们预测,配备 1.3 升发动机,重量为 2300 千克的汽车,每行驶 1 公里,就会释放约 107 克二氧化碳。

系数

系数是描述与未知变量的关系的因子。

例如:如果 x 是变量,则 2x 是 x 的两倍。x 是未知变量,数字 2 是系数。

在这种情况下,我们可以要求重量相对于 CO2 的系数值,以及体积相对于 CO2 的系数值。我们得到的答案告诉我们,如果我们增加或减少其中一个独立值,将会发生什么。

实例

打印回归对象的系数值:

import pandas

from sklearn import linear_model

df = pandas.read_csv("cars.csv")

X = df[['Weight', 'Volume']]

y = df['CO2']

regr = linear_model.LinearRegression()

regr.fit(X, y)

print(regr.coef_)

结果:

[0.00755095 0.00780526]

结果解释

结果数组表示重量和排量的系数值。

Weight: 0.00755095

Volume: 0.00780526

这些值告诉我们,如果重量增加 1g,则 CO2 排放量将增加 0.00755095g。

如果发动机尺寸(容积)增加 1 ccm,则 CO2 排放量将增加 0.00780526g。

我认为这是一个合理的猜测,但还是请进行测试!

我们已经预言过,如果一辆配备 1300ccm 发动机的汽车重 2300 千克,则二氧化碳排放量将约为 107 克。

如果我们增加 1000g 的重量会怎样?

实例

复制之前的例子,但是将车重从 2300 更改为 3300:

import pandas

from sklearn import linear_model

df = pandas.read_csv("cars.csv")

X = df[['Weight', 'Volume']]

y = df['CO2']

regr = linear_model.LinearRegression()

regr.fit(X, y)

predictedCO2 = regr.predict([[3300, 1300]])

print(predictedCO2)

结果:

[114.75968007]

我们已经预测,配备 1.3 升发动机,重量为 3.3 吨的汽车,每行驶 1 公里,就会释放约 115 克二氧化碳。

这表明 0.00755095 的系数是正确的:

107.2087328 + (1000 * 0.00755095) = 114.75968

特征缩放(Scale Features)

当您的数据拥有不同的值,甚至使用不同的度量单位时,可能很难比较它们。与米相比,公斤是多少?或者海拔比较时间呢?

这个问题的答案是缩放。我们可以将数据缩放为易于比较的新值。

请看下表,它与我们在多元回归一章中使用的数据集相同,但是这次,Volume 列包含的单位是升,而不是 ccm(1.0 而不是 1000)。

很难将排量 1.0 与车重 790 进行比较,但是如果将它们都缩放为可比较的值,我们可以很容易地看到一个值与另一个值相比有多少。

缩放数据有多种方法,在本教程中,我们将使用一种称为标准化(standardization)的方法。

标准化方法使用以下公式:

z = (x - u) / s

其中 z 是新值,x 是原始值,u 是平均值,s 是标准差。

如果从上述数据集中获取 weight 列,则第一个值为 790,缩放后的值为:

(790 - 1292.23) / 238.74 = -2.1

如果从上面的数据集中获取 volume 列,则第一个值为 1.0,缩放后的值为:

(1.0 - 1.61) / 0.38 = -1.59

现在,您可以将 -2.1 与 -1.59 相比较,而不是比较 790 与 1.0。

您不必手动执行此操作,Python sklearn 模块有一个名为 StandardScaler() 的方法,该方法返回带有转换数据集方法的 Scaler 对象。

实例

缩放 Weight 和 Volume 列中的所有值:

import pandas

from sklearn import linear_model

from sklearn.preprocessing import StandardScaler

scale = StandardScaler()

df = pandas.read_csv("cars2.csv")

X = df[['Weight', 'Volume']]

scaledX = scale.fit_transform(X)

print(scaledX)

结果:

请注意,前两个值是 -2.1 和 -1.59,与我们的计算相对应:

[[-2.10389253 -1.59336644]

[-0.55407235 -1.07190106]

...

[ 0.47215993 -0.0289703 ]

[ 0.4302729 2.31762392]]

预测 CO2 值

多元回归一章的任务是在仅知道汽车的重量和排量的情况下预测其排放的二氧化碳。

缩放数据集后,在预测值时必须使用缩放比例:

实例

预测一辆重 2300 公斤的 1.3 升汽车的二氧化碳排放量:

import pandas

from sklearn import linear_model

from sklearn.preprocessing import StandardScaler

scale = StandardScaler()

df = pandas.read_csv("cars2.csv")

X = df[['Weight', 'Volume']]

y = df['CO2']

scaledX = scale.fit_transform(X)

regr = linear_model.LinearRegression()

regr.fit(scaledX, y)

scaled = scale.transform([[2300, 1.3]])

predictedCO2 = regr.predict([scaled[0]])

print(predictedCO2)

结果:

[107.2087328]

评估模型

在机器学习中,我们创建模型来预测某些事件的结果,就像在上一章中当我们了解重量和发动机排量时,预测了汽车的二氧化碳排放量一样。

要衡量模型是否足够好,我们可以使用一种称为训练/测试的方法。

什么是训练/测试

训练/测试是一种测量模型准确性的方法。

之所以称为训练/测试,是因为我们将数据集分为两组:训练集和测试集。

80% 用于训练,20% 用于测试。

您可以使用训练集来训练模型。

您可以使用测试集来测试模型。

训练模型意味着创建模型。

测试模型意味着测试模型的准确性。

从数据集开始

从要测试的数据集开始。

我们的数据集展示了商店中的 100 位顾客及其购物习惯。

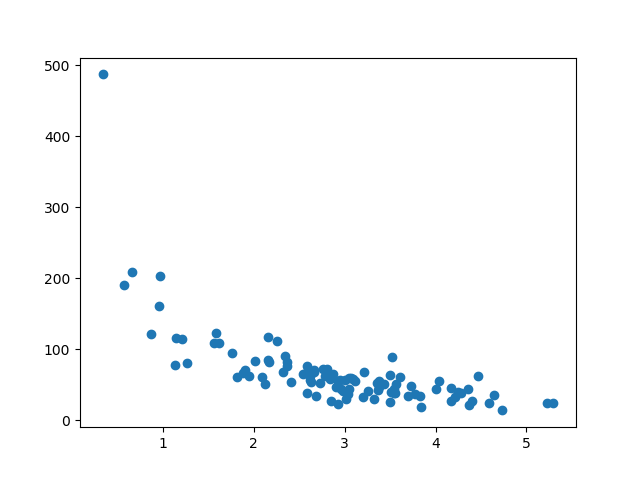

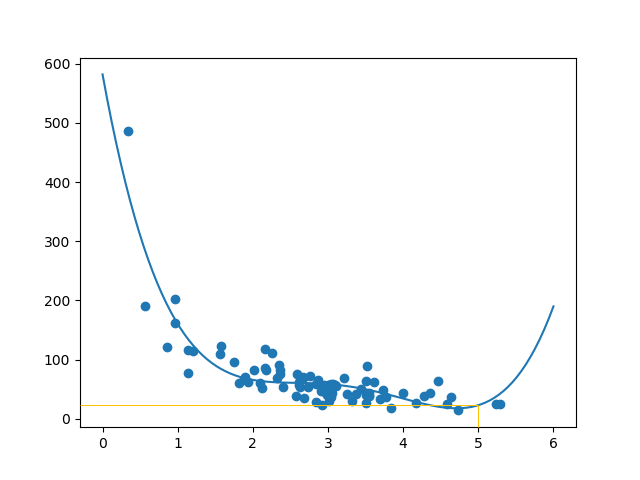

实例

import numpy

import matplotlib.pyplot as plt

numpy.random.seed(2)

x = numpy.random.normal(3, 1, 100)

y = numpy.random.normal(150, 40, 100) / x

plt.scatter(x, y)

plt.show()

结果:

x 轴表示购买前的分钟数。

y 轴表示在购买上花费的金额。

拆分训练/测试

训练集应该是原始数据的 80% 的随机选择。

测试集应该是剩余的 20%。

train_x = x[:80]

train_y = y[:80]

test_x = x[80:]

test_y = y[80:]

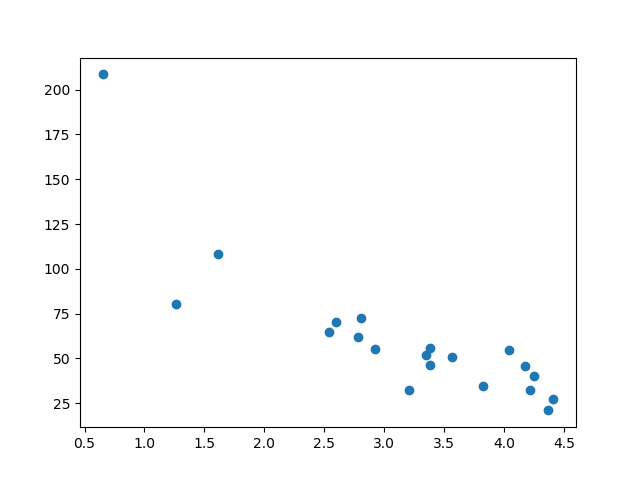

显示训练集

显示与训练集相同的散点图:

实例

plt.scatter(train_x, train_y)

plt.show()

结果:

它看起来像原始数据集,因此似乎是一个合理的选择:

显示测试集

为了确保测试集不是完全不同,我们还要看一下测试集。

实例

plt.scatter(test_x, test_y)

plt.show()

结果:

测试集也看起来像原始数据集:

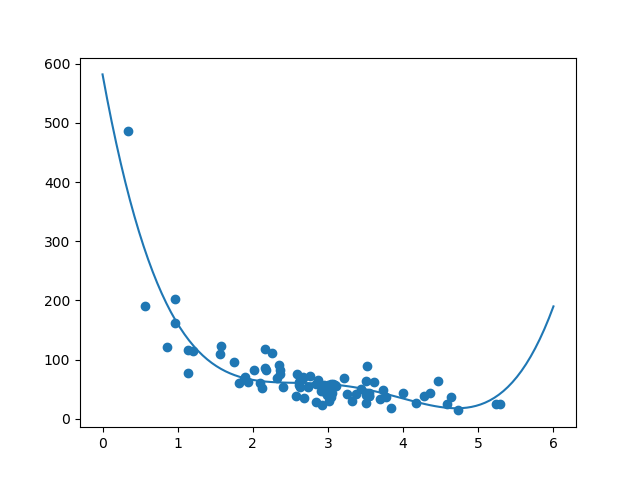

拟合数据集

数据集是什么样的?我认为最合适拟合的是多项式回归,因此让我们画一条多项式回归线。

要通过数据点画一条线,我们使用 matplotlib 模块的 plott() 方法:

实例

绘制穿过数据点的多项式回归线:

import numpy

import matplotlib.pyplot as plt

numpy.random.seed(2)

x = numpy.random.normal(3, 1, 100)

y = numpy.random.normal(150, 40, 100) / x

train_x = x[:80]

train_y = y[:80]

test_x = x[80:]

test_y = y[80:]

mymodel = numpy.poly1d(numpy.polyfit(train_x, train_y, 4))

myline = numpy.linspace(0, 6, 100)

plt.scatter(train_x, train_y)

plt.plot(myline, mymodel(myline))

plt.show()

结果:

此结果可以支持我们对数据集拟合多项式回归的建议,即使如果我们尝试预测数据集之外的值会给我们带来一些奇怪的结果。例如:该行表明某位顾客在商店购物 6 分钟,会完成一笔价值 200 的购物。这可能是过拟合的迹象。

但是 R-squared 分数呢? R-squared score很好地指示了我的数据集对模型的拟合程度。

R2

还记得 R2,也称为 R平方(R-squared)吗?

它测量 x 轴和 y 轴之间的关系,取值范围从 0 到 1,其中 0 表示没有关系,而 1 表示完全相关。

sklearn 模块有一个名为 rs_score() 的方法,该方法将帮助我们找到这种关系。

在这里,我们要衡量顾客在商店停留的时间与他们花费多少钱之间的关系。

实例

我们的训练数据在多项式回归中的拟合度如何?

import numpy

from sklearn.metrics import r2_score

numpy.random.seed(2)

x = numpy.random.normal(3, 1, 100)

y = numpy.random.normal(150, 40, 100) / x

train_x = x[:80]

train_y = y[:80]

test_x = x[80:]

test_y = y[80:]

mymodel = numpy.poly1d(numpy.polyfit(train_x, train_y, 4))

r2 = r2_score(train_y, mymodel(train_x))

print(r2)

**注释:**结果 0.799 显示关系不错。

引入测试集

现在,至少在训练数据方面,我们已经建立了一个不错的模型。

然后,我们要使用测试数据来测试模型,以检验是否给出相同的结果。

实例

让我们在使用测试数据时确定 R2 分数:

import numpy

from sklearn.metrics import r2_score

numpy.random.seed(2)

x = numpy.random.normal(3, 1, 100)

y = numpy.random.normal(150, 40, 100) / x

train_x = x[:80]

train_y = y[:80]

test_x = x[80:]

test_y = y[80:]

mymodel = numpy.poly1d(numpy.polyfit(train_x, train_y, 4))

r2 = r2_score(test_y, mymodel(test_x))

print(r2)

**注释:**结果 0.809 表明该模型也适合测试集,我们确信可以使用该模型预测未来值。

预测值

现在我们已经确定我们的模型是不错的,可以开始预测新值了。

实例

如果购买客户在商店中停留 5 分钟,他/她将花费多少钱?

print(mymodel(5))

该例预测客户花费了 22.88 美元,似乎与图表相对应:

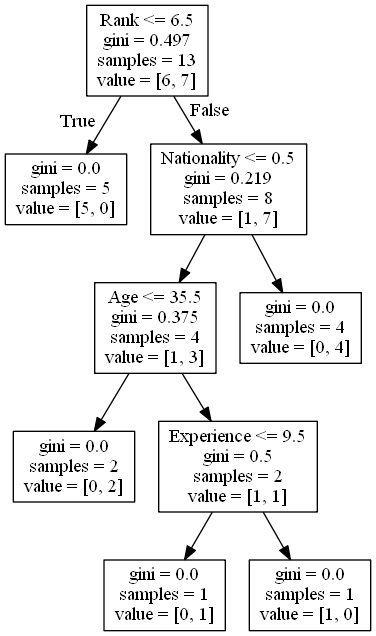

决策树(Decision Tree)

在本章中,我们将向您展示如何制作“决策树”。决策树是一种流程图,可以帮助您根据以前的经验进行决策。

在这个例子中,一个人将尝试决定他/她是否应该参加喜剧节目。

幸运的是,我们的例中人物每次在镇上举办喜剧节目时都进行注册,并注册一些关于喜剧演员的信息,并且还登记了他/她是否去过。

| Age | Experience | Rank | Nationality | Go |

|---|---|---|---|---|

| 36 | 10 | 9 | UK | NO |

| 42 | 12 | 4 | USA | NO |

| 23 | 4 | 6 | N | NO |

| 52 | 4 | 4 | USA | NO |

| 43 | 21 | 8 | USA | YES |

| 44 | 14 | 5 | UK | NO |

| 66 | 3 | 7 | N | YES |

| 35 | 14 | 9 | UK | YES |

| 52 | 13 | 7 | N | YES |

| 35 | 5 | 9 | N | YES |

| 24 | 3 | 5 | USA | NO |

| 18 | 3 | 7 | UK | YES |

| 45 | 9 | 9 | UK | YES |

现在,基于此数据集,Python 可以创建决策树,这个决策树可用于决定是否值得参加任何新的演出。

工作原理

首先,导入所需的模块,并使用 pandas 读取数据集:

实例

读取并打印数据集:

import pandas

from sklearn import tree

import pydotplus

from sklearn.tree import DecisionTreeClassifier

import matplotlib.pyplot as plt

import matplotlib.image as pltimg

df = pandas.read_csv("shows.csv")

print(df)

如需制作决策树,所有数据都必须是数字。

我们必须将非数字列 “Nationality” 和 “Go” 转换为数值。

Pandas 有一个 map() 方法,该方法接受字典,其中包含有关如何转换值的信息。

{‘UK’: 0, ‘USA’: 1, ‘N’: 2}

表示将值 ‘UK’ 转换为 0,将 ‘USA’ 转换为 1,将 ‘N’ 转换为 2。

实例

将字符串值更改为数值:

d = {'UK': 0, 'USA': 1, 'N': 2}

df['Nationality'] = df['Nationality'].map(d)

d = {'YES': 1, 'NO': 0}

df['Go'] = df['Go'].map(d)

print(df)

然后,我们必须将特征列与目标列分开。

特征列是我们尝试从中预测的列,目标列是具有我们尝试预测的值的列。

实例

X 是特征列,y 是目标列:

features = ['Age', 'Experience', 'Rank', 'Nationality']

X = df[features]

y = df['Go']

print(X)

print(y)

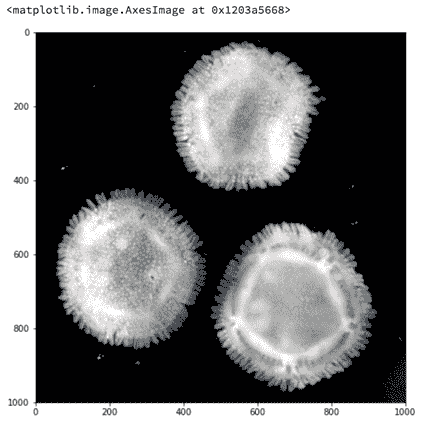

现在,我们可以创建实际的决策树,使其适合我们的细节,然后在计算机上保存一个 .png 文件:

实例

创建一个决策树,将其另存为图像,然后显示该图像:

dtree = DecisionTreeClassifier()

dtree = dtree.fit(X, y)

data = tree.export_graphviz(dtree, out_file=None, feature_names=features)

graph = pydotplus.graph_from_dot_data(data)

graph.write_png('mydecisiontree.png')

img=pltimg.imread('mydecisiontree.png')

imgplot = plt.imshow(img)

plt.show()

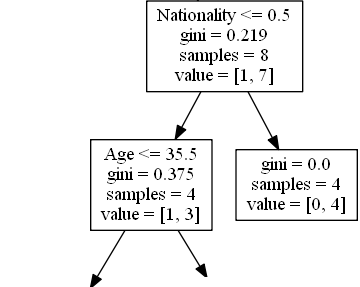

结果解释

决策树使用您先前的决策来计算您是否愿意去看喜剧演员的几率。

让我们阅读决策树的不同方面:

Rank

Rank <= 6.5 表示排名在 6.5 以下的喜剧演员将遵循 True 箭头(向左),其余的则遵循 False 箭头(向右)。

gini = 0.497 表示分割的质量,并且始终是 0.0 到 0.5 之间的数字,其中 0.0 表示所有样本均得到相同的结果,而 0.5 表示分割完全在中间进行。

samples = 13 表示在决策的这一点上还剩下 13 位喜剧演员,因为这是第一步,所以他们全部都是喜剧演员。

value = [6, 7] 表示在这 13 位喜剧演员中,有 6 位将获得 “NO”,而 7 位将获得 “GO”。

Gini

分割样本的方法有很多,我们在本教程中使用 GINI 方法。

基尼方法使用以下公式:

Gini = 1 - (x/n)2 - (y/n)2

其中,x 是肯定答案的数量 (“GO”),n 是样本数量,y 是否定答案的数量 (“NO”),使用以下公式进行计算:

1 - (7 / 13)2 - (6 / 13)2 = 0.497

下一步包含两个框,其中一个框用于喜剧演员,其 ‘Rank’ 为 6.5 或更低,其余为一个框。

True - 5 名喜剧演员在这里结束:

gini = 0.0 表示所有样本均得到相同的结果。

samples = 5 表示该分支中还剩下 5 位喜剧演员(5 位的等级为 6.5 或更低的喜剧演员)。

value = [5, 0] 表示 5 得到 “NO” 而 0 得到 “GO”。

False - 8 位戏剧演员继续:

Nationality(国籍)

Nationality <= 0.5 表示国籍值小于 0.5 的喜剧演员将遵循左箭头(这表示来自英国的所有人),其余的将遵循右箭头。

gini = 0.219 意味着大约 22% 的样本将朝一个方向移动。

samples = 8 表示该分支中还剩下 8 个喜剧演员(8 个喜剧演员的等级高于 6.5)。

value = [1, 7] 表示在这 8 位喜剧演员中,1 位将获得 “NO”,而 7 位将获得 “GO”。

True - 4 名戏剧演员继续:

Age(年龄)

Age <= 35.5 表示年龄在 35.5 岁或以下的喜剧演员将遵循左箭头,其余的将遵循右箭头。

gini = 0.375 意味着大约 37.5% 的样本将朝一个方向移动。

samples = 4 表示该分支中还剩下 4 位喜剧演员(来自英国的 4 位喜剧演员)。

value = [1, 3] 表示在这 4 位喜剧演员中,1 位将获得 “NO”,而 3 位将获得 “GO”。

False - 4 名喜剧演员到这里结束:

gini = 0.0 表示所有样本都得到相同的结果。

samples = 4 表示该分支中还剩下 4 位喜剧演员(来自英国的 4 位喜剧演员)。

value = [0, 4] 表示在这 4 位喜剧演员中,0 将获得 “NO”,而 4 将获得 “GO”。

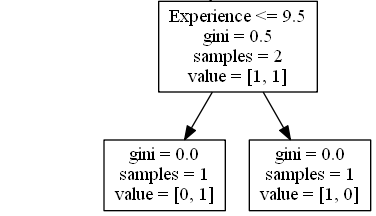

True - 2 名喜剧演员在这里结束:

gini = 0.0 表示所有样本都得到相同的结果。

samples = 2 表示该分支中还剩下 2 名喜剧演员(2 名 35.5 岁或更年轻的喜剧演员)。

value = [0, 2] 表示在这 2 位喜剧演员中,0 将获得 “NO”,而 2 将获得 “GO”。

False - 2 名戏剧演员继续:

Experience(经验)

Experience <= 9.5 表示具有 9.5 年或以上经验的喜剧演员将遵循左侧的箭头,其余的将遵循右侧的箭头。

gini = 0.5 表示 50% 的样本将朝一个方向移动。

samples = 2 表示此分支中还剩下 2 个喜剧演员(2 个年龄超过 35.5 的喜剧演员)。

value = [1, 1] 表示这两个喜剧演员中,1 将获得 “NO”,而 1 将获得 “GO”。

True - 1 名喜剧演员在这里结束:

gini = 0.0 表示所有样本都得到相同的结果。

samples = 1 表示此分支中还剩下 1 名喜剧演员(1 名具有 9.5 年或以下经验的喜剧演员)。

value = [0, 1] 表示 0 表示 “NO”,1 表示 “GO”。

False - 1 名喜剧演员到这里为止:

gini = 0.0 表示所有样本都得到相同的结果。

samples = 1 表示此分支中还剩下 1 位喜剧演员(其中 1 位具有超过 9.5 年经验的喜剧演员)。

value = [1, 0] 表示 1 表示 “NO”,0 表示 “GO”。

预测值

我们可以使用决策树来预测新值。

例如:我是否应该去看一个由 40 岁的美国喜剧演员主演的节目,该喜剧演员有 10 年的经验,喜剧排名为 7?

实例

使用 predict() 方法来预测新值:

print(dtree.predict([[40, 10, 7, 1]]))

实例

如果喜剧等级为 6,答案是什么?

print(dtree.predict([[40, 10, 6, 1]]))

不同的结果

如果运行足够多次,即使您输入的数据相同,决策树也会为您提供不同的结果。

这是因为决策树无法给我们 100% 的肯定答案。它基于结果的可能性,答案会有所不同。

文件处理

在 Python 中使用文件的关键函数是 open() 函数。

open() 函数有两个参数:文件名和模式。

有四种打开文件的不同方法(模式):

- “r” - 读取 - 默认值。打开文件进行读取,如果文件不存在则报错。

- “a” - 追加 - 打开供追加的文件,如果不存在则创建该文件。

- “w” - 写入 - 打开文件进行写入,如果文件不存在则创建该文件。

- “x” - 创建 - 创建指定的文件,如果文件存在则返回错误。

此外,您可以指定文件是应该作为二进制还是文本模式进行处理。

- “t” - 文本 - 默认值。文本模式。

- “b” - 二进制 - 二进制模式(例如图像)。

语法

此外,您可以指定文件是应该作为二进制还是文本模式进行处理:

f = open("demofile.txt")

以上代码等同于:

f = open("demofile.txt", "rt")

因为 “r” (读取)和 “t” (文本)是默认值,所以不需要指定它们。

**注释:**请确保文件存在,否则您将收到错误消息。

在服务器上打开文件

假设我们有以下文件,位于与 Python 相同的文件夹中:

demofile.txt

Hello! Welcome to demofile.txt

This file is for testing purposes.

Good Luck!

如需打开文件,请使用内建的 open() 函数。

open() 函数返回文件对象,此对象有一个 read() 方法用于读取文件的内容:

实例

f = open("demofile.txt", "r")

print(f.read())

只读取文件的一部分

默认情况下,read() 方法返回整个文本,但您也可以指定要返回的字符数:

实例

返回文件中的前五个字符:

f = open("demofile.txt", "r")

print(f.read(5))

读行

您可以使用 readline() 方法返回一行:

实例

读取文件中的一行:

f = open("demofile.txt", "r")

print(f.readline())

通过两次调用 readline(),您可以读取前两行:

实例

读取文件中的两行:

f = open("demofile.txt", "r")

print(f.readline())

print(f.readline())

通过循环遍历文件中的行,您可以逐行读取整个文件:

实例

逐行遍历文件:

f = open("demofile.txt", "r")

for x in f:

print(x)

关闭文件

完成后始终关闭文件是一个好习惯。

实例

完成后关闭文件:

f = open("demofile.txt", "r")

print(f.readline())

f.close()

**注释:**在某些情况下,由于缓冲,您应该始终关闭文件,在关闭文件之前,对文件所做的更改可能不会显示。

写入已有文件

如需写入已有的文件,必须向 open() 函数添加参数:

- “a” - 追加 - 会追加到文件的末尾

- “w” - 写入 - 会覆盖任何已有的内容

实例

打开文件 “demofile2.txt” 并将内容追加到文件中:

f = open("demofile2.txt", "a")

f.write("Now the file has more content!")

f.close()

# 追加后,打开并读取该文件:

f = open("demofile2.txt", "r")

print(f.read())

实例

打开文件 “demofile3.txt” 并覆盖内容:

f = open("demofile3.txt", "w")

f.write("Woops! I have deleted the content!")

f.close()

# 写入后,打开并读取该文件:

f = open("demofile3.txt", "r")

print(f.read())

注释:“w” 方法会覆盖全部内容。

创建新文件

如需在 Python 中创建新文件,请使用 open() 方法,并使用以下参数之一:

- “x” - 创建 - 将创建一个文件,如果文件存在则返回错误

- “a” - 追加 - 如果指定的文件不存在,将创建一个文件

- “w” - 写入 - 如果指定的文件不存在,将创建一个文件

实例

创建名为 “myfile.txt” 的文件:

f = open("myfile.txt", "x")

结果:已创建新的空文件!

实例

如果不存在,则创建新文件:

f = open("myfile.txt", "w")

删除文件

如需删除文件,必须导入 OS 模块,并运行其 os.remove() 函数:

实例

删除文件 “demofile.txt”:

import os

os.remove("demofile.txt")

检查文件是否存在

为避免出现错误,您可能需要在尝试删除文件之前检查该文件是否存在:

实例

检查文件是否存在,然后删除它:

import os

if os.path.exists("demofile.txt"):

os.remove("demofile.txt")

else:

print("The file does not exist")

删除文件

如需删除整个文件夹,请使用 os.rmdir() 方法:

实例

删除文件夹 “myfolder”:

import os

os.rmdir("myfolder")

**提示:**您只能删除空文件夹。

高阶函数

高阶函数英文叫Higher-order function。什么是高阶函数?我们以实际代码为例子,一步一步深入概念。

1. 变量可以指向函数

以Python内置的求绝对值的函数abs()为例,调用该函数用以下代码:

# 调用abs()函数

In [1]: abs(-10)

Out[1]: 10

# 只写abs

In [3]: abs

Out[3]: <function abs>

依据如上例子,可见abs(-10)是对函数的调用,而只写abs是函数本身。

要获得函数调用结果,我们可以把结果赋值给变量:

In [4]: x = abs(-10)

In [5]: x

Out[5]: 10

但是,如果把函数本身赋值给变量呢?

In [6]: fun_abs = abs

In [8]: fun_abs

Out[8]: <function abs>

结论:函数本身也可以赋值给变量,即:变量可以指向函数。

# 变量fun_abs已经指向`abs`函数本身,调用完全和abs一样

In [9]: fun_abs(-10)

Out[9]: 10

2. 传入函数

既然变量可以指向函数,函数的参数能接收变量,那么一个函数就可以接收另一个函数作为参数,这种函数就称之为高阶函数。

一个最简单的高阶函数:

In [10]: def add(x, y, f):

....: return f(x) + f(y)

....:

In [11]: add(-5, -6, abs)

Out[11]: 11

我们将abs函数作为变量传给add()里的f作为高阶函数传参。然后在add里还调用了f的功能。 整个行为流有些像这样:

x = -5

y = -6

f = abs

f(x) + f(y) ==> abs(-5) + abs(6) ==> 11

return 11

把函数作为参数传入,这样的函数称为高阶函数,函数式编程就是指这种高度抽象的编程范式。

map/reduce

Python内建了map()和reduce()函数。

我们先看map。map()函数接收两个参数,一个是函数,一个是Iterable,map将传入的函数依次作用到序列的每个元素,并把结果作为新的Iterator返回。

举例说明,比如我们有一个函数f(x)=x^2,要把这个函数作用在一个list [1, 2, 3, 4, 5, 6, 7, 8, 9]上,就可以用map()实现如下:

In [12]: def f(x):

....: return x * x

....:

In [13]: r = map(f, [1, 2, 3, 4, 5, 6])

In [14]: r

Out[14]: [1, 4, 9, 16, 25, 36]

map()传入的第一个参数是f,即函数对象本身。由于结果r是一个Iterator,Iterator是惰性序列,因此通过list()函数让它把整个序列都计算出来并返回一个list。

然后是reduce()函数。

reduce把一个函数作用在一个序列[x1, x2, x3, ...]上,这个函数必须接收两个参数,reduce把结果继续和序列的下一个元素做累积计算,其效果就是:

reduce(f, [x1, x2, x3, x4]) = f(f(f(x1, x2), x3), x4)

### 计算流像是这个样子

f(x1, x2)

f(f(x1, x2), x3)

f(f(f(x1, x2), x3), x4)

比方说对一个序列求和,就可以用reduce实现:

In [15]: from functools import reduce

In [16]: def add(x, y):

....: return x + y

....:

In [17]: reduce(add, [1, 2, 3, 4, 5])

Out[17]: 15

当然求和运算可以直接用Python内建函数sum(),没必要动用reduce。

但是如果要把序列[1, 3, 5, 7, 9]变换成整数13579,reduce就可以派上用场:

In [18]: from functools import reduce

In [19]: def fn(x, y):

....: return x * 10 + y

....:

In [20]: reduce(fn, [1, 3, 5, 7, 9])

Out[20]: 13579

做个练习,利用map()函数,把用户输入的不规范的英文名字,变为首字母大写,其他小写的规范名字。输入:[‘adam’, ‘LISA’, ‘barT’],输出:[‘Adam’, ‘Lisa’, ‘Bart’]:

"""

第一个版本

"""

# -*- coding: utf-8 -*-

def normalize(name):

return name.upper()[0:1] + name.lower()[1:]

L1 = ['adam', 'LISA', 'barT']

L2 = list(map(normalize, L1))

print(L2)

"""

写完第一个版本后,虽然完成了需求,但是其实有可以优化的地方

觉得下面的写法更pythonic些

"""

# -*- coding: utf-8 -*-

def normalize(name):

this_name = name.lower()

return this_name[0:1].upper() + this_name[1:].lower()

L1 = ['adam', 'LISA', 'barT']

L2 = list(map(normalize, L1))

print(L2)

第二个练习: Python提供的sum()函数可以接受一个list并求和,请编写一个prod()函数,可以接受一个list并利用reduce()求积:

from functools import reduce

def fn(x, y):

return x * y

def prod(L):

return reduce(fn, L)

print("3 * 5 * 7 * 9 =", prod([3, 5, 7, 9]))

练习三:利用map和reduce编写一个str2float函数,把字符串’123.456’转换成浮点数123.456:

# -*- coding: utf-8 -*-

def char2num(s):

return {'0': 0, '1': 1, '2': 2, '3': 3, '4': 4, '5': 5, '6': 6, '7': 7, '8': 8, '9': 9}[s]

def str2int(s):

return reduce(lambda x, y: x * 10 + y, map(char2num, s))

def reduce_float(x, y):

y = 10

return x / y

def return_float(s):

base = 0.1

base_minus = 10

stra = "1"

for i in range(s-1):

stra = stra + '0'

return base / str2int(stra)

def split_float(arg, l_or_r):

if l_or_r == "l":

return arg.split('.')[0]

else:

return arg.split('.')[1]

def str2float(s):

left = split_float(s, "l")

right = split_float(s, "r")

final_left = str2int(left)

r_float = return_float(len(right))

final_right = str2int(right) * r_float

return final_left + final_right

print('str2float(\'123.456\') =', str2float('123.456'))

print('str2float(\'123.888\') =', str2float('123.888'))

filter

Python内建的filter()函数用于过滤序列。

和map()类似,filter()也接收一个函数和一个序列。和map()不同的是,filter()把传入的函数依次作用于每个元素,然后根据返回值是True还是False决定保留还是丢弃该元素。

例如,在一个list中,删掉偶数,只保留奇数,可以这么写:

def is_odd(n):

return n % 2 == 1

list(filter(is_odd, [1,2,3,4,5,6,10,15]))

sorted

排序也是在程序中经常用到的算法。无论使用冒泡排序还是快速排序,排序的核心是比较两个元素的大小。如果是数字,我们可以直接比较,但如果是字符串或者两个dict呢?直接比较数学上的大小是没有意义的,因此,比较的过程必须通过函数抽象出来。

Python内置的sorted()函数就可以对list进行排序:

>>> sorted([36, 5, -12, 9, -21])

[-21, -12, 5, 9, 36]

此外,sorted()函数也是一个高阶函数,它还可以接收一个key函数来实现自定义的排序,例如按绝对值大小排序:

>>> sorted([36, 5, -12, 9, -21], key=abs)

[5, 9, -12, -21, 36]

返回函数

高阶函数除了可以接受函数作为参数外,还可以把函数作为结果值返回。

我们来实现一个可变参数的求和。通常情况下,求和的函数是这样定义的:

def calc_sum(*args):

ax = 0

for n in args:

ax = ax + n

return ax

但是,如果不需要立刻求和,而是在后面的代码中,根据需要再计算怎么办?可以不返回求和的结果,而是返回求和的函数:

def lazy_sum(*args):

def sum():

ax = 0

for n in args:

ax = ax + n

return ax

return sum

当我们调用lazy_sum()时,返回的并不是求和结果,而是求和函数:

>>> f = lazy_sum(1, 3, 5, 7, 9)

>>> f

<function lazy_sum.<locals>.sum at 0x101c6ed90>

调用函数f时,才真正计算求和的结果:

>>> f()

25

在这个例子中,我们在函数lazy_sum中又定义了函数sum,并且,内部函数sum可以引用外部函数lazy_sum的参数和局部变量,当lazy_sum返回函数sum时,相关参数和变量都保存在返回的函数中,这种称为“闭包(Closure)”的程序结构拥有极大的威力。

请再注意一点,当我们调用lazy_sum()时,每次调用都会返回一个新的函数,即使传入相同的参数:

>>> f1 = lazy_sum(1, 3, 5, 7, 9)

>>> f2 = lazy_sum(1, 3, 5, 7, 9)

>>> f1==f2

False

f1()和f2()的调用结果互不影响。

闭包

注意到返回的函数在其定义内部引用了局部变量args,所以,当一个函数返回了一个函数后,其内部的局部变量还被新函数引用,所以,闭包用起来简单,实现起来可不容易。

返回闭包时牢记的一点就是:返回函数不要引用任何循环变量,或者后续会发生变化的变量。

匿名函数 lambda

当我们在传入函数时,有些时候,不需要显式地定义函数,直接传入匿名函数更方便。

在Python中,对匿名函数提供了有限支持。还是以map()函数为例,计算f(x)=x^2时,除了定义一个f(x)的函数外,还可以直接传入匿名函数:

>>> list(map(lambda x: x * x, [1, 2, 3, 4, 5, 6, 7, 8, 9]))

[1, 4, 9, 16, 25, 36, 49, 64, 81]

关键字lambda表示匿名函数,冒号前面的x表示函数参数。

匿名函数有个限制,就是只能有一个表达式,不用写return,返回值就是该表达式的结果。

用匿名函数有个好处,因为函数没有名字,不必担心函数名冲突。此外,匿名函数也是一个函数对象,也可以把匿名函数赋值给一个变量,再利用变量来调用该函数:

>>> f = lambda x: x * x

>>> f

<function <lambda> at 0x101c6ef28>

>>> f(5)

25

同样,也可以把匿名函数作为返回值返回,比如:

def build(x, y):

return lambda: x * x + y * y

Python对匿名函数的支持有限,只有一些简单的情况下可以使用匿名函数。

装饰器

由于函数也是一个对象,而且函数对象可以被赋值给变量,所以,通过变量也能调用该函数。

def now():

print('2016-11-22')

f = now

f()

# 2016-11-22

函数对象有一个__name__属性,可以拿到函数的名字:

>>> now.__name__

'now'

>>> f.__name__

'now'

现在,假设我们要增强now()函数的功能,比如,在函数调用前后自动打印日志,但又不希望修改now()函数的定义,这种在代码运行期间动态增加功能的方式,称之为“装饰器”(Decorator)。

本质上,decorator就是一个返回函数的高阶函数。所以,我们要定义一个能打印日志的decorator,可以定义如下:

def log(func):

def wrapper(*args, **kw):

print('call %s():' % func.__name__)

return func(*args, **kw)

return wrapper

观察上面的log,因为它是一个decorator,所以接受一个函数作为参数,并返回一个函数。我们要借助Python的@语法,把decorator置于函数的定义处:

@log

def now():

print('2015-3-25')

调用now()函数,不仅会运行now()函数本身,还会在运行now()函数前打印一行日志:

>>> now()

call now():

2015-3-25

把@log放到now()函数的定义处,相当于执行了语句:

now = log(now)

由于log()是一个decorator,返回一个函数,所以,原来的now()函数仍然存在,只是现在同名的now变量指向了新的函数,于是调用now()将执行新函数,即在log()函数中返回的wrapper()函数。

wrapper()函数的参数定义是(*args, **kw),因此,wrapper()函数可以接受任意参数的调用。在wrapper()函数内,首先打印日志,再紧接着调用原始函数。

如果decorator本身需要传入参数,那就需要编写一个返回decorator的高阶函数,写出来会更复杂。比如,要自定义log的文本:

def log(text):

def decorator(func):

def wrapper(*args, **kw):

print('%s %s():' % (text, func.__name__))

return func(*args, **kw)

return wrapper

return decorator

这个3层嵌套的decorator用法如下:

@log('execute')

def now():

print('2015-3-25')

偏函数

Python的functools模块提供了很多有用的功能,其中一个就是偏函数(Partial function)。要注意,这里的偏函数和数学意义上的偏函数不一样。

在介绍函数参数的时候,我们讲到,通过设定参数的默认值,可以降低函数调用的难度。而偏函数也可以做到这一点。举例如下:

int()函数可以把字符串转换为整数,当仅传入字符串时,int()函数默认按十进制转换:

>>> int('12345')

12345

但int()函数还提供额外的base参数,默认值为10。如果传入base参数,就可以做N进制的转换:

>>> int('12345', base=8)

5349

>>> int('12345', 16)

74565

假设要转换大量的二进制字符串,每次都传入int(x, base=2)非常麻烦,于是,我们想到,可以定义一个int2()的函数,默认把base=2传进去:

def int2(x, base=2):

return int(x, base)

这样,我们转换二进制就非常方便了:

>>> int2('1000000')

64

>>> int2('1010101')

85

functools.partial就是帮助我们创建一个偏函数的,不需要我们自己定义int2(),可以直接使用下面的代码创建一个新的函数int2:

>>> import functools

>>> int2 = functools.partial(int, base=2)

>>> int2('1000000')

64

>>> int2('1010101')

85

所以,简单总结functools.partial的作用就是,把一个函数的某些参数给固定住(也就是设置默认值),返回一个新的函数,调用这个新函数会更简单。

注意到上面的新的int2函数,仅仅是把base参数重新设定默认值为2,但也可以在函数调用时传入其他值:

>>> int2('1000000', base=10)

1000000

最后,创建偏函数时,实际上可以接收函数对象、*args和**kw这3个参数,当传入:

int2 = functools.partial(int, base=2)

实际上固定了int()函数的关键字参数base,也就是:

int2('10010')

相当于:

kw = { 'base': 2 }

int('10010', **kw)

当函数的参数个数太多,需要简化时,使用functools.partial可以创建一个新的函数,这个新函数可以固定住原函数的部分参数,从而在调用时更简单。

NumPy 数值分析

一、求解线性方程

在本节中,您将学习如何使用linalg.solve()方法求解线性方程。 当您有线性方程要求解时 ,在简单情况下,您只需计算A的反函数即可。然后将其乘以B即可得到解,但是当A具有高维数时,这使得计算起来很难进行计算A的倒数。 让我们从具有三个未知数的三个线性方程式的示例开始,如下所示:

In [44]: A = np.array([[2, 1, 2], [3, 2, 1], [0, 1, 1]])

A

Out[44]: array([[2, 1, 2],

[3, 2, 1],

[0, 1, 1]])

In [45]: B = np.array([8,3,4])

B

Out[45]: array([8, 3, 4])

In [46]: A_inv = np.linalg.inv(A)

A_inv

Out[46]: array([[ 0.2, 0.2, -0.6],

[-0.6, 0.4, 0.8],

[ 0.6, -0.4, 0.2]])

In [47]: np.dot(A_inv,B)

Out[47]: array([-0.2, -0.4, 4.4])

最后,得到a = -0.2,b = -0.4和c = 4.4的结果。 现在,让我们使用linalg.solve()执行相同的计算,如下所示:

In [48]: A = np.array([[2, 1, 2], [3, 2, 1], [0, 1, 1]])

B = np.array([8,3,4])

x = np.linalg.solve(A, B)

x

Out[48]: array([-0.2, -0.4, 4.4])

为了检查我们的结果,我们可以使用allclose()函数,该函数用于按元素比较两个数组:

In [49]: np.allclose(np.dot(A, x), B)

Out[49]: True

linalg.lstsq()方法是求解线性方程组的另一个重要函数,它返回最小二乘解。 此函数将返回回归线的参数。 回归线的主要思想是最小化每个数据点到回归线的距离平方和。 距离的平方和实际上量化了回归线的总误差。 距离越大,误差越大。 因此,我们正在寻找可以最大程度减少此误差的参数。 为了可视化我们的线性回归模型,我们将使用一个非常流行的 Python 二维绘图库matplotlib。 以下代码块在矩阵中运行最小二乘解,并返回权重和偏差:

In [50]: from numpy import arange,array,ones,linalg

from pylab import plot,show

x = np.arange(1,11)

A = np.vstack([x, np.ones(len(x))]).T

A

Out[50]: array([[ 1., 1.],

[ 2., 1.],

[ 3., 1.],

[ 4., 1.],

[ 5., 1.],

[ 6., 1.],

[ 7., 1.],

[ 8., 1.],

[ 9., 1.],

[ 10., 1.]])

In [51]: y = [5, 6, 6.5, 7, 8,9.5, 10, 10.4,13.1,15.5]

w = linalg.lstsq(A,y)[0]

w

Out[51]: array([ 1.05575758, 3.29333333])

In [52]: line = w[0]*x+w[1]

plot(x,line,'r-',x,y,'o')

show()

上图给出了适合我们数据的回归线拟合结果。 该模型生成可用于预测或预测的线性线。 尽管线性回归有很多假设(恒定方差,误差的独立性,线性等),但它仍然是建模数据点之间线性关系的最常用方法。

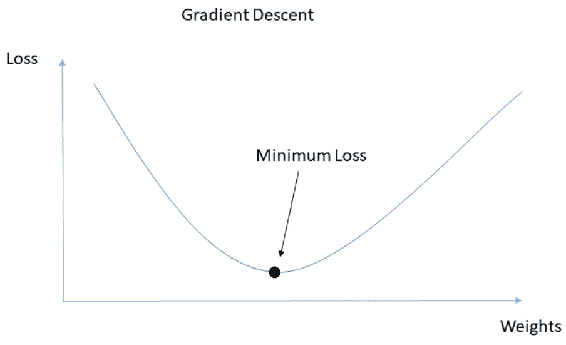

二、计算梯度

当您有一条直线时,您可以使用导数,以便导数显示该线的斜率。 当函数中有多个变量时,梯度是导数的泛化,因此,梯度的结果实际上是向量函数,而不是导数中的标量值。 ML 的主要目标实际上是找到适合您数据的最佳模型。 您可以通过将损失函数或目标函数最小化来求值最佳均值。 梯度用于查找系数或函数,以最大程度地减少损失或成本函数。 查找最佳点的一种众所周知的方法是采用目标函数的导数,然后将其设置为零以找到模型系数。 如果系数不止一个,则它将成为梯度而不是导数,并且将成为向量方程式而不是标量值。 您可以在每个点上将梯度解释为向量,该梯度将指向函数的下一个局部最小值。 有一种非常流行的优化技术,可以通过计算每个点的梯度并沿该方向移动系数来寻找函数的最小值,以寻求最小值。 该方法称为梯度下降。 在 NumPy 中,gradient()函数用于计算数组的梯度:

In [53]: a = np.array([1,3, 6, 7, 11, 14])

gr = np.gradient(a)

gr

Out[53]: array([ 2\. , 2.5, 2\. , 2.5, 3.5, 3\. ])

让我们看看如何计算此梯度:

gr[0] = (a[1]-a[0])/1 = (3-1)/1 = 2

gr[1] = (a[2]-a[0])/2 = (6-1)/2 = 2.5

gr[2] = (a[3]-a[1])/2 = (7-3)/2 = 2

gr[3] = (a[4]-a[2])/2 = (11-6)/2 = 2.5

gr[4] = (a[5]-a[3])/2 = (14-7)/2 = 3.5

gr[5] = (a[5]-a[4])/1 = (14-11)/1 = 3

在前面的代码块中,我们计算了一维数组的梯度。 让我们添加另一个维度,并查看计算如何更改,如下所示:

[54]: a = np.array([1,3, 6, 7, 11, 14]). reshape(2,3)

gr = np.gradient(a)

gr

Out[54]: [array([[ 6., 8., 8.],

[ 6., 8., 8.]]), array([[ 2\. , 2.5, 3\. ],

[ 4\. , 3.5, 3\. ]])]

对于二维数组,与前面的代码一样,按列和按行计算梯度。 因此,结果将是两个数组的返回。 第一个数组代表行方向,第二个数组代表列方向。

总结

在本章中,我们介绍了线性代数的向量和矩阵运算。 我们研究了高级矩阵运算,尤其是特征点运算。 您还了解了的特征值和特征向量,然后在主成分分析(PCA)中实践了它们的用法。 此外,我们介绍了范数和行列式计算,并提到了它们在 ML 中的重要性和用法。 在最后两个小节中,您学习了如何将线性方程式转换为矩阵并求解它们,并研究了梯度的计算和重要性。

在下一章中,我们将使用 NumPy 统计数据进行解释性数据分析,以探索 2015 年美国住房数据。

三、使用 NumPy 统计函数对波士顿住房数据进行探索性数据分析

探索性数据分析(EDA)是数据科学项目的重要组成部分(如图数据科学过程所示)。 尽管在将任何统计模型或机器学习算法应用于数据之前这是非常重要的一步,但许多从业人员经常忽略或低估了它。

John Wilder Tukey 于 1977 年通过他的著作探索性数据分析促进了探索性数据分析。 在他的书中,他指导统计学家通过使用几种不同的视觉手段对统计数据集进行统计分析,这将帮助他们制定假设。 此外,在确定关键数据特征并了解有关数据的哪些问题后,EDA 还可以用于为高级建模准备分析。 在较高的层次上,EDA 是对您的数据的无假设探索,它利用了定量方法,使您可以可视化结果,从而可以识别模式,异常和数据特征。 在本章中,您将使用 NumPy 的内置统计方法执行探索性数据分析。

本章将涵盖以下主题:

- 加载和保存文件

- 探索数据集

- 查看基本统计量

- 计算平均值和方差

- 计算相关性

- 计算直方图

加载和保存文件

在本节中,您将学习如何加载/导入数据并保存。 加载数据的方式有很多,正确的方式取决于您的文件类型。 您可以加载/导入文本文件,SAS/Stata 文件,HDF5 文件以及许多其他文件。 HDF(分层数据格式)是一种流行的数据格式,用于存储和组织大量数据,并且在处理多维同构数组时非常有用。 例如,Pandas 库有一个非常方便的类,名为HDFStore,您可以在其中轻松使用 HDF5 文件。 在从事数据科学项目时,您很可能会看到许多这类文件,但是在本书中,我们将介绍最受欢迎的文件,例如 NumPy 二进制文件,文本文件(.txt)和逗号分隔值(.csv)文件。

如果内存和磁盘上有大量数据要管理,则可以使用bcolz库。 它提供了列式和压缩数据容器。 bcolz对象称为chunks,您在其中将整个数据压缩为位,然后在查询时部分解压缩。 压缩数据后,它会非常高效地使用存储。bcolz对象也提高了数据获取性能。 如果您对该库的性能感兴趣。 您可以在其官方 GitHub 存储库 上检查查询和速度比较。

使用数组时,通常在完成使用后将它们另存为 NumPy 二进制文件。 原因是您还需要存储数组形状和数据类型。 重新加载数组时,您希望 NumPy 记住它,并且您可以从上次中断的地方继续工作。 此外,即使您在具有不同架构的另一台计算机上打开文件, NumPy 二进制文件也可以存储有关数组的信息。 在 NumPy 中,load(),save(),savez()和savez_compressed()方法可帮助您加载和保存 NumPy 二进制文件,如下所示:

In [1]: import numpy as np

In [2]: example_array = np.arange(12).reshape(3,4)

In [3]: example_array

Out[3]: array([[ 0, 1, 2, 3],

[ 4, 5, 6, 7],

[ 8, 9, 10, 11]])

In [4]: np.save('example.npy',example_array)

In [5]: d = np.load('example.npy')

In [6]: np.shape(d)

Out[6]: (3, 4)

In [7]: d

Out[7]: array([[ 0, 1, 2, 3],

[ 4, 5, 6, 7],

[ 8, 9, 10, 11]])

在前面的代码中,我们执行以下步骤来练习将数组保存为二进制文件,以及如何在不影响其形状的情况下将其加载回:

- 创建形状为

(3, 4)的数组 - 将数组另存为二进制文件

- 加载回数组

- 检查形状是否仍然相同

同样,您可以使用savez()函数将多个数组保存到单个文件中。 如果要将文件另存为压缩的 NumPy 二进制文件,则可以按以下方式使用savez_compressed():

In [8]: x = np.arange(10)

y = np.arange(12)

np.savez('second_example.npz',x, y)

npzfile = np.load('second_example.npz')

npzfile.files

Out[8]: ['arr_0', 'arr_1']

In [9]: npzfile['arr_0']

Out[9]: array([0, 1, 2, 3, 4, 5, 6, 7, 8, 9])

In [10]: npzfile['arr_1']

Out[10]: array([ 0, 1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11])

In [11]: np.savez_compressed('compressed_example.npz', first_array = x , second_array = y)

npzfile = np.load('compressed_example.npz')

npzfile.files

Out[11]: ['first_array', 'second_array']

In [12]: npzfile['first_array']

Out[12]: array([0, 1, 2, 3, 4, 5, 6, 7, 8, 9])

In [13]: npzfile['second_array']

Out[13]: array([ 0, 1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11])

当您将多个数组保存在单个文件中时,如果您提供关键字参数如first_array=x,则将使用该名称保存数组。 否则,默认情况下,您的第一个数组将被赋予一个变量名,例如arr_0。 NumPy 具有称为loadtxt()的内置函数,用于从文本文件加载数据。 让我们加载一个.txt文件,该文件由一些整数和一个标头组成。

在前面的代码中,由于无法将字符串转换为浮点数,因此会出现误差,这实际上意味着您正在读取非数字值。 这样做的原因是该文件在顶部包含作为标题的字符串以及数值。 如果知道标题有多少行,则可以使用skiprows参数跳过这些行,如下所示:

In [15]: a = np.loadtxt("My_file.txt", delimiter='\t', skiprows=4)

a

Out[15]: array([ 0., 1., 2., 3., 4., 5., 6., 7., 8.,

9., 10., 11., 12., 13., 14., 15., 16., 17.,

18., 19., 20., 21., 22., 23., 24., 25., 26.,

27., 28., 29., 30., 31., 32., 33., 34., 35.,

36., 37., 38., 39., 40., 41., 42., 43., 44.,

45., 46., 47., 48., 49., 50., 51., 52., 53.,

54., 55., 56., 57., 58., 59., 60., 61., 62.,

63., 64., 65., 66., 67., 68., 69., 70., 71.,

72., 73., 74., 75., 76., 77., 78., 79., 80.,

81., 82., 83., 84., 85., 86., 87., 88., 89.,

90., 91., 92., 93., 94., 95., 96., 97., 98.,

99., 100., 101., 102., 103., 104., 105., 106., 107.,

108., 109., 110., 111., 112., 113., 114., 115., 116.,

117., 118., 119., 120., 121., 122., 123., 124., 125.,

126., 127., 128., 129., 130., 131., 132., 133., 134.,

135., 136., 137., 138., 139., 140., 141., 142., 143.,

144., 145., 146., 147., 148., 149., 150., 151., 152.,

153., 154., 155., 156., 157., 158., 159., 160., 161.,

162., 163., 164., 165., 166., 167., 168., 169., 170.,

171., 172., 173., 174., 175., 176., 177., 178., 179.,

180., 181., 182., 183., 184., 185., 186., 187., 188.,

189., 190., 191., 192., 193., 194., 195., 196., 197.,

198., 199., 200., 201., 202., 203., 204., 205., 206.,

207., 208., 209., 210., 211., 212., 213., 214., 215.,

216., 217., 218., 219., 220., 221., 222., 223., 224.,

225., 226., 227., 228., 229., 230., 231., 232., 233.,

234., 235., 236., 237., 238., 239., 240., 241., 242.,

243., 244., 245., 246., 247., 248., 249.])

另外,您可以使用genfromtxt()并将标头的转换默认设置为nan。 然后,您可以检测到标题占用了多少行,并使用skip_header参数跳过它们,如下所示:

In [16]: b = np.genfromtxt("My_file.txt", delimiter='\t')

b

Out[16]: array([ nan, nan, nan, nan, 0., 1., 2., 3., 4.,

5., 6., 7., 8., 9., 10., 11., 12., 13.,

14., 15., 16., 17., 18., 19., 20., 21., 22.,

23., 24., 25., 26., 27., 28., 29., 30., 31.,

32., 33., 34., 35., 36., 37., 38., 39., 40.,

41., 42., 43., 44., 45., 46., 47., 48., 49.,

50., 51., 52., 53., 54., 55., 56., 57., 58.,

59., 60., 61., 62., 63., 64., 65., 66., 67.,

68., 69., 70., 71., 72., 73., 74., 75., 76.,

77., 78., 79., 80., 81., 82., 83., 84., 85.,

86., 87., 88., 89., 90., 91., 92., 93., 94.,

95., 96., 97., 98., 99., 100., 101., 102., 103.,

104., 105., 106., 107., 108., 109., 110., 111., 112.,

113., 114., 115., 116., 117., 118., 119., 120., 121.,

122., 123., 124., 125., 126., 127., 128., 129., 130.,

131., 132., 133., 134., 135., 136., 137., 138., 139.,

140., 141., 142., 143., 144., 145., 146., 147., 148.,

149., 150., 151., 152., 153., 154., 155., 156., 157.,

158., 159., 160., 161., 162., 163., 164., 165., 166.,

167., 168., 169., 170., 171., 172., 173., 174., 175.,

176., 177., 178., 179., 180., 181., 182., 183., 184.,

185., 186., 187., 188., 189., 190., 191., 192., 193.,

194., 195., 196., 197., 198., 199., 200., 201., 202.,

203., 204., 205., 206., 207., 208., 209., 210., 211.,

212., 213., 214., 215., 216., 217., 218., 219., 220.,

221., 222., 223., 224., 225., 226., 227., 228., 229.,

230., 231., 232., 233., 234., 235., 236., 237., 238.,

239., 240., 241., 242., 243., 244., 245., 246., 247.,

248., 249.])

同样,您可以使用loadtxt(),genfromtxt()和savetxt()函数加载和保存.csv文件。 您唯一需要记住的是使用逗号作为定界符,如下所示:

In [17]: data_csv = np.loadtxt("MyData.csv", delimiter=',')

In [18]: data_csv[1:3]

Out[18]: array([[ 0.21982, 0.31271, 0.66934, 0.06072, 0.77785, 0.59984,

0.82998, 0.77428, 0.73216, 0.29968],

[ 0.78866, 0.61444, 0.0107 , 0.37351, 0.77391, 0.76958,

0.46845, 0.76387, 0.70592, 0.0851 ]])

In [19]: np.shape(data_csv)

Out[19]: (15, 10)

In [20]: np.savetxt('MyData1.csv',data_csv, delimiter = ',')

In [21]: data_csv1 = np.genfromtxt("MyData1.csv", delimiter = ',')

In [22]: data_csv1[1:3]

Out[22]: array([[ 0.21982, 0.31271, 0.66934, 0.06072, 0.77785, 0.59984,

0.82998, 0.77428, 0.73216, 0.29968],

[ 0.78866, 0.61444, 0.0107 , 0.37351, 0.77391, 0.76958,

0.46845, 0.76387, 0.70592, 0.0851 ]])

In [23]: np.shape(data_csv1)

Out[23]: (15, 10)

加载.txt文件时,它们会默认返回带有值的numpy数组,如后面的代码中所示:

In [24]: print (type(a))

print (type(b))

<class 'numpy.ndarray'>

<class 'numpy.ndarray'>

您可以使用tolist()方法将数据从数组更改为列表,然后使用savetxt()使用不同的分隔符将其保存为新文件,如下所示:

In [25]: c = a.tolist()

c

Out[25]: [0.0,

1.0,

2.0,

3.0,

4.0,

5.0,

6.0,

7.0,

8.0,

9.0,

10.0,

11.0,

12.0,

13.0,

14.0,

15.0,

16.0,

17.0,

18.0,

...

In [26]: np.savetxt('My_List.txt',c, delimiter=';')

In [27]: myList = np.loadtxt("My_List.txt", delimiter=';')

type(myList)

Out[27]: numpy.ndarray

将列表保存到My_List.txt后,可以使用loadtxt()加载此文件,它将再次作为numpy数组返回。 如果要返回数组的字符串表示形式,可以使用array_str(),array_repr()或array2string()方法,如下所示:

In [28]: d = np.array_str(a,precision=1)

d

Out[28]: '[ 0\. 1\. 2\. 3\. 4\. 5\. 6\. 7\. 8\. 9\. 10\. 11.\n 12\. 13\. 14\. 15\. 16\. 17\. 18\. 19\. 20\. 21\. 22\. 23.

24\. 25\. 26\. ... ]'

即使array_str()和array_repr()看起来一样,array_str()返回数组内部数据的字符串表示形式,而array_repr()实际上返回数组的字符串表示形式。 因此,array_repr()返回有关数组类型及其数据类型的信息。 这两个函数在内部都使用array2string(),这实际上是字符串格式化函数最灵活的版本,因为它具有更多可选参数。 以下代码块使用load_boston()方法加载波士顿房屋数据集:

In [29]: from sklearn.datasets import load_boston

dataset = load_boston()

dataset

在本章中,您将对sklearn.datasets包中的示例数据集进行探索性数据分析。 该数据集是关于波士顿房价的。 在前面的代码中,load_boston()函数是从sklearn.datasets包中导入的,如您所见,它返回具有属性DESCR,data,feature_names和target的类似字典的对象 ]。 这些属性的详细信息如下:

| 属性 | 解释 |

|---|---|

DESCR |

数据集的完整描述 |

data |

特征列 |

feature_names |

特征名称 |

target |

标签数据 |

在本节中,您学习了如何使用numpy函数加载和保存文件。 在下一部分中,您将探索波士顿住房数据集。

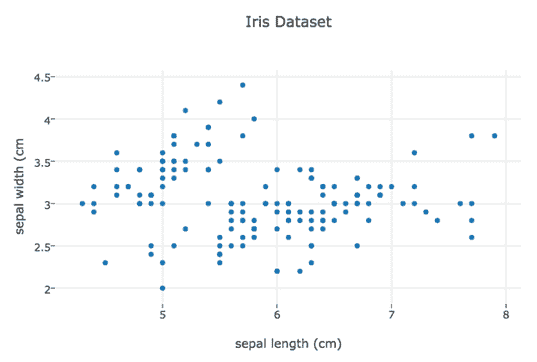

探索我们的数据集

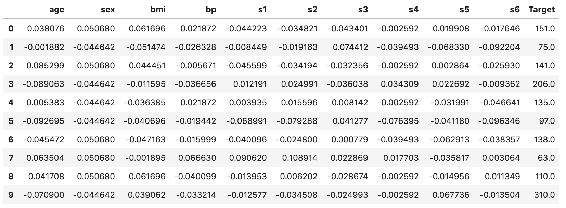

在本节中,您将探索数据集并对其进行质量检查。 您将检查数据形状是什么,以及它的数据类型,所有缺失值/ NaN,拥有多少个特征列以及每个列代表什么。 让我们开始加载数据并进行探索:

In [30]: from sklearn.datasets import load_boston

dataset = load_boston()

samples,label, feature_names = dataset.data , dataset.target , dataset.feature_names

In [31]: samples.shape

Out[31]: (506, 13)

In [32]: label.shape

Out[32]: (506,)

In [33]: feature_names

Out[33]: array(['CRIM', 'ZN', 'INDUS', 'CHAS', 'NOX', 'RM', 'AGE', 'DIS', 'RAD',

'TAX', 'PTRATIO', 'B', 'LSTAT'],

dtype='<U7')

在前面的代码中,您加载了数据集并解析了数据集的属性。 这表明我们拥有具有13函数的506样本,并且具有506标签(回归目标)。 如果要阅读数据集的描述,可以使用print(dataset.DESCR)。 由于此代码的输出太长,无法放置在此处。

如第一章所示,您可以使用dtype检查数组的数据类型。 如下面的代码所示,示例的每一列中都有一个数字float64数据类型和一个标签。 检查数据类型是非常重要的一步,您可能会意识到类型和列描述之间存在一些不一致,或者,如果您认为使用不太精确的目标值仍然可以实现,则可以通过更改其数据类型来减少数组的内存大小:

In [35]: print(samples.dtype)

print(label.dtype)

float64

float64

缺失值处理在 Python 软件包中略有不同。numpy库没有缺失值。 如果您的数据集中缺少值,则导入后它们将转换为NaN。 NumPy 中非常常见的方法是使用掩码数组以忽略NaN值,这在第一章中已向您展示:

In [36]: np.isnan(samples)

Out[36]: array([[False, False, False, ..., False, False, False],

[False, False, False, ..., False, False, False],

[False, False, False, ..., False, False, False],

...,

[False, False, False, ..., False, False, False],

[False, False, False, ..., False, False, False],

[False, False, False, ..., False, False, False]], dtype=bool)

In [37]: np.isnan(np.sum(samples))

Out[37]: False

In [38]: np.isnan(np.sum(label))

Out[38]: False

要针对数据中的NaN值逐元素进行测试,可以使用isnan()方法。 此方法将返回一个布尔数组。 对于大型数组而言,检测它是否返回true可能很麻烦。 在这种情况下,您可以将数组的np.sum()用作isnan()的参数,这样它将为结果返回单个布尔值。

在本节中,您将深入研究数据并进行常规质量检查。 在下一节中,我们将继续进行基本统计。

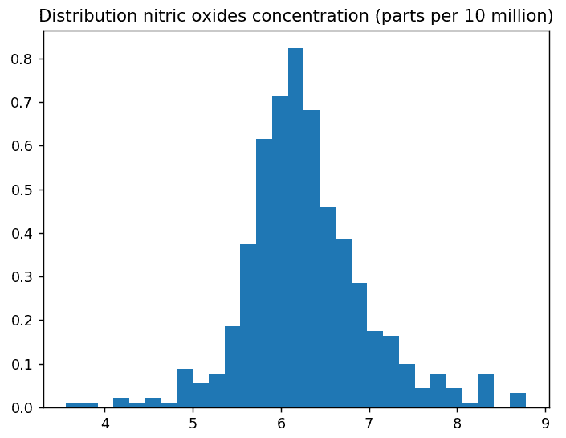

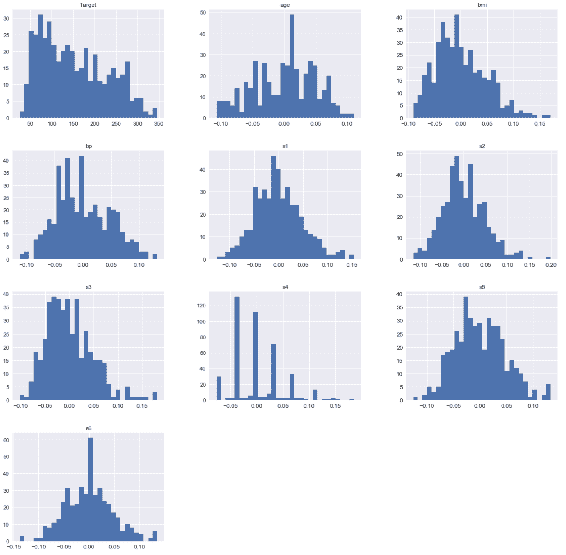

查看基本统计量

在本节中,您将从统计分析的第一步开始,计算数据集的基本统计信息。 即使 NumPy 的内置统计函数有限,我们也可以将其与 SciPy 结合使用。 在开始之前,让我们描述一下我们的分析将如何进行。 所有特征列和标签列都是数字,但您可能已经注意到 Charles River 虚拟变量(CHAS)列具有二进制值(0, 1),这意味着它实际上是根据分类数据编码的。 分析数据集时,可以将列分为Categorical和Numerical。 为了一起分析它们,应将一种类型转换为另一种类型。 如果您具有分类值,并且想要将其转换为数字值,则可以通过将每个类别转换为数字值来实现。 该过程称为编码。 另一方面,可以通过将数值转换为类别对应物来执行装箱,类别对应物是通过将数据分成间隔来创建的。

我们将通过逐一探讨其特征来开始分析。 在统计中,此方法称为单变量分析。 单变量分析的目的主要围绕描述。 我们将计算最小值,最大值,范围,百分位数,均值和方差,然后绘制一些直方图并分析每个特征的分布。 我们将介绍偏度和峰度的概念,然后看一下修剪的重要性。 完成单变量分析后,我们将继续进行双变量分析,这意味着同时分析两个特征。 为此,我们将探索两组特征之间的关系:

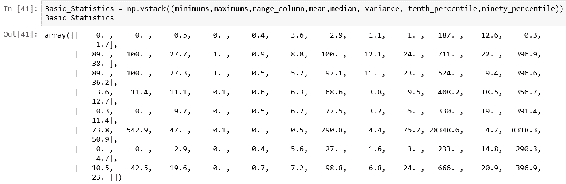

In [39]: np.set_printoptions(suppress=True, linewidth=125)

minimums = np.round(np.amin(samples, axis=0), decimals=1)

maximums = np.round(np.amax(samples, axis=0), decimals=1)

range_column = np.round(np.ptp(samples, axis=0), decimals=1)

mean = np.round(np.mean(samples, axis=0), decimals=1)

median = np.round(np.median(samples, axis=0), decimals=1)

variance = np.round(np.var(samples, axis=0), decimals=1)

tenth_percentile = np.round(np.percentile(samples, 10, axis=0), decimals = 1)

ninety_percentile = np.round(np.percentile(samples, 90 ,axis=0), decimals = 1)

In [40]: range_column

Out[40]: array([ 89\. , 100\. , 27.3, 1\. , 0.5, 5.2, 97.1, 11\. , 23\. , 524\. , 9.4, 396.6, 36.2])

在前面的代码中,我们首先使用set_printoptions()方法设置打印选项,以便查看四舍五入的小数位数,并且其线宽足以容纳所有列。 要计算基本统计信息,我们使用numpy函数,例如amin(),amax(),mean(),median(),var(),percentile()和ptp()。 所有计算都是按列进行的,因为每一列都代表一个要素。 最终的数组看起来有点草率且无用,因为您看不到哪行显示了哪些统计信息:

为了打印对齐的 numpy 数组,可以使用zip()函数添加行标签并在数组之前打印列标签。 在 SciPy 中,您可以使用更多统计函数来计算基本统计信息。 SciPy 提供describe()函数,该函数返回给定数组的一些描述性统计信息。 您可以使用一个函数来计算点,最小值,最大值,均值,方差,偏度和峰度,然后分别解析它们,如下所示:

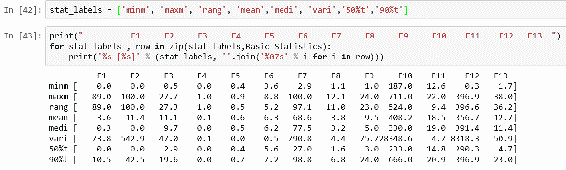

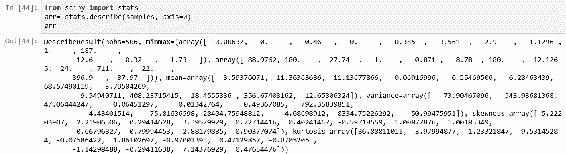

以下代码块分别计算基本统计信息并将其堆叠到最终数组中:

In [45]: minimum = arr.minmax[0]

maximum = arr.minmax[1]

mean = arr.mean

median = np.round(np.median(samples,axis = 0), decimals = 1)

variance = arr.variance

tenth_percentile = stats.scoreatpercentile(samples, per = 10, axis = 0)

ninety_percentile = stats.scoreatpercentile(samples, per =90, axis = 0)

rng = stats.iqr(samples, rng = (20,80), axis = 0)

np.set_printoptions(suppress = True, linewidth = 125)

Basic_Statistics1 = np.round(np.vstack((minimum,maximum,rng, mean,median,variance,tenth_percentile,ninety_percentile)), Basic_Statistics1.shape

Out[45]: (8, 13)

In [46]: stat_labels1 = ['minm', 'maxm', 'rang', 'mean', 'medi', 'vari', '50%t', '90%t']

与 NumPy 相比,我们可以使用iqr()函数来计算范围。 此函数计算沿指定轴和范围(rng参数)的数据的四分位数范围。 默认情况下,rng = (25, 75),这意味着该函数将计算数据的第 75 和第 25 个百分位数之间的差。 为了返回与numpy.ptp()函数相同的输出,可以使用rng = (0, 100),因为这将计算所有给定数据的范围。 我们使用stat.scoreatpercentile()作为与numpy.percentile()方法的等效物,来计算特征的第 10 个和第 90 个百分位值。 如果您看一眼结果,您会发现几乎每个特征的差异都很大。 您可以看到,由于我们通过将参数传递为(20,80)来限制范围计算,因此范围值显着减小。 它也向您展示了我们在分布式要素的两侧都有许多极值。 从我们的结果可以得出结论,对于大多数特征,平均值均高于中位数,这表明我们这些特征的分布偏向右侧。 在下一节中,当我们绘制直方图然后深入分析这些特征的偏度和峰度时,您将清楚地看到这一点。

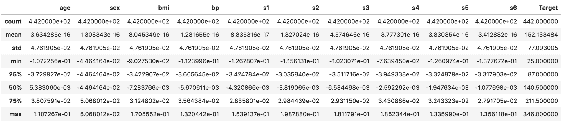

计算直方图

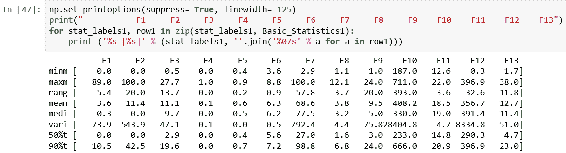

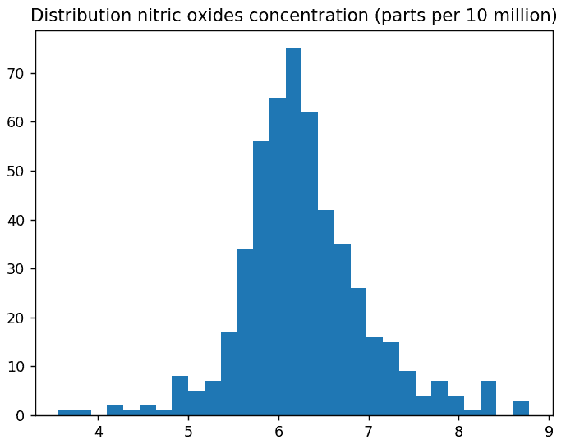

直方图是数字数据分布的直观表示。 一百多年前,卡尔·皮尔森(Karl Pearson)首次提出了这一概念。 直方图是一种用于连续数据的条形图,而条形图直观地表示类别变量。 第一步,您需要将整个值范围划分为一系列间隔(仓位)。 每个桶必须相邻,并且它们不能重叠。 通常,桶大小相等,要包含的桶数量的经验法则是 5–20。 这意味着,如果您有 20 个以上的容器,则图形将很难阅读。 相反,如果您的箱数少于 5 个,则您的图形将很少了解数据的分布:

In [48]: %matplotlib notebook

%matplotlib notebook

import matplotlib.pyplot as plt

NOX = samples[:,5:6]

plt.hist(NOX,bins ='auto')

plt.title("Distribution nitric oxides concentration (parts per 10 million)")

plt.show()

在前面的代码中,我们绘制了特征NOX的直方图。 箱柜计算自动完成,如下所示:

您可以通过将切片数组作为第一个参数,使用pyplot.hist()绘制直方图。 y 轴显示数据集中每个间隔(桶)中有多少值的计数, x 轴表示其值。 通过设置normed=True,您可以看到箱柜的百分比,如下所示:

In [49]: plt.hist(NOX,bins ='auto', normed = True)

plt.title("Distribution nitric oxides concentration (parts per 10 million)")

plt.show()

当您查看直方图时,可能很难计算每个桶及其边界的大小。 当pyplot.hist()返回包含此信息的元组时,您可以轻松地获得这些值,如下所示:

In [50]: import matplotlib.pyplot as plt

NOX = samples[:,5:6]

n, bins, patches = plt.hist(NOX, bins='auto')

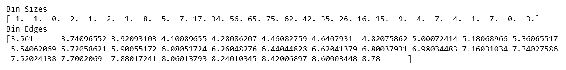

print('Bin Sizes')

print(n)

print('Bin Edges')

print(bins)

在前面的代码中,我们打印出每个桶中包含多少个数字,以及桶的边界是什么,如下所示:

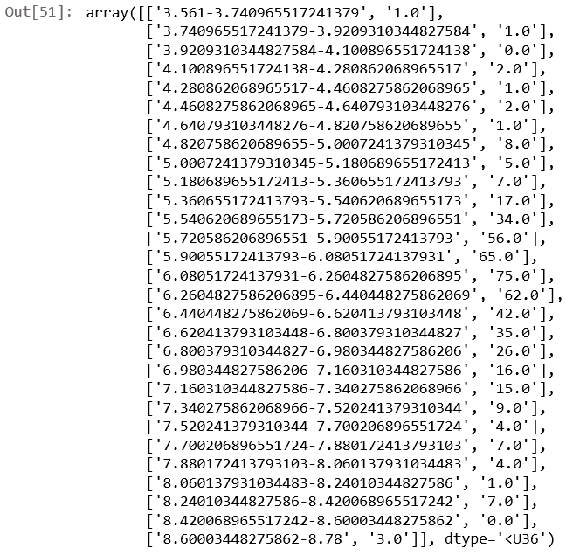

让我们解释一下前面的输出。 第一个桶的大小为1,这意味着此桶中仅存在一个值下降。 第一仓的间隔在3.561和3.74096552之间。 为了使它们更整洁,可以使用以下代码块,该代码块有意义地堆叠了这两个数组(bin_interval,bin_size):

In [51]: bins_string = bins.astype(np.str)

n_string = n.astype(np.str)

lists = []

for i in range(0, len(bins_string)-1):

c = bins_string[i]+ "-" + bins_string[i+1]

lists.append(c)

new_bins = np.asarray(lists)

Stacked_Bins = np.vstack((new_bins, n_string)).T

Stacked_Bins

确定桶的数量及其宽度非常重要。 一些理论家对此进行试验以确定最佳拟合。 下表显示了最受欢迎的估计器。 您可以将估计器设置为numpy.histogram()中的bins参数,以相应地更改桶计算。 这些方法由pyplot.hist()函数隐式支持,因为其参数传递给numpy.histogram():

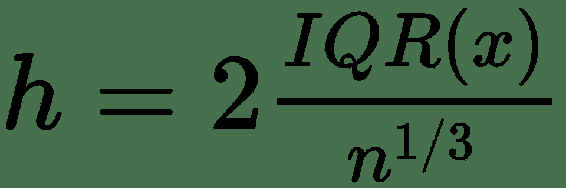

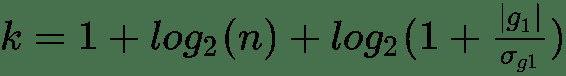

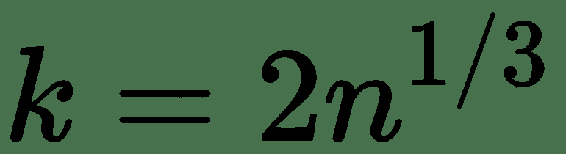

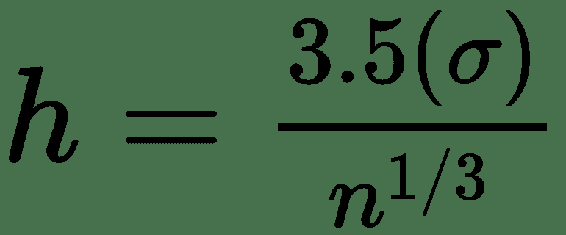

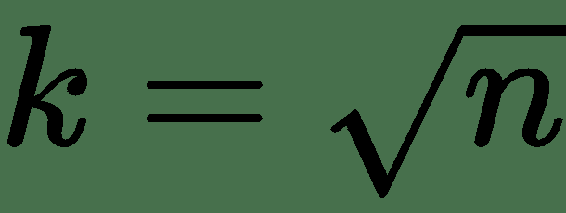

| 估计器 | 公式 |

|---|---|

| Freedman-Diaconis 估计 |  |

| Doane 公式 |  |

| Rice 法则 |  |

| Scott 的常规参考法则 |  |

| Sturges 公式 |  |

| 平方根选项 |  |

IQR =四分位间距

g[1] =分布的估计三阶偏度

所有这些方法都有不同的优势。 例如,Strurges 公式对于高斯数据是最佳的。 Rice 的规则是 Sturges 公式的简化版本,并假定近似正态分布,因此,如果数据不是正态分布,则可能效果不佳。 Doane 的公式是 Sturges 公式的改进版本,尤其是在具有非正态分布的情况下。 Freedman–Diaconis 估计器是 Scott 规则的修改版本,他用IQR=2代替了 3.5 个标准差,这使公式对异常值的敏感性降低。 平方根选择是一种非常常见的方法,许多工具都以其快速简便的方式使用它。 在numpy.histogram()中,还有一个名为'auto'的选项,它为我们提供了最大的 Sturges 和 Freedman–Diaconis 估计器方法。 让我们看看这些方法将如何影响直方图:

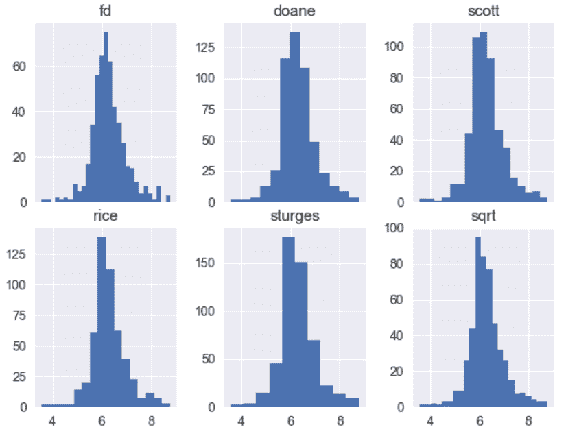

In [52]: fig, ((ax1, ax2, ax3),(ax4,ax5,ax6)) = plt.subplots(2,3,sharex=True)

axs = [ax1,ax2,ax3,ax4,ax5,ax6]

list_methods = ['fd','doane', 'scott', 'rice', 'sturges','sqrt']

plt.tight_layout(pad=1.1, w_pad=0.8, h_pad=1.0)

for n in range(0, len(axs)):

axs[n].hist(NOX,bins = list_methods[n])

axs[n].set_title('{}'.format(list_methods[n]))

在前面的代码中,我们编译了六个直方图,它们全部共享相同的 x 轴,如下所示:

所有直方图都表示相同的特征,但具有不同的合并方法。 例如,fd方法显示数据看起来接近其正态分布,而另一方面,doane方法看起来更像学生的 T 分布。 另外,sturges方法会创建两个小容器,因此很难分析数据。 当我们查看基本统计数据时,我们指出大多数特征的均值均高于其中位数,因此他们将数据向右倾斜。 但是,如果您查看sturges,rice和sqrt方法,则很难这么说。 但是,当我们使用自动箱绘制直方图时,这是显而易见的:

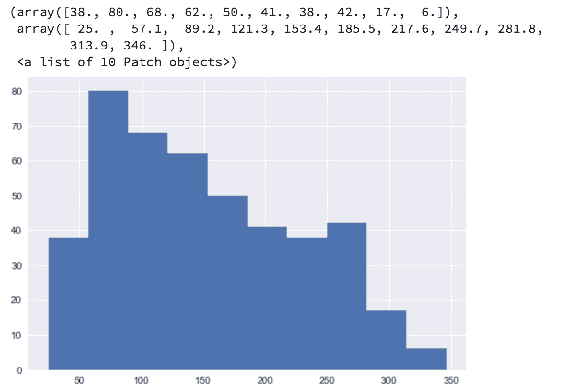

In [53]: import numpy as np

samples_new = np.delete(samples, 3 , axis=1)

samples_new.shape

Out[53]: (506, 12)

In [54]: %matplotlib notebook

%matplotlib notebook

import matplotlib.pyplot as plt

fig,((ax1, ax2 , ax3),(ax4, ax5, ax6), (ax7, ax8, ax9), (ax10, ax11, ax12)) = plt.subplots(4,3, figsize = (10,15))

axs =[ax1, ax2 , ax3, ax4, ax5, ax6, ax7, ax8, ax9, ax10, ax11, ax12]

feature_names_new = np.delete(feature_names,3)

for n in range(0, len(axs)):

axs[n].hist(samples_new[:,n:n+1], bins ='auto', normed = True)

axs[n].set_title('{}'.format(feature_names[n]))

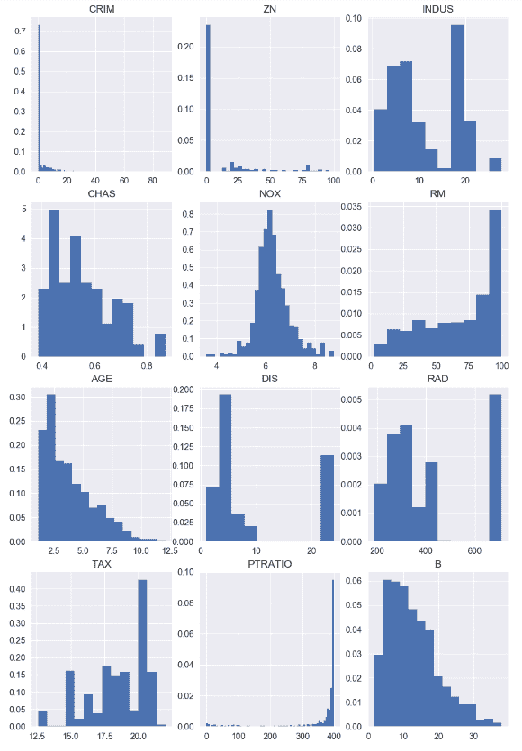

在前面的代码中,我们在单个布局中编译所有特征直方图。 这将帮助我们轻松比较它们。 前面代码的输出如下:

在前面的代码中,我们删除了CHAS,因为它包含二进制值,这意味着直方图将无助于我们进一步了解此特征。 我们还从特征列表中取出了特征名称,以便正确绘制其余特征。

从这些图表我们可以得出结论,在大多数城镇中,人均犯罪率非常低,但是在某些城镇中,这一比例非常高。 通常,住宅用地面积低于 25,000 英尺。在许多情况下,非零售业务用地所占土地不到整个城镇的 10% 。 另一方面,我们可以看到许多城镇的非零售业务用地约为 20% 。 一氧化氮的浓度非常偏斜,尽管此处存在一些离平均值很远的异常值。 每个住宅的平均房间数在 5 至 7 间之间。 在 1940 年之前建造的架构物中,超过 50% 的架构物被其所有者占用。 他们中的大多数人离波士顿的就业中心都不远。 超过 10% 的人无法轻松到达径向公路。 对于相当多的人来说,财产税很高。 通常,教室规模为 15 至 20 个孩子。 大多数城镇中居住的黑人比例非常相似。 大多数城镇居民的经济地位较低。 通过查看这些直方图,您可以得出许多其他结论。 如您所见,直方图在描述数据的分布方式时非常有用,并且可以看到平均值,方差和离群值。 在下一节中,我们将重点介绍偏度和峰度。

解释偏度和峰度

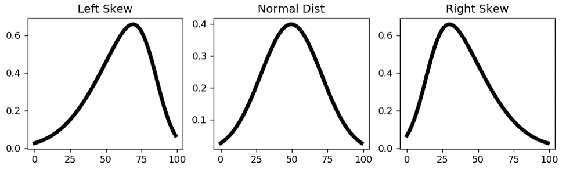

在统计分析中,力矩是一种定量度量,用于描述距参考点的预期距离。 如果期望参考点,则将其称为中心矩。 在统计中,中心矩是与均值相关的矩。 第一个和第二个矩分别是平均值和方差。 平均值是您的数据点的平均值。 方差是每个数据点与平均值的总偏差。 换句话说,方差表明您的数据如何与均值分散。 第三个中心矩是偏度,它测量均值分布的不对称性。 在标准正态分布中,偏度是对称的,因此等于零。 另一方面,如果均值

In [55]: %matplotlib notebook

%matplotlib notebook

from scipy.stats import skewnorm

fig, (ax1, ax2, ax3) = plt.subplots(1,3 ,figsize=(10,2.5))

x1 = np.linspace(skewnorm.ppf(0.01,-3), skewnorm.ppf(0.99,-3),100)

x2 = np.linspace(skewnorm.ppf(0.01,0), skewnorm.ppf(0.99,0),100)

x3 = np.linspace(skewnorm.ppf(0.01,3), skewnorm.ppf(0.99,3),100)

ax1.plot(skewnorm(-3).pdf(x1),'k-', lw=4)

ax2.plot(skewnorm(0).pdf(x2),'k-', lw=4)

ax3.plot(skewnorm(3).pdf(x3),'k-', lw=4)

ax1.set_title('Left Skew')

ax2.set_title('Normal Dist')

ax3.set_title('Right Skew')

您可以使用skewnorm()函数轻松创建具有偏斜度的正态分布。 如您在前面的代码中看到的,我们生成一个具有 100 个值的百分点函数(与累积分布函数百分位数相反),然后创建具有不同偏斜度的线。 您不能直接得出结论,左偏斜比右偏斜好,反之亦然。 当分析数据的偏斜度时,您需要考虑这些尾巴会导致什么。 例如,如果您正在分析股票收益的时间序列,并将其绘制后看到一个正确的偏斜,则不必担心获得比预期更高的收益,因为这些离群值不会给您的股票带来任何风险。 交易策略。 当您分析服务器的响应时间时,可能会出现类似的示例。 当您绘制响应时间的概率密度函数时,您对左尾巴并不真正感兴趣,因为它们代表了快速的响应时间。

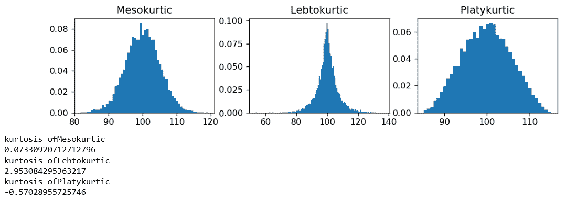

关于均值的第四个中心矩是峰度。 峰度描述了与分布曲线的平坦程度或变薄程度有关的尾部(离群值)。 在正态分布中,峰度等于 3。峰度主要有三种类型:Leptokurtic(薄),Mesokurtic和Platykurtic(平坦):

In [56]: %matplotlib notebook

%matplotlib notebook

import scipy

from scipy import stats

import matplotlib.pyplot as plt

fig, (ax1, ax2, ax3) = plt.subplots(1, 3 , figsize=(10,2))

axs= [ax1, ax2, ax3]

Titles = ['Mesokurtic', 'Lebtokurtic', 'Platykurtic']

#Mesokurtic Distribution - Normal Distribution

dist = scipy.stats.norm(loc=100, scale=5)

sample_norm = dist.rvs(size = 10000)

#leptokurtic Distribution

dist2 = scipy.stats.laplace(loc= 100, scale= 5)

sample_laplace = dist2.rvs(size= 10000)

#platykurtic Distribution

dist3 = scipy.stats.cosine(loc= 100, scale= 5)

sample_cosine = dist3.rvs(size= 10000)

samples = [sample_norm, sample_laplace, sample_cosine]

for n in range(0, len(axs)):

axs[n].hist(samples[n],bins= 'auto', normed= True)

axs[n].set_title('{}'.format(Titles[n]))

print ("kurtosis of" + Titles[n])

print(scipy .stats.describe(samples[n])[5])

在前面的代码中,您可以更清楚地看到分布形状的差异。 所有峰度值均使用stats.describe()方法进行归一化,因此正态分布的实际峰度值约为 3,而归一化版本为 0.02。 让我们快速检查一下我们特征的偏度和峰度值是什么:

In [57]: samples,label, feature_names = dataset.data , dataset.target , dataset.feature_names

for n in range(0, len(feature_names_new)):

kurt = scipy.stats.describe(samples[n])[5]

skew = scipy.stats.describe(samples[n])[4]

print (feature_names_new[n] + "-Kurtosis: {} Skewness: {}" .format(kurt, skew))

CRIM-Kurtosis: 2.102090573040533 Skewness: 1.9534138515494224

ZN-Kurtosis: 2.8706349006925134 Skewness: 2.0753333576721893

INDUS-Kurtosis: 2.9386308786131767 Skewness: 2.1061627843164086

NOX-Kurtosis: 3.47131446484547 Skewness: 2.2172838215060517

RM-Kurtosis: 3.461596258869246 Skewness: 2.2086627738768234

AGE-Kurtosis: 3.395079726813977 Skewness: 2.1917520072643533

DIS-Kurtosis: 1.9313625761956317 Skewness: 1.924572804475305

RAD-Kurtosis: 1.7633603556547106 Skewness: 1.8601991629604233

TAX-Kurtosis: 1.637076772210217 Skewness: 1.8266096199819994

PTRATIO-Kurtosis: 1.7459544645159752 Skewness: 1.8679592455694167

B-Kurtosis: 1.7375702020429316 Skewness: 1.8566444885400044

LSTAT-Kurtosis: 1.8522036606250456 Skewness: 1.892802610207445

从结果中可以看出,所有特征都具有正偏度,这表明它们向右偏斜。 就峰度而言,它们都具有正值,尤其是 NOX 和 RM,它们具有非常高的色氨酸。 我们可以得出结论,它们全都是瘦腿型的,这表明数据更加集中在均值上。 在下一节中,我们将着重于数据修整并使用修整后的数据计算统计数据。

整理统计量

正如您在上一节中已经注意到的那样,我们特征的分布非常分散。 处理模型中的异常值是分析中非常重要的部分。 当您查看描述性统计数据时,它也非常重要。 由于这些极端值,您很容易混淆并曲解分布。 SciPy 具有非常广泛的统计函数,可以计算有关修剪数据的描述性统计数据。 使用调整后的统计数据的主要思想是删除异常值(尾部),以减少其对统计计算的影响。 让我们看看如何使用这些函数,以及它们如何影响我们的特征分布:

In [58]: np.set_printoptions(suppress= True, linewidth= 125)

samples = dataset.data

CRIM = samples[:,0:1]

minimum = np.round(np.amin(CRIM), decimals=1)

maximum = np.round(np.amax(CRIM), decimals=1)

variance = np.round(np.var(CRIM), decimals=1)

mean = np.round(np.mean(CRIM), decimals=1)

Before_Trim = np.vstack((minimum, maximum, variance, mean))

minimum_trim = stats.tmin(CRIM, 1)

maximum_trim = stats.tmax(CRIM, 40)

variance_trim = stats.tvar(CRIM, (1,40))

mean_trim = stats.tmean(CRIM, (1,40))

After_Trim = np.round(np.vstack((minimum_trim,maximum_trim,variance_trim,mean_trim)), decimals=1)

stat_labels1 = ['minm', 'maxm', 'vari', 'mean']

Basic_Statistics1 = np.hstack((Before_Trim, After_Trim))

print (" Before After")

for stat_labels1, row1 in zip(stat_labels1, Basic_Statistics1):

print ('%s [%s]' % (stat_labels1, ''.join('%07s' % a for a in row1)))

Before After

minm [ 0.0 1.0]

maxm [ 89.0 38.4]

vari [ 73.8 48.1]

mean [ 3.6 8.3]

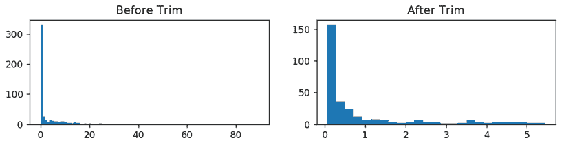

要计算调整后的统计信息,我们使用了tmin(),tmax(),tvar()和tmean(),如前面的代码所示。 所有这些函数都将极限值作为第二个参数。 在CRIM函数中,我们可以在右侧看到很多尾巴,因此我们将数据限制为(1, 40),然后计算统计信息。 在修整值之前和之后,您可以通过比较计算的统计信息来观察差异。 作为tmean()的替代方法,如果要从两侧按比例分割数据,可以使用trim_mean()函数。 您可以看到我们的均值和方差在修剪数据后如何显着变化。 当我们删除了 40 至 89 之间的许多极端离群值时,方差显着减小。相同的修整对均值有不同的影响,此后均值增加了一倍以上。 原因是先前的分布中有很多零,并且通过将计算限制在 1 和 40 的值之间,我们删除了所有这些零,这导致了更高的平均值。 请注意,上述所有函数只是在计算这些值时即时修剪数据,因此CRIM数组不会被修剪。 如果要从两侧修剪数据,则可以在一侧使用trimboth()和trim1()。 在这两种方法中,应该使用比例作为参数,而不是使用极限值。 例如,如果您传递proportiontocut =0.2,它将把您最左边和最右边的值切成 20% :

In [59]: %matplotlib notebook

%matplotlib notebook

import matplotlib.pyplot as plt

CRIM_TRIMMED = stats.trimboth(CRIM, 0.2)

fig, (ax1, ax2) = plt.subplots(1,2 , figsize =(10,2))

axs = [ax1, ax2]

df = [CRIM, CRIM_TRIMMED]

list_methods = ['Before Trim', 'After Trim']

for n in range(0, len(axs)):

axs[n].hist(df[n], bins = 'auto')

axs[n].set_title('{}'.format(list_methods[n]))

从两侧修剪掉 20% 的值后,我们可以更好地解释分布,实际上可以看到大多数值在 0 到 1.5 之间。 仅查看左方的直方图就很难获得这种见解,因为极值主导了直方图,并且我们只能看到 0 周围的一条线。因此,trimmed函数在探索性数据分析中非常有用。 在下一部分中,我们将重点讨论箱形图,它们对于数据的描述性分析和异常值检测非常有用且非常流行。

箱形图

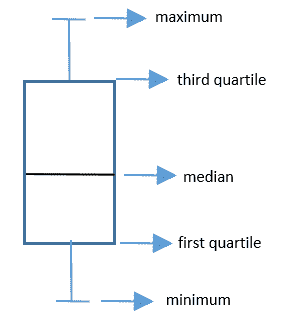

探索性数据分析中的另一个重要视觉效果是箱形图,也称为箱须图。 它基于五位数摘要建立,该摘要是最小值,第一四分位数,中位数,第三四分位数和最大值。 在标准箱形图中,这些值表示如下:

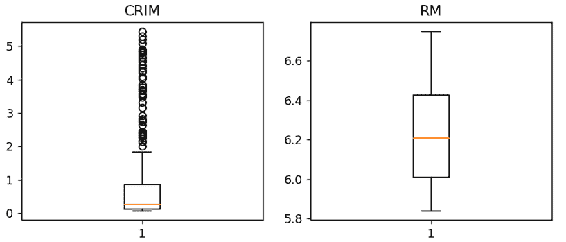

这是比较几种分布的一种非常方便的方法。 通常,情节的胡须通常延伸到极限点。 或者,您可以将其切入 1.5 个四分位范围。 让我们检查一下CRIM和RM函数:

In [60]: %matplotlib notebook

%matplotlib notebook

import matplotlib.pyplot as plt

from scipy import stats

samples = dataset.data

fig, (ax1,ax2) = plt.subplots(1,2, figsize =(8,3))

axs = [ax1, ax2]

list_features = ['CRIM', 'RM']

ax1.boxplot(stats.trimboth(samples[:,0:1],0.2))

ax1.set_title('{}'.format(list_features[0]))

ax2.boxplot(stats.trimboth(samples[:,5:6],0.2))

ax2.set_title('{}'.format(list_features[1]))

正如您在前面的代码中看到的那样,RM 值一直沿最小值和最大值连续分散,以便胡须看起来像一条线。 您可以轻松地检测到中位数几乎位于第一和第三四分位数之间的中间位置。 在CRIM中,极值不会沿着最小值继续; 它们更像是单个外围数据点,因此表示就像一个圆圈。 您可以看到这些离群值大多位于第三个四分位数之后,并且中位数非常接近第一个四分位数。 由此,您还可以得出结论,分布是右偏的。 因此,箱形图是直方图的非常有用的替代方法,因为您可以轻松分析分布并一次比较多个分布。 在下一节中,我们将继续进行双变量分析,并研究标签数据与要素的相关性。

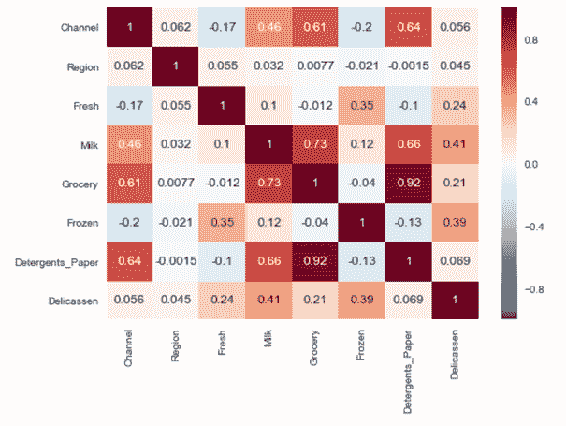

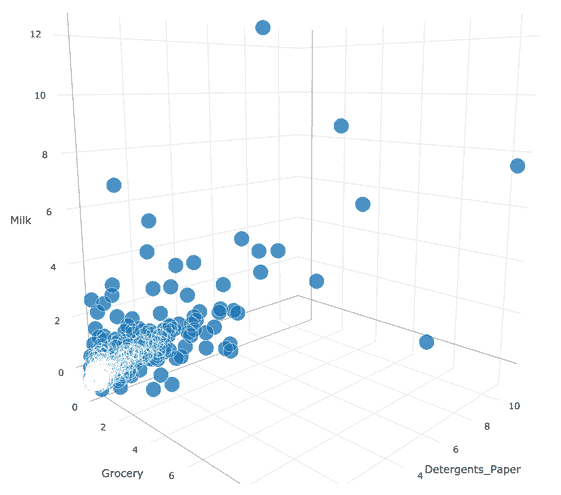

计算相关性

本节专门用于双变量分析,您可以在其中分析两列。 在这种情况下,我们通常研究这两个变量之间的关联,这称为相关性。 相关性显示两个变量之间的关系,并回答一些问题,例如,如果变量 B 增加 10% ,变量 A 将会发生什么? 在本节中,我们将说明如何计算数据的相关性并以二维散点图表示它。

通常,相关是指任何统计依赖性。 相关系数是计算相关度量的定量值。 您可以将相关性和相关系数之间的关系视为湿度计和湿度之间的相似关系。 相关系数最流行的类型之一是皮尔逊积矩相关系数。 相关系数的值在 +1 和 -1 之间,其中 -1 表示两个变量之间的强负线性关系,而 +1 表示两个变量之间的强正线性关系。 在 NumPy 中,我们可以使用corrcoef()方法来计算系数相关矩阵,如下所示:

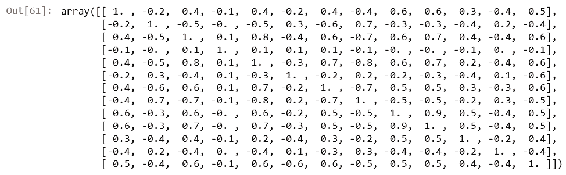

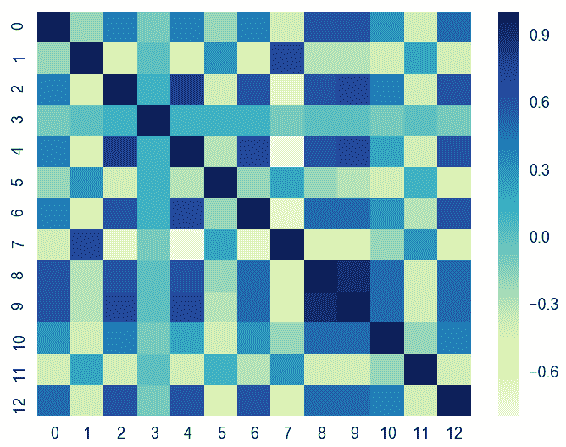

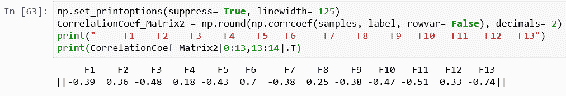

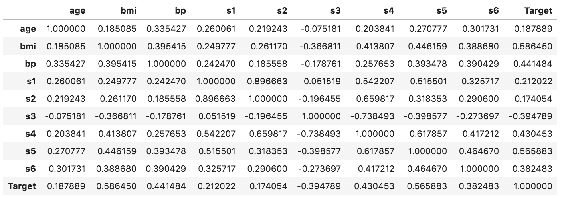

In [61]: np.set_printoptions(suppress= True, linewidth = 125)

CorrelationCoef_Matrix = np.round(np.corrcoef(samples, rowvar= False), decimals= 1)

CorrelationCoef_Matrix

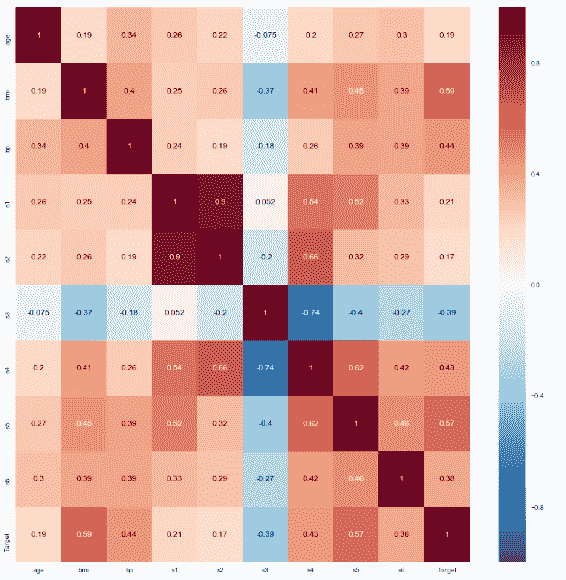

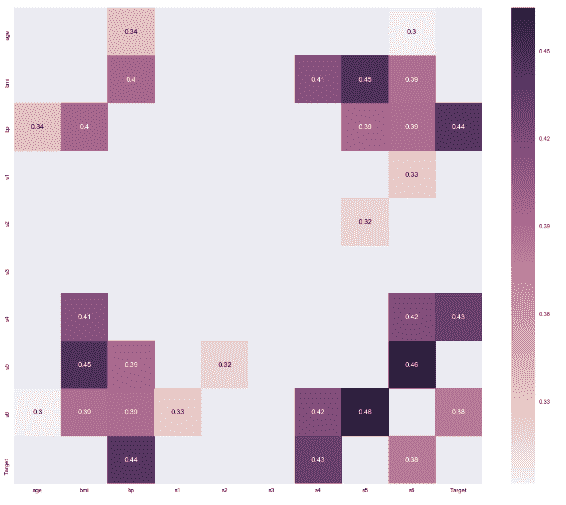

Seaborn 是一个基于 matplotlib 的统计数据可视化库,您可以使用它创建非常吸引人的美观统计图形。 它是一个非常受欢迎的库,具有精美的可视化效果,并且与流行的软件包(尤其是 Pandas)具有完美的兼容性。 您可以使用seaborn程序包中的热图来形象化相关系数矩阵。 当您具有数百种特征时,它对于检测高相关系数非常有用:

In [62]: CorrelationCoef_Matrix1 = np.round(np.corrcoef(samples, rowvar= False), decimals= 1)

CorrelationCoef_Matrix1

import seaborn as sns; sns.set()

ax = sns.heatmap(CorrelationCoef_Matrix1, cmap= "YlGnBu")

在这里,我们具有标签列特征的相关系数。 您可以在corrcoef()函数中添加其他变量集作为第二个参数,就像我们对label列所做的那样,如下面的屏幕快照所示。 只要形状相同,该函数将在最后堆叠此列并计算相关系数矩阵:

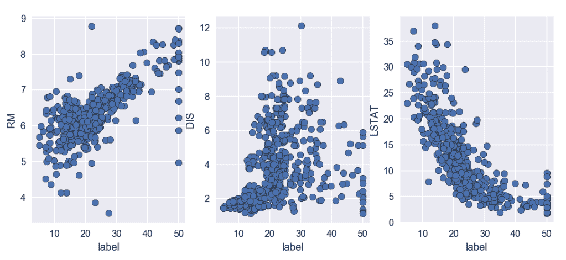

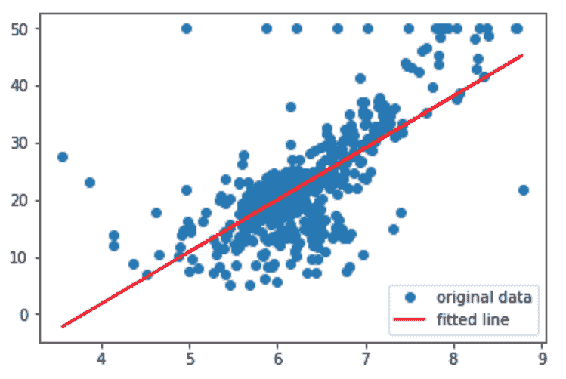

如您所见,除了F13之外,大多数特征都具有弱或中等的负线性关系。 另一方面,F6具有很强的正线性关系。 让我们绘制此特征并用散点图查看这种关系。 以下代码块借助matplotlib显示了三个不同的特征散点图(RM,DIS和LSTAT)和一个标签列:

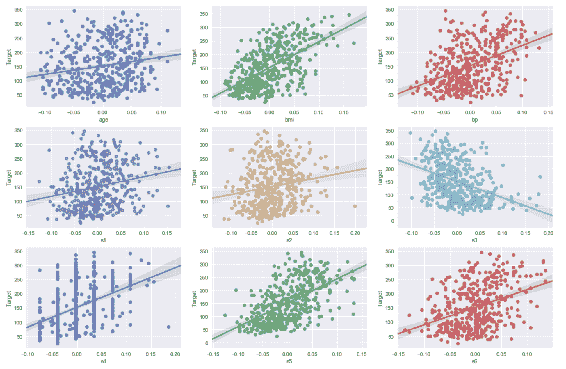

In [64]: %matplotlib notebook

%matplotlib notebook

import matplotlib.pyplot as plt

from scipy import stats

fig, (ax1, ax2, ax3) = plt.subplots(1,3 ,figsize= (10,4))

axs =[ax1,ax2,ax3]

feature_list = [samples[:,5:6], samples[:,7:8], samples[:,12:13]]

feature_names = ["RM", "DIS", "LSTAT"]

for n in range(0, len(feature_list)):

axs[n].scatter(label, feature_list[n], edgecolors=(0, 0, 0))

axs[n].set_ylabel(feature_names[n])

axs[n].set_xlabel('label')

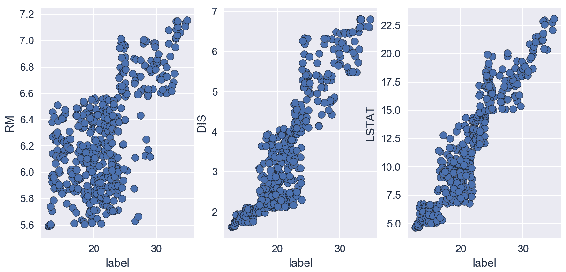

在前面的代码中,RM 和标签值分散为一条正线性线,这与相关系数值为 0.7 一致,如前面的屏幕快照所示。 散点图表明样品的 RM 值越高,标签的值越高。 在中间的散点图中,您可以看到系数相关性等于 0.25 的位置。 这显示出非常弱的正线性相关性,这在散点图中也可以看到。 我们可以得出结论,由于值分散在各处,因此没有明确的关系。 第三个散点图显示了强大的线性关系,相关系数为 -0.7。 随着LSTAT下降,标签值开始增加。 所有这些相关矩阵和散点图均使用未修剪的数据对此进行了计算。 让我们看看如何针对每个要素和标签从两侧修剪数据 10% 来改变数据集的线性关系结果:

In [65]: %matplotlib notebook

%matplotlib notebook

import matplotlib.pyplot as plt

from scipy import stats

fig, (ax1, ax2, ax3) = plt.subplots(1,3 ,figsize= (9,4))

axs = [ax1, ax2, ax3]

RM_tr = stats.trimboth(samples[:,5:6],0.1)

label_tr = stats.trimboth(label, 0.1)

LSTAT_tr = stats.trimboth(samples[:,12:13],0.1)

DIS_tr = stats.trimboth(samples[:,7:8],0.1)

feature_names = ["RM", "DIS", "LSTAT"]

feature_list = [RM_tr, DIS_tr, LSTAT_tr]

for n in range(0, len(feature_list)):

axs[n].scatter(label_tr,feature_list[n], edgecolors=(0, 0, 0))

axs[n].set_ylabel(feature_names[n])

axs[n].set_xlabel('label')

修剪数据后,您可以看到所有特征都与标签具有很强的正线性相关性,尤其是DIS和LSTAT的相关性,其中标签发生了巨大变化。 这显示了修剪的力量。 如果您不知道如何处理异常值,则很容易误解您的数据。 离群值可以更改分布的形状以及其他变量之间的相关性,最终它们可以影响模型的性能。

总结

在本章中,我们介绍了使用 NumPy,SciPy,matplotlib 和 Seaborn 软件包进行探索性数据分析的过程。 首先,我们学习了如何加载和保存文件以及探索数据集。 然后,我们解释并计算了重要的统计中心矩,例如均值,方差,偏度和峰度。 四个重要的可视化分别用于单变量和变量分析的图形表示; 这些是直方图,箱形图,散点图和热图。 还通过示例强调了数据修整的重要性。

在下一章中,我们将更进一步,并开始使用线性回归预测房价。

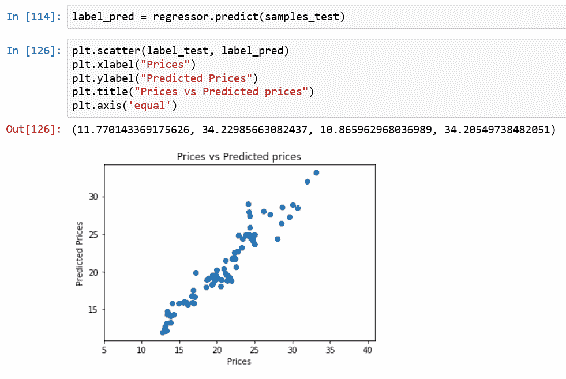

四、使用线性回归预测房价

在本章中,我们将通过实现线性回归来介绍监督学习和预测建模。 在上一章中,您了解了探索性分析的知识,但尚未研究建模。 在本章中,我们将创建一个线性回归模型来预测房地产市场价格。 广义上讲,我们将借助目标变量与其他变量的关系来预测目标变量。 线性回归被广泛使用,并且是监督机器学习算法的简单模型。 本质上是关于为观察到的数据拟合一条线。 我们将从解释监督学习和线性回归开始我们的旅程。 然后,我们将分析线性回归的关键概念,例如自变量和因变量,超参数,损失和误差函数以及随机梯度下降。 对于建模,我们将使用与上一章相同的数据集。

本章将介绍以下主题:

- 监督学习和线性回归

- 自变量和因变量

- 超参数

- 损失和误差函数

- 为单个变量实现我们的算法

- 计算随机梯度下降

- 使用线性回归建模房价

监督学习和线性回归

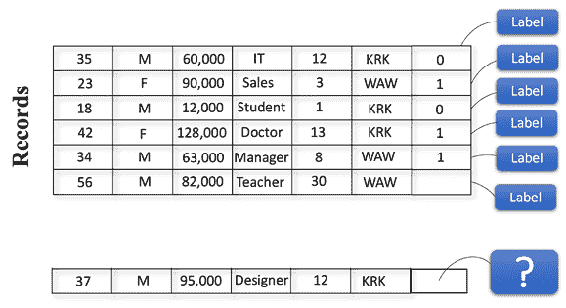

机器学习使计算机系统无需显式编程即可学习。 监督学习是最常见的机器学习类型之一。 监督学习由一组不同的算法组成,这些算法提出学习问题并通过使用历史数据映射输入和输出来解决它们。 该算法分析输入和相应的输出,然后将它们链接在一起以找到关系(学习)。 最后,对于新的给定数据集,它将使用此学习来预测输出。

为了区分监督学习和非监督学习,我们可以考虑基于输入/输出的建模。 在监督学习中,将对计算机系统的每组输入数据使用标签进行监督。 在无监督学习中,计算机系统将仅使用没有任何标签的输入数据。

例如,假设我们有 100 万张猫和狗的照片。 在监督学习中,我们标记输入数据并声明给定的照片是猫还是狗。 假设每张照片(输入数据)有 20 个特征。 标有照片的计算机系统将知道照片是猫还是狗(输出数据)。 当我们向计算机系统显示一张新照片时,它将通过分析新照片的 20 个特征来确定它是猫还是狗,并根据其先前的学习进行预测。 在无监督学习中,我们将只拥有 100 万张猫和狗的照片,而没有任何标签说明是猫还是狗的照片,因此该算法将在没有我们监督的情况下通过分析其特征来对数据进行聚类。 聚类完成后,会将新照片输入到无监督学习算法中,系统会告诉我们该照片属于哪个聚类。

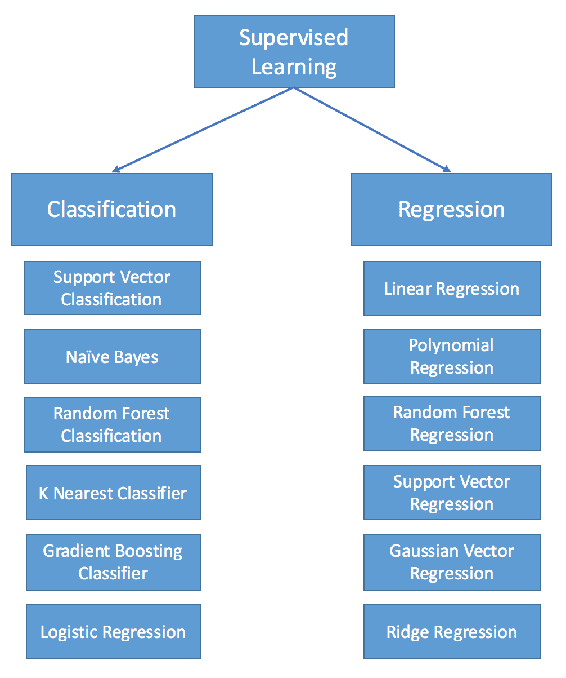

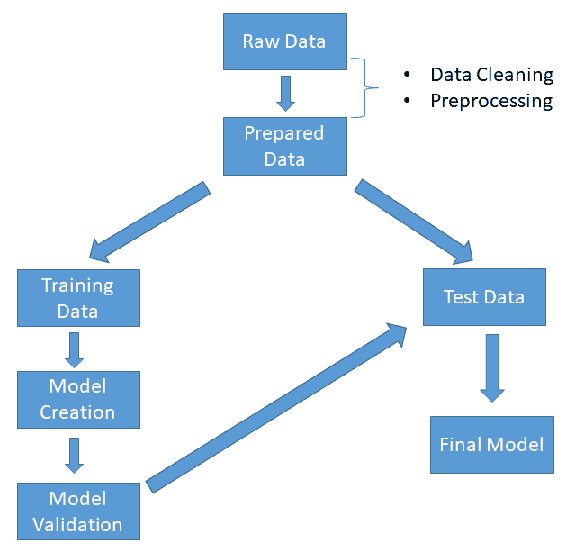

在这两种情况下,系统都将具有简单或复杂的决策算法。 唯一的区别是是否有任何初始监督。 监督学习方法的概述方案如下:

监督学习可以分为分类和回归两种类型,如上图所示。 分类模型预测标签。 例如,可以将前面的示例视为监督分类问题。 为了执行分类,我们需要训练分类算法,例如支持向量分类器(SVC),随机森林, K 近邻(KNN),依此类推。 基本上,分类器是指用于对数据进行分类(分类)的算法。

当我们的目标变量是分类变量时使用分类方法,而当我们的目标变量是连续变量时,则应用回归模型,因为目标是预测数值而不是类别。

考虑一下我们在上一章中使用的数据集:波士顿房屋价格数据集。 在该数据集中,我们的目的是对特征值进行统计分析,因为我们需要了解特征值的分布方式,其基本统计量以及之间的相互关系。 最后,我们想知道每个特征如何导致房价上涨。 它对正面,负面还是根本没有影响? 如果特征 x 与房屋价格 A 之间存在潜在的影响(关系),则该关系的强弱是多少?

我们试图通过建立模型来预测具有给定特征的房价来回答这些问题。 结果,在为模型提供新特征后,我们期望模型将输出变量生成为连续值(150k,120,154 美元等)。 让我们看一个非常基本的工作流程:

如上图所示,分析从为模型准备数据开始。 在此阶段,我们应该清理数据,处理缺失的值,并提取将要使用的特征。 数据干净后,我们应该将其分为训练数据和测试数据两部分,以测试模型的性能。

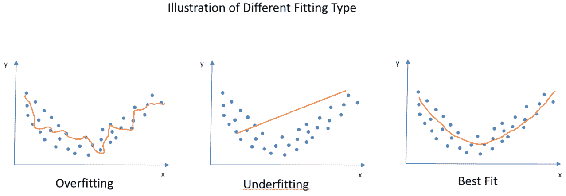

模型验证中的重要部分是过拟合的概念。 用外行的术语来说,过度拟合意味着从训练数据集中学到太多,因此我们的模型过度拟合并为训练数据集产生近乎完美的结果。 但是,对于从未见过的数据,它的灵活性不足以产生良好的结果,因此无法很好地泛化。

可以将数据集分为训练,验证(强烈推荐)和测试数据集来解决此问题。 训练数据是算法最初学习算法参数(权重)并在其中将误差最小化的地方建立模型的地方。 当您有几种算法并且需要调整超参数时,或者当算法中有许多参数并且需要调整参数时,平移数据集非常有用。 测试数据集用于性能评估。

简而言之,您可以使用训练数据来训练算法,然后在验证数据集中微调算法的参数或权重,最后一步,在测试数据集中测试调整后的算法的性能。

与过度拟合相反的情况是欠拟合,这意味着该算法从数据中学习得更少,并且我们的算法与我们的观察结果不太吻合。 让我们以图形方式查看过度拟合,欠拟合和最佳拟合的样子:

您可能已经注意到,在上图中,即使过度拟合看起来非常合适,它也会生成一个回归线,该回归线对于该数据集非常独特,并且无法正确捕获特征。 第二个图,即欠拟合图,实际上无法捕获数据的形状。 当我们的数据是非线性的时,它没有从中学习并产生了线性回归线。 第三个图是我们的最佳拟合图,拟合得很好,掌握了分布特征并产生了一条曲线。 我们可以预期,对于此数据集的延续,它不会有令人失望的性能指标。

在本章中,我们将使用线性回归作为有监督的学习方法。 我们将首先解释非常重要的概念,例如自变量和因变量,超参数以及损失和误差函数。 我们还将介绍线性回归的实际示例。 在下一章中,我们将介绍线性回归模型的最重要组成部分:独立变量和因变量。

自变量和因变量

正如我们在前面的小节中提到的,线性回归用于基于其他变量来预测变量的值。 我们正在研究输入变量X与输出变量Y之间的关系。

在线性回归中,因变量是我们要预测的变量。 之所以称其为因变量,是因为线性回归背后的假设。 该模型假设这些变量取决于方程另一侧的变量,这些变量称为独立变量。

在简单回归模型中,模型将解释因变量如何基于自变量而变化。

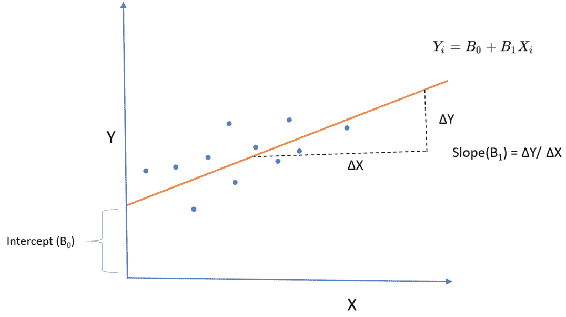

例如,假设我们要分析基于给定产品的价格变化如何影响销售值。 如果您仔细阅读此句子,则可以轻松检测出我们的因变量和自变量。 在我们的示例中,我们假设销售值受价格变化的影响,换句话说,销售值取决于产品的价格。 结果,销售值是从属值,价格是独立的值。 这不一定意味着给定产品的价格不依赖于任何东西。 当然,它取决于许多因素(变量),但是在我们的模型中,我们假设价格是给定的,并且给定的价格会改变销售值。 线性回归线的公式如下:

哪里:

Yi =估计值或因变量

B0 =截距

B1 =斜率

Xi =自变量或探索变量:

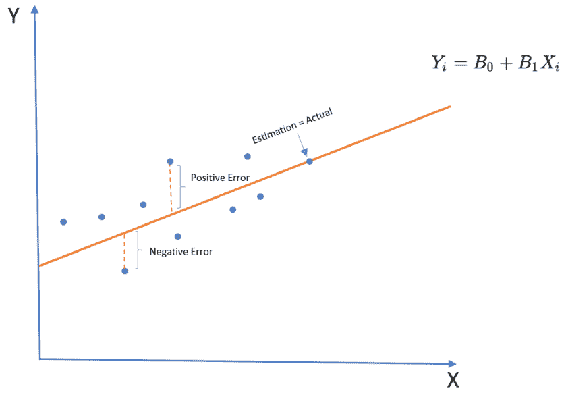

线性回归线的斜率(B1)实际上显示了这两个变量之间的关系。 假设我们将斜率计算为 0.8。 这意味着自变量增加 1 个单位可能会使估计值增加 0.8 个单位。 前面的线性回归线仅生成估计,这意味着它们仅是给定X的Y的预测。 如下图所示,每个观测值和线性线之间有一段距离。 该距离称为误差,这是预期的,在回归线拟合和模型评估中也非常重要:

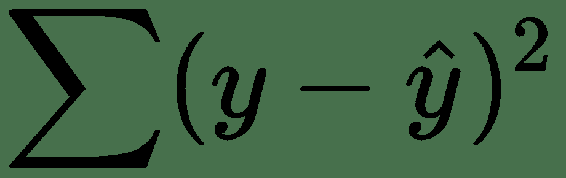

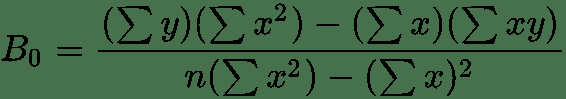

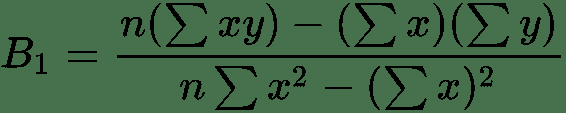

拟合线性回归线的最常见方法是使用最小二乘方法。 该方法通过最小化这些误差的平方和来拟合回归线。 计算公式如下:

这些误差均方根的原因是我们不希望负误差和正误差彼此抵消。 在模型评估中,使用 R 平方,F 检验和均方根误差(RMSE)。 他们都使用平方和(SST)和平方和误差(SSE)作为基本度量。 如您所见,在 SSE 中,我们再次计算预测值和实际值之间的差,取平方并求和,以评估回归线对数据的拟合程度。

如前所述,最小二乘方法旨在最小化平方误差(残差),并找到最适合数据点的斜率和截距值。 由于这是一种封闭形式的解决方案,因此您可以轻松地手动计算它,以便在后台查看此方法的作用。 让我们使用一个包含少量数据集的示例:

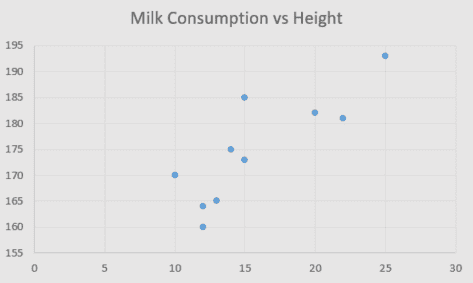

| 牛奶消耗量(每周升) | 身高 |

|---|---|

| 14 | 175 |

| 20 | 182 |

| 10 | 170 |

| 15 | 185 |

| 12 | 164 |

| 15 | 173 |

| 22 | 181 |

| 25 | 193 |

| 12 | 160 |

| 13 | 165 |

假设我们有 10 个观察值,如上表所示,用于每周食用牛奶和食用牛奶的人的身高值。 如果我们绘制这些数据,我们可以看到每日牛奶消耗量与身高之间存在正相关:

现在,我们要使用最小二乘法拟合线性回归线,该方法通过对斜率和截距使用以下公式来完成:

然后,我们需要创建一个表格来帮助我们进行计算,例如x,y,xy,x^2和y^2的总和:

x(牛奶消耗量) |

y(高度) |

xy |

x^2 |

y^2 |

|

|---|---|---|---|---|---|

| 1 | 14 | 175 | 2,450 | 196 | 30,625 |

| 2 | 20 | 182 | 3,640 | 400 | 33,124 |

| 3 | 10 | 170 | 1,700 | 100 | 28,900 |

| 4 | 15 | 185 | 2,775 | 225 | 34,225 |

| 5 | 12 | 164 | 1,968 | 144 | 26,896 |

| 6 | 15 | 173 | 2,595 | 225 | 29,929 |

| 7 | 22 | 181 | 3,982 | 484 | 32,761 |

| 8 | 25 | 193 | 4,800 | 625 | 37,249 |

| 9 | 12 | 160 | 1,920 | 144 | 25,600 |

| 10 | 13 | 165 | 2,145 | 169 | 27,225 |

| ∑ | 158 | 1,748 | 27,975 | 2,712 | 306,534 |

B0 = (1748*2712) - (158*27975) / (10*2712) - (158)^2 = 320526/2156 = 148.66

B1 = (10*27975) - (158*1748) / (10*2712) - (158)^2 = 1.65

然后,我们可以将回归线公式如下:

在本小节中,我们提到了自变量和因变量,并介绍了线性回归线和拟合方法。 在下一节中,我们将介绍超参数,这些参数在回归模型调整中非常有用。

超参数

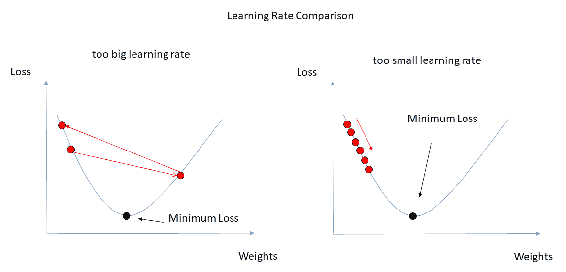

在开始之前,也许最好解释一下为什么我们称它们为超参数而不是参数。 在机器学习中,可以从数据中学习模型参数,这意味着在训练模型时,您可以拟合模型的参数。 另一方面,我们通常在开始训练模型之前先设置超参数。 为了举例说明,您可以将回归模型中的系数视为模型参数。 以超参数为例,我们可以说许多不同模型中的学习率或 K 均值聚类中的聚类数(k)。

另一个重要的事情是模型参数和超参数之间的关系,以及它们如何塑造我们的机器学习模型,换句话说,就是我们模型的假设。 在机器学习中,参数用于配置模型,此配置将为我们的数据集专门定制算法。 我们需要处理的是如何优化超参数。 另外,如上所述,可以在验证期间执行该优化。 在许多情况下,优化超参数将带来性能提升。

您还可以将超参数视为模型参数之上的高级参数。 想象一下您使用无监督学习的 K 均值聚类的情况。 如果您使用误差的群集号(K)作为超参数,则可以确保您的数据不适合。

现在,您应该问的是,如果在训练模型之前手动设置超参数,我们该如何调整它们。 有几种方法可以调整超参数。 此优化的底线是使用一组不同的超参数测试算法,并在选择性能更好的超参数集之前针对每种情况计算误差函数或损失函数。

在本节中,我们简要介绍了参数,超参数及其差异。 在下一节中,我们将介绍损失和误差函数,这对于超参数优化非常重要。

损失和误差函数

在前面的小节中,我们解释了有监督和无监督的学习。 无论使用哪种机器学习算法,我们的主要挑战都是关于优化的问题。 在优化函数中,我们实际上是在尝试使损失函数最小化。 设想一下您试图优化每月储蓄的情况。 在关闭状态下,您要做的就是最小化支出,换句话说,将损失函数最小化。

建立损失函数的一种非常常见的方法是从预测值与实际值之差开始。 通常,我们尝试估计模型的参数,然后进行预测。 我们可以用来评估我们的预测水平的主要度量包括计算实际值之间的差:

在不同的模型中,使用了不同的损失函数。 例如,您可以在回归模型中使用均方误差,但是将其用作分类模型的损失函数可能不是一个好主意。 例如,您可以按以下方式计算均方误差:

其中回归模型如下:

有许多不同的损失函数可用于不同的机器学习模型。 以下是一些重要的说明,并简要说明了它们的用法:

| 损失函数 | 解释 |

|---|---|

| 交叉熵 | 这用于分类模型,其中模型的输出为 0-1 之间的概率。 这是对数损失函数,也称为对数损失。 当理想的模型的概率接近 1.0 时, 交叉熵损失降低。 |

| MAE(L1) | 计算误差绝对值的均值。 由于它仅使用绝对值,因此不会将较大误差的权重放大。 当较大误差与较小误差相比可以容忍时,这很有用。 |

| MSE(L2) | 计算误差的平方根的均值。 放大较大误差的权重。 当不希望出现较大误差时,这很明智。 |

| Hinge | 这是用于线性分类器模型(例如支持向量机)的损失函数。 |

| Huber | 这是回归模型的损失函数。 它与 MSE 非常相似,但对异常值不敏感。 |

| Kullback-Leibler | Kullback-Leibler 散度衡量两个概率分布之间的差异 。 KL 损失函数在 T 分布随机邻居嵌入算法中大量使用。 |

在机器学习算法中,损失函数在更新变量权重时至关重要。 假设您使用反向传播训练神经网络。 在每次迭代中,都会计算出总误差。 然后,权重被更新以便最小化总误差。 因此,使用正确的损失函数会直接影响您的机器学习算法的性能,因为它直接影响模型参数。 在下一章中,我们将从住房数据中的单个变量开始简单的线性回归。

使用梯度下降的单变量线性回归

在本小节中,我们将为波士顿住房数据集实现单变量线性回归,该数据已在上一章中用于探索性数据分析。 在拟合回归线之前,让我们导入必要的库并按以下方式加载数据集:

In [1]: import numpy as np

import pandas as pd

from sklearn.cross_validation import train_test_split

from sklearn.linear_model import LinearRegression

import matplotlib.pyplot as plt

%matplotlib inline

In [2]: from sklearn.datasets import load_boston

dataset = load_boston()

samples , label, feature_names = dataset.data, dataset.target, dataset.feature_names

In [3]: bostondf = pd.DataFrame(dataset.data)

bostondf.columns = dataset.feature_names

bostondf['Target Price'] = dataset.target

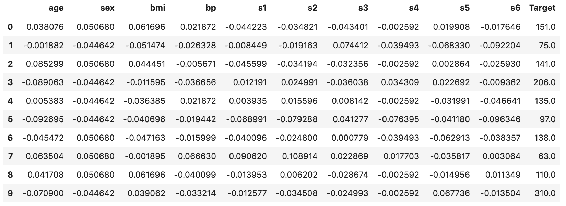

bostondf.head()

Out[3]: CRIM ZN INDUS CHAS NOX RM AGE DIS RAD TAX PTRATIO B LSTAT Target Price

0 0.00632 18.0 2.31 0.0 0.538 6.575 65.2 4.0900 1.0 296.0 15.3 396.90 4.98 24.0

1 0.02731 0.0 7.07 0.0 0.469 6.421 78.9 4.9671 2.0 242.0 17.8 396.90 9.14 21.6

2 0.02729 0.0 7.07 0.0 0.469 7.185 61.1 4.9671 2.0 242.0 17.8 392.83 4.03 34.7

3 0.03237 0.0 2.18 0.0 0.458 6.998 45.8 6.0622 3.0 222.0 18.7 394.63 2.94 33.4

4 0.06905 0.0 2.18 0.0 0.458 7.147 54.2 6.0622 3.0 222.0 18.7 396.90 5.33 36.2

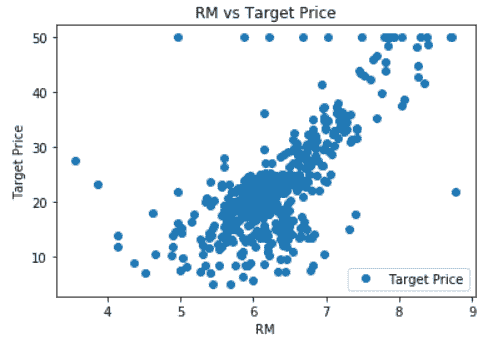

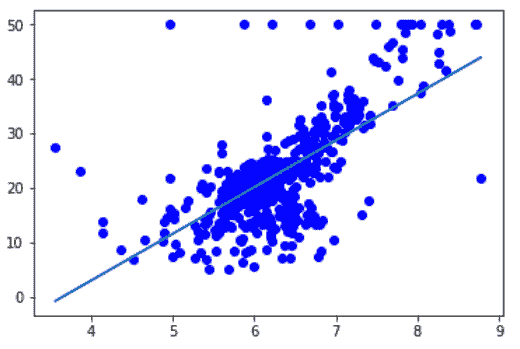

与上一章相比,我们使用 Pandas 数据帧代替了 numpy 数组,以便向您展示数据帧的用法,因为它也是一个非常方便的数据结构。 从技术上讲,在大多数情况下,如果仅将数值存储在 numpy 数组或 Pandas 数据帧中,则没有任何区别。 让我们将目标值添加到数据框中,并使用散点图查看RM函数与目标值之间的关系:

In [4]: import matplotlib.pyplot as plt

bostondf.plot(x='RM', y='Target Price', style= 'o')

plt.title('RM vs Target Price')

plt.ylabel('Target Price')

plt.show()

从该图可以看出,每个住宅的平均房间数(RM)与房价之间存在正相关,正如预期的那样。 现在,我们将看到这种关系的强度,并尝试使用这种关系来预测房价。

想象一下,您对线性回归的了解非常有限。 假设您只是熟悉方程式,但不知道误差函数是什么,为什么我们需要迭代,什么是梯度下降,以及为什么要在线性回归模型中使用它。 在这种情况下,您要做的就是简单地开始传递系数的一些初始值,并在计算预测值之前截取方程。

在计算了几个预测值之后,您可以将它们与实际值进行比较,看看您与实际情况有多远。 下一步将是更改系数或截距,或者同时进行这两项操作,以查看是否可以使结果更接近实际值。 如果您对此过程感到满意,这就是我们的算法将以更智能的方式进行的操作。

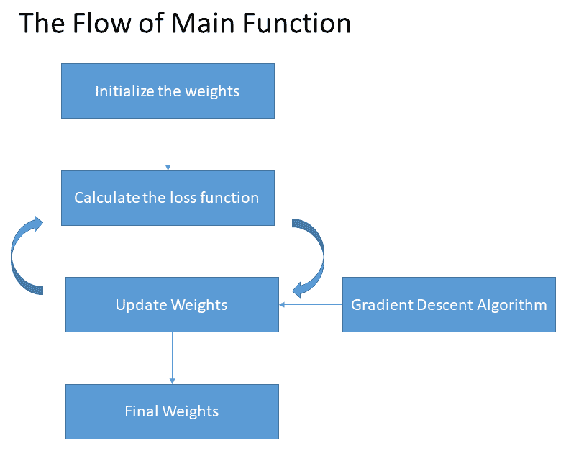

为了更好地理解线性回归模型步骤,我们将代码分成几个块。 首先,让我们创建一个函数,该函数作为回归线的结果返回预测值:

In [5]: def prediction(X, coefficient, intercept):

return X*coefficient + intercept

前面的函数计算线性回归模型如下:

然后,我们需要一个成本函数,该函数将在每次迭代中进行计算。 作为cost_function,我们将使用均方误差,它是预测值与实际值之间总平方差的平均值:

In [6]: def cost_function(X, Y, coefficient, intercept):

MSE = 0.0

for i in range(len(X)):

MSE += (Y[i] - (coefficient*X[i] + intercept))**2

return MSE / len(X)

我们的最后一个代码块将用于更新权重。 当我们讨论权重时,不仅涉及自变量的系数,还涉及截距。 拦截也称为偏差。 为了逻辑上更新权重,我们需要一种迭代优化算法,该算法可以找到给定函数的最小值。 在此示例中,我们将使用梯度下降方法来最小化每次迭代中的损失函数。 让我们一步一步地发现梯度下降的作用。