前言

本书是笔者从业二十余年、从事图书创作十余年的工作经验和技术积累的结晶,是对十余年来一直默默支持我的全国百万读者的真诚回馈。同时,本书也是笔者这十多年来付诸心血最多(整整一年专职创作时间)、寄予希望最大的一部重头之作,期待能为国家的计算机网络专业教育尽一份绵薄之力。

为什么写这本书

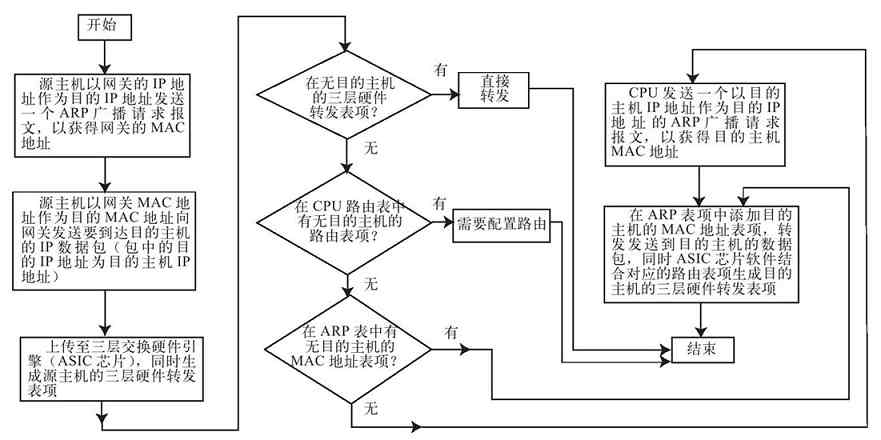

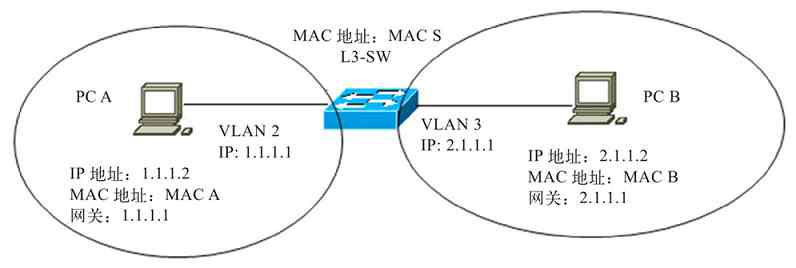

其实很久以前就有了写这本书的动机了,但由于我深知写作这本书的难度很大,再加上自己还在写作其他图书,写作任务一直非常繁重,所以就耽误了。不过,或许今天写这本书正是时候,一则笔者又多经过了几年的技术学习和工作经验的积累,书稿的质量可能比以前更高;二则目前计算机网络专业越来越边缘化了,已成为了所有IT人员的必修课,所以现在对要求有一本高质量、通俗易懂的专注于计算机网络原理和基础知识的教材的呼声比以前更高了。综合起来就是以下三点:

1.学子的呼唤:“零基础”不应只是一句宣传口号

计算机网络原理和基础知识类的课程一直是广大计算机网络专业的读者最头痛的一门课程。因为这类课程不仅相对枯燥乏味,而且教材中的技术原理解释普遍晦涩难懂。也正因如此,现在许多计算机网络专业的大学生,毕业后仍对这方面的知识一知半解,走上工作岗位后遇到实际的网络问题很难从原理方面分析出故障原因,更别说排除网络故障了。

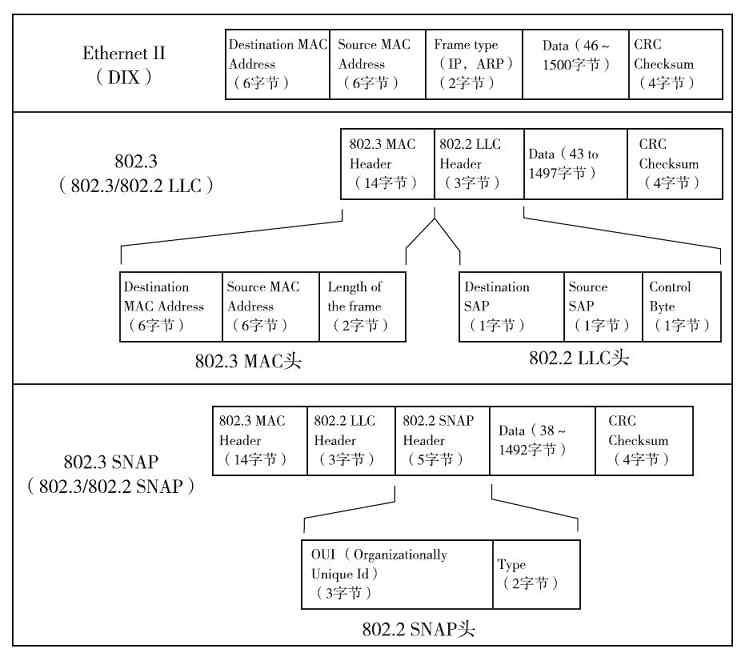

虽然国内这方面的教材非常多,也不乏一些经典著作,但经笔者分析后认为大部分存在这样或那样的不足,要么通俗性较差,要么内容上过于浅显,更多的是照搬理论,难以使网络专业学生比较轻松地掌握全面、系统、专业的计算机网络原理和基础知识。但作为一名老的网络职业工作者和有着十几年计算机网络专业图书创作经验的老作者,深知这样一本看似非常基础,甚至有一些人认为非常简单的教材,要真正写出水平、写出权威并非易事,特别是在通俗性方面。现在许多书都把“零基础”当作卖点在宣传,但真正能做到零基础,并且在内容上有一定深度的书却并不多见。

另外,以前学计算机网络原理和网络基础知识的人可能大多数是计算机网络专业的学生,但随着计算机网络应用的普及,计算机网络知识几乎已成为所有IT专业必修的基础课程。而那些非计算机网络专业的学生对计算机网络可以说是真正的零基础,所以对这类教材在通俗性方面的要求会更高。要把那么深奥的计算机网络原理讲得能让这些零基础的读者理解和接受,难度就更是难以想象的了,这点笔者在创作过程中深有体会。尽管笔者在这方面也没有过深的造诣,但本着对信任、支持笔者的百万读者负责,怀抱着百万读者的期待和笔者自己二十多年的学习和工作经验积累,花了整整一年全职的创作时间写下了这本笔者认为在某些方面,特别是在通俗性方面有所提高的著作,力争使零基础的网络“菜鸟”也能轻松掌握复杂、深奥的计算机网络原理。希望这本书不会令广大读者朋友失望。

2.时代的变迁:不懂计算机网络,你不敢说自己是ITer

如果十年前你听到同行们都在说“不懂计算机,都不敢说自己是ITer”,那么十年后的今天,你所听到的一定就是“不懂计算机网络,都不好意思说自己是ITer”。更有人甚至会说“不懂计算机网络,就是现代文盲”。这些观点虽然可能有些偏颇,但也足以说明在全面信息化的今天,计算机网络在整个IT行业的重要性和基础性,它不再仅是网络专业人士必须掌握的,所有ITer,甚至所有现代人都应该掌握。

以上虽然看似口号,但却实实在在地反映了当前整个IT行业都是以计算机网络作为中心和基础平台的这样一个现状。十年前,几乎所有的IT开发和应用都是以单一的计算机系统为平台的,几乎所有的计算机程序的运行环境都是单台计算机。十年后的今天,随着互联网接入的普及和宽带接入速度的提高,以及互联网和企业网络技术在应用上的普及与发展,一切都发生了变化。

过去单一的计算机系统平台根本无法满足当前无处不在、各种各样的网络应用需求,绝大多数IT开发和应用平台都转向了计算机网络这个无边的大平台。现在个人和企事业单位所进行的各项IT应用绝大多数都是基于计算机网络的,如浏览网页、收发邮件、写博客、写微博、网上购物、网上看电影/电视、网上玩游戏、网上听音乐、网络电子商务、网络营销、企业网络远程互联、网络会议、网络直播等。似乎我们现在所做的一切一切都离不开计算机网络,计算机网络成了实实在在的IT计算中心和基础应用平台。

现在基于单一计算机系统的应用已非常少了,且随着云计算、物联网这样的新型网络技术的应用和普及,可以十分清楚地预见,计算机网络这个平台才是整个IT行业发展的根本。就连现在我们仍然基于单机操作的办公应用软件,在不久的将来都可能全由云计算服务提供商通过互联网集中提供,再加上迅猛发展的移动互联网,计算机网络的基础地位将得到进一步巩固。到那时,如果连何为计算机网络都不懂,简单的计算机网络故障排除还要求助于人,这不就是现代文盲吗?你还敢说你是ITer吗?

3.职业的挑战:计算机网络基础原理,网络职业发展的真正瓶颈

形势摆在我们所有ITer面前,但国内的现状却不怎么令人满意。先且不说所有IT行业,就是专门从事网络管理,或者网络工程行业的网络管理员和网络工程师,在计算机基础原理方面能比较深入地说出个一、二、三来的也没多少,碰到一个网络故障能从原理上进行全面分析的人更是少之又少,至少我所了解的是这样。可能有些人会说,会配置和管理网络不就行了?他们认为那些深奥的基础理论没什么用。其实说这样话的人还是不是很懂得网络管理和网络工程的真正职责,不是很理解这些网络基础原理的本质和重要性。网络管理的主要职责就是维护,在出现了网络故障时能快速、准确地排除故障,网络工程的主要职责就是为用户设计一个实用、符合各项标准,且稳定的系统。

很难想象,一个网络基础理论不扎实的网络管理人员如何能快速、准确地进行网络故障分析和排除,网络工程人员又如何能设计出一个符合标准、符合用户应用需求且能长时间保持稳定的系统。对于从事各种网络应用程序开发的程序员们来说,网络基础理论同样非常重要,一个不懂得网络体系结构,以及各层功能实现原理和应用接口的程序员,怎么可能设计出一个符合对应网络应用标准的应用程序?又怎么可能被用户认同?

随着计算机网络应用的不断高速发展,随着一大批快速成长型中小企业的高速发展,相信在不久的将来,全国将有无数企事业单位急需高水平、全面掌握基于计算机网络基础平台的IT设计和IT管理专业人才,到那时必将是一场残酷的职业竞争。如果连计算机网络基础原理都没有比较好的掌握,在起跑线上就输了,还如何参与竞争?

基于以上分析,我们可以十分清楚地知道,要成为一名合格的IT专业人才,无论你是从事IT应用开发,还是从事网络管理和网络工程设计,计算机网络基础原理都将是你的必修课!不要让自己输在起跑线上!

读者对象

本书内容看似非常专业、深奥,但这方面的知识现在已成为所有ITer的必修课。本书适合以下读者阅读,每类读者都可以通过阅读本书获得相应的收益:

❏所有想从事网络管理、网络工程设计的准网络管理员、准网络工程师

❏所有在网络职业发展道路遇到基础理论瓶颈的在职网络专业人士

❏所有大中专院校的IT专业学生

❏所有想学习计算机网络技术的“菜鸟”

如何阅读本书

本书虽然在知识讲解上已力争尽可能通俗化,但里面的知识点毕竟相当专业,所以在阅读本书时,建议注意以下几个方面:

❏不要刻意追求阅读速度

书中有的专业技术原理还是比较复杂的,建议大家在阅读时要一章、一节地消化,不要刻意追求阅读速度。一定要静下心来,认真阅读,千万别一目十行。

❏结合书中的示例阅读

本书所介绍的每项技术原理都会结合一些类比、演示示例,阅读者一定要仔细阅读示例讲解的每一步,最好自己也跟着示例进行计算、分析,以加深对原理的理解。

❏坚持,坚持,再坚持

尽管书中在通俗化方面已有较好的体现,但书中的内容毕竟全是基础理论,仍不能完全克服枯燥性,远不如图形操作界面那么简单明了,所以在阅读本书时一定要坚持,要静下心来学习,千万别半途而废。

❏选学内容可先不学

本书第1章和第9章属选学内容,主要是为已有一些基础的读者而准备的,所以如果你基础不是太好,可先跳过这两章,等以后有兴趣时再来学习。

本书的特色

“要登堂入室,必须先打开一扇门,或者一扇窗”,本书就是你登入计算机网络神圣殿堂的那扇门或窗。与同类图书对比,本书具有以下特色:

❏通俗易懂

这是本书最大的特色。为了能把复杂的技术原理讲得通俗易懂,书中不仅使用了大量的现实生活事例作为说明性的比喻,还列举了许多实例。同时,本书近600幅插图、近100个表格,可以帮助读者朋友更加直观地分析和理解各种复杂的技术原理。这是国内其他同类图书所没有的。

❏全面系统

本书的内容应该是同类图书中内容最全面、最系统的,不仅讲了目前主流的TCP/IP体系结构中的相关技术,还同时兼顾了OIS/RM和局域网体系结构的相关技术。更重要的是还包括了与各层对应的一些主要网络基础知识。真正做到“一本在手,网络无忧”。

❏专业深入

本书对所写到的每一部分内容都从专业角度进行了非常深入的剖析,使读者朋友不会有在阅读其他同类图书时所有的许多重要知识点都“一笔带过”的感觉。笔者在写作之初就确立了“绝不一笔带过那些重要的知识点”的目标。

❏条理清楚

本书无论是从各章节内容安排上,还是从各小节内容组织上,条理都是比较清楚的。在本书中,对于一些比较复杂的内容都分出了多个小标题,重点突出,这样可以使读者朋友更加清楚地理解所介绍的内容,不会有整页或者几页都找不到主题、抓不住重点的现象。

勘误和支持

本书由王达主笔并统稿,参加编写、校验和排版的人员还有:何艳辉、王珂、沈芝兰、马平、何江林、刘凤竹、卢京华、周志雄、洪武、高平复、周建辉、孔平、尚宝宏、姚学军、张磊、刘学、李翔、王娇、李敏、吴鹏飞、宋希岭、刘中洲、潘朝阳、刘伟、曾平辉、李京杨、张跃、周平辉、王新宇、王薄、韩大为、宋宝强、史鹏宇、陆伟等。笔者在此对以上各位老师一并表示最由衷的谢意!尽管我们花了大量时间和精力校验,但由于水平有限,书中难免存在一些错误和瑕疵,敬请各位批评指正,万分感谢!

另外本书读者可以通过以下渠道享受相关服务:

❏多个专家博客和认证微博

笔者的主要博客:http://winda.blog.51cto.com、http://blog.csdn.net/lycb_gz、http://blog.chinaunix.net/uid/10659021.html。每个博客里面都有数百篇各方面的专业技术和职业指导文章,以及大量我以前所出版的图书的精彩试读文章。读者朋友不仅可以在里面学习各方面的知识,还可以直接向笔者提问。

笔者的两个微博:weibo.com/winda(新浪微博)、t.qq.com/winda2010(腾讯微博)。

❏超级QQ读者群

为方便全国各地读者交流,专门为本书读者新建了一个超大型、可容纳2000人的超级QQ读者群:196652938。由于读者众多,请尽快购买、加入,否则可能很快就没有位子了(加入时请注明本书名称)。

❏授课PPT免费下载

为了支持高校和培训机构老师讲课,本书为各位老师提供了授课PPT,需要的朋友可以在机械工业出版社华章公司官网(www.hzbook.com)上下载,也可直接与笔联系获取(QQ:93220994,邮箱:lycb_gz@vip.sina.com)。

致谢

本书是笔者与机械工业出版社合作出版的第一部图书,感谢机械工业出版社华章公司,以及杨福川老师给予我的这次十分难得的合作机会。由于本书内容较多,专业性较高,出版时间又非常紧,所以特别要感谢杨福川老师专门为本书抽调的精干编辑力量,及他在本书上线前做的大量推广工作;感谢孙海亮等其他所有编辑老师对本书的辛勤付出,我经常发现他们加班加点在编辑这部图书。期待本书能取得好的成绩,也期待通过此部图书合作的成功,为笔者与机械工业出版社展开更广泛的合作打下坚实基础。

王达

第1章 数制与编码

本章可作为选学内容,所介绍的知识仅是为了帮助大家理解本书以后章节中涉及的二进制、八进制、十六进制的内容,特别是各种信息编码、IP地址格式转换、MAC地址格式转换等内容。本章的知识对于数据包分析非常有用。如果你对这些内容已掌握了,可直接跳过本章。

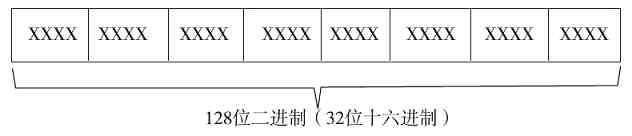

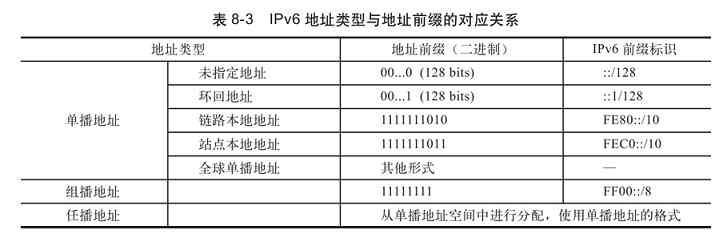

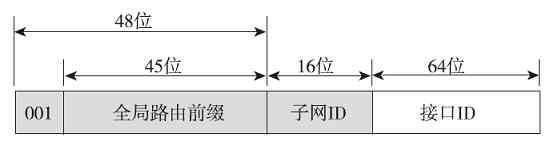

“数制”是“数据进制”的简称,也就是表示数据逢几进位的意思,如我们常用的十进制就是逢十进位。当然,数制的类型远不只十进制,在计算机系统中常见的还有二进制、八进制和十六进制这三种。与数制关系最密切当然就是数据编码了。数据编码主要包括原码、反码和补码三种,它们用于以不同形式表示数据,当然这主要是一些特殊的应用需求,如在进行校验和(checksum)计算时,就需要用于原码计算。反码和补码是为了在计算机中表示负数才出现的。本章的主要内容就是数制与编码的概念,以及二进制的运算和表示形式。

1.1 数制概述

“数制”就是“数据进制”的简称,是指数据的进位计数规则,又称“进位计数制”,简称“进制”。本节先来简单地了解一些常见的数制类型及其特点。

1.1.1 常见数制类型及表示方法

日常生活中我们经常使用的数是十进制的,如我们拿的3000元工资,市场1.5元/斤的菜价等。之所以称其为十进制,是因为这类数是逢十进一的。除了十进制计数以外,还有许多其他进制的计数方法。在计算机中常见的还有二进制、八进制、十六进制等制式。这三种进制的数在进行加法运算中分别是逢二、八、十六进一,这就是前面所说的进位计数规则。关于如何理解这些不同数制类型数据的加法运算,在本章后面将有专门介绍。

其实数制类型远不止这么几种,如我们以60分钟为1小时,60秒为一分钟,用的就是六十进制计数法;一天之中有24小时,用的是二十四进制计数法;而一星期有7天,用的是七进制计数法。

虽然数制类型可以有很多种,但在计算机通信中通常遇到的仍是以上提到的二进制、八进制、十进制和十六进制这四种。在一种数制中所能使用的数码的个数称为该数制的“基数”,也就是对应数制类型的名称,如二进制的基数为“2”,八进制的基数为“8”,十进制的基数为“10”,十六进制的基数也就是“16”。这里所说的“基数”其实就是前面所说的进位计算规则,如我们常见的十进制数是逢十进一,二进制数是逢二进一,……

既然有不同的数制,那么在计算机程序中给出一个数时就必须指明它属于哪一种数制,否则计算机程序就不知道该把它看成哪种数了。如12300这个数,既可能是十进制、又可能是八进制或者十六进制,所以“数”需要有专门的标志来进行区别。下面分别予以介绍。

(1)十进制(Decimal)

十进制是日常生活中常用的数制类型,基数是10,也就是它有10个数字符号,即0、l、2、3、4、5、6、7、8、9。其中最大数码是“基数”减1,即10-1=9,最小数码是0。十进制数的标志为D,如(1250)D,也可用下标“10”来表示,如(1250)10 (注意是下标)。

(2)二进制(Binary)

二进制是计算机运算时所采用的数制,基数是2,也就是说它只有两个数字符号,即0和1。如果在给定的数中,除0和1外还有其他数(例如1061),那它就绝不会是一个二进制数了。二进制数的最大数码也是基数减1,即2-1=1,最小数码也是0。二进制数的标志为B,如(1001010)B,也可用下标“2”来表示,如(1001010)2 (注意是下标)。

(3)八进制(Octal)

八进制的基数是8,也就是说它有8个数字符号,即0、l、2、3、4、5、6、7。对比十进制可以看出,它比十进制少了两个数“8”和“9”,这样当一个数中出现“8”和(或)“9”时(如23459),那它也就绝不是八进制数了。八进制数的最大数码也是基数减1,即8-1=7,最小数码也是0。八进制数的标志为O或Q(注意它特别一些,可以有两种标志),如(4603)O(注意是字母O,不是数字0)、(4603)Q,也可用下标“8”来表示,如(4603)8(注意是下标)。在C、C++这类语言中规定,一个数如果要指明它采用八进制,必须在它前面加上一个0,如:123是十进制数,但0123则表示采用的是八进制。

(4)十六进制(Hexadecilmal)

十六进制数用得比较少,最新的IPv6地址就是采用16进制来表示的(IPv4地址通常采用十进制表示)。在注册表中也会用到16进制,所以了解十六进制还是非常重要的。

十六进制的基数是16,也就是说它有16个数字符号,除了十进制中的10个数外,还使用了6个英文字母,这16个数字和字母依次是0、l、2、3、4、5、6、7、8、9、A、B、C、D、E、F(与大小写无关)。其中A至F分别代表十进制数的10至15。如果数据中出现了字母之类的符号,如63AB,则一定不会是八进制或十进制,而是十六进制了。它的最大的数码也是“基数”减1,即16-1=15(为F),最小数码也是0。十六进制数的标志为H,如(4603)H,也可用下标“16”来表示,如(4603)16 (注意是下标)。十六进制数也常常用前缀0x来表示(注意是数字0,而不是字母O)。在C、C++这类编程语言中也规定,16进制数必须以0x开头。比如0x10表示一个十六进制数,而不是八进制或者十进制的10。

经验之谈 既然在计算机中使用的是二进制,那为什么还要十进制、八进制和十六进制呢?其实这都不是计算机自身要求的,因为在计算机运算中使用的全都是二进制。之所以还需要这些数制,完全出于表达和识别的方便性考虑。因为大多数的数据用二进制表示太长了,如一个C、C++等编程语言中的int(整数)类型的数据要占用4个字节,也就是32位。比如100,用int类型的二进制数表达将是:0000 0000 0000 0000 0110 0100。这还是一个比较小的数,如果数更大,则会更复杂。试想一下,要写这么长,估计没几个人会喜欢,于是就有了可以更简便表示的十进制、八进制和十六进制了。所以,像C、C++这类语言没有提供在代码中直接写二进制数的方法,而是普遍采用八进制或十六进制。

那为什么不是其他进制类型,如九或二十进制呢?原因就在于2、8、16,分别是2的1次方、3次方、4次方,这就使得这三种进制之间可以非常直接地互相转换。八进制或十六进制缩短了二进制数,但保持了二进制数的表达特点。在下面关于进制转换的介绍中,你可以发现这一点。

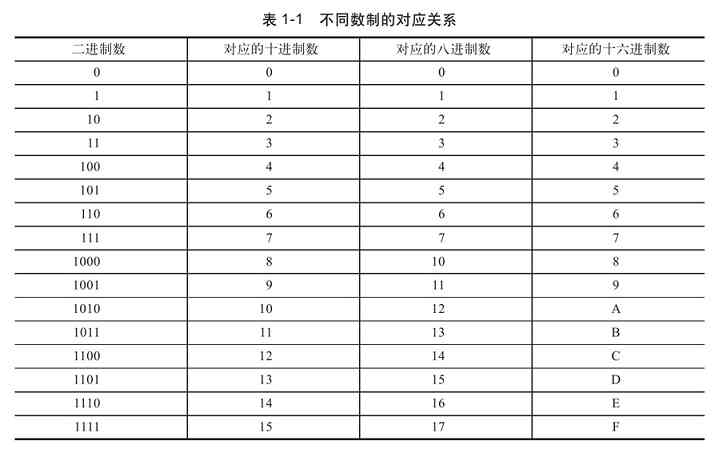

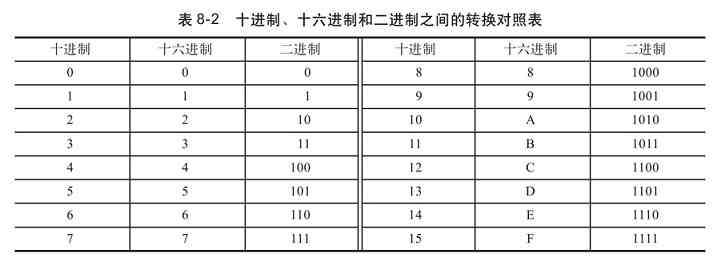

1.1.2 不同数制之间的对应关系

表1-1所示是以上介绍的二进制、十进制、八进制和十六进制这四种常在计算机中使用的数制的对应关系。注意,八进制没有8和9,二进制1000对应八进制的10,而不是想象中的8,二进制1001对应的八进制数是11,而不是想象中的9,这就是进位造成的。这个表很重要,大家最好全部记下来,特别是这几种数制的对应关系。

1.2 不同数制间的相互转换

同一个数在一些环境中(如我们要进行子网划分,或者计算子网掩码时,或者对信息进行编码时等)可能要用不同数据制形式来表示,这就涉及数制间的转换问题了。下面是常见的十进制、二进制、八进制、十六进制之间的转换方法。

1.2.1 非十进制数转换成十进制数

非十进制数转换成十进制数就是把这些非十进制数按位以对应的权值(注意:要区分整数位和小数位)展开,然后相加即得出相应的十进制值。本节后面介绍的各种非十进制转换成十进制的方法都是按照这种方法进行的。

“权值”是指对应数值位的进制幂次方数,如二进制整数中第0位(最低位,也就是整数最右边的那位)的权值是2的0次方,第1位的权值是2的1次方……同理在八进制整数中第0位的权值是8的0次方,第1位的权值是8的1次方……,依此类推。但每位的权值会因是整数位还是小数位而不同:

❏整数的第0位(也就是最低位)的权值为对应进制的0次方,最高位的权值为对应进制的n-1次方。

❏小数的第一位(最靠近小数点的那位,也是小数的最高位)的权值为对应进制的-1次方,最后一位(最右边的那位,也即小数的最低位)的权值为对应进制的-n次方。

1.二进制转换为十进制

二进制转换成十进制的方法,大家可能早就有所了解了,如在IPv4地址计算时就经常进行这样的操作。转换的方法比较简单,只需按它的权值展开即可。展开的方式是把二进制数首先写成加权系数展格式,然后按十进制加法规则求和。这种方法称为“按权相加”法。

二进制整数部分的一般表现形式为:bn-1 …b1 b0 (共n位),按权相加展开后的格式为(注意,展开式中从左往右各项的幂次是从高到低下降的,最高位的幂为n-1,最低的幂为0):

bn-1 ×2n-1 +bn-2 ×2n-2 …+b1 ×21 +b0 ×20

如二进制数(11010)2 的按权相加展开格式为:

1×24 +1×23 +0×22 +1×21 +0×20 =16+8+0+2+0=(26)10

二进制小数部分的幂次是反序排列的(也就是与整数部分的幂次序列相反,从左往右其绝对值是从低到高上升的),且为负值,最高位幂次(也就是最靠近小数点的第一个小数位的幂次)为“-1”。如二进制小数部分的格式为:0.bn-1 …b1 b0 ,则按权相加后的展开格式为:

bn-1 ×2-1 +bn-1 ×2-2 …+b1 ×2-(n-1) +b0 ×2-n

如(0.1011)2 的按权相加展开格式为:

1×2-1 +0×2-2 +1×2-3 +1×2-4 =0.5+0+0.125+0.0625=(0.6875)10

2.八进制转换为十进制

八进制转换成十进制也是采取“按权相加”法,只是这里的权值是8的相应幂次方。如八进制整数部分的格式为:bn-1 …b1 b0 ,则按权值相加,展开后的格式就为(从左往右幂次是从高到低下降的):

bn-1 ×8n-1 +bn-2 ×8n-2 …+b1 ×81 +b0 ×80

如八进制数(26356)8 的按权值相加展开格式为:

2×84 +6×83 +3×82 +5×81 +6×80 =8192+3072+192+40+6=(11502)10

八进制小数部分的幂次也是反序排列的(也就是与整数部分的幂次序列相反,从左往右其绝对值是从低到高上升的),且为负值,最低幂次(也就是最靠近小数点的第一个小数位的幂次)为“-1”。如八进制小数部分的格式为:0.bn-1 …b1 b0 ,则按权相加后的展开格式为:

bn-1 ×8-1 +bn-2 ×8-2 …+b1 ×8-(n-1) +b0 ×8-n

如(0.257)8 按权相加的展开格式为:

2×8-1 +5×8-2 +7×8-3 =0.25+0.078125+0.013671875=(0.341796875)10

3.十六进制转换为十进制

十六进制转换成十进制的方法也是采取“按权相加”法,只是这里的权值是16的相应幂次方。如十六进制整数部分的格式为:bn-1 bn-2 …b1 b0 ,则按权相加展开后的格式就为(从左往右幂次是从高到低下降的):

bn-1 16n-1 +bn-2 ×16n-2 …+b1 ×161 +b0 ×160

如十六进制数(26345)16 的按权相加,展开后的格式为:

2×164 +6×163 +3×162 +4×161 +5×160 =131072+24576+768+64+5=(156485)10

十六进制小数部分的幂次也是反序排列的(也就是与整数部分的幂次序列相反,从左往右其绝对值是从低到高上升的),且为负值,最低幂次(也就是最靠近小数点的第一个小数位的幂次)为“-1”。如十六进制小数部分的格式为:0.bn-1 …b1 b0 ,则按权相加后的展开格式为:

bn-1 ×16-1 +bn-2 ×16-2 …+b1 ×16-(n-1) +b0 ×16-n

如(0.25A)16 按权值相加,展开后的格式为:

2×16-1 +5×16-2 +10×16-3 =0.125+0.0234375+0.00244140625=(0.15087890625)10

4.同步练习

1)把(01110100)B、(11101001000.10111)B转换成十进制;

2)把(1076)O、(6374.65)Q转换成十进制;

3)把0x7A8C、0x259B.25转换成十进制。

1.2.2 十进制数转换成非十进制数

十进制数转换成非十进制数的方法是:整数部分的转换用“除基取余法”,也就是用基数相除,然后反序(由后向前取)取余数;小数部分的转换用“乘基取整法”,也就是用基数相乘,然后正序(由前向后取)取整数。这里的“基数”就是对应的数制,如二进制的基数为2,八进制的基数为8,十六进制的基数为16。

1.十进制转换为二进制

这里分别对十进制整数和十进制小数转换成二进制进行介绍。

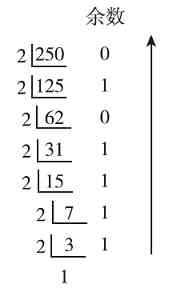

1)十进制整数转换成二进制的方法

十进制整数转换为二进制的方法是:采用“除2逆序取余”法(采用短除法进行)。也就是先将十进制数除以2,得到一个商数(也是下一步的被除数)和余数;然后再将商数除以2,又得到一个商数和余数;以此类推,直到商数为小于2的数为止。然后从最后一步得到的小于2的商数开始将其他各步所得的余数(也都是小于2的0或1)排列起来(俗称“逆序排列”)就得到了对应的二进制数。

注意 这里与下面的小数转换有些不一样,这里要包括最后得到的小于2的商数,而小数转换中是不需要包括最后的积的,只包括各步得到的整数部分,后面的十进制整数转换为八进制、十六进制也一样。

图1-1所示为十进制整数48转换成二进制数时依次除2的过程,在每步的最右边显示的是各步商数除2所得到的余数,最后一步的商数为1,因为它小于2,所以不能再除了。然后从最后得到商数(1)开始依次向上把其他各步除2得到的余数排列起来,就得到最后48转换成二进制时的结果为(110000)2 。同理,图1-2所示的十进制数250转换成二进制数后的结果就为(11111010)2 。

图 1-1 十进制整数48转换成二进制整数的步骤

图 1-2 十进制整数250转换成二进制整数的步骤

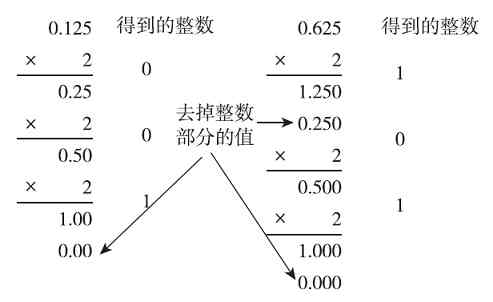

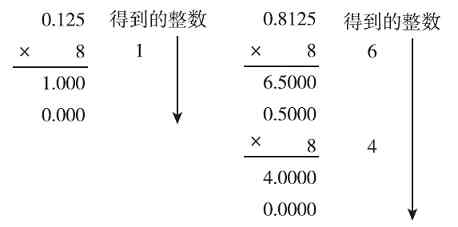

2)十进制小数转换成二进制的方法

十进制小数转换为二进制的方法是采用“乘2正序取整”法。也就是用2乘十进制小数,得到一个积,然后将积的整数部分取出作为相应步骤得到的整数;再用2乘余下的小数部分,又得到一个积;然后再将这个积的整数部分取出;以此类推,直到积中的小数部分为零,或者达到所要求的精度为止;最后把各步取出的整数部分(仅需要各步得到的整数部分,不需要最后没有取整的小数部分)按正序排列起来,即先取的整数作为二进制小数的高位,后取的整数作为低位。

图1-3的左、上图是分别将十进制小数0.125和0.625转换成二进制的过程,最后得到的二进制数就是从最开始得到的整数值开始,一直到最后得到的整数值(也就是自上而下的顺序,与整数转换中取余的顺序相反)。0.125和0.625最后的二进制值分别为(0.001)2 和(0.101)2 (注意,一定要记得在整数部分加上“0.”,因为十进制小数转换成二进制后仍是小数)。

图 1-3 0.125和0.625十进制小数转换成二进制小数的步骤

注意 有些十进制小数乘以2后是个无穷循环数,永远不会有完整的整数,此时就要看所需的精度如何了,按所需位数精度取值即可。如0.825就是这样一个数,如果仅要求是小数点后3位,则相应的二进制数为(0.110)2 ,如果要求为4位,则对应的二进制值为(0.1101)2 。具体如图1-4所示。

图 1-4 不同精确度要求的取值示例

如果一个十进制同时有整数和小数部分,则要对整数和小数部分分别按以上介绍的对应方法进行二进制转换。

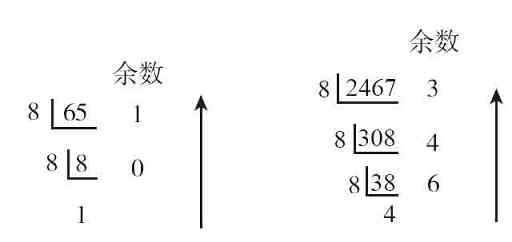

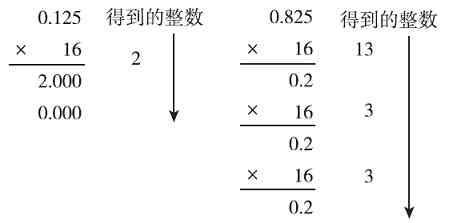

2.十进制转换成八进制

八进制数的基数为8,因此八进制数中的数码有0、1、2、3、4、5、6、7,共八个。十进制转换成八进制的方法与前面介绍的十进制数转换成二进制的方法类似,只不过这里的基数是8(而不再是2)。十进制转换成八进制当然也分整数部分和小数部分两种不同的转换方法。

十进制整数转换为八进制整数采用“除8逆序取余”的方法,直到所得的商小于8,然后把余数(包括最后一步中得到的小于8的商数)按逆序排列即可;十进制小数转换为八进制小数是采用“乘8正序取整”法,直到所得到的积小数部分为0,或者在规定的精度范围内,然后把所得到的整数正序排列起来即可。

图1-5左、上图是分别将十进制整数65和2467按“除8逆序取余”的方法转换成八进制的步骤,得到的结果分别是(101)8 和(4643)8 。

图 1-5 两个十进制整数转换成八进制整数的步骤

图1-6左、上图所示的是两个十进制小数0.125和0.8125通过“乘8正序取整”的方法转换成八进制的步骤,得到的结果分别是(0.1)8 和(0.64)8 (是正序排列,一定要记得在整数部分加上“0.”)。

图 1-6 两个十进制小数转换成八进制小数的步骤

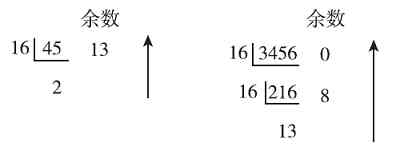

3.十进制转换成十六进制

十六进制数的基数为16,十六进制数中的数码有0、1、2、3、4、5、6、7、8、9、A、B、C、D、E、F,共十六个。

十进制转换成十六进制与十进制转换成二进制类似,将十进制整数转换为十六进制的方法是采用“除16逆序取余”法,直到所得的商小于16,然后把余数(包括最后一步中得到的小于16的商数)按逆序排列即可;十进制小数转换为十六进制的方法是采用“乘16正序取整”法,直到所得到的积小数部分为0,或者在规定的精度范围内,然后把所得到的整数正序排列起来即可。

图1-7左、上图是分别将十进制整数45和3456按“除16逆序取余”的方法转换成十六进制的步骤,得到的结果分别是(2D)16 和(D80)16 (注意,其中的13用十六进制的D表示了)。

图 1-7 两个十进制整数转换成十六进制整数的步骤

图1-8左、上图是将十进制小数0.125和0.825通过“乘16正序取整”的方法转换成十六进制的步骤,得到的结果分别是(0.2)16 和(0.D33)16(精确到小数点后面三位)(注意:是正序排列,也一定要记得在整数部分加上“0.”,仍是小数)。

图 1-8 两个十进制小数转换成十六进制小数的步骤

4.同步练习

1)把十进制数825、10815.6转换成二进制;

2)把十进制数658、9240.65转换成八进制;

3)把十进制数2508、5420.82转换成十六进制。

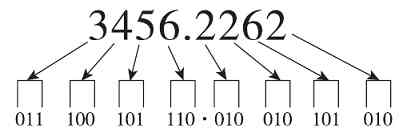

1.2.3 非十进制数之间的相互转换

从表1-1可以得出这样一个规律:1位八进制数对应3位二进制数,而1位十六进制数对应4位二进制数。因此,二进制数与八进制数之间、二进制数与十六进制数之间的相互转换十分容易。

1.相互转换方法

非十进制数间的具体转换方法如下:

1)八进制数转换成二进制数的方法是:将每1位八进制数直接用相应的3位二进制来表示;二进制数转换成八进制数的方法是:以小数点为边界,整数部分向左,小数部分向右将每3位二进制分成一组,若不足3位则用0补足3位;然后将每一组二进制数直接用相应的1位八进制来表示。

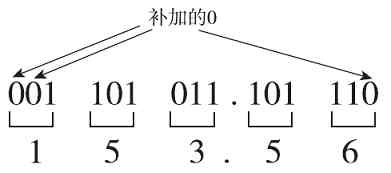

例如要将(3456.2262)8 转换为二进制数的方法是依次把八进制的每1位用3位二进制表示(如图1-9所示),最后的结果为(11100101110.010010101010)2 (整数部分最前面的0可以省略)。

图 1-9 八进制转换成二进制示例

例如要将(1101011.10111)2 转化为八进制数,可以把整数部分从右向左每3位分为一组,最后不足3位时加0补上,然后把小数部分从左向右(与整数部分的划分顺序相反)同样以每3位分为一组,最后不足3位时加0补上(如图1-10所示),最后的结果为(153.56)8 。

图 1-10 二进制转换成八进制示例

2)十六进制数转换成二进制数的方法是:将每1位十六进制数直接用相应的4位二进制来表示。二进制数转换成十六进制数的方法是:以小数点为边界,整数部分向左,小数部分向右将每4位二进制数分成一组,若不足4位则用0补足4位;然后将每一组二进制数直接用相应的1位十六进制表示。

例如将(4AF.51)16 转换成二进制数的最后结果为(100 1010 1111.0101 0001)2 ;将二进制数(11 0110 1110.1010 1010 1000)2 (最后部分的三个0是划分位时补上去的,下同)转换为十六进制数的最后结果为(36E.AA8)16 。

3)八进制与十六进制的相互转换最好的方法就是先把其中一个转换成二进制,然后再把所得到的二进制转换成另一个进制的数。

如八进制数(6237.431)8 转换成十六进制的步骤为:

步骤1:将(6237.431)8 转换成二进制(每1位用3位二进制表示),得到的二进制结果是(110010011111.100011001)2 。

步骤2:再将(1100 1001 1111.1000 1100 1000)2 转换成十六进制(以小数点为边界,整数部分从右向左每4位分为一组,最后不足4位时加0补上,然后把小数部分从左向右将每4位二进制数分成一组,若不足4位则用0补足4位),得到最终的十六进制结果为(C9F.8C8)16 。

将十六进制(3AB.11)16 转换成八进制的步骤与上边的步骤类似,具体转换过程如下:

步骤1:先将十六进制数(3AB.11)16 转换成二进制,得到(001110101011.00010001)2 。

步骤2:再将(001 110 101 011.000 100 010)2 转换成八进制以小数点为边界,整数部分从右向左每3位分为一组,最后不足3位时加0补上,然后把小数部分从左向右将每3位二进制数分成一组,若不足3位则用0补足3位,最后的结果为(1653.042)8 。

以上二进制、八进制、十六进制的对应关系可参见表1-1,根据该表可直接进行转换。

2.同步练习

1)把(1011011)B、(10110111.0010)B转换成八进制;

2)把(1100111011)B、(11101001.101)B转换成十六进制;

3)把(758)O、(8265.42)O转换成十六进制;

4)把0xA58C、0x8152.78转换成八进制。

1.3 二进制数运算

二进制数在计算机中是应用最广的,因为它最简单,数码仅1和0两个,可以代表电平的高和低,或者电压的正和负,或者电路的开与关等。

对于二进制数,除了与十进制数一样可以进行四则算术运算外,还可以进行逻辑运算,因为它只有两个数码,可以代表两种截然相反的状态。本节将分别介绍二进制数的四则算术运算和逻辑运算。

1.3.1 二进制四则算术运算

二进制数的加、减、乘、除四则算术运算法则其实与十进制数的四则算术运算法则是一一对应的。理解了十进制数的四则算术运算法则,二进制数的四则算术运算就一点都不难了。下面分别予以介绍。

1.加、减法运算

首先要了解二进制的加、减法运算法则。

(1)加法运算法则

0+0=0,0+1=1,1+0=1,1+1=10,也就是当两个相加的二进制位仅一位为1时,相加的结果为1;如果两个二进制位全是0,相加的结果仍为0;而如果两个相加的二进制位均为1,则结果为10(相当于十进制中的2),也就是“逢2进1”规则,与十进制中的“逢10进1”的道理一样。

在进行二进制加减法运算时,最关键的一点就是逢2进1,进1当1,而借1当2。大家联想一下我们经常使用的十进制数加法运算法则,那就是逢10进1,进1当1,而借1当10,这样一来我们就好理解了。二进制数的加法运算法则只是把原来十进制数加法运算法则中的10改成了2。

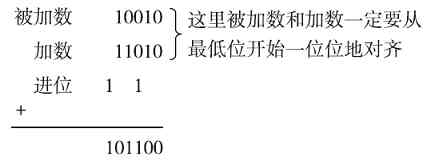

计算(10010)2 +(11010)2 的过程如图1-11所示(注意两数要从最低位开始对齐)。

图 1-11 二进制加法运算示例

1)首先是进行最低位相加,这里加数和被加数都为“0”,根据加法法则可以知道,相加后为“0”;

2)再进行倒数第二位相加,这里加数和被加数都为“1”,根据加法法则可以知道,相加后为“(10)2 ”,此时把后面的“0”留下,而把第一位的“1”向高一位进“1”;

3)再进行倒数第三位相加,这里加数和被加数都为“0”,根据加法法则可以知道,本来结果应为“0”,但倒第二位已向这位进“1”了,此时就要同时把“被加数”、“加数”和“进位”这三个数加起来了,所以结果应为0+0+1=1;

4)再进行倒数第四位的相加,这里加数和被加数分别为“1”和“0”,倒数第三位也没有进位,根据加法法则可以知道,相加后为“1”;

5)最后是最高位相加,这里加数和被加数都为“1”,根据加法法则可以知道,相加后为“(10)2 ”。同样需把第一位的“0”留下,并向高位进1,这样会产生新的最高位,值为“1”(如果超出了字长的限制,则新产生的最高位将溢出)。

这样(10010)2 +(11010)2 的最后运算结果为101100。

(2)减法运算法则

1-1=0,1-0=1,0-0=0,0-1=-1,也就是当两个相加的二进制位中同为0或1时,相减的结果为0;如果被减数的二进制位为1,而减数的二进制位为0,则相减的结果仍为1;而如果被减数的二进制位为0,而减数的二进制位为1,则需要向高位借1,但此时是借1当2,与十进制中的借1当10道理一样。

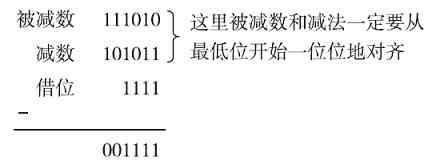

计算(111010)2 -(101011)2 的过程如图1-12所示(注意两数要从最低位开始对齐)。

图 1-12 二进制减法运算示例

1)首先是最低位相减,这里被减数为“0”,减数为“1”,不能直接相减,需要向高位(此时为倒数第二位)借“1”,这样相当于得到了十进制中的“2”,用2减1结果就得到1。

2)再对倒数第二位相减,此时本来被减数和减数均为“1”,但是被减数的该位被上一步借走了1,所以最后就变为“0”(1-1)了。此时也不能直接与减数相减了,又需要向高位(此时为倒数第三位)借1。同样是借1当2,相当于该位总共为0+2=2。这样倒数第二位相减后的结果为2-1=1。

3)用上一步同样的方法计算倒数第三位和倒数第四位的减法运算,结果都为1。

4)再计算倒数第五位的减法运算,此时被减数原来为“1”,可是已被倒数第四位借走了1,所以成了“0”(1-1),而此时减数也为“0”,可以直接相减,得到的结果为“0”。

5)最后计算最高位的相减,被减数和减数均为“1”,可以直接相减,得到的结果为“0”。

这样一来,(111010)2 -(101011)2 的结果是(001111)2 ,由于整数的前导0可以不写,所以最后结果就是(1111)2 。

2.乘、除法运算

同样,首先要了解二进制的乘、除法运算法则。

(1)乘法运算法则

0×0=0,0×1=0,1×0=0,1×1=1,也就只有当两个相乘的二进制位都为1,相乘的结果才为1;两个相乘的二进制位中只要有一位为0(也包括是两位同时为0),则相乘的结果都为0。也可以这么理解:1与任何数相乘的结果就是对应的被乘数;而0与任何数相乘的结果都为0。这与十进制中的乘法运算法则也是一样的。要注意的是,在乘法运算中,乘数的每一位要与被乘数的每一位分别相乘,而不仅是对应位相乘,而且乘数的每一位与被乘数的每一位相乘的结果的最低位要与对应的乘数位对齐。当然这与十进制的乘法运算法则也是一样的,很好理解。

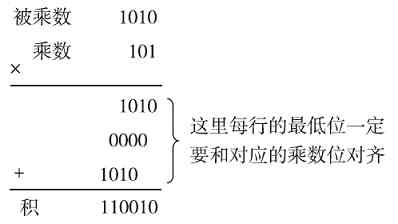

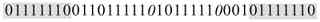

计算(1010)2 ×(101)2 的过程如图1-13所示(注意两数要从最低位开始对齐)。

图 1-13 二进制乘法运算示例

1)首先是乘数的最低位与被乘数的所有位相乘,因为乘数的最低位为“1”,根据乘法法则可以得出,结果其实就是被乘数本身,直接复制下来即可。此处结果就为1010。

2)接着进行的是乘数的倒数第二位与被乘数的所有位相乘,因为乘数的这一位为“0”,根据乘法运算法则可以得出,结果均为“0”。此处结果就为0000。

3)然后是乘数的最高位与被乘数的所有位相乘,此时乘数为“1”,结果就是被乘数本身。此处结果就为1010。

4)最后再按照前面介绍的二进制加法原则对以上三步所得的结果按位相加(但这里的位对齐方式与单纯的二进制数相加不一样,最低位一定要与对应乘数位对齐。这也与十进制的乘法运算方法一样),结果得到(110010)2 。

(2)除法运算法则

当被除数大于除数时,商是“1”;当被除数小于除数时,不够除,商只能是“0”,这与十进制的除法也类似。二进制只有两个数(0,1),因此它的商也只能是1或0。

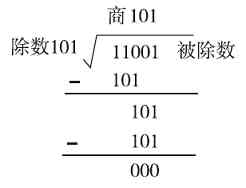

计算(11001)2 ÷(101)2 的过程如图1-14所示。

图 1-14 二进制除法运算示例

1)因为除数为“101”,有3位,所以在被除数中也至少要取3位(从最高位开始取)。被除数的高3位为“110”,恰好比除数“101”大,可以直接相除,但商只能是1(因为二进制的最大数元就是1),然后把被除数减法商“1”与除数相乘后的结果,得到的值为“1”。

2)再从被除数中取下一位“0”下来,与上一步的差“1”值组成新的被除数,为“10”,显然它比除数“101”小,不够除。于是在商的对应位置上输入“0”。

3)继续从被除数中取下一位“1”下来,与上一步的余数“10”值组成新的被除数,为“101”,此数正好与除数“101”相等,所以此时的商取“1”,正好除尽。

这样一来(11001)2 ÷(101)2 所得的商就是(101)2 了。

3.同步练习

1)求(011101)B+(10010)B、(100111)B+(110110)B的值;

2)求(1110101)B-(110010)B、(1101011)B-(10001)B的值;

3)求(1110)B×(1001)B、(1100)B×(10111)B的值;

4)求(110010)B÷(1010)B、(100110101011)B÷(1011)B的值。

1.3.2 二进制逻辑运算

逻辑运算是指对因果关系进行分析的一种运算,这也是在计算机中经常采用的一种二进制运算。逻辑运算的结果并不表示数值大小,而是表示一种逻辑概念,若成立则为“真”,或用“1”表示;若不成立,则为“假”,或用“0”表示。二进制的逻辑运算主要有“与”、“或”、“非”和“异或”四种。

1.“与”运算(AND)

“与”运算又称逻辑乘,用符号“·”或“∧”来表示。运算法则如下:

0∧0=0 0∧1=0 1∧0=0 1∧1=1

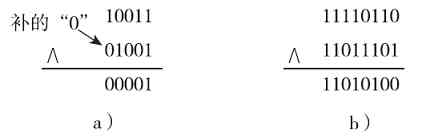

归纳起来也就是在“与”运算中,只要两个参加“与”运算的数的对应位有一个为0,运算结果就为0;仅当两数的对应位均为1时结果才为1,很容易判断。这与前面介绍的二进制乘法运算是一样的。图1-15所示是两个“与”的逻辑运算示例。图1-15a所示的是两个位数不一样的二进制数进行“与”运算,这时要求两个数从最低位开始对齐,在位数少的二进制的最高位前面加上“0”补齐,使得它与位数多的二进制数有一样的位数。

图 1-15 两个“与”逻辑运算示例

2.“或”运算(OR)

“或”运算又称逻辑加,用符号“+”或“∨”表示。运算法则如下:

0∨0=0 0∨1=1 1∨0=1 1∨1=1

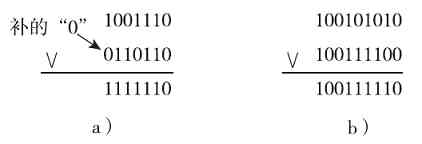

也就是说,在“或”运算中,只要两个参加“或”运算数的对应位中有一个为1,运算结果就为1,仅当两数的对应位均为0时结果才为0,也很容易判断。如图1-16所示是两个“或”的逻辑运算示例。同样,进行“或”运算时要求两数从最低位开始对齐,位数少的数在最高位前面加“0”补齐,最终使两个二进制数的位数相同。

图 1-16 两个“或”逻辑运算示例

3.“非”运算(NOT)

“非”运算就是逐位求反的运算,其运算法则为:“0”的反值为“1”,“1”的反值为“0”,也就是“0”与“1”互为反。注意:“非运算”只是针对一个二进制数进行的,这与前面的“与”和“或”运算不一样。如“101110101”进行“非”运算后就得到“010001010”(可简写为“10001010”)。

4.“异或”运算(XOR)

“异或”运算用符号“⊕”来表示。其运算法则如下:

0⊕0=0 0⊕1=1 1⊕0=1 1⊕1=0

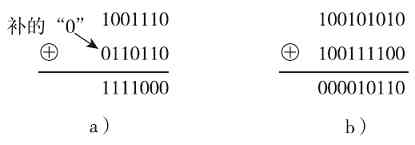

也就是说,当两个参加“异或”运算的二进制数对应位相同时运算结果为0,不同时运算结果为1。图1-17所示是“异或”逻辑运算示例。同样,进行“异或”运算时要求两数从最低位开始对齐,位数少的数在最高位前面加“0”补齐,最终使两个二进制数的位数相同。

图 1-17 两个“异或”逻辑运算示例

5.同步练习

1)求(11001)B∧(1011)B、(10011)B∧(10101)B的结果;

2)求(11001)B∨(1011)B、(10011)B∨(10101)B的结果;

3)求(1100110)B、(1000111)B非的结果;

4)求(1100110)B⊕(1011)B、(100111)B⊕(10101)B的结果。

1.4 二进制数的表示形式

结束了以上各种进制数之间的转换,我们来谈谈另一个话题:原码、反码、补码和移码。其实它们都是计算机中二进制数(称之为“机器数”)的不同表示形式,之所以会有这么多码,最根本的原因就是计算机只有加法运算器,减法运算需要转换成负数的加法。这里又出现一个问题,那就是计算机如何来识别负数?因为它不能像人的大脑一样可以识别“+”、“-”之类的符号,故必须用一个专门的位来表示数的符号,这就是计算机中的“有符号数”的由来。

我们已经知道,计算机中所有数据最终都是使用二进制数表示的。我们也已经学会如何将一个十进制、八进制和十六进制数转换为二进制数,但我们仍然不知道如何将一个负数用二进制形式来表示,因为我们前面学习的都是针对正数的,无论是整数,还是小数。其实,在计算机中负数是以其正数的补码形式表示的,这就是本节所要介绍的主题。

1.4.1 二进制数的真值和字长

前面说了,负数是通过其正数的补码形式来表示的,那什么是补码呢?这还得从原码、反码说起。在计算机二进制数中其实也包括符号位,并不是所有位都代表数据本身,就像我们常用的十进制数中有正、有负一样。但是二进制中没有“-”这个符号,那么计算机中的机器数的符号是怎样规定的呢?这得从机器数的两个基本概念(真值和字长)说起。

(1)真值

计算机中的二进制机器数分为“有符号数”和“无符号数”两种。“无符号数”就是二进制数的每一位都代表对应位的数值;而在“有符号数”中规定最高位用来表示数据符号,其中1代表负,0代表正,这样一来机器数本身就不等于真正的数值了。例如有符号数10000101,其最高位1代表负,所以余下的“0000101”才是数值本身,所以其真正数值是-5,而如果是无符号数,则10000101所代表的是133。为区别起见,把带符号位的机器数所对应的真正数值称为机器数的“真值”。例:00100001的真值=0 0100001=+33(正号可以不写,可以直接写成33),10100011的真值=1 0100011=-35。

(2)字长

在机器数中还有一个概念需要首先弄明白,那就是“字长”。“字长”是指计算机一次可处理的二进制数的码位长度,是计算机进行数据存储和数据处理的运算单位。如我们通常所指的32位处理器,就是指该处理器的字长为32位,也就是一次能处理32位二进制数。通常称16位是一个字,32位是一个双字,64位是两个双字。

数值的转换结果是与字长有关的。如果计算机字长为8位,十进制中的数+5转换成二进制就是00000101,-5转换成二进制就是10000101;但如果字长是16位,+5转换的结果就是00000000 00000101,而-5转换成二进制就是10000000 00000101了。也就是对应的机器数要转换为字长所代表的位数。

字长越长代表计算机的处理能力越强,可以处理的数越大。如现在字长普遍是64位的了,这样一来计算机可以处理的二进制数码位长度最大为64位,去掉符号位,则表示计算机可以处理的最大二进制数为2的63次方,最小二进制数就是-2的63次方。而在8位字长中,因为最高位要用于符号位,所以实际可以处理的数值大小范围为-127~-00127(即27 -1),共256个数了;但如果字长是16位,可以处理的数值大小就可以是-32677~-0032767(215 -1)。

注意 以上的“-0”与“0”的机器数是不一样的,在8位字长中,-0为1 0000000,而+0为0 0000000;在16位字长中,-0为1 0000000 00000000,而+0为0 0000000 00000000。所以在二进制的机器数中,0也有两个(-0和0),且表示形式并不一样。

1.4.2 二进制数的四种表示形式

计算机中的二进制数有四种主要表示形式,那就是原码、反码、补码和移码,其中最重要的是前三种。反码和补码是为了在二进制中表示负数而产生的。本节具体介绍这四种表示形式。要注意的是,采用哪种表示形式,运算的结果也是对应的表示形式。

1.原码

对于人脑来说,我们都知道,+表示正数,-表示负数,然而在计算机二进制中也引入这两个符号肯定是不行的,因为在计算机中只有0和1这两个字,根本不认识“+”和“-”这两个符号。计算机中的任何行为都依赖于它的物理结构。计算机是没有思维的,所以得让计算机在0和1之间识别出对应数的正与负。

最开始的时候,人们约定在一个二进制数前用第一位(最高位)来表示符号,即1表示负,0表示正,这就是最初“原码”的概念。“原码”就是“原始码位”,或者“原始编码”的意思,就是对应二进制数本身所代表的形式。比如,+3(以8位字长为例,下同),符号位为0,3转化为二进制就是11,那么+3的原码就是00000011(最高位为符号位,正数的符号位为“0”,其余数值位不足部分补0)。同理,-3的符号位为1,3转化为二进制就是11,最终-3的原码就是10000011(不足8位时在前面用0补足)。在日常的书写中,原码的表示形式是用方括号下面加上一个“原”字下标来区别的,如[+3]原 =00000011,[-3]原 =10000011。

再来计算+127和-127各自的原码。+127中符号位为“0”,127的二进制为“1111111”,这样[+127]原 =01111111;而-127中的符号位也为“1”,所以最终[-127]原 =11111111。

最应该注意的是,在原码表示形式中,0有“+0”和“-0”之分。对应的原码分别是0 0000000和1 0000000。

2.补码

原码的设计很不错,至少可以成功地区分出二进制数的正与负了,但是这种方法仍有一些局限性,那就是原码在加、减法运算中不方便,符号位需要单独处理、单独判断。同为正数的加、减是没什么问题的,可是异号相加、减时就存在问题了。如1-1,如果用原码计算的话结果为-2,显然不正确。

(0 0000001)原 +(1 0000001)原 =(1 0000010)原 =-2

另外,在原码中0有+0和-0两种表示形式,这就存在二义性了,在计算机中是绝对不能容忍的。于是后来就想到一种能解决原码中存在的这些问题的另一种表示形式——补码。

补码的编码规则如下:正数的补码和原码相同;负数的补码是通过先把除符号位外其他各位取反,再在末位(最低位)加1得到的。这样,我们只要让减数通过一个求反电路,再通过一个+1电路,然后再通过加法器就可以实现减法运算了。

经验之谈 如果要把一个补码转换成原码该如何操作呢?很简单,只需要把原码转换成补码的过程倒过来操作就行了。因为正数的补码与原码一样,所以正数补码的原码就是其补码,而负数补码的原码是先在最后一位加1,然后对其除符号位外的其他各位全部取反得到。只有相同码制的数才能进行操作,结果就是对应的码制,也就是原码数与码数的运算,结果也为原码,反码数与反码数的运算结果也为反码,补码数与补码数的运算结果也为补码。如果结果是负数,要判断结果是否正确,需要再将其对应的码制转换为原码。

补码首先继承了原码的特点(可以表示正与负),而且它包括了两个优点:

❏可以把符号位一起运算;

❏0只有一种表示形式,没有二义性。

下面同样以上面的1-1为例,如果采用补码形式,则算式如下:

(0 0000001)补 +(1 1111111)补 =0 0000000=0

结果完全正确。其实这里涉及一个计算机运算中“模”的概念。

我们把一个计量单位称为模或模数。例如,时钟是以十二进制进行计数循环的,即以12为模。在时钟上,时针加上(正拨)12的整数倍或减去(反拨)12的整数倍,时针的位置不变。例如,14点钟在舍去模12后,成为(下午)2点钟(14=14-12=2);从0点出发逆时针拨10格即减去10小时,也可看成从0点出发顺时针拨2格(加上2小时),即2点(0-10=-10=-10+12=2)。因此,在模12的前提下,-10可映射为+2。

由此可见,对于一个模数为12的循环系统来说,加2和减10的效果是一样的。所以,在以12为模的系统中,凡是减10的运算都可以用加2来代替,这样就把减法问题转化成加法问题了(注:计算机的硬件结构中只有加法器,所以大部分的运算都必须最终转换为加法)。10和2对模12而言互为补数。

同理,计算机的运算部件与寄存器都有一定字长的限制,因此它的运算也是一种模运算。如果字长为8,则当计数器计满8位也就是256个数后会产生溢出,又从头开始计数。产生溢出时的那个量就是计数器的模。显然,8位二进制数的模数为2的8次方,即256。在计算中,两个互补的数称为“补码”,这就是“补码”表示形式诞生的由来。

十进制数2-3=(0 0000010)补 +(1 1111101)补 =(11111111)补 =-1,也是正确的。十进制数123-121=(0 1111011)补 +(1 0000111)补 =(0 0000010)补 =2,也是正确的。

另外,在补码表示形式中,0仅有一种表示形式,因为无论是“+0”,还是“-0”的补码均为0 0000000。

3.反码

通过以上介绍,我们可以知道,补码是我们的最佳选择,因为它可以全面解决异号二进数之间的加减运算问题。那为什么还有“反码”这种表示形式呢?其实“反码”是“原码”向“补码”表示形式转变过程中的一个过渡形式,最终证明它是失败的。之所以当初会想到“反码”,是因为它太容易从电路上来实现了(仅需要取反就行了)。但“反码”专门是针对负数进行的(正数的反码与原码一样),就是对二进制负数按位(除符号位外)取反,原来为1就变为0,原来为0就变为1。而且采用反码形式对于一些异号二进制运算还是正确的,如上面所说的“2-3”,采用反码运算的格式如下:

(0 0000010)反 +(1 1111100)反 =(1 1111110)反 =-1

但是在1-1的反码运算中,结果就不正确了:

(0 0000001)反 +(1 1111110)反 =(1 1111111)反 =-0

本来应该是+0的,结果却成了-0。

再如十进制数“123-121”,用反码加法运算就得到:

(0 1111011)反 +(1 0000110)反 =(0 0000001)反 =1

显然也不正确。

注意 反码是相互的,如10011001的反码为11100110(符号位是不变的),相反11100110的反码也是10011001。另外,与原码一样,在反码表示形式中0也有“+0”和“-0”之分,对应的反码分别为0 0000000和1 1111111。

综上可以得出:正数的原码、反码和补码都是一样的,而负数的这三种表示形式就不一样了,负数的反码是对原码中除符号位外的其他各位取反,而负数的补码是再对其反码加1,也就是先对其原码中除符号位外的其他各位取反,然后再在最低位加1。

4.移码

移码是一种比较特殊的二进制数表示形式。它的编码规则如下:

❏正数的符号位为1,负数的符号位为0;

❏真值部分与补码一样。

从以上两个编码规则中可以看出,要求一个二进制数的移码,只需先求出它的补码,然后再把符号位取反(因为在补码中规定符号位1表示负数,0为正数,正好相反)就行了,所以移码又称为符号位取反的补码。如:5的二进制移码(假设字长为8)为10000101,-5的二进制移码为01111011(它是对-5的补码符号取反的结果)。

其实还有一种更简单的计算移码的方法,那就是[X]移 =2的n次方(n为二进制数的位数,不包括符号位)的二进制值+X。如[-11010]移 =[25 ]B+(-11010)=1000000-11010=000110。现在我们再来利用上面所介绍的补码符号位取反的方法来重新计算一下,验证以上结果是否正确。

[-11010]B的补码为100110,符号位取反后得到000110,最后证明两种算法结果一样。

1.4.3 补码的加减法运算

上节介绍了原码、反码、补码和移码的转换方法,同时我们知道,在计算机机器数中实际上全是采用补码方式进行运算的,特别是减法运算。因为原码和反码的减法运算有时结果是不正确的。所以本节仅介绍补码的加、减法运算方法。

1.补码的转换

在正式介绍补码的加减法运算前,还是先回顾一下补码的运算方法,这是补码运算的基础。通过前面的学习,我们知道,机器数的补码可由原码和反码得到。如果机器数是正数,则该机器数的补码与原码一样;如果机器数是负数,则该机器数的补码是对它的反码在未位加1而得到的。

例如,当X=+0.1011时,根据以上规则可得到[X]补 =0.1011(因为正数的补码与原码、补码一样)。而当X=-0.1011时,则[X]补 =1.0101(负数的补码是符号位不变,真值是在它的反码基础上最后位加1得到的)。这里的“1011”的反码(也就是按位取反)为“0100”,再在末位加“1”后即得到了“0101”,最后再加上符号位“1”,所以最后的值为1.0101(符号位是最高位)。

又例如,X=+1010时,则[X]补 =01010(正数的补码与原码、反码一样,注意在最高位要体现数的正、负符号)。而当X=-1010时,则[X]补 =10110。运算方法一样:先计算“1010”的反码,为“0101”,然后再在末位加“1”,得到“0110”,最后再加上符号位“1”,即得到“10110”。

经验之谈 整数“0”的补码只有一种表示形式,即00…0,因为“-0”的补码最终结果也是“0”,如字长为8时,-0的原码就为10000000,求其补码时,首先是在原码中除符合位外的其他位取反(得到1 1111111),然后在最后位加1,得到10 0000000,注意这里一共有9位了。因为字长为8位,所以9位的1会溢出,这样最后得到的补码值同样为“00000000”,也就是0。如果采用16位字长,“-0”的补码同样为“00000000 00000000”,因为这将产生值为“1”的第17位,而这个第17位在16位字长中同样是溢出的。

表1-2是8位二进制的原码、反码、补码对照表。在进行表示形式转换时如果记得这个数,有时速率会快许多。

2.补码的加法运算

补码的加法运算法则如下:

[X+Y]补 =[X]补 +[Y]补

该式表明,两个有符号数相加的补码可以通过先分别对两个数求补码,然后相加得到。在采用补码形式表示时,进行加法运算时可以把符号位和数值位一起进行运算(若符号位有进位,则溢出不管),结果为两数之和的补码形式。

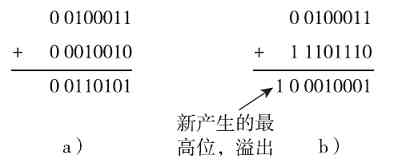

如要求两个十进制数:35+18的补码(假设字长为8)。根据上面的补码加法运算法则可以得知,只需分别求35和18这两个数的补码,然后相加即可。又因这两个数都是正数,所以它们的补码与原码一样。这样一来,这道题实际上也就是求35和18这两个十进制数的原码和。35的原码为0 0100011(注意:最高位为符号位),18的补码为0 0010010。所以35+18的补码就等于(0 0100011)B+(0 0010010)B=(00110101)B,如图1-18a所示。如果转换成十进制就等于53,结果正确。如果相加后有超过字长的位溢出,则直接丢弃。

同理,如果要求两个十进制数:35+(-18)和的补码也是直接求35和-18的补码和。35的补码与其原码一样,前面已计算出,为0 0100011;而后面那个“-18”因为是负数,所以不能直接从它的原码得到补码。需要先求-18的原码1 0010010,然后对其除符号位外的其他各位取反,得到其反码(为1 1101101),最后再在其末位(最低位)加1,最终得到其补码为1 1101110。

这样一来,“35-18”的补码就是(00100011)B+(11101110)B,结果为00010001,如图1-18b所示。这里要注意,两个补码相加后产生了第9位(为1)的溢出,直接丢弃,所以结果就是(00010001)B。如果转换成十进制的话就等于17,结果正确。

图 1-18 两个补码加法运算示例

3.补码的减法运算

补码的减法运算法则如下:

[X-Y]补 =[X]补 +[-Y]补

该公式表明,求两个机器数的差值(如[X-Y]补 )的补码,可以通过求被减数的补码(如[X]补 )与减数的负值的补码([-Y]补 )的和得到。

[-Y]补 是对减数进行求负操作,求负的规则是全部位(含符号位)取反后再加1(实际上也是分别对符号位和真值位进行求反,因为正数与负数的符号也正好相反)。例如:已知[15]补 =00001111,则[-15]补 =11110000+1=11110001。

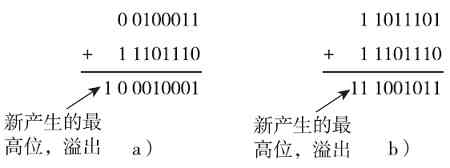

现在假设X=+35,Y=+18,要求[X-Y]补 (字长为8)。

先根据正数的补码与原码一样的规则,求得[X]补 =00100011,[Y]补 =00010010;再根据以上介绍的补码求负操作规则,即可得到[-Y]补 =11101110;最后用[X]补 +[-Y]补 公式即可得到最终的[X-Y]补 =00010001,如图1-19a所示。转换成十进制,也可得到结果17,正确,且与上面使用加法法则运算的结果一样。注意,这里相加的结果也产生了溢出的第9位(1),直接丢弃。

图 1-19 两个补码减法运算示例

注意 原码、反码和补码运算的结果也是对应的表示形式,因为正数的原码、反码和补码都一样,所以当反码、补码的运算结果为正数时,反码和补码的结果也就是对应的原码。但是如果结果是负数,则反码、补码的结果不等于原码,必须经过相应的操作才能转换为原码。如负数的反码要转换为原码必须对反码除符号位外的其他位全部取反;而负数的补码要转换为原码必须先在该补码的最后一位减1,然后对除符号位外的其他各位取反才能得到。

如有两个十进制数分别是X=-35,Y=-18,现要求[X+Y]补 的值,很显然这个结果是一个负数。根据前面介绍的加法法则得知,可先求得[X]补 和[Y]补 的值,然后再相加,即[X]补 +[Y]补 。根据本章前面介绍的知识,我们很快可以算出[-35]补 为1 1011101,[-18]补 =11101110。最后[-35]补 +[-18]补 的运算过程如图1-19b所示,结果为11001011。注意这是一个有符号位数,所以结果为-75。这样看起来结果是不正确的,因为-35-18应该等于-53。这时就要特别注意了,这个-75是一个补码形式,要看最终的结果,还得把它转换成原码。按照上面介绍的方法可得[-75]补 的原码为10110101(注意它也是一个有符号位,最高的1代表为负数)=[-53]原 。这样结果就正确了。

4.同步练习

1)求[85+24]补 、[152+35]补 的值;

2)求[185-56]补 、[52-135]补 的值。

第2章 计算机网络概述

本章作为本书的开篇(除了作为选学内容的第1章),先从宏观角度对计算机网络进行了概括性的介绍,以便使大家对计算机网络有一个基本的了解。本章内容比较丰富,这对于以前对计算机网络方面的知识了解较少的朋友来说非常重要。相信你学完本章之后,再与朋友谈论有关计算机网络方面的话题时也可以对上几句了,再也不会像以前一样被“冷落”,让朋友觉得你完全是一个局外人了。

本章主要介绍计算机网络的一些基础知识,包括计算机网络的发展历史、基本组成、作用、分类、拓扑结构等。本章的重点是理解各种拓扑结构的主要特性和优缺点。当然,本章只是概述,详细介绍将在后续章节进行。

2.1 计算机网络概述

学习计算机网络,应从了解计算机网络定义、计算机网络发展历史、计算机网络的基本组成和主要应用开始。这些都是最基本、最基础的计算机网络的知识,也是我们平时与朋友经常聊到的内容。

2.1.1 计算机网络的定义

“计算机网络定义”就是“什么是计算机网络”。其实这个问题并不是很重要,而且也没有一个非常精确的定义。一开始只要我们知道眼前所见到的那些由许多计算机设备通过电缆连接在一起所组成的系统就是计算机网络就行了。

计算机网络从诞生起,发展至今也仅有50多年的历史了(真正的计算机网络是从1969年美国国防部高级研究计划署(ARPA)建立ARPANet开始的,这部分内容将在本章后面介绍)。在这短短的50来年的时间里,各方面的计算机网络技术的发展和普及真可谓“日新月异”,真的很难想象最早的几兆连接速率在这么短时间里已发展到了几十吉的连接速率,增加了几千倍。随着计算机网络技术和应用的不断发展,计算机网络的内涵也在不断发生变化,所以关于“计算机网络”,至今仍没有一个严格意义上的权威定义。

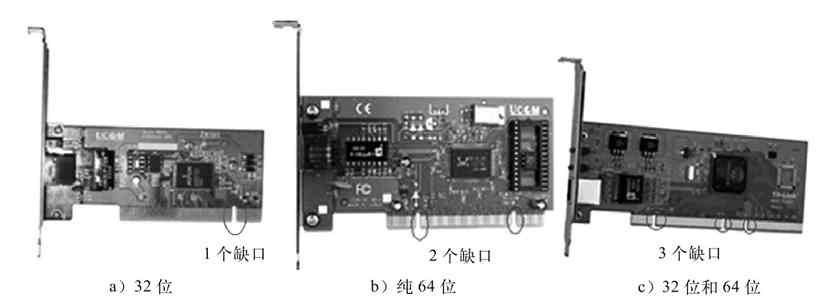

目前通常认为“计算机网络”是指将不同地理位置,具有独立功能的多台计算机及网络设备通过通信线路(包括传输介质和网络设备)连接起来,在网络操作系统、网络管理软件及网络通信协议的共同管理和协调下实现资源共享和信息传递的计算机系统。如果你还不知道计算机网络为何物的话,回到家里,或者到网吧,或者去你所在的公司去亲眼看一下吧。你所看到的那一台台看似独立、位于不同位置的PC(个人计算机),通过一些电缆和一些盒子状的设备(如交换机、路由器)连接起来的就是一个计算机网络。

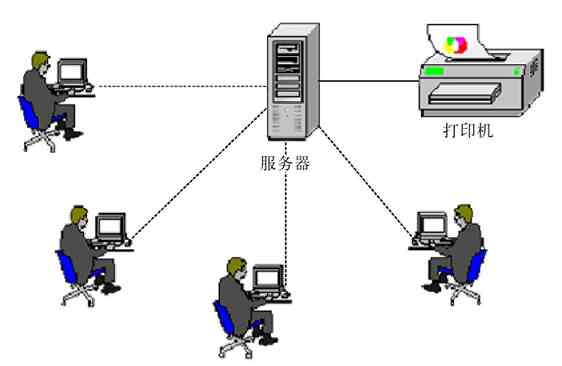

简单地讲,计算机网络就是许多独立工作的计算机系统通过通信线路(包括连接电缆和网络设备)相互连接构成的计算机系统集合,或者计算机系统团体。而在这个计算机系统集合中,可以实现各计算机间的资源共享、相互访问,可以进行各种需要的计算机网络应用。其中的计算机可以是微机、小型机、中型机、大型机或巨型机等,网络设备包括网桥、网关、交换机、AP、路由器、防火墙等。但仅有这些硬件是不可能组成计算机网络的,还必须有相应的软件系统支持,这方面内容将在本章后面介绍计算机网络组成时再详述。这里所说的“资源共享”包括:硬件资源共享、软件资源共享、数据资源共享这三个方面。硬件资源共享的最典型例子就是我们最常用的打印机共享(还记得和其他电脑使用一台打印机来打印文件的情形吗?如图2-1所示)、磁盘共享(如网吧中的无盘网络)。

图 2-1 硬件资源共享示例

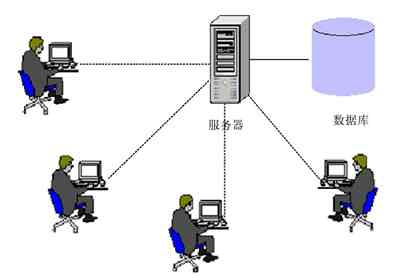

数据资源共享的典型例子就是数据库资源共享,各网络用户可以集中调用一台数据库服务器中的相关数据信息,如图2-2所示。各种应用服务器也是数据资源共享的实例,如通过FoxMail、OutLook等客户端邮件软件收取邮件,你和你的好友天天玩的网络游戏,或者你和你的家人天天在家里不同电脑中看的网上的同一部电影等。至于软件资源共享的例子也是非常多的,比如在企业内部网络中我们会在服务器上为所有员工提供一些常用工具软件共享,让用户自己选择安装。如果推到互联网上,则更直观了,我们从网上下载的各种软件都是软件资源共享的实例。

图 2-2 数据库资源共享示例

2.1.2 计算机网络的发展历史

计算机网络发展至今已经历了几代变革,不仅计算机网络的内涵发生了巨大的改变,计算机网络技术和网络应用都不再是几十年前第一、第二代计算机网络所能比拟的了。了解计算机网络的整个发展历史,有助于我们对计算机网络技术和应用的发展有一个清晰的认识,也有助于我们分清目前哪些才是主流应用的技术,哪些是已过时、我们不用去学的技术。当然要先有了计算机,才能有计算机网络,就像肯定是先有人,然后才会有人类社会一样。总体来说,可以把计算机网络的发展历程归纳为以下几个阶段。

(1)第一代计算机网络(面向终端的计算机网络)

1946年,世界上第一台数字计算机问世。但当时的计算机数量非常少,且非常昂贵。由于当时的计算机大都采用批处理方式,所以用户计算机首先要将程序和数据打印成纸带或卡片,再送到计算中心去处理。1954年,出现了一种称为收发器(Transceiver)的终端,人们使用这种终端首次实现了将穿孔卡片上的数据通过电话线路发送到远地的计算中心计算机的过程。自此以后,电传打字也可作为远程终端与计算机相连了,用户可以在远地的电传打字机上输入自己的程序,而计算中心通过计算机计算出来的结果也可以传到远地的电传打字机上并打印出来。当时的这种简单的传输系统就是计算机网络的基本原型。当然,这些离我们有些远,现在的我们不必研究这些收发器终端及其数据传输原理。

第一代计算机网络是以计算机主机(其实相当于我们现在所说“计算机服务器”)为中心,一台或多台终端围绕计算机主机分布在各处,而计算机主机的任务是进行成批处理,用户终端则不具备数据的存储和处理能力。从某种意义上来说,这根本不能算是真正的计算机网络,因为终端并不具备独立工作的能力。所以我们现在说,计算机网络的诞生通常不是指第一代计算机网络,而是从下面将要介绍的第二代计算机网络开始算起的。这里所说的“终端”是指由一台计算机外围设备组成的简单计算机,有点类似于现在所说的“瘦客户机”,仅包括CRT显示器、键盘,没有CPU和硬盘,所以没有数据存储和处理能力。之所以网络中更多的是计算机终端,因为那时的计算机非常昂贵,为了节省成本,所以在用户端通常是使用那些不带关键部件的计算机终端。

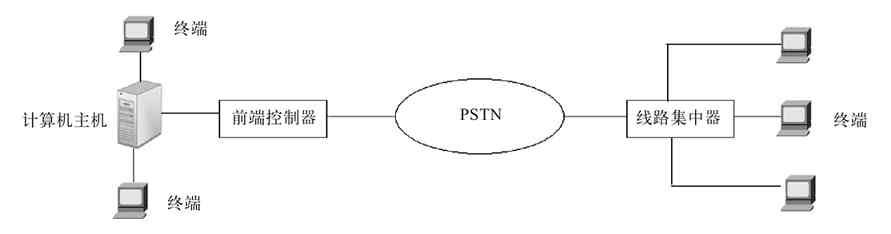

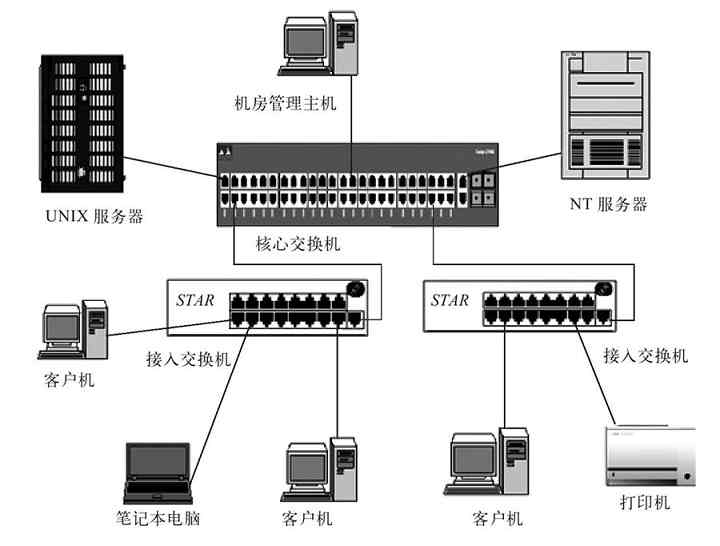

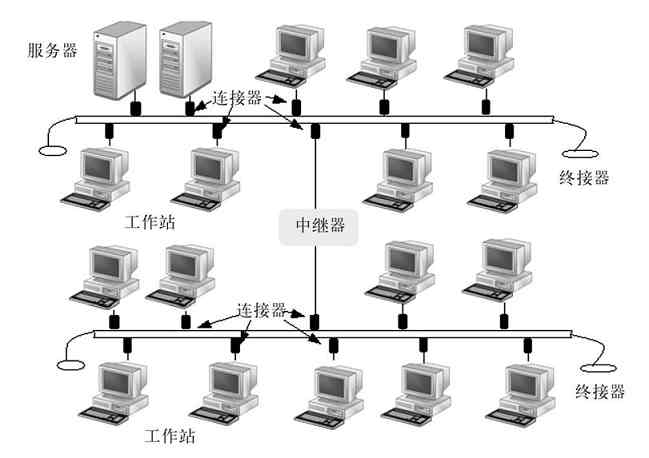

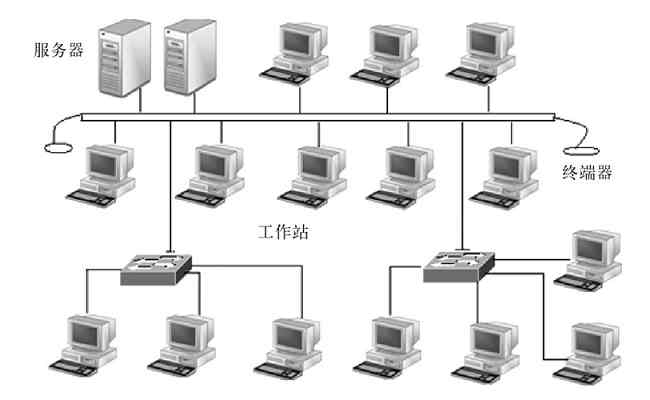

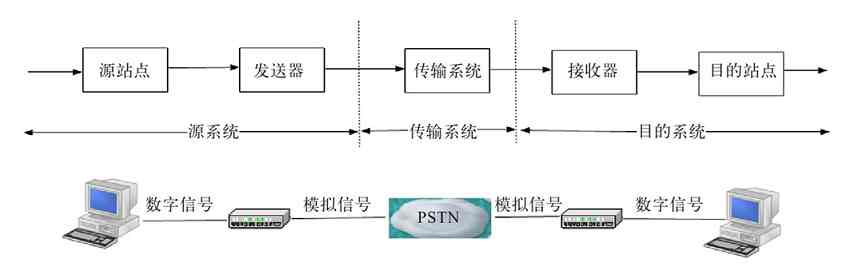

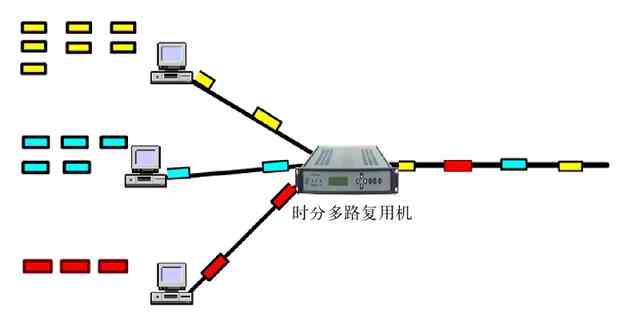

到了20世纪50年代中后期,通过像多路复用器(MUX)、线路集中器、前端控制器等通信控制设备,计算机网络系统可以将地理上分散的多个终端通过公用电话交换网络(PSTN)集中连接到一台主机上,这就是真正意义上的第一代计算机网络,如图2-3所示。

图 2-3 第一代计算机网络示例

第一代计算机网络的典型应用是当时的美国航空公司与IBM公司在20世纪50年代初开始联合研究,并于20世纪60年代投入使用的飞机订票系统SABRE-I。它由一台计算机和全美国范围内2000个终端组成。

由于第一代计算机网络是以单个计算机为中心的远程联机系统,所以很显然它具有天生的一些缺点,主要表现在如下两个方面:

❏担当计算中心的计算机负荷很重,造成对终端系统的响应比较慢,甚至会出现服务器崩溃现象。

❏单主机系统的可靠性较低,一旦发生计算机主机=瘫痪,将导致整个计算机网络系统瘫痪。这与现在的C/S(服务器/客户机)管理模式类似,但现在计算机网络中服务器系统通常是有容错配置的,那时的主机可没这种功能。而且现在的计算机服务器和客户机性能都非常强大,远不是当时的计算机主机和终端系统所能相提并论的。

(2)第二代计算机网络(分组交换式的计算机网络)

为了克服第一代计算机网络的缺点,提高网络的可用性和可靠性,专家们又开始研究将多台计算机互连的方法。有问题就要想办解决,这与现在所有技术的改进思路是一样的。首先,1964年8月巴兰(Baran)在美国兰德(Rand)公司《论分布式通信》的研究报告中提到了“存储转发”(这在我们学习交换机技术时会介绍这项技术)的概念。在1962年至1965年间,美国的ARPA(Advanced Research Projects Agency,美国国防部高级研究计划署)和英国的NPL(National Physics Laboratory,国家物理实验室)都对这一新技术进行了研究。后来,英国NPL的戴维斯(David)于1966年首次提出了“分组”(packet)的概念。在1969年12月,产生了世界上第一个基于分组技术的计算机分组交换系统APPANET。这是大家公认的计算机网络的鼻祖。

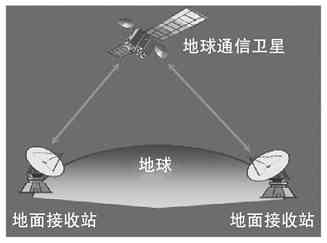

APPANET是美国国防部高级研究计划局(DARPA)采用电话线路为主干网络建成的。它最开始仅连接了美国加州大学洛杉矶分校、加州大学圣巴巴拉分校、斯坦福大学和犹他大学四个结点的计算机;两年后建成15个结点,此后规模不断扩大。到了20世纪70年代后期,网络结点超过60个,主机100多台,地理范围跨越美洲大陆,连通了美国东部和西部的许多大学和研究机构,而且还通过通信卫星与夏威夷和欧洲地区的计算机网络相互连通。

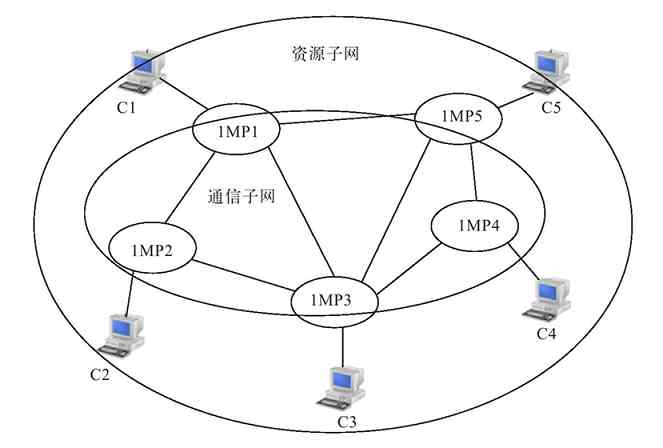

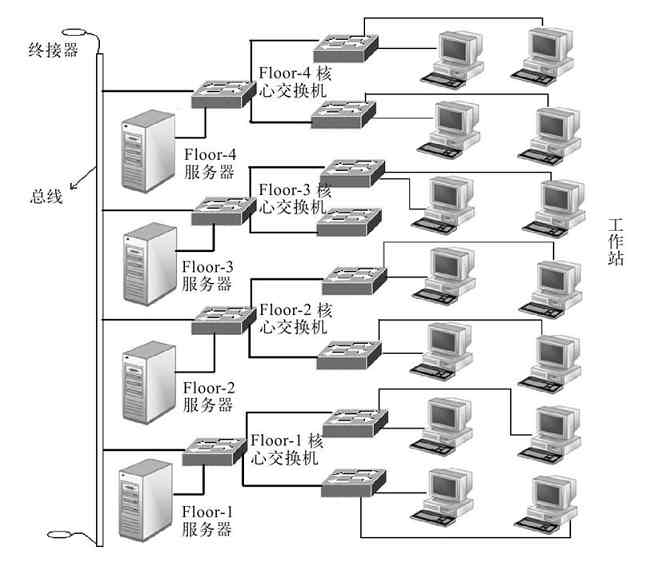

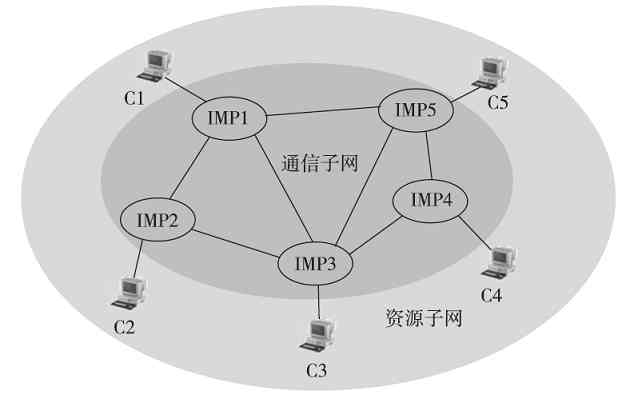

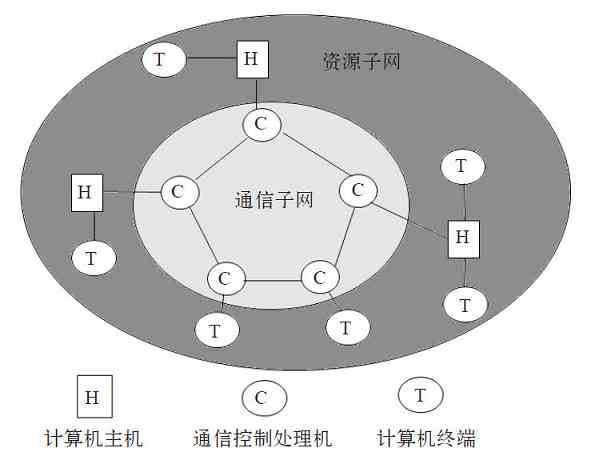

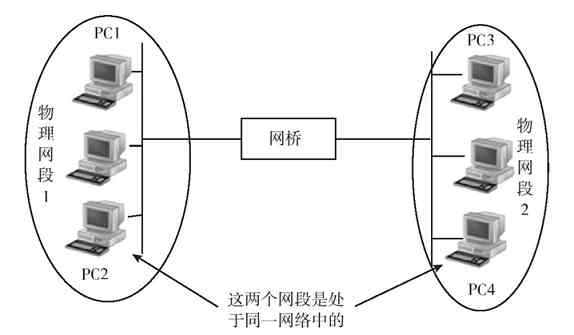

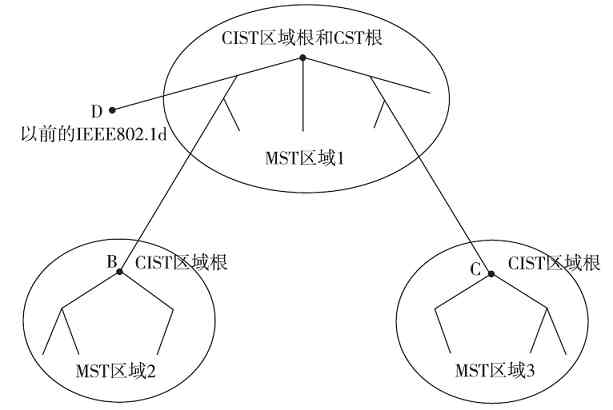

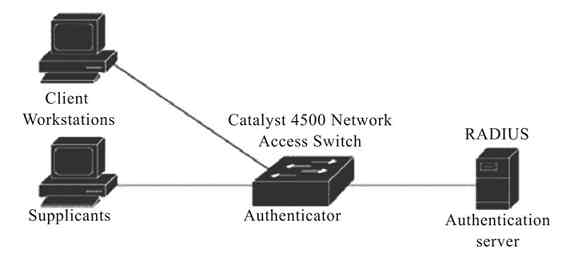

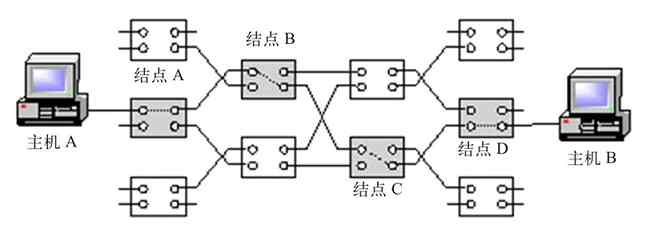

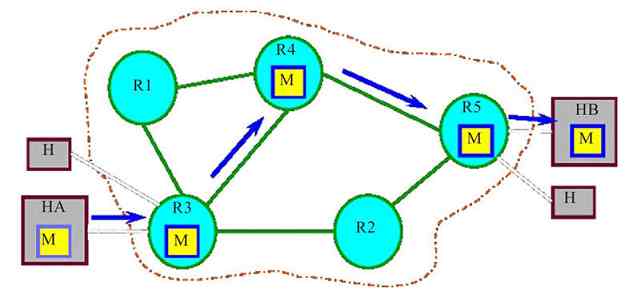

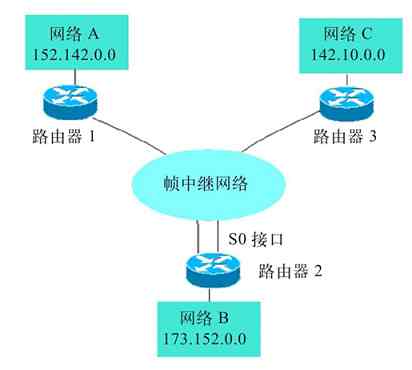

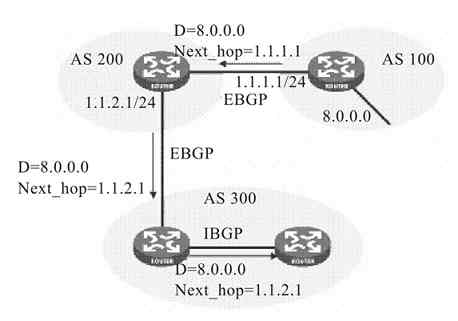

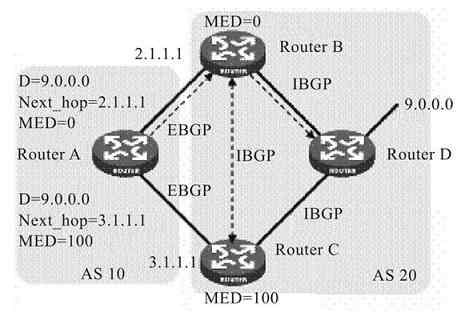

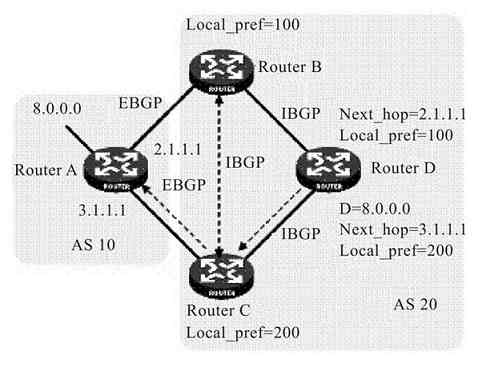

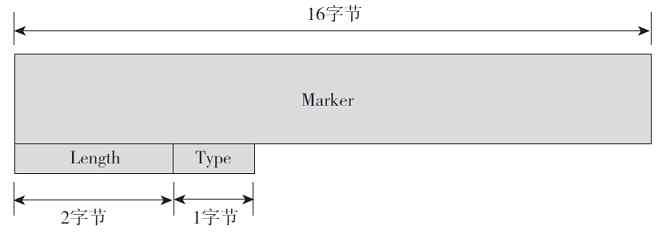

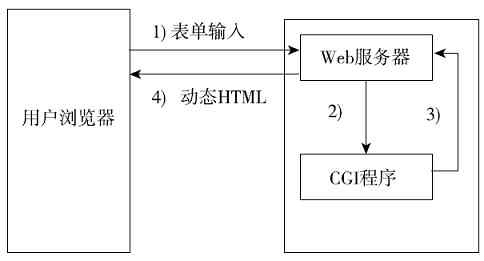

APPANET的运行成功使计算机网络的概念发生了根本性的变化,也标志着计算机网络的发展进入了一个新的纪元。这种在计算机网络中运行各种应用程序的计算机称为主机(不再使用功能简单的终端了),这些主机提供资源共享,组成“资源子网”;各计算机之间不是直接用线路相连,而是由接口报文处理机(Interface Message Processor,IMP)转接后互连。IMP专门负责通信处理,通信线路将各IMP相互连接起来,然后各主机再与IMP相连,各主机之间的通信需要通过IMP连接起来的网络来实现。IMP和它们之间互连的通信线路一起负责主机间的通信任务,构成“通信子网”,如图2-4所示。

图 2-4 第二代计算机网络

第二代计算机网络中的终端用户不仅可以共享“通信子网”中的线路和设备资源,还可以共享用户“资源子网”的丰富硬件和软件资源。这种以“通信子网”为中心的计算机网络就成了我们现在所说的第二代计算机网络。

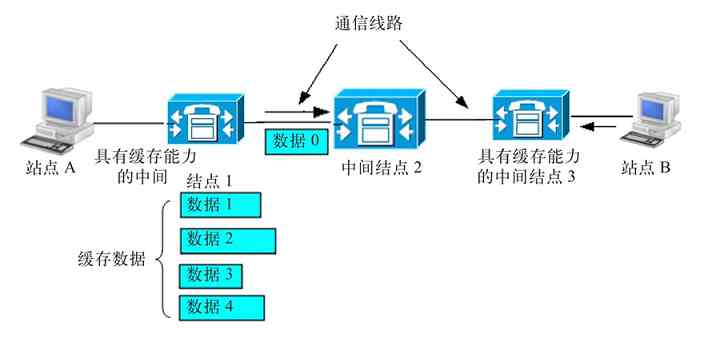

在第二代计算机网络中,采用了“存储-转发”数据通信方式,也就是各个IMP在接收到数据后先按接收顺序把数据存储在自己的缓存中,然后再按接收顺序依次进行下一级的数据转发,这样可以使网络上的流量更加平滑、有序。如果某台主机的一个用户要发送数据给网络中的另一台主机,它先是将数据交给与其相连接的IMP,接着该IMP通过适当的通信线路转给下一个IMP,然后继续转发这个数据,以此类推,直到到达目的IMP,最后由目的IMP转发给目的主机。

第二代计算机网络的这种既分散(从地理位置上来讲)又统一(从服务功能上来讲)的多主机计算机网络,使得整个计算机网络系统性能大大提高,同时也不会因为单机故障而导致整个网络系统瘫痪。另外,可以使原来第一代计算机网络中的单一计算机主机的负载可以分散到整个计算机网络的各个计算机主机上,使得计算机网络系统的响应性能也大大提高了。

(3)第三代计算机网络(标准化的计算机网络)

第二代计算机网络的传输方式采用了“存储-转发”方式,极大地提高了昂贵的通信线路资源的利用率。因为在这种“存储-转发”方式的通信过程中,通信线路不会被某一节点间的通信所独占,而是可以为多路通信所共用。但是第二代计算机网络仍存在许多弊端,主要表现为没有统一的网络体系架构和协议标准。而且,尽管第二代计算机网络已进行了通信子网和资源子网的两级分层,但不同公司的网络体系都只适用于自己公司的设备,不能进行相互连接。如IBM于1974年推出了系统网络结构(System Network Architecture,SNA),为用户提供能够互连的成套通信产品;1975年DEC公司宣布了自己的数字网络体系结构(DigitaoNetwork Architecture,DNA);1976年UNIVAC宣布了自己的分布式通信体系结构(Distributed Communication Architecture,DCA)。这些网络技术标准只在一个公司范围内有效,遵从某种标准的、能够互连的网络通信产品,只适用于同一公司生产的设备,不同公司间的网络仍不能相互连通。计算机网络通信市场这种各自为政的状况使得用户在投资方向上无所适从,也不利于多厂商之间的公平竞争。

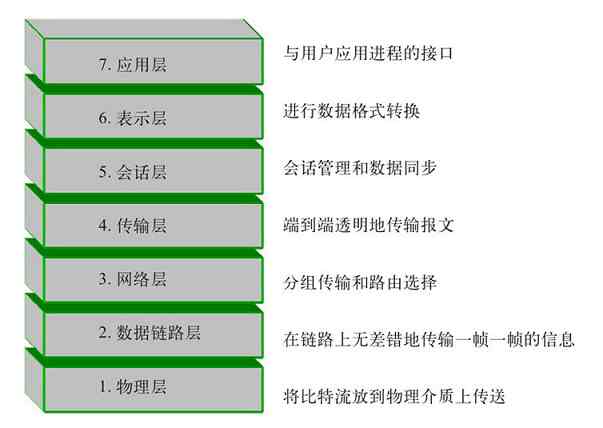

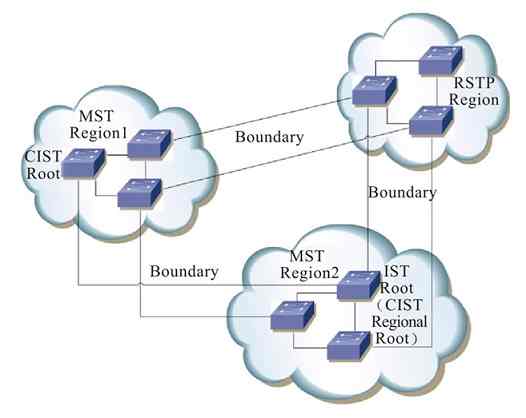

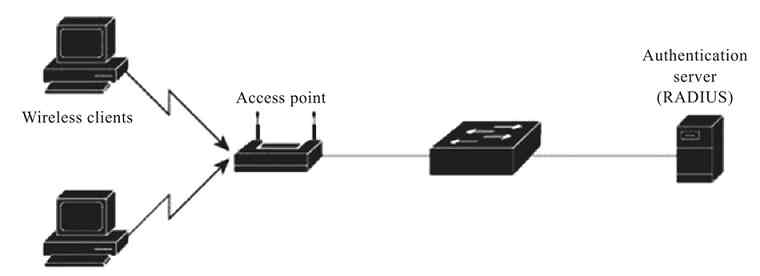

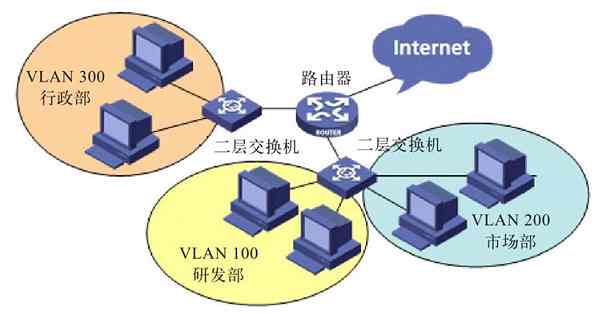

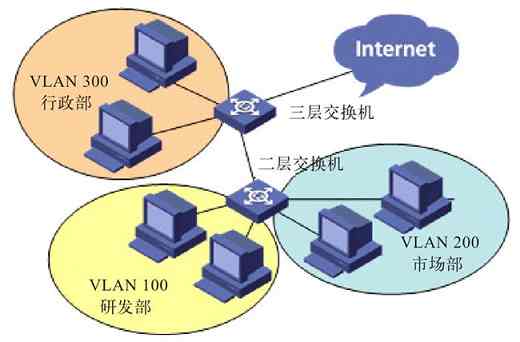

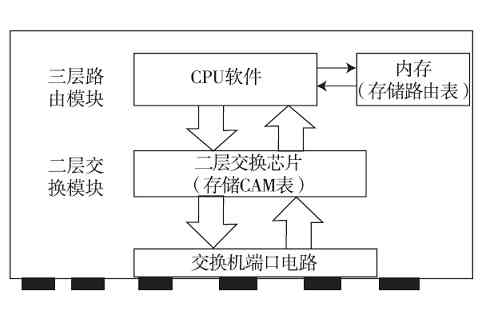

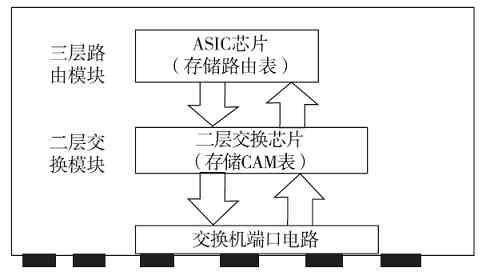

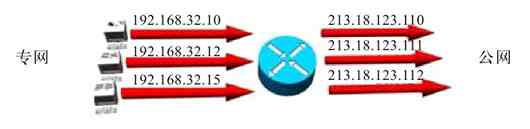

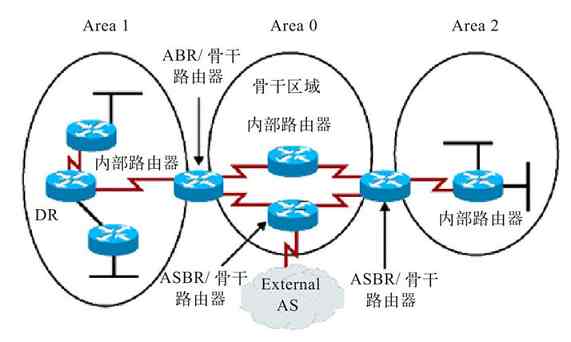

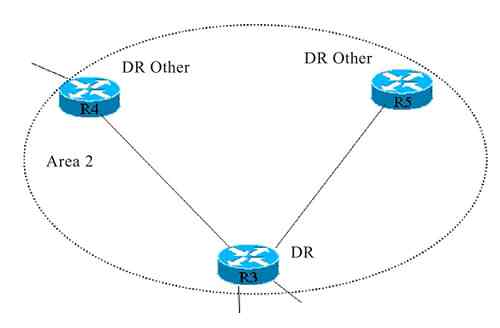

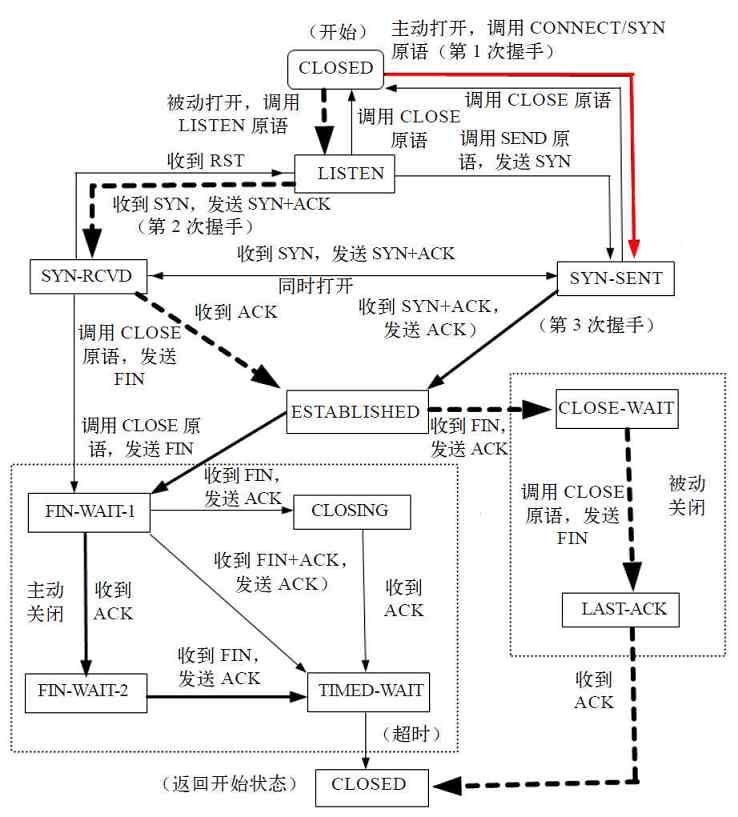

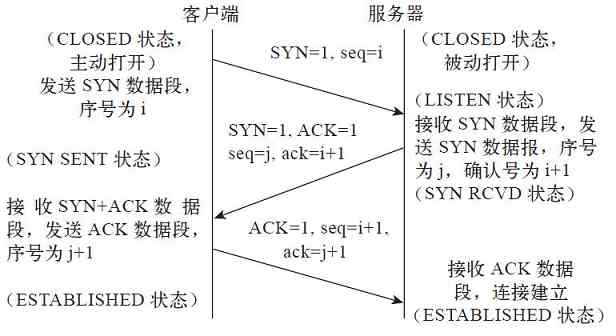

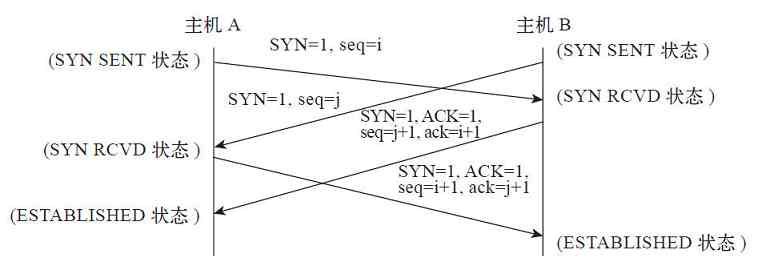

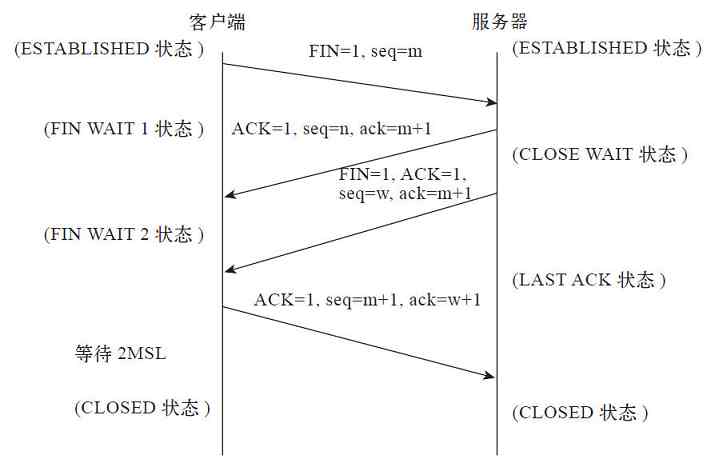

针对上述情况,1977年ISO(国际标准化组织)的TC97信息处理系统技术委员会SC16分技术委员会开始着手制定开放系统互连参考模型(OSI/RM),并于1984年发布。OSI/RM模型是一个开放体系结构,定义了网络互连的七层结构,并详细规定了每一层的功能(如图2-5所示),以实现开放系统环境中的互连性、互操作性和应用的可移植性。OSI/RM模型同时规定了计算机之间只能在对应层之间进行通信,大大简化了网络通信原理,是公认的新一代计算机网络体系结构的基础,为普及计算机网络奠定了基础。

图 2-5 OSI/RM的七层结构及各层对应的基本功能

从前面第一代、第二代计算机网络技术的发展可以看出,它们都是企业驱动的,也就是由各个公司根据自己的市场和用户需求进行相关技术和产品开发的,可以说是处于“百家争鸣”的时代。虽说“百家争鸣”可以充分展示各家公司的优势,但毕竟“无规矩难成方圆”。由于这些公司间彼此的市场竞争关系,导致这些不同公司开发出来的技术和产品并不具有通用性,这样一来结果就是谁都做不大、做不强,用户也很难选择,计算机网络的发展也就很难真正有实质性的进展。

到了第三代计算机网络时代,随着OSI/RM的诞生,就把整个计算机网络体系架构以标准形式确定下来了,大大推动了计算机网络的发展,激发了无数公司参与开发计算机网络相关硬件和软件,迎来了计算机网络发展历史上第一个真正意义上的“春天”。因为大家已“有规可循”了,不再担心兼容问题了。当然OSI/RM标准的诞生也是在汇总了前面不同公司开发的体系架构优点的基础上开发的。

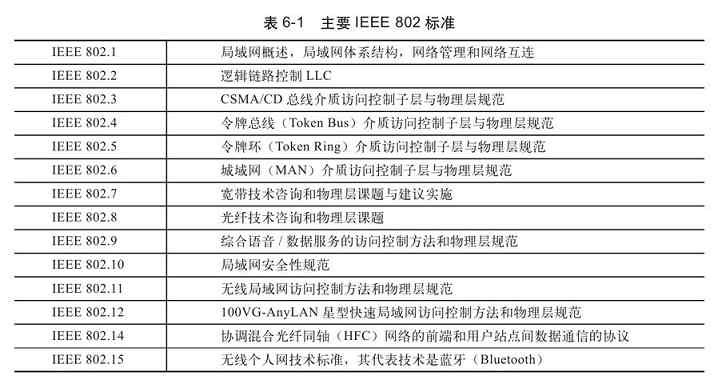

OSI/RM的诞生也标志着第三代计算机网络的诞生。此时的计算机网络在共同遵循OSI标准的基础上,形成了一个具有统一计算机网络体系结构,并遵循国际标准的开放式和标准化的网络。1980年2月,IEEE学会下属的802局域网标准委员会宣告成立,并相继推出了若干个802局域网协议标准,其中绝大部分后来被OSI正式认可,并成为局域网的国际标准。这标志着局域网协议及标准化工作向前迈出了一大步。从1980年至今,802委员会已陆续发布了环网、总线网、令牌总线网、光纤网、宽带网、城域网和无线局域网等许多局域网标准。

这些IEEE 802局域网标准的制定,极大地推进了计算机局域网的发展。近几年,计算机局域网的发展速度更是惊人,千兆、万兆、十万兆的局域网技术也已走入应用,百万兆的局域网技术的研究也取得了非常不错的进展。不仅如此,以太网的传输距离已从原来局域网的范围延伸到了城域网、广域网的范围。正因如此,现在的局域网和广域网之间的界限变得越来越模糊了。事实上,现在,几乎每个单位的计算机网络都接入了Internet,每个人的计算机也都已接入了Internet,成为了Internet的一分子。

最后,不得不说的是,虽然OSI/RM的诞生大大促进了计算机网络的发展,但主要还是表现在局域网范围中,在后来的广域网,包括Internet(互联网)的发展中,OSI/RM却被后来居上的TCP/IP协议规范(由DARPA研究并发布)远远抛在后面。1983年,DARPA将ARPANET上的所有计算机结构转向了TCP/IP协议,并以ARPANET为主干建立和发展了Internet,形成了TCP/IP体系结构。

TCP/IP协议体系结构虽然不是国际标准,但它的发展和应用都远远超过了OSI/RM,成为了Internet体系结构上的实际标准。究其原因主要有以下三个方面:一是TCP/IP协议簇非常庞大,功能完善且实用(目前的Internet基本上全是TCP/IP协议类型的网络),用户基础好;二是曾经的Internet的投资者不会轻易放弃在TCP/IP协议体系上的巨大投资;三是OSI/RM的网络体系结构本身分层过多,有些层次(如会话层和表示层)没有太大单独划分的必要性,而有些功能(如流量控制和差错控制等)又在多个层次中出现,实现和协调起来比较难。

当然,我们不能否认OSIR/RM的贡献,它提出了许多计算机网络的概念和技术至今仍广为使用,包括在Internet上。另外,也正是在它的推动下,使得计算机网络体系结构的标准化工作不断进展,事实上后来的TCP/IP协议规范也是在OSI/RM基础上改进而来的。

说明 有关计算机网络体系结构方面的具体内容将在第3章具体介绍,有关这些计算机网络体系结构中各层的主要功能和技术实现原理将在后续各章中分别介绍。

(4)第四代计算机网络(国际化的计算机网络)

到了20世纪80年代末,局域网技术发展成熟,出现了光纤及高速以太网技术,局域网的组建和应用也首先在国外,特别是美国开始普及开来。随着第三代计算机网络中的OSI/RM体系架构的诞生,又大大促进了以Internet为代表的因特网的发展,这就是现在的第四代计算机网络。第四代计算机网络的定义为“将多个具有独立工作能力的计算机系统通过通信设备和线路由功能完善的网络软件实现资源共享和数据通信的系统”。其实,Internet的雏形就是DARPA的ARPANET,所采用的协议标准就是TCP/IP协议规范。

Internet的基本发展历史如下:1985年美国国家科学基金会(National Science Foundation)利用ARPANET协议建立了用于科学研究和教育的骨干网络NSFnet;1990年NSFnet取代ARPANET成为国家骨干网,并且走出了大学和研究机构进入社会,从此网上的电子邮件、文件下载和信息传输受到人们的欢迎和广泛使用;1992年,Internet学会成立;1993年,伊利诺斯大学国家超级计算中心成功开发出网上浏览工具Mosaic(后来发展为Netscape),同年克林顿宣布正式实施国家信息基础设施(National Information Infrastructure)计划,从此在世界范围内开始了争夺信息化社会领导权和制高点的竞争;与此同时NSF不再向Internet注入资金,完全使其进入商业化运作;20世纪90年代后期,Interner以惊人的速度发展,一直到今天。

(5)下一代计算机网络

有人会问,我们现在的计算机处于一个什么时代?可以这么说,我们目前正处于第四代和第五代之间的过渡时期。但最终下一代网络到底是什么样子,现在可能还没有人能全部说清楚,至少没有形成标准。总体而言,普遍认为下一代计算机网络(NGN,也就是我们所说的第五代计算机网络)是因特网、移动通信网络、固定电话通信网络的融合,IP网络和光网络的融合;是可以提供包括语音、数据和多媒体等各种业务的综合开放的网络构架;是业务驱动、业务与呼叫控制分离、呼叫与承载分离的网络;是基于统一协议的、基于分组的网络。在功能上NGN分为四层,即接入和传输层、媒体层、控制层、网络服务层。我们看得见的一些下一代计算机网络的主要特征包括:目前正在进行的就是“三网”(计算机网络、电信网络、广东电视网络)融合,物联网、虚拟化、云计算、HTML5等新的革命性技术等。

在这些新技术中,“云计算”和“物联网”可能是将来彻底改变目前计算机网络格局和应用的最主要的两大技术。“云计算”其实类似于以前的IBM大型机,是一种集中服务、集中管理的平台。就是由云计算运营商集中为企业客户提供一些软、硬件平台及各种所需的服务和管理,企业客户只需要通过比较简单的云计算客户端连上位于互联网上的运营商云计算平台就可享受所购买的服务、平台,大大节省了企业客户在计算机网络软、硬件平台(如各种服务器系统、企业交换机、路由器、防火墙等)上的投资。

“物联网”是一种继续扩展计算机网络的新型技术,简单地讲就是“物-物相联的网”。它是通过射频识别(RFID)技术,以及红外感应器、全球定位系统、激光扫描器等信息传感设备,按约定的协议,把一些目前不能与计算机网络连接的物品(如电灯、电器、监控设施等)与互联网连接,以便进行物品之间的信息交换和通信,实现对物品的智能化识别、定位、跟踪、监控和管理。通过“物联网”我们将来在上班时就可以控制家里的电灯、电器设施的开关,监控家里的防盗监控设施,真正实现无处不在的互联网应用。

2.1.3 计算机网络的基本组成

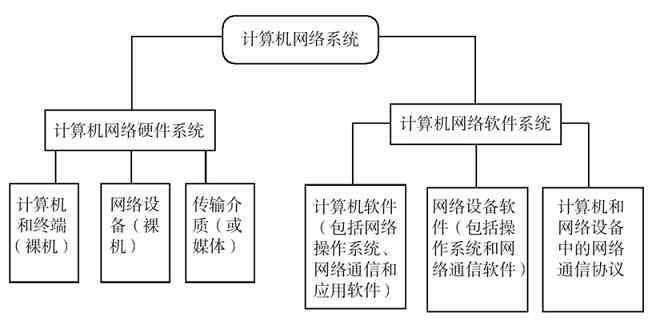

无论是从前面哪个定义都可以看出,计算机网络是一个由一些硬件设备和相应的软件系统组成的完整系统。计算机网络的基本组成包括:计算机(或者是只具有基本计算机功能的计算机终端)、网络连接和通信设备、传输介质、网络通信软件(包括网络通信协议)。

以上这些计算机网络基本组成又分为硬件系统和软件系统两大部分,如图2-6所示。

图 2-6 计算机网络系统组成

1.计算机网络硬件系统

计算机网络硬件系统就是指计算机网络中可以看得见的物理设施,包括各种计算机设备、传输介质、网络设备这三大部分。

(1)计算机设备

组建计算机网络的目的就是为各种计算机设备用户之间的网络通信(可以是用户访问、数据传输、文件共享、远程控制等应用)提供平台。计算机设备就是由网络用户控制和使用的各种计算机(如PC、计算机服务器、计算机终端、笔记本式计算机、iPAD之类的便携式设备)。网络的主要应用都是在这些计算机设备上进行的。其实现在计算机网络与电信通信网络有些重合了,许多电信通信终端同样可以连接到计算机网络中,如我们现在所使用的智能手机,就可以通过USB接口与计算机之间进行数据传输,甚至进行远程通信。

说明 在传统的计算机网络定义中,计算机网络至少要求有一台功能完整的物理计算机(其他的可以是终端)。随着网络虚拟化技术的兴起,目前的计算机网络可以通过虚拟机软件(如VPC、VMWare等)在一台物理计算机中模拟多个独立计算机系统,组成一个虚拟的计算机网络,通过这个网络同样可以实现在许多物理计算机网络中才能实现的功能。

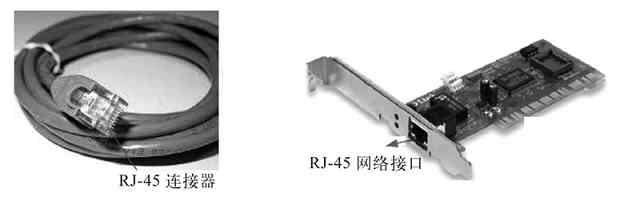

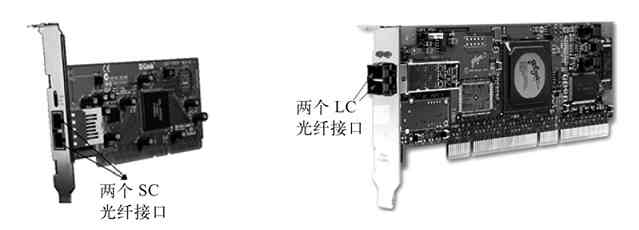

(2)网络设备

在计算机网络系统中,网络设备通常是指除计算机设备以外的设备,如有线网络中的网卡、网桥、网关、Modem、交换机、路由器、硬件防火墙、硬件IDS(入侵检测系统)、硬件IPS(入侵防御系统)、宽带接入服务器(BRAS)、UPS(不间断电源)等,无线网络(WLAN)中的WLAN网卡、WLAN AP、WLAN路由器、WLAN交换机等。有关这些计算机网络设备的主要用途和特点将在本书后面专门介绍。

网络设备是用来构建“通信子网”中网络拓扑结构的,与所用的通信线路(也就是“传输介质”)一起共同组成整个计算机网络的骨架。当然最简单的网络,其实是不需任何网络设备的,那就是两台终端计算机用串/并口电缆直接连接起来的对等网络。但这种网络其实并不能算是真正意义上的计算机网络,对于现在来说,这样的计算机网络也没多大的实际意义。

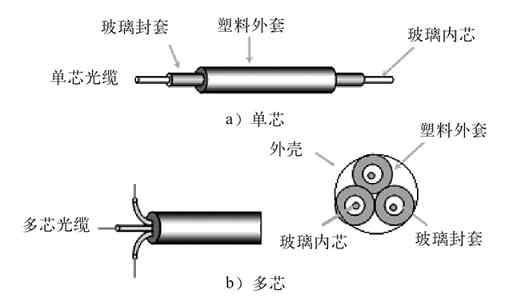

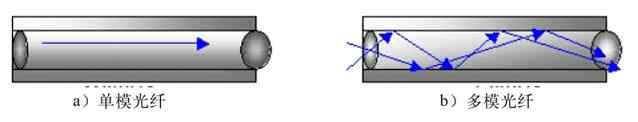

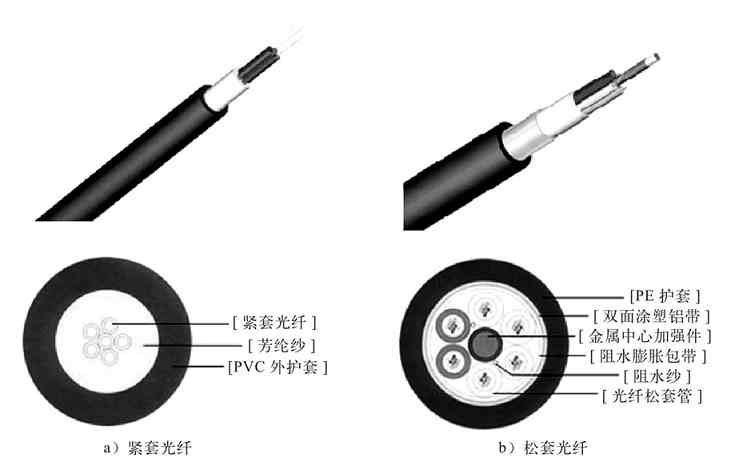

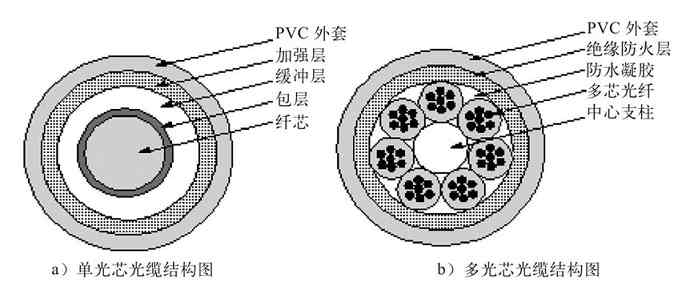

(3)传输介质

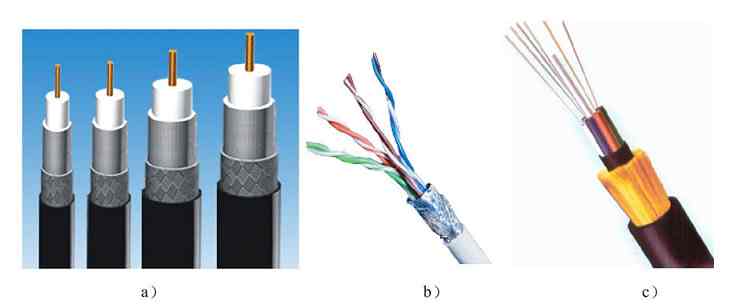

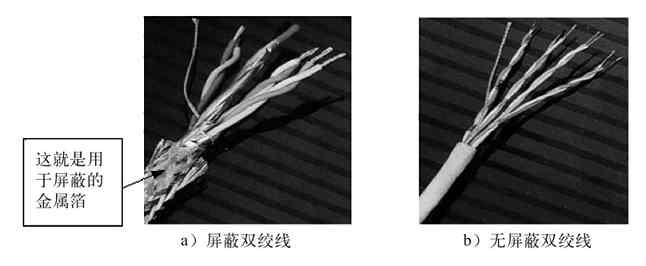

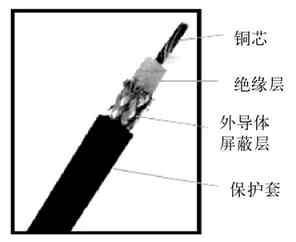

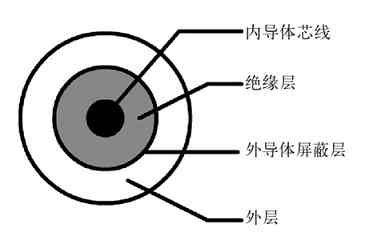

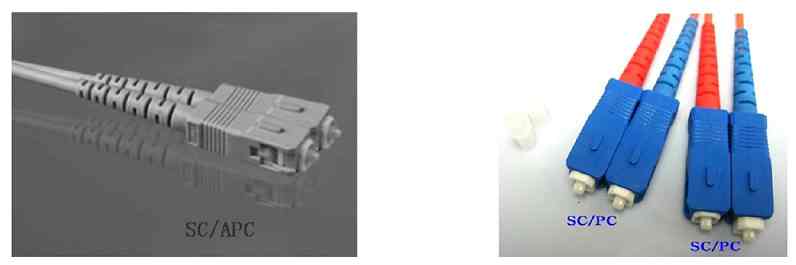

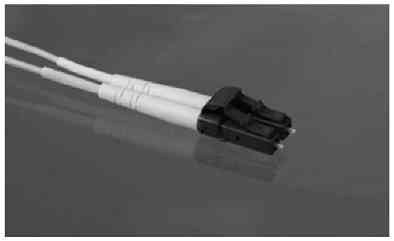

传输介质简单地说就是网线,是网络通信的“路”。如果没有这些传输介质,网络通信信号将不知道往哪里传,也不可能传,就像前面没有路,我们无法向前行进一样。当然,传输介质可以是物理有形的,如同轴电缆(有线电视所用的电缆也是同轴电缆)、双绞线、光缆(也常叫光纤)等(依次如图2-7的a、b、c所示);还可以是无形的,如各种无线网络中使用的传输介质其实就是电磁波。无线计算机网络就是通过电磁波实现无线计算机网络中各节点连接的。当然,在同轴电缆、双绞线、光缆这些传输介质中又有许多分类,具体将在第4章介绍。

图 2-7 同轴电缆、双绞线、光缆

2.计算机网络软件系统

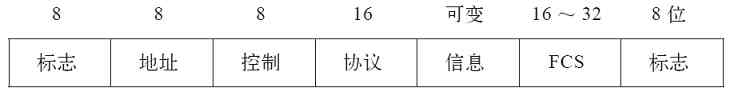

计算机网络通信除了需要前面所说的各种计算机硬件系统外,还需要一些计算机网络通信和应用软件。这些计算机网络通信和应用软件就是指安装在终端计算机中,用于计算机网络通信或应用的计算机程序。首先要有的就是一个网络应用平台,如计算机和服务器上所安装的、具备计算机网络通信功能的操作系统。像交换机、路由器和防火墙等,这类设备上也会安装用于计算机网络通信的操作系统。如计算机或服务器上所安装的各种Windows系统、Linux系统、UNIX系统,Cisco交换机/路由器/防火墙上安装的CatOS、IOS系统,H3C交换机/路由器/防火墙上安装的Comware系统等。

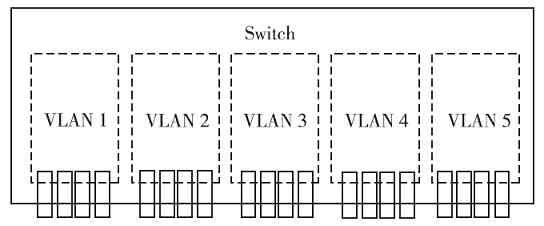

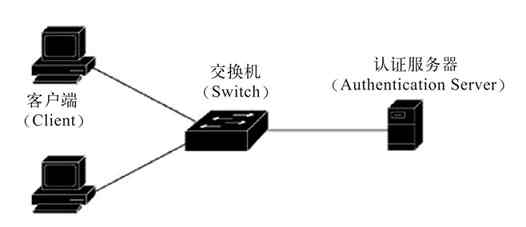

除了操作系统以外,还需要独立或者内植于操作系统中的网络通信协议,如TCP/IP协议簇、IEEE 802协议簇、PPP、PPPoE、IPX/SPX等,及网络设备中的VLAN、STP、RIP、OSPF、BGP等。最后就是需要进行各种具体网络应用的工具软件,如我们常见的QQ、MSN等即时通信软件,Outlook、Firefox、Sendmail等电子邮件软件,用于拨号的PPP、PPPoE协议,用于VPN通信的IPSec、PPTP、L2TP协议等。

说明 有关网络设备中的各种通信协议的具体工作原理和应用配置,可参见笔者编著的《Cisco交换机配置与管理完全手册》、《H3C交换机配置与管理完全手册》、《Cisco路由器配置与管理完全手册》和《H3C路由器配置与管理完全手册》这四本专著(这四本图书将于2013年6月份前出版上市)。

2.1.4 计算机网络的主要应用

说到计算机网络,大家肯定首先要问的是它到底有什么用途,也就是我们可以用它来做什么。如果时光倒退十多年,问到计算机网络有什么用途时,可能大家会不约而同地回答为“资源共享”。那时的计算机网络应用的确如此,除了主要用于资源共享外,看不出有其他方面的应用,因为那时既没有互联网,又没有什么局域网内部的网络应用。现在,随着计算机网络系统,特别是Internet技术的完善与普及,计算机网络的应用得到了空前繁荣。已渗透到了普通百姓的日常工作、生活和休闲等各个方面。可以说,我们现在是生活在网络时代,关于计算机网络的用途,绝大多数普通计算机网络用户都可以说出个一、二、三来。

虽然目前的计算机网络应用非常多,但总体上可以分为两大类:商业应用、家庭/个人应用。下面进行具体介绍,大家可以对照地看一下自己公司,乃至本人用到了哪些。

1.商业应用

商业应用是计算机网络应用的最主要的方面,后面的家庭/个人应用是在商业应用基础上发展而来的。在计算机网络的商业应用中,主要依赖的网络就是公司局域网,以及与公司局域网连接的外部用户(如子公司、合作伙伴、供应商等)的内部局域网和Internet。商业应用主要包括:资源共享、数据传输、协同工作、远程访问与管理、电子商务等。

(1)资源共享

在计算机网络中,一个最基本,也是最传统的应用就是资源共享(Resource Sharing)。这里的共享资源可以是物理设备,如打印机、扫描仪、传真机、刻录机,也可以是共享的数据文件、软件资源等。其目标就是让每个人都可以访问其允许的设备、程序、文件和数据信息。一个最简单的资源共享的例子就是局域网内部多用户通过网络共享一台打印机(现在有些打印机也支持Internet共享打印)进行打印操作,这样一来,公司就没有必要为每个用户配备一台单独的打印机了,大大节省了设备投资成本。

在公司局域网中,比物理设备共享意义更重要的还是我们前面提到的程序、文件和数据资源共享,如公司内部公用文档、数据库报表,或者用户共享安装使用的软件,以及公司数据库系统。局域网的好处就是我们无需再像没有计算机网络时那样,需要通过移动媒体(如软盘、U盘、移动硬盘等)来复制数据了。这样既确保了共享数据的安全性(因为共享时还可以为不同用户设置不同的访问权限),又大大提高了数据共享使用的效率。通常在公司内部局域网中,会有一个文件服务器来存储这些共享数据资源。

在互联网中的资源共享实例就更多了,如许多网站提供的文件上传和下载功能,音、视频分享功能,文件浏览和查阅功能等。

(2)网络通信

在网络通信方面,目前在企业中用得较多的功能是远程网络互联、远程视频会议,远程培训、远程会诊等。远程网络互联目前在集团公司与子公司之间,或者公司与合作伙伴、供应商网站之间通过专门的接入方式(目前主要是利用VPN技术)把各单位的网络按照应用需求和访问权限连接起来。这样可以使网络间的通信、用户访问更加安全、便利,还可以更有效地管理网站数据、电子商务数据等。

远程视频会议、远程培训、远程会诊等的应用目前在一些大的集团公司或医院中是很常见的。应用这个功能一方面可以节省会议、培训成本(因为它克服了物理距离的时空限制),另一方面可以充分利用各方面的专家资源,及时地解决一些疑难杂症。

(3)数据传输

在计算机网络中进行数据传输是最常见的了,如我们天天在用E-mail邮件收发、通过FTP(文件传输协议)进行文件传输、通过TFTP/RCP(简单文件传输协议/远程复制协议)进行文件上传和下载等。又如我们可能天天都在通过QQ或者MSN等工具软件向好友发送文件;许多网站提供了资源下载功能,供用户根据需要选择下载他们资源库中的文件;现在又有了一些专门用于资源上传和下载的网站网盘等。这些上传和下载的过程都属于计算机网络的数据传输应用。

(4)协同工作

协同工作是目前计算机网络的一种典型应用,是指通过网络,使位于相同或者不同地点,甚至不同国家的多个系统共同担负着某项网络通信或者网络应用任务的工作方式。最典型的例子如服务器、交换机集群实现的负载均衡,ISP中的多个DNS服务器、DC(域控制器)服务器等也可以实现负载均衡,为网络用户提供相应的服务。

协同工作目前还有一个应用就是现在的维基(Wiki)百科,其中的内容可以由全球授权参与的网友共同编辑、完善。还有,如一个项目可以由总公司和分公司的多人共同负责完成。

(5)远程访问与管理

远程访问与管理是计算机网络用户访问,以及管理员对客户机和服务器的管理方式。如一些支持移动上网的VPN解决方案就可以使公司员工在任何时候、任何地点通过VPN连接到公司的网络,查看所需的文件或数据,上传或下载所需的文件。另外,利用像Windows服务器系统中的“远程Web桌面”和“远程协助”功能就可以使在外出差的员工通过Internet访问甚至控制公司内部网络中的主机或服务器。如果具有管理员账户,他们还可以远程管理、维护公司内部的服务器。

(6)电子商务

现在几乎所有稍具规模的单位都架设了自己的网站,目的之一就是向全世界的用户宣传自己的产品。另外还有大部分企业用户通过自己的网站为客户提供网上在线交易,这就是我们通常所说的“电子商务”。相信大多数人都有过在淘宝网购物的体验,淘宝网上有许多商家开店销售他们的商品,这些商品大到名贵珠宝、家用电器,小到日用百货和图书,一应俱全。还有像当当网、亚马逊卓越网、京东商城等(目前这类网店非常多,数不胜数了)都允许各种商品在网站上销售。现在通常把这些电子商务网站称为“电商”,以区别于实体开店的商户。

“电子商务”这种经营模式最大的优点有三个:一是受众面广,全国乃至全球的人都可以看到;二是成本低,因为这类电子商务网站不需要租用昂贵的实体店面,只需要利用虚拟的磁盘空间就可以了;三是用户购买方便,只需要在网上提交所购商品订单,就可以坐在家里等着收货了,而不用亲自跑到商店中去买,然后还要想办法运回来。

2.家庭应用

一开始,计算机网络基本上全部是出于商业应用的,但随着Internet宽带接入和互联网应用的丰富,计算机网络开始走入寻常百姓的家。现在,我们坐在家里就可以通过家里的宽带接入访问互联网,访问全球的网站;通过像QQ、MSN之类的即时通信软件与世界各地的相识或不相识的朋友取得即时联系,建立感情;我们还可以有自己的局域网,或者个人网站,全世界的人都可以访问我们的网站,了解我们提供的产品、服务,以及我们的工作、学习和生活状态。

在娱乐方面,现在各大电视台都开通了网上频道,各种娱乐节目可以直接通过互联网进行互动参与。网上看电影、听音乐和手机上网娱乐更是年青一族的时尚追求(现在电信推出的IPTV已实现了电影、电视、音乐、游戏等各方面的互动点播,就像在自己的电脑中播放一样);而网络游戏则成了年青一族的最爱(还记得你与朋友们在网络游戏中一起拼杀的场景吗?)。

当然,现在的计算机网络应用可能还远不止以上这些,因为它已渗透到了我们工作、生活、学习和娱乐等各个方面,而且各种新的网络应用也在不断涌现中。

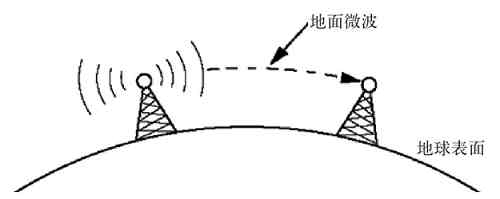

2.2 计算机网络的分类

自计算机网络诞生至今,出现过许多类型的计算机网络,可以依据许多不同的分类标准来划分这些计算机网络。如按通信协议类型分为IBM令牌网络、分组交换网络、以太网协议局域网、TCP/IP协议网络等;按管理模式则可分为对等网和C/S(客户机/服务器)网络;按不同传输介质则可分为同轴电缆网络、双绞线网络、光纤网络、WLAN无线网络、卫星网络、微波网络等;按传输方式来分又可分为点对点网络和广播网络;按所覆盖的地理范围又可分为局域网、城域网和广域网;等等。下面介绍几种目前最常见的计算机网络分类方式。

2.2.1 按网络所覆盖的地理范围分

按照计算机网络覆盖的地理范围(也是一种按网络规模进行的计算机网络分类)可分为局域网、城域网和广域网三种。这种分类方式可以很好地反映出不同类型网络的技术特征,因为不同类型网络覆盖的地理范围不同,故所采用的传输技术也就不同,从而形成了不同的网络技术特点与网络服务功能。

1.局域网

局域网(Local Area Network,LAN)是最常见到的,也是应用最多的一种计算机网络,大到各行各业的企业内部网络,小到千家万户的家庭网络都属于局域网(仅指内部网络部分)。我们常说的校园网通常也是一种局域网。局域网是将一个比较小的区域内的各种通信设备互连在一起组成的计算机网络。LAN具有如下主要特点:

(1)私有服务

LAN属于个人或单位自建,所以其用途也是完全出于私用,不会为网络以外人员提供服务,如企业局域网通常只为本单位员工提供服务。在LAN中也是采用专门为LAN分配的私有IP地址(这种地址每个公司和个人都可直接拿来使用,无须购买,也无须注册)。关于局域网的具体内容将在第8章介绍。

(2)分布范围较小

LAN中各计算机网络设备分布的地理范围较小,有的甚至只是在自己家里那几平方米范围内,当然也可以是较大范围内的设备相连,如分布在某公司不同建筑物中。LAN的地理分布范围通常最大在10公里范围内,可以分布在不同地理位置的建筑物内。

(3)结构简单,布线容易

因为LAN都为个人或单位私用,所以网络结构相对较为简单。没有,也无需太多、太复杂的网络设备和应用,只需满足自身的网络应用需求即可。同时大多数LAN都采用比较廉价的双绞线布线(在较大公司的核心层或者汇聚层也有采用光纤作为传输介质的),且因为分布范围比较小,所以布线方式较为简单,容易实现。

(4)网络速度较快

目前以太网局域网技术的发展非常迅速,最快的以太网速率已达到了10Gbps,相对广域网和互联网来说具有非常大的优势,这也为企业局域网的集中应用提供了保证。

(5)误码率低

因为局域网的结构比较简单,而网络连接带宽又都很高,所以通信的误码率比较低,通常在10-11 ~10-8 之间。

在LAN中又有许多分类,如目前最主流的以太网(EtherNet)、WLAN(无线局域网),以前还有IBM令牌网(传输速率最高可达16Mbps)、FDDI(光纤分布式数据接口)网(最高传输速率可达100Mbps)、ATM(异步传输模式)网(最高传输速率可达Gbps以上)。而以太网中又有许多分类,如10Mbps的标准以太网、100Mbps的快速以太网、1Gbps的千兆以太网、10Gbps的万兆以太网,现在100Gbps的十万兆以太网也正在研究之中。有关以太网标准的内容将在第6章介绍。

2.城域网

城域网(Metropolitan Area Network,MAN)中各计算机网络设备的地理分布范围介于LAN和下面将要介绍的广域网(WAN)之间,主要遍布一个城市内部,所以称之为“城域网”。MAN主要是用来在一个较大的地理区域(通常是10~100公里)内提供数据、声音和图像的传输,一般是用于提供公共服务的。

MAN的标准为IEEE 802.6,通常采用ATM技术作为骨干网传输技术,目前光纤技术也在城域网中得到了广泛应用。ATM是一个可同时应用于数据、语音、视频和其他多媒体应用的网络传输技术。城域网通常为一个或几个组织所有,更多的是为公众提供公共服务的,如城市银行系统、城市消防系统、城市邮政系统、城市有线电视/广播网络等。

3.广域网

广域网(Wide Area Network,WAN)是规模最大的一种计算机网络,分布的地理范围可以非常广,如一个或多个城市,或者多个国家,甚至可以遍布全球。Internet是最大的广域网。它遍及全球,由全球许多LAN、MAN互联组成。WAN主要也是为公众提供公共服务的,由不同ISP(Internet服务商)组建,为他们的广大用户提供各种网络接入和应用服务。WAN具有以下基本特性。

(1)覆盖范围广

WAN所覆盖的地理范围非常大,一般从几百公里到几千公里,可覆盖多个城市、整个国家,乃至全球。Internet是最大的广域网,其他的WAN又是Internet的核心。在广域网中通常使用的是公网IP地址(这种地址是需要购买并注册的)。当然,WAN互连的各局域网内部仍可使用供局域网私用的IP地址。

(2)构建成本高

由于WAN地理范围广,网络线路很长,介质类型多种多样,而且铺设非常困难,所以单独组建一个WAN的成本非常昂贵,所以通常借用传统的公共传输(电报、电话)网这个平台来实现。

(3)网络结构和类型复杂

由于WAN连接了多个远程网络,所以网络结构非常复杂、网络类型也可能不一样,所以需要解决不同结构和不同类型网络之间的互连的问题。

(4)传输速率低,误码率高

由于WAN的传输距离远,又依靠传统的公共传输网,所以误码率较高(一般在10-8 ~10-7 之间),传输速率较低(通常是100Mbps以内)。

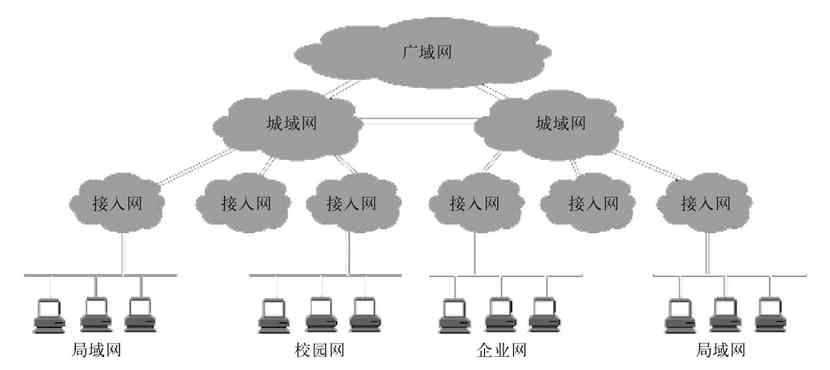

图2-8显示了局域网、城域网和广域网三者之间的典型关系。其中的“接入网”是位于局域网与城域网或广域网之间的中间小型网络,专门为远程网络间互连提供网络用户接入技术,如各种ISP(Internet服务商)为我们提供的ADSL拨号、光纤接入、分组接入、卫星接入,以及各种专线接入等。

图 2-8 局域网、城域网和广域网之间的关系

2.2.2 按网络管理模式分

按计算机网络的管理模式可以把目前的计算机网络划分为对等网(Peer-to-Peer,PTP)和C/S(Client/Server,客户机/服务器)网。

1.对等网

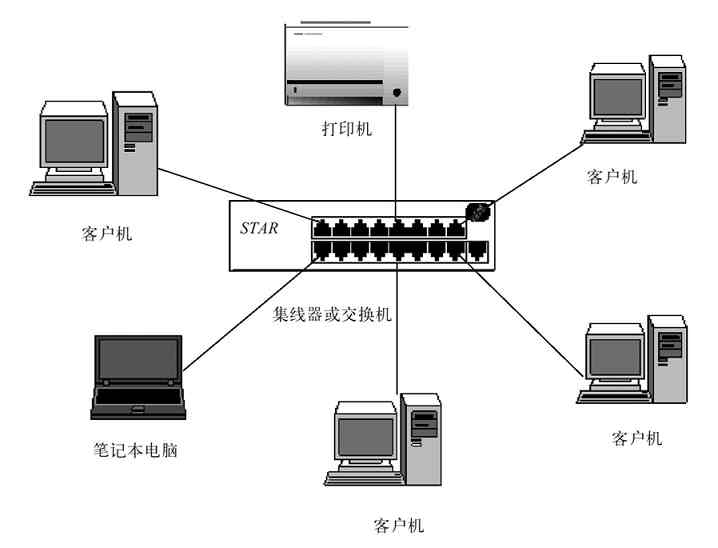

所谓“对等网”(PTP),即网络中各成员计算机的地位都是平等的,没有管理与被管理之分。计算机各自为政,谁也不管谁,采用的是分散管理模式。就像日常的一些小沙龙一样,沙龙中各成员是平等的,大家组织在一起仅为了相互交流。对等网中的每台计算机都既可以作为其他计算机资源访问的服务器,又可作为工作站来访问其他计算机,整个网络中没有专门的资源服务器,如图2-9所示。最简单的对等网可以仅通过串行线缆(称为零调制解调器)来连接两台计算机。

对等网可以说是当今最简单的网络,远没有像Windows域网络那样的C/S网络配置复杂,非常适合家庭、校园和小型办公室用户。从用户和计算机管理角度来看,通过Linux和UNIX操作系统组成的计算机网络都采用这种网络管理模式,Windows操作系统中的“工作组”网络也是对等网管理模式。但要注意的是,即使在对等网中,也可能有部分服务是采用C/S管理模式的,如在工作组网络中部署的文件服务器、数据库存服务器、邮件服务器等。

图 2-9 对等网示例

对等网除具有配置简单的优点之外,更多的是不足,主要体现在以下几个方面:

(1)配置与管理困难

因为采用的是分散管理模式,所以对等网络管理员无法做到通过一台计算机集中管理网络中的用户、计算机和其他资源,更难以对网络中的用户计算机进行统一配置。

(2)安全性差

同样是因为对等网采用分散管理模式,给整个网络(特别是企业网络)的安全性带来了巨大挑战。因为在这种计算机网络中,企业数据分散保存在各用户计算机上,很难十分有效地为每一用户计算机配置高级的安全保护措施。

(3)成本高

表面上看对等网不需要服务器,成本会更低,事实上不完全是这样,特别是对于有一定规模的企业网络。因为企业数据是分散在各用户计算机上存储和管理的,随着时间的推移,可能需要为每个用户计算机配备较大容量的磁盘,浪费了磁盘空间。如果要再为每个用户配备相应的安全保护措施,这成本就更高了。

(4)性能差

在对等网中,各用户计算机的网络连接性能、数据处理性能和磁盘读取性能基本上一样,而且通常只是普通的性能,再加上各用户计算机之间可能因一些数据共享而需频繁访问,所以对等网的网络通信和数据读取性能就只能算一般了。而在下面将要介绍的C/S模式网络中,服务器的网络连接性能、数据处理性能和磁盘读取性(通常是采用服务器专用磁盘)能都比较高,而且用户间的访问通常比较少,所以C/S网络的整体网络性能往往会更高。

2.C/S网

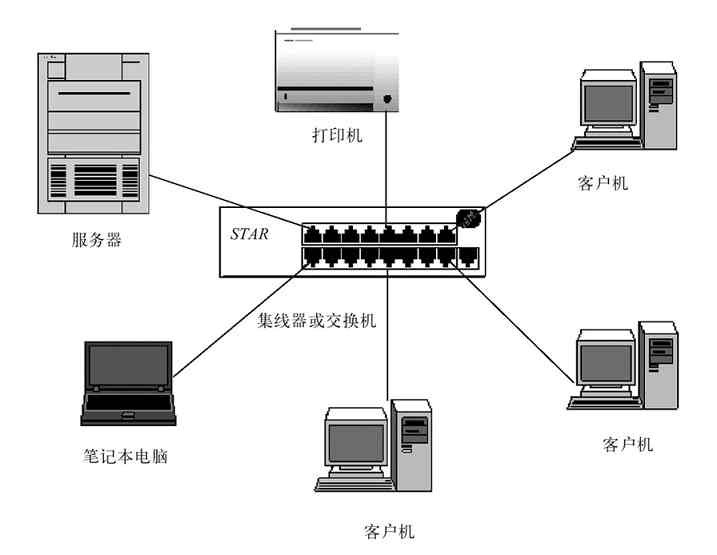

C/S模式其实是针对具体服务器功能来说的,这些服务器可以是用于管理整个计算机网络中计算机和用户账户的服务器(如Windows域网络中的域控制器),也可以是其他网络或应用服务器(如邮件服务器、数据库服务器、Web服务器、FTP服务器等)。这些服务器有一个共同的特点,就是一般只作为服务器角色而存在,专门为网络中其他用户计算机提供对应的服务。这相当于我们现实生活中每个组织、每个部门都有一个或多个管理者一样,他们负责的就是对对应的组织或部门进行管理。图2-10所示的就是一个单台服务器的C/S网,而图2-11所示的是一个具有多台不同类型服务器的C/S网。

图 2-10 单服务器的C/S网

图 2-11 多服务器的C/S网

C/S网的杰出代表就是Windows服务器系统(如Windows Server 2003、Windows Server 2008等)的域网络。这种域网络可以对网络中的所有用户、计算机账户进行统一管理。除此之外,各种其他网络服务器(如DNS服务器、DHCP服务器、NFS服务器等)和应用服务器(如Web服务器、FTP服务器、E-mail服务器等)也可以组成C/S网,不过它们不能集中管理网络中的用户和计算机账户。

综合起来,C/S网络的主要优点如下:

(1)管理和配置容易

在C/S网中,用户账户往往可以集中管理,在服务器上的配置可能稍微复杂一些,但在客户端的配置却非常简单;对于Windows域网络,更是可以集中管理整个网络中的用户和计算机账户。

(2)安全性高

同样是因为在服务器上集中管理了用户账户、计算机账户、企业数据,乃至整个网络的安全策略,所以整个网络的安全性较高。

(3)性能好

因为网络中有专门的高性能服务器,同时分配有高性能的交换处理设备、高带宽端口和高性能磁盘(通常还使用性能和安全性更高的磁盘阵列),所以整个网络中尽管用户会集中频繁访问服务器,但就整体网络性能来讲,仍比对等网模式要高。

C/S网对于小型企业来说,因为要专门配备高性能的服务器,所以成本还是有些高。但对于稍有一些规模的企业网络来说,这点成本其实完全可以从各用户计算机磁盘容量成本中节省出来,因为有了专门的服务器后,各用户计算机的磁盘容量可以小许多,自然总成本就低了许多。目前各企业基本上都采用的是C/S网,因为企业中基本上都会专门配置一台甚至多台专门的服务器,哪怕是Linux和UNIX操作系统网络。

2.2.3 按传输方式分

按网络传输方式计算机网络可划分为点对点传输网络和广播式传输网络两种。这种划分方式其实是根据所采用的传输协议进行划分的方式,因为无论是点对点传输网络,还是广播式传输网络,都主要取决于所采用的通信协议,与网络拓扑结构也有一定的关系。

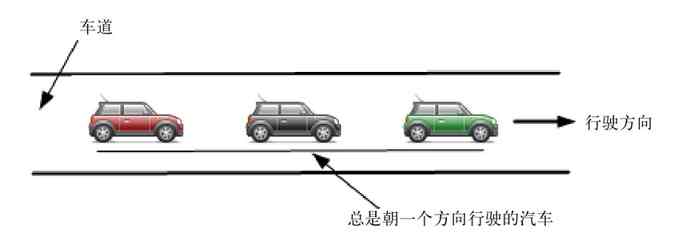

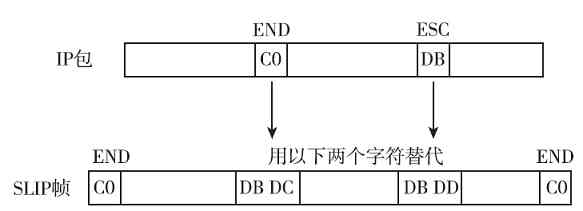

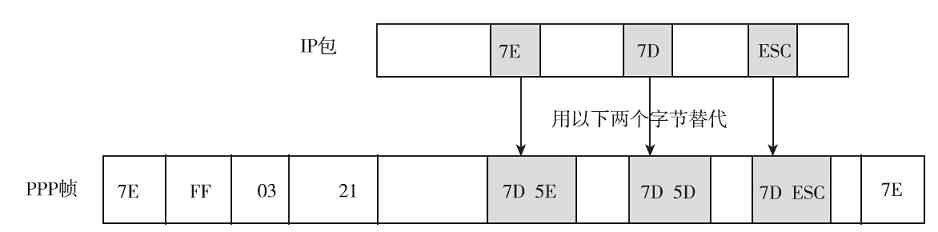

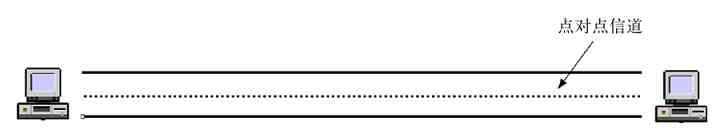

(1)点对点传输网络

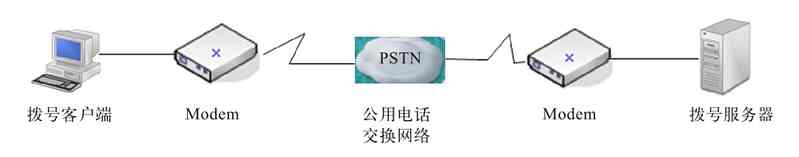

在点对点传输网络中采用的通信协议都是基于点对点通信的,如SLIP(串行线路Internet协议)、PPP(点对点协议)、PPPOE(基于以太网的点对点协议)、PPTP(点对点隧道协议)等。我们使用的各种Modem拨号(拨号网络的基本结构如图2-12所示),以及路由器间串口(通常称为S口)的连接,所使用的都是PPP(点对点协议)或PPOE(以太网点对点协议)。我们打电话也是点对点通信的,通信只在两部电话机线路之间进行,其他线路上的用户是听不到的。

图 2-12 拨号网络基本结构

在点对点传输网络中,数据是以点对点的方式(或者说是“一对一”方式)在计算机或通信设备中传输的,也就是某个端口只能和与它相接、相连的对端端口进行通信,不能把数据发送到本网络的其他链路中,也就是只能单点“联系”。就像我们在电视剧中经常听到的“单线联系”一样,某个人只能与组织中另一个人联系,任何一个下级成员根本不知道整个组织中其他成员的联系方式。

点对点传输网络是由许多互相连接的节点构成的,在每对机器之间都有一条专用的通信信道,也就是说这两台机器是独占通信线路的,如各种拨号网络就是这样的。因此在点对点传输网络中,不存在信道共享与复用的情况。

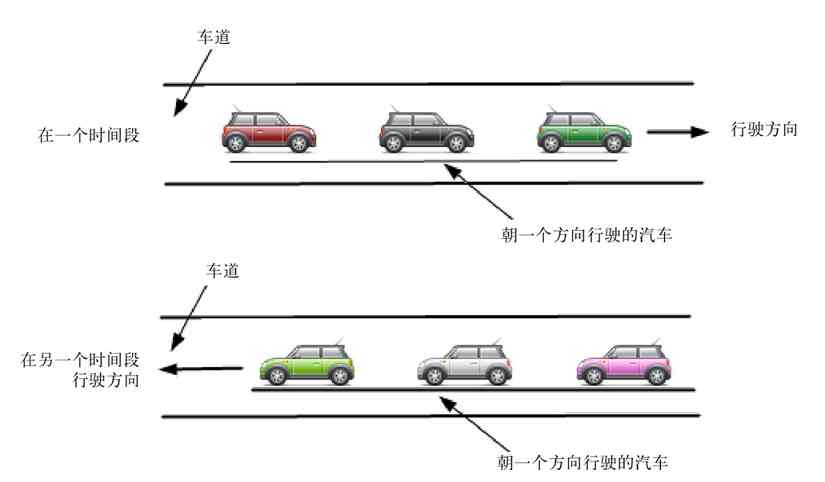

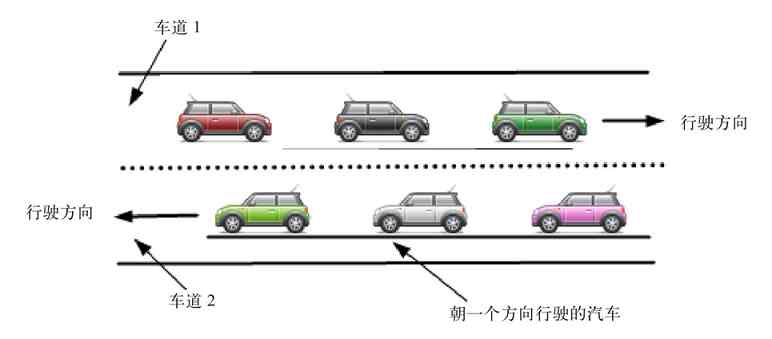

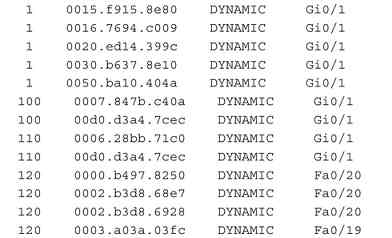

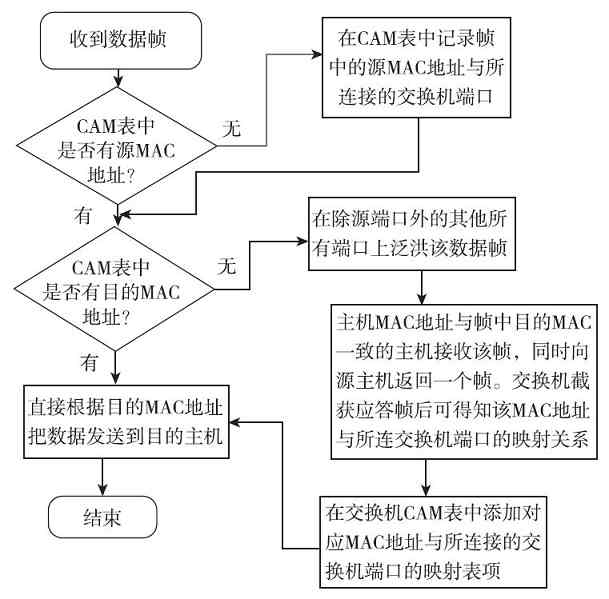

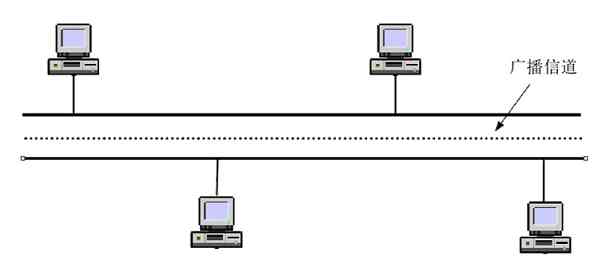

(2)广播式传输网络

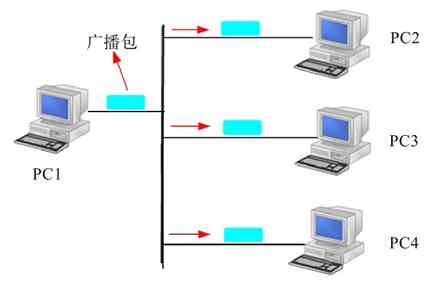

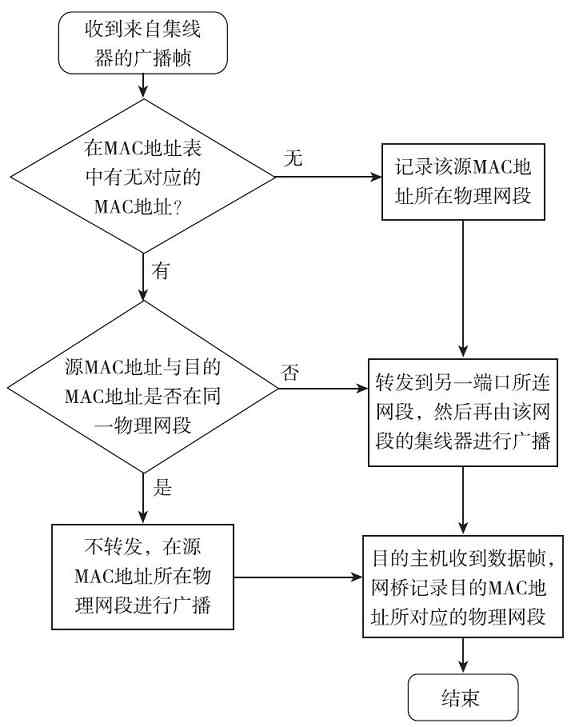

广播式传输网络是一种可以仅使用由网络上的所有节点共享的公共信道进行广播传输的计算机网络,是一种一点对多点的网络结构。图2-13就是一个广播式传输网络示例,图中PC1机发送一个广播包,可以到达网络中其他任何PC机上。

图 2-13 广播式传输网络示例

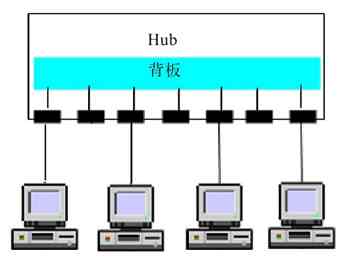

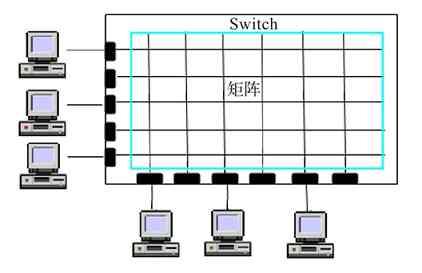

在广播式传输网络中传输信息时,任何一个节点都可以发送数据包,通过公共信道(如交换机的背板矩阵,以及设备间的连接通道)或总线传送到网络中的其他计算机上。然后,这些计算机根据数据包中的目的MAC地址进行判断,如果自己的MAC地址与目的MAC地址匹配则接收(与此同时,发送节点就可以知道与目的IP地址对应的MAC地址,下次接收到包括同样目的IP地址的包时就不用再广播了),否则便丢弃它。

区分是哪种传输方式网络,最关键的是看它里面所用的通信协议。以太网就是典型的广播式传输网络,其所使用的就是各种以太网(Ethernet)协议。本章后面将要介绍的环形拓扑结构的令牌环网络和总线型拓扑结构的令牌总线网络也是广播式传输网络,因为在这两种拓扑结构网络中,任何一个站点发送数据,其他站点都可以接收到,总线两端的计算机是存在公共传输通道的,这条公共传输通道就是那条总线。当然,不仅环形、总线型拓扑结构的网络可以是广播式网络,其他的像星型、树型、网状拓扑结构的计算机网络都可以是广播式传输网络,因为这些网络中都存在公共信道。各种无线网络、卫星传播网络也都是广播式传输网络的,因为它们的传输信道都是公用的。具体的网络拓扑结构将在下节介绍。

2.3 计算机网络拓扑结构

拓扑(Topology)学是一种研究与大小、距离无关的几何图形特性的方法。“网络拓扑结构”是由网络节点设备和通信介质通过物理连接所构成的逻辑结构图。网络拓扑结构是从逻辑上表示网络服务器、工作站的网络配置和互相之间的连接方式和服务关系。在选择拓扑结构时,主要考虑的因素有:不同设备所担当的角色(或者设备间服务的关系)、各节点设备工作性能要求、安装的相对难易程度、重新配置的难易程度、维护的相对难易程度、通信介质发生故障时受到影响的设备的情况。

本节要分别介绍计算机网络(包括局域网和广域网)中的一些主要拓扑结构。在此先介绍与网络拓扑结构有关的几个基本概念。

2.3.1 网络拓扑结构相关基本概念

在设计网络拓扑结构时,我们经常会遇到如“节点”、“结点”、“链路”和“通路”这四个术语。它们到底各自代表什么,它们之间又有什么关系呢?

(1)节点

一个“节点”其实就是一个网络端口。节点又分为“转节点”和“访问节点”两类。“转节点”的作用是支持网络的连接,它通过通信线路转接和传递信息,如交换机、网关、路由器、防火墙设备的各个网络端口等;而“访问节点”是信息交换的源点和目标点,通常是用户计算机上的网卡接口。如我们在设计一个网络系统时,通常所说的共有××个节点,其实就是在网络中有多个要配置IP地址的网络端口。

(2)结点

一个“结点”是指一台网络设备,因为它们通常连接了多个“节点”,所以称之为“结点”。在计算机网络中的结点又分为链路结点和路由结点,它们就分别对应的是网络中的交换机和路由器。从网络中的结点数多少就可以大概知道你的计算机网络规模和基本结构了。

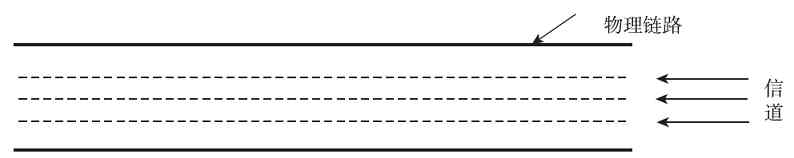

(3)链路

“链路”是两个节点间的线路。链路分物理链路和逻辑链路(或称数据链路)两种,前者是指实际存在的通信线路,由设备网络端口和传输介质连接实现;后者是指在逻辑上起作用的网络通路,由计算机网络体系结构中的数据链路层标准和协议来实现。如果链路层协议没有起作用,数据链路也就无法建立起来。

(4)通路

“通路”从发出信息的节点到接收信息的节点之间的一串节点和链路的组合。也就是说,它是一系列穿越通信网络而建立起来的节点到节点的链路串连。它与“链路”的区别主要在于一条“通路”中可能包括多条“链路”。

2.3.2 星型拓扑结构

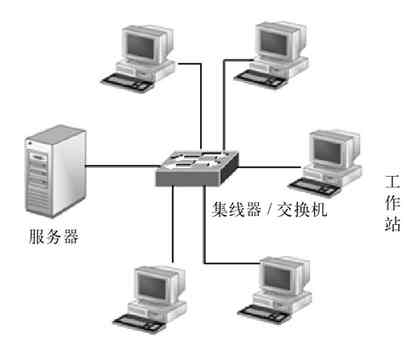

星型拓扑结构(Star Topology)又称集中式拓扑结构,是因集线器或交换机连接的各节点呈星状(也就是放射状)分布而得名。在这种拓扑结构的网络中有中央结点(集线器,或交换机),其他节点(工作站、服务器)都与中央结点直接相连。

1.基本星型拓扑结构单元

星型拓扑结构是目前应用最广、实用性最好的一种拓扑结构,这主要是因为它非常容易实现网络的扩展。无论在局域网中,还是在广域网中都可以见到它的身影,但其主要还是应用于有线以太局域网中。所以事实上,星型拓扑结构主要应用于以太局域网中,以太网包括许多标准,对应的标准集就是IEEE 802.3,具体将在第6章介绍。“星型拓扑结构”其实只是一个结构单元(一台集线器,或者交换机设备就是一个星型结构单元),多个星型结构单元连接起来又可以形成下面将要介绍的“树型拓扑结构”。图2-14所示的是最简单的单台集线器或交换机星型拓扑结构单元。

图 2-14 基本星型拓扑结构单元示例

在这个星型拓扑结构单元中,所有服务器和工作站等网络设备都集中连接在同一台交换机上。因为现在的固定端口交换机最多可以有48个或以上交换端口,所以这样一个简单的星型网络完全可以适用于用户节点数在40个以内的小型企业,或者分支办公室选用。模块式的交换机端口数可达100个以上,可以满足一个小型企业的需求。但实际上这种连接方式是比较少见的,因为单独用一台模块式的交换机连接成本要远高于采用多台低端口密度的固定端口交换机级联方式。模块式交换机通常用于大中型网络的核心层(或骨干层)或汇聚层,小型网络很少使用。

扩展交换端口的另一种有效方法就是堆叠了。有一些固定端口配置的交换机支持堆叠技术,通过专用的堆叠电缆连接,所有堆叠在一起的交换机都可作为单一交换机来管理,不仅可以使端口数量得到大幅提高(通常最多堆叠8台),还可以提高堆叠交换机中各端口实际可用的背板带宽,提高了交换机的整体交换性能。

有关交换机的级联和堆叠技术及配置的具体内容可参见笔者的《Cisco/H3C交换机配置与管理完全手册》(第2版)一书。

2.多级星型拓扑结构

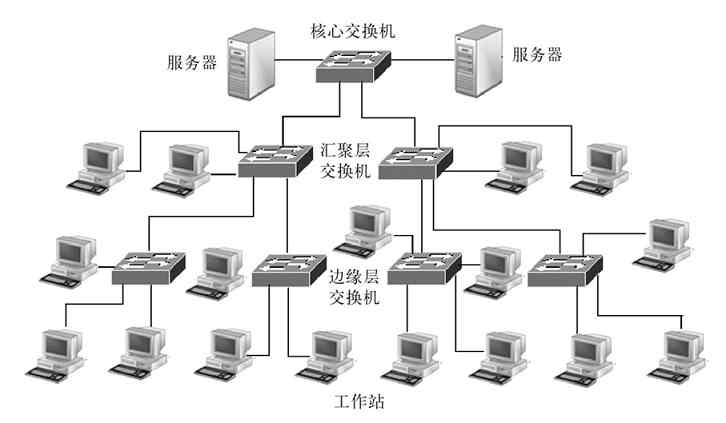

复杂的星型结构网络就是在图2-14基础上通过多台交换机级联形成的,从而形成多级星型拓扑结构,满足更多、不同地理位置分布的用户连接和不同端口带宽需求。其实这就是下面将要介绍的“树型拓扑结构”。图2-15是一个包含两级交换机结构的星型网络,其中的两层交换机通常为不同档次的,可以满足不同需求。核心(或骨干层)交换机要选择档次较高的,用于连接下级交换机、服务器和有高性能需求的工作站用户等,下面各级则可以依次降低要求,以便最大限度地节省投资。

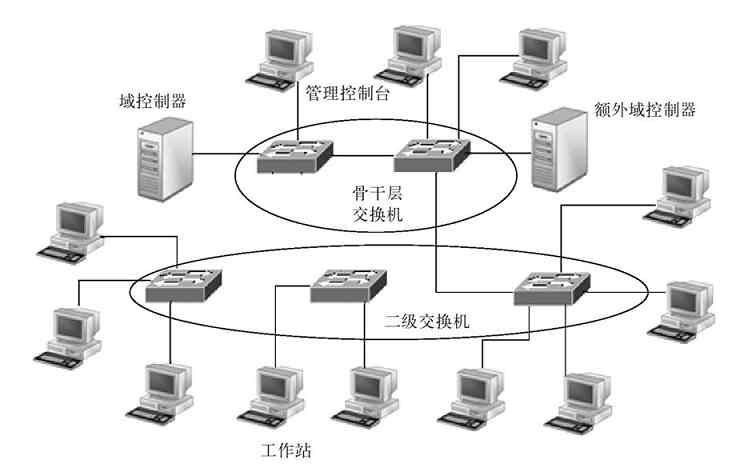

图 2-15 两级星型拓扑结构示例

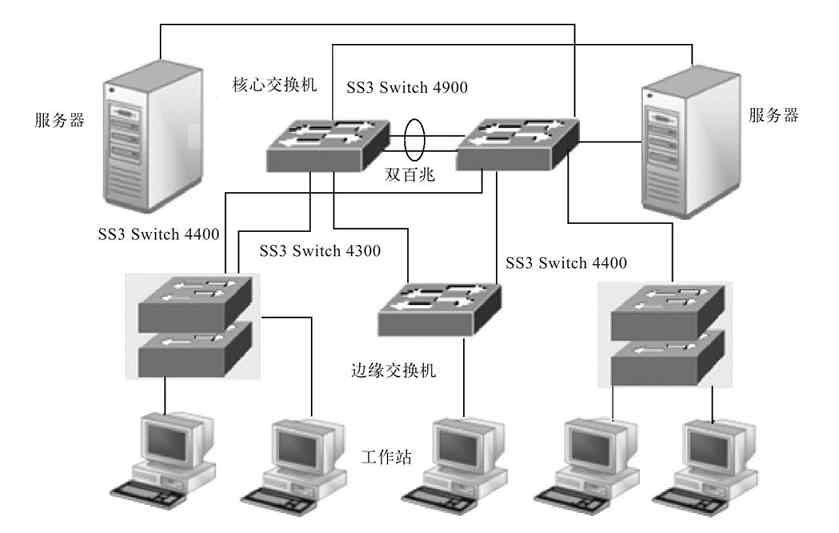

当然,在实际的大中型企业网络中,其网络结构可能要比图2-15所示的网络复杂许多,还可能有三级,甚至四级交换机的级联(通常最多部署四级),还可能有交换机的堆叠和集群。图2-16所示网络结构中SS3 Switch 4400位置就是由两台这样的交换机堆叠组成的。

图 2-16 包含交换机堆叠的星型拓扑结构示例

3.星型拓扑结构传输距离限制

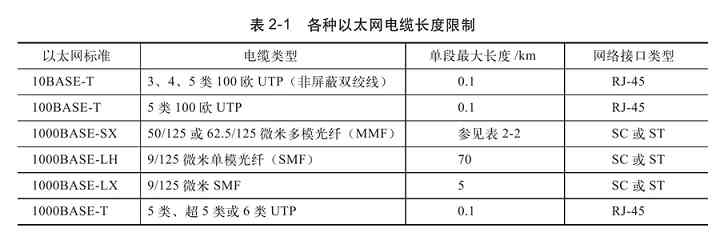

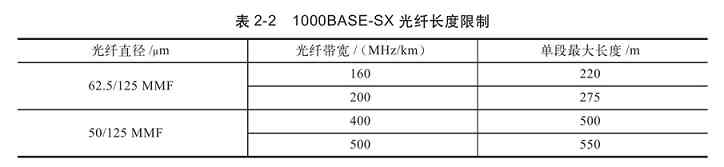

因为在星型结构网络中通常是采用双绞线和光纤作为传输介质的,而单段双绞线的最大长度为100m,集线设备放置在中心点,这样每一个采用此种结构的集线设备所能连接的网络范围最大直径就达到200m,超过这个范围都将要采用级联或中继的方法。采用光纤作为传输介质时虽然传输距离可以长许多,但也是有限制的。各种连接电缆长度限制如表2-1所示,1000BASE-SX网络的光纤长度限制如表2-2所示。

经验之谈 许多读者朋友认为,星型拓扑结构只适用于同楼层的网络,其实不是这样的。在多楼层,甚至多栋建筑物之间的网络互连多数也可以采用星型拓扑结构,因为它具有非常高的传输速率。从表2-1和表2-2可以看出,各楼层之间,各建筑物之间都可以采用普通的双绞线进行连接(通常是大对数的),只要距离在双绞线的有效距离范围内;当超过了双绞线的有效距离后,可以采用光纤连接(光纤的传输距离更远,传输性能更好),但光纤介质和相应接口的设备价格更贵,这必须予以充分考虑。同轴电缆只是一种低成本、低性能的选择,因为它的传输性能要远低于双绞线和光纤,在目前实际的楼层和建筑物之间网络互连很少采用。

4.星型拓扑结构主要优缺点

星型拓扑结构的优点主要体现在以下几个方面:

(1)节点扩展、移动方便

在星型拓扑结构网络中,节点扩展时只需要从交换机等集中设备空余端口中拉一条电缆与要加入的节点连接上即可;而要移动一个节点只需要把相应节点设备连接网线从设备端口拔出,然后移到新设备端口即可。上述过程并不影响其他任何已有设备的连接和使用,不会像下面将要介绍的环形网络那样“牵一发而动全身”。这是星型拓扑结构的最大优势。

(2)网络传输数据快

因为整个网络呈星型连接,网络的上行通道不是共享的,所以每个节点的数据传输对其他节点的数据传输影响非常小,这样就加快了网络数据传输速度。

另外,星型拓扑结构所对应的双绞线和光纤以太网标准的传输速率可以非常高(主要是因为相应的网络技术发展非常快),如普通的5类、超5类都可以通过4对芯线实现1000Mbps传输速率,7类屏蔽双绞线则可以实现10Gbps传输速率,光纤则更是可以轻松实现千兆、万兆的传输速率。而后面要介绍的环形、总线型结构中所对应的标准速率都在16Mbps以内,明显低了许多。

(3)维护容易

在星型网络中,每个节点都是相对独立的,一个节点出现故障不会影响其他节点的连接,可任意拆走故障节点。正因如此,这种网络结构受到用户的普遍欢迎,成为应用最广的一种拓扑结构类型。但如果集线设备出现了故障,也会导致整个网络的瘫痪。

星型拓扑结构的缺点主要体现在如下几个方面。

(1)核心交换机工作负荷重

虽然说各工作站用户连接的是不同的交换机,但是最终还是要与连接在网络中央核心交换机上的服务器进行用户登录和网络服务器访问操作,所以中央核心交换机的工作负荷相当繁重,故对担任中央设备的交换机的性能和可靠性的要求非常高。其他各级集线器和交换机也连接多个用户,其工作负荷同样非常重,也要求具有较高的可靠性。

(2)网络布线较复杂

每个计算机直接采用专门的电缆与集线设备相连,这样整个网络中至少就需要所有计算机及网络设备总量以上条数的电缆,这使得结构本就非常复杂的星型网络变得更加复杂了。特别是在大中型企业网络的机房中,太多的电缆无论对维护、管理,还是对机房安全都是一个威胁。这就要求我们在布线时要多加注意,一定要在各条电缆、集线器和交换机端口上做好相应的标记。同时建议做好整个布线系统的标记和记录,以备日后出现布线故障时能迅速找到故障发生点。另外,由于这种星型网络中的每条电缆都是专用的,利用率不高,在较大的网络中,这种浪费还是相当大的。

(3)广播传输影响网络性能

其实这是以太网的一个不足,但因星型拓扑结构主要应用于以太网中,所以相应的也就成了星型网络的一个缺点。因为在以太网中,当集线器收到节点发送的数据时,采取的是广播发送方式,任何一个节点发送信息在整个网中的节点都可以收到,这严重影响了网络性能的发挥。虽然说交换机具有MAC地址“学习”功能,但对于那些以前没有识别的节点发送来的数据,同样是采取广播方式发送的,所以同样存在广播风暴的负面影响。当然交换机的广播影响要远比集线器的要小得多,在局域网中使用影响不大。

综上所述,星型拓扑结构是一种应用广泛的有线局域网拓扑结构,特别是它可以采用廉价的双绞线进行布线,而且是非共享传输通道,传输性能好,节点数不受技术限制,扩展和维护容易,所以它又是一种经济、实用的网络拓扑结构。但受到单段双绞网线长度必须在100m以内的限制,超过这个距离则需要采取交换机级联拓展方式,或者采用成本较高的光纤作为传输介质(不仅是传输介质的改变,相应设备也要有相应的接口)。

2.3.3 环形拓扑结构

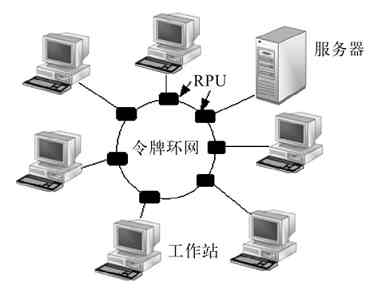

环形拓扑结构(Ring Topology)在20世纪90年代计算机网络刚开始进入国内时采用得比较多,应用的标准是IEEE 802.5。可以说,令牌环在物理上是一个由一系列环接口(称之为中继转发器,即RPU)和这些接口间的点对点链路构成的闭合环路,各站点PC通过环接口连到网上。目前这一网络拓扑结构形式已不用了,因为它的传输速率最高只有16Mbps,扩展性能又不好,早已被性能远超过它的星型拓扑结构双绞线以太网替代了。

1.环形网络结构概述

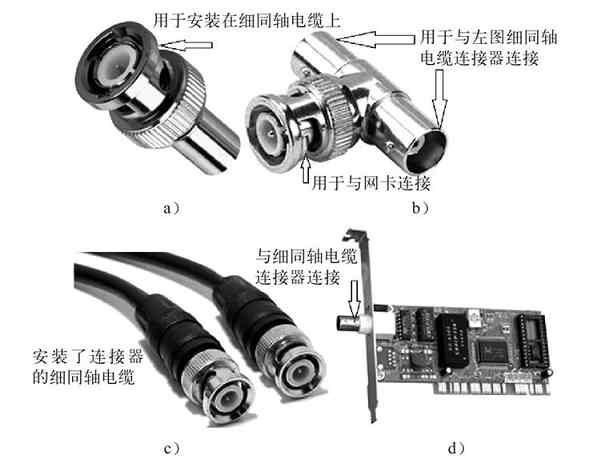

环形网络拓扑结构主要应用于采用同轴电缆作为传输介质的令牌网中,图2-17就是一个典型的环形网络。笔者曾于2000年为一家小型公司组建过局域网,该局域网采用的就是这种结构的。这种网络中的每一站点都是通过环中继转发器与它左右相邻的站点串行连接起来的,在传输介质环的两端各加上一个阻抗匹配器(又称终端匹配器)就形成了一个封闭的环路,“环形”结构的命名起因就在于此了。在细同轴电缆环形网中的环中继转发器是一个BNC接头,阻抗匹配器上的那个链子样的东西接在PC外壳上(相当于接地),如图2-18所示。

图 2-17 环形拓扑结构网络示例

图 2-18 BNC中继转发器和阻抗匹配器

说明 图2-17只是一种示意图,实际这种拓扑结构的网络不会是所有计算机真的要连接成物理上的环形,其连成的可以是任意形状,如直线形、半环形等。这里所说的“环”是从电气性能上来讲的,“环”的形成并不是通过电缆两端直接连接形成的,而是通过在环的电缆两端加装一个阻抗匹配器来实现的。

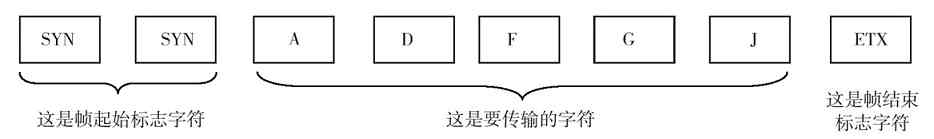

环形拓扑结构网络的一个典型代表就是采用同轴电缆作为传输介质的IEEE 802.5的令牌环网(Token Ring Network)。令牌环拓扑结构最早是由IBM推出的,传输速率为4Mbps或16Mbps,比当时只有2Mbps的以太网性能要高出好几倍,所以在当时得到了广泛的应用。但随着以太网技术的跳跃式发展,令牌环网技术性能不能再适应时代的要求了,故逐渐被淘汰出局了。令牌环网的传输原理是,RPU(环中继转发器)从其中的一个环段(称为上行链路)上获取帧中的每个比特位信号,然后经过整形和放大转发到另一环段(称为下行链路)。如果帧中的目的MAC地址与本站点MAC地址一致,则复制该MAC帧发送给连接本RPU的站点。

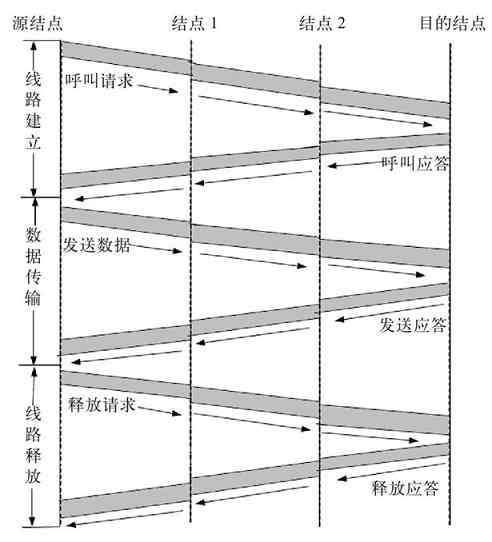

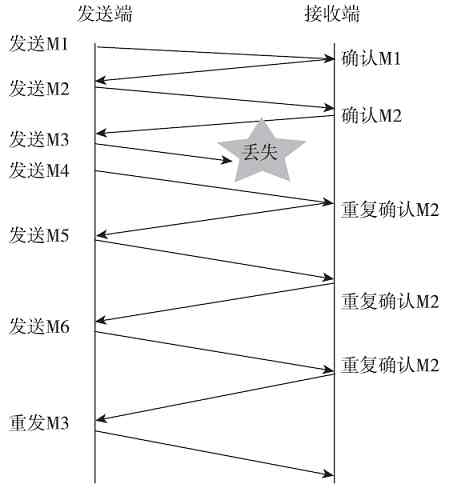

2.令牌环网数据传输原理

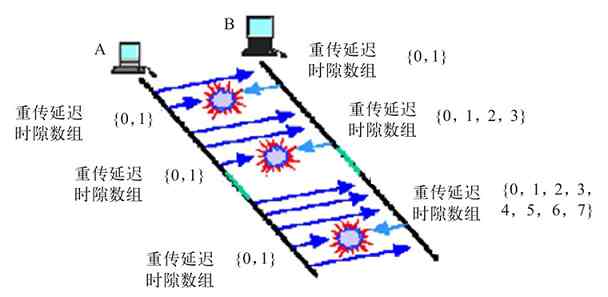

令牌环网中由点对点链路构成的环路虽然不是真正意义上的广播媒体,但令牌环网上运行的数据帧仍能被所有的站点接收到。而且任何时刻仅允许一个站点发送数据,因此理论上是存在发送权竞争问题的,这实际上就是我们将在第6章介绍的“介质争用”问题。为了解决这个问题,在令牌环网中使用了一个称之为“令牌”(Token,可以联想到以前武将出征杀敌时手中拿的由皇上发的帅印,代表一种授权)的特殊的MAC控制帧(该帧中有一个比特位用来标志令牌的忙或闲),使其沿着环路循环。并且规定只有获得“令牌”的站点才有权发送数据帧(就像战争中只有一位统帅可以获得“帅印”一样),完成数据发送后立即释放令牌以供其他站点使用。由于环路中只有一个令牌,因此任何时刻至多只有一个站点发送数据,不会产生冲突。但令牌环网上各站点均有相同的机会获得令牌。

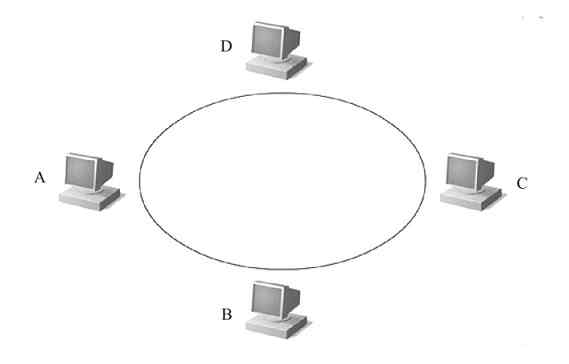

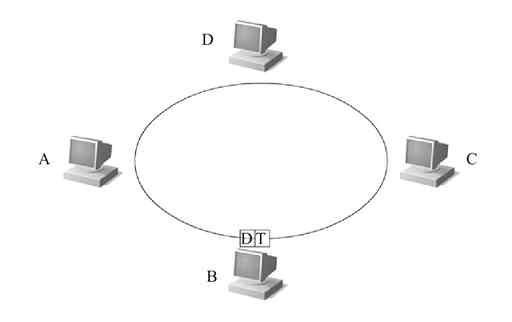

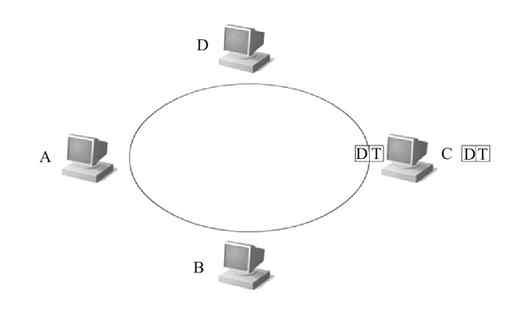

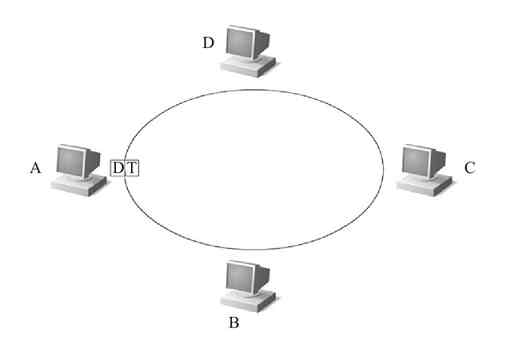

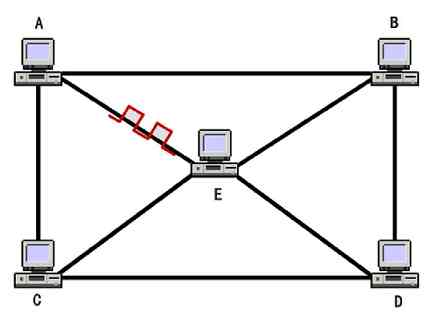

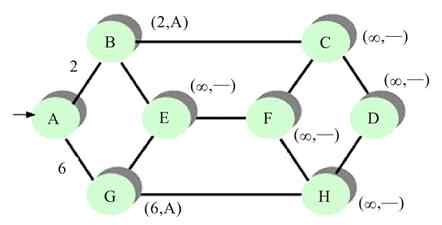

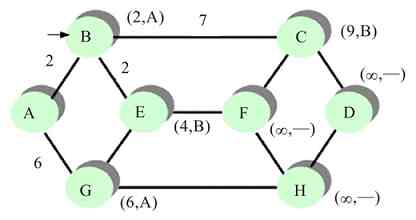

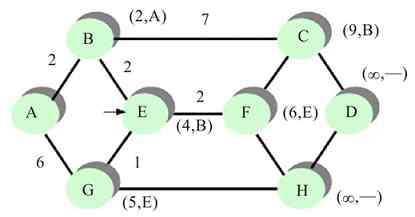

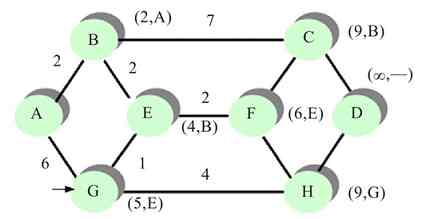

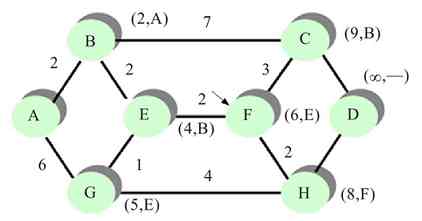

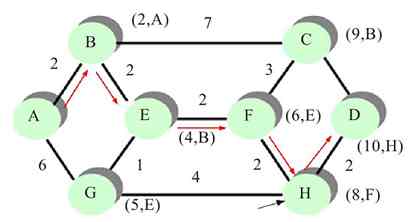

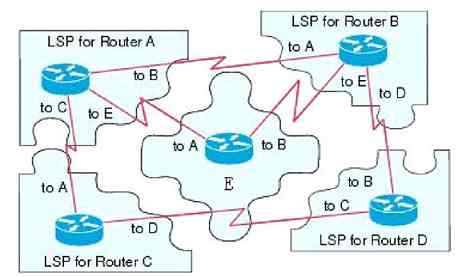

图2-19所示的是一个简单令牌环网(注意,这里的环是逻辑意义上的,并不是真正的物理环),其中连接了4台机器。现假设A站点要向C站点发送数据。下面介绍A站点的具体数据发送流程。

图 2-19 令牌环网示例

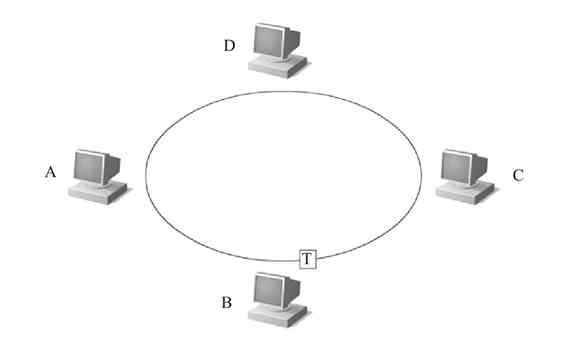

1)首先环网中的令牌是在网上按照一个方向循环流动的,如图2-20所示(图中的“T”代表的就是环网中的“令牌”)。

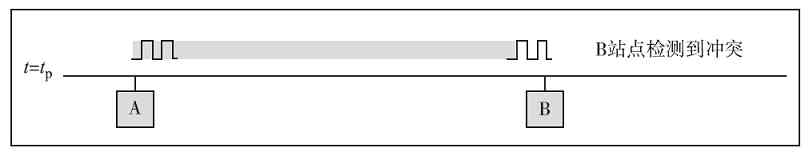

图 2-20 令牌在环网上流动

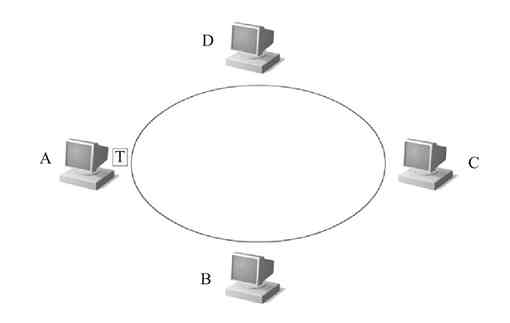

2)当令牌转到A站点时,A站点的RPU截获该令牌(如图2-21所示),把令牌的状态控制位设置为1,代表处于忙的状态(表示令牌目前已被占用),同时在令牌帧上附加要发送的数据帧沿着环的路径向下发送出去。当令牌帧和数据帧组合的信息帧(在此称之为“信息帧”)流经B站点时,B站点把自己的MAC地址与帧中的目的MAC地址进行比较,发现不匹配,于是不接收该数据帧,继续转发信息帧,如图2-22所示。

图 2-21 A站点截获令牌

图 2-22 B站点不接收信息帧

3)当信息帧流经C站点时,C站点也会把自己的MAC地址与帧中的目的MAC地址进行比较,发现正好匹配,于是C站点的RPU复制其中的数据帧,并把复制的数据帧传送给C站点,丢弃其中的令牌帧,如图2-23所示。

图 2-23 C站点的RPU复制该数据帧,并把其传送给C站点

4)原来的信息帧继续向下传递,流经D站点时同样因它的MAC地址与数据帧中的目的MAC地址不匹配,故不接收,信息帧继续转,直到回到源站点A,如图2-24所示。

图 2-24 信息帧返回源站点,并释放令牌

此时恰好循环一周,A站点根据返回的有关信息确定所传数据帧有无出错。若有错则重发存于缓冲区中的待确认帧,否则释放缓冲区中的待确认帧。确认无错后,A站点的RPU会把其中的令牌帧状态置为0,表示处于空闲状态,释放令牌,然后在网上发送出去,令牌继续在环网上流动。其他站点如果想要发送数据,则可通过获得该令牌进行数据发送。

一个控制了令牌的站点可以进行一次或多次数据帧发送,只要不超过网络中规定的最长令牌控制时间即可。而具体的最长令牌控制时间要视具体网络环境通过计算才能得出,在此不做具体介绍。

3.环形拓扑结构的主要优缺点

环形拓扑结构网络的优点主要体现在以下方面。

(1)网络路径选择和网络组建简单

在这种拓扑结构网络中,信息在环形网络中流动是沿着一个特定的方向,每两台计算机之间只有一个通路,简化了路径的选择,路径选择效率非常高。同样因为这个,这类网络的组建相当简单。

(2)投资成本低

在投资成本方面,主要体现在令牌环网络中没有任何其他专用网络设备(如交换机),各站点直接通过电缆连接,所以无需任何投资去购买网络设备。

尽管有以上两个看似非常诱人的优点,但环形网络的缺点仍是主要的,这也是它最终被淘汰出局的根本原因。环形拓扑结构网络的缺点主要体现在以下几个方面。

(1)传输速度慢

这是它最终不能得到发展和用户认可的最根本原因。虽说它在刚出现时,较当时的10Mbps以太网在速度上有一定优势(因为它可以实现16Mbps的接入速率),但由于这种网络技术后来一直没有任何发展,速度仍保留在原来水平,相对现在最起码的100Mbps、1Gbps速率的以太网来说,实在是太落后了。现在连无线局域网(WLAN)的传输速度都远远超过了它。这么低的连接性能决定了它只能被淘汰的局面。

(2)连接用户数非常少

在这种环形拓扑结构中,各用户是相互串联在一条传输电缆上的,所以可以连接的用户数非常有限。尽管可以有中继设备,但中继器只起到一个信号放大和连接距离的拓展的作用,并不能很明显地提高连接用户的数量(通常最多也就是几十个用户)。

(3)传输效率低

这种环形拓扑结构网络共享一条传输电缆,每发送一个数据均要先取得令牌,每次数据的发送,令牌都要在整个环状网络中从头走到尾,哪怕是已有站点接受了数据;而且每个环形网络中只有一个令牌,所以同一时刻只有一个站点可以取得令牌并发送数据,所以传输效率是非常低的,明显不再适用当前复杂的网络应用需求。

(4)扩展性能差

因为是环形拓扑结构,且没有任何可用来扩展连接的设备,决定了它的扩展性能远不如星型拓扑结构好。如果要新添加或移动站点,就必须中断整个网络,在适当位置切断网线,并在两端做好环中继转发器才能连接。

(5)维护困难

虽然在环形拓扑结构网络中只有一条传输电缆,看似结构也非常简单,但它是一个闭环,设备都连接在同一条串行连接的环路上,所以一旦某个站点出现了故障,整个网络将瘫痪。并且在这样一个串行结构中,要找到具体的故障点非常困难,必须一个站点一个站点地排除,非常不便。另一方面,因为同轴电缆所采用的是插针接触方式,也非常容易出现接触不良,造成网络中断,网络故障率非常高。笔者就曾经维护过这样一个小型企业网,虽然只有20多台机,但因分布在几栋建筑物中,几乎天天发生网络故障,有时一查就可能是几个小时。

2.3.4 总线型拓扑结构

总线型拓扑结构(Bus Topology)与上节介绍的环形拓扑结构从外形上看有些类似,都是共享一条同轴电缆作为传输介质,通过RPU(中继转发器)连接多台计算机,而且网络通信中都是以令牌的方式进行的。所谓“总线”就表示,网络中连接的各站点间进行数据通信时都必须通过这条线缆。但总线型拓扑结构采用的是IEEE 802.4标准(对应RFC 1230),接入速率也低于上节介绍的环形网络(只有10Mbps),这两种拓扑结构还是存在较大不同的,具体将在本节后面介绍。但要说明的是,在当前的局域网中,纯粹的总线型结构网络基本上不见了,取而代之的是在一些特殊的网络环境中与星型拓扑结构混合使用,也就是在本章后面即将介绍的混合型拓扑结构。

1.总线型结构概述

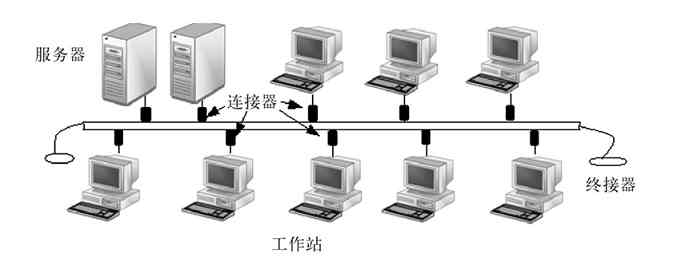

总线型拓扑结构网络中所有设备通过连接器并行连接到一条传输电缆(通常称之为中继线、总线、母线或干线)上,并在两端加装一个称为“终接器”的组件,如图2-25所示。终接器主要用来与总线进行阻抗匹配,最大限度吸收传送端部的能量,避免信号反射回总线产生不必要的干扰。

图 2-25 总线型结构示例

总线型结构网络所采用的传输介质一般也是同轴电缆(包括粗同轴电缆和细同轴电缆,也有采用光纤的),如ATM网、Cable Modem所采用的网络等都属于总线型网络结构。为了扩展所连接的计算机数量,可以在网络中添加其他的扩展设备,如中继器。图2-26所示的就是通过中继器连接的两个总线型网络单元。

图 2-26 双总线结构网络互连示例

总线型拓扑结构的代表技术就是IBM的ARCNet令牌网络,所以总线型拓扑结构通常认为是令牌总线(Token Bus)结构。物理上是总线网,逻辑上是令牌网。总线型拓扑结构与上节介绍的环形拓扑结构相比,不同之处主要体现在以下两个方面。

(1)与传输电缆的连接方式不同

环形拓扑结构中的连接器与电缆是串联的,所以任何连接站点出现故障都会引起整个网络的中断,而总线型拓扑结构中的连接器与电缆是并联的,所以某个站点发生故障不会影响网络中的其他站点通信。

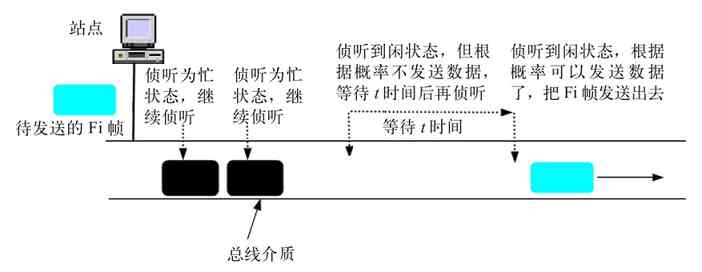

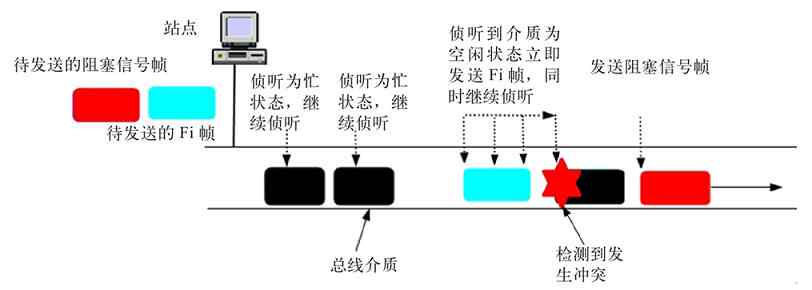

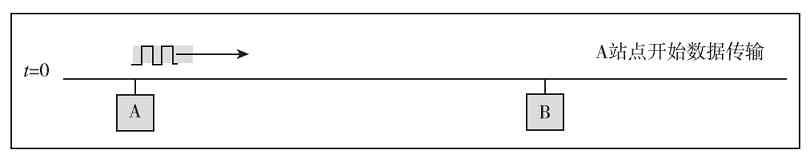

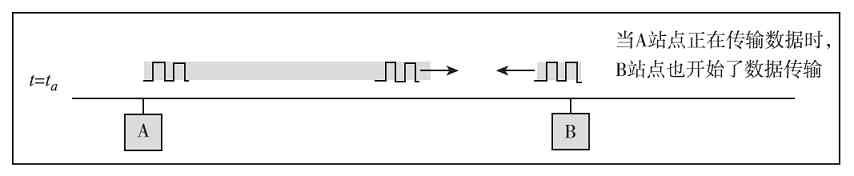

(2)数据传输原理不同

两种拓扑结构的数据传输原理不一样。在总线型拓扑结构中,令牌帧和数据帧都是沿着根据当前网络环境自动生成的逻辑令牌环进行传输的,而不是像环形拓扑结构那样按照物理环路径进行传输的。具体将在本节后面介绍。

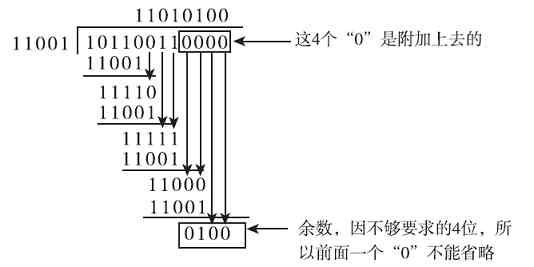

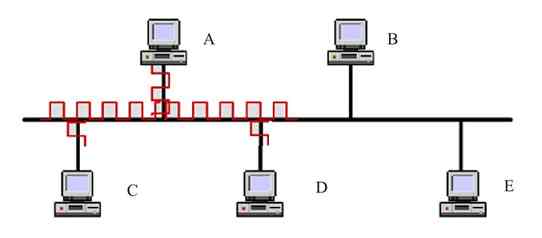

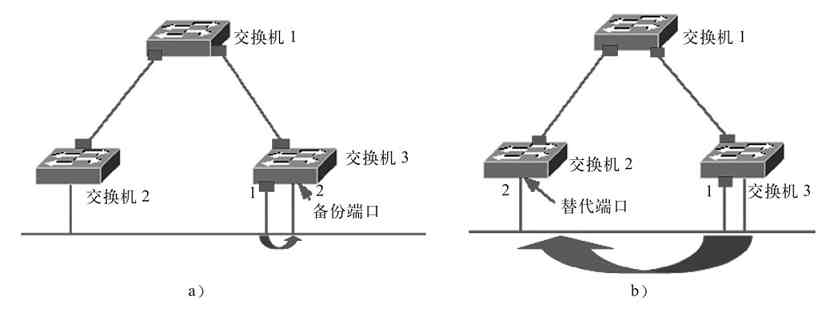

2.令牌总线数据传输原理

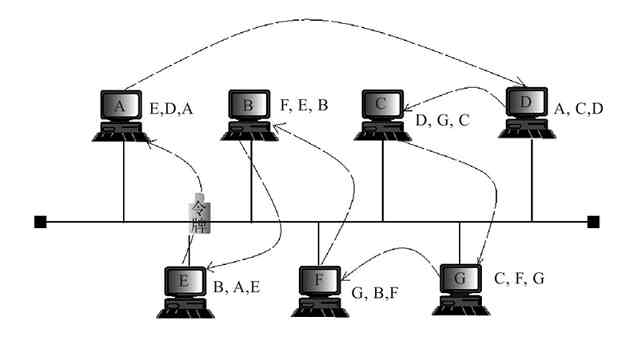

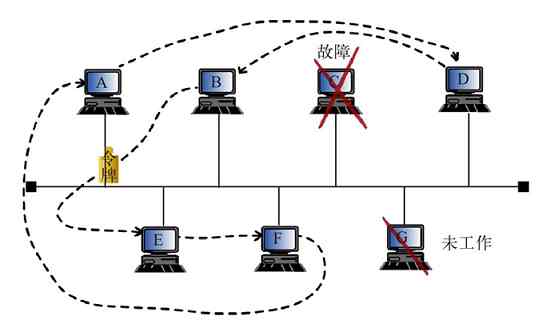

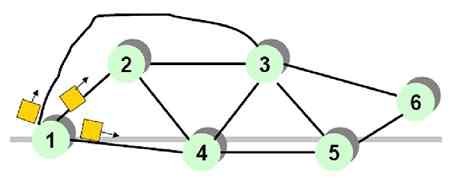

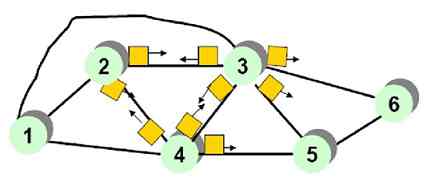

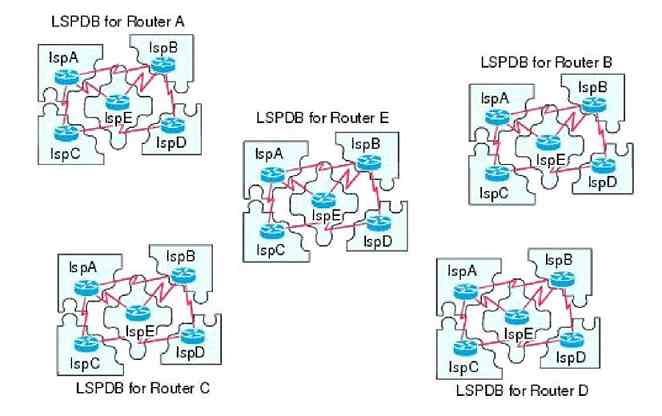

IEEE 802.4标准下的令牌总线的介质访问控制(MAC)是根据局域网物理总线的各站点先生成一个逻辑环,每一个站点都在一个序列中被指定一个逻辑位置(注意,不是物理位置),序列中最后一个站点的后面又跟着第一个站点,以形成一个逻辑上闭合的环路。图2-27所示的就是一个小型总线拓扑型拓扑结构计算机网络示例。从图中可以看出,在物理结构上,它是一个总线拓扑结构局域网,但是在逻辑结构上,又成了一种环形拓扑结构的局域网:A→D→C→G→F→B→E→A。

图 2-27 令牌总线中的站点连接表

另外,在总线型拓扑结构网络中,每个站点都知道在它之前的站点和在它之后的邻居站点标识。为了保证逻辑闭合环路的形成,每个站点都动态地维护着一个连接表,该表记录着本站点在环路中的前继、后继和本站点的地址。如图2-27所示,A站点中有E、D、A这三个地址,分别代表着A站点的前继站点(E站点)MAC地址、后继站点(D站点)MAC地址和本站点MAC地址。每个站点根据它的后继站点MAC地址确定下一个可能要占有令牌的站点。所以,令牌的传递顺序与总线上各站点的物理位置无关。

如果总线网络中某个站点出现故障或没有工作,则会重新建立新的逻辑令牌环网络,绕开出现故障或没有工作的站点(因为各站点之间是并行连接的),如图2-28所示的就是图2-27所示的总线型拓扑结构网络在出现两个站点(C和G站点)没有正常工作时新建的令牌环网。

图 2-28 当总线网络中出现不能正常工作站点时新建的令牌环网络

令牌总线网络与令牌环网络的数据传输原理基本一样,都是站点在发送数据前必须先取得“令牌”,取得令牌的站点有数据帧要发送则可发送,如果没有数据帧要发送,则直接把令牌传递到逻辑令牌环中的后继站点。而且只有获得令牌的站点才能发送信息,其他站点只能接收信息,或者被动地发送信息(在拥有令牌的站点要求下发送信息)。由于站点接收到令牌的过程是顺序依次进行的,因此对所有站点都有公平的访问权,也不会出现介质访问冲突。

在具体的数据发送过程中,取得了令牌的站点把令牌帧和数据帧一起(在此也称之为信息帧)在总线网络中发送,其他各站点均可收到这个信息帧,但也只有其MAC地址与接收到的数据帧中的目的MAC地址一致的站点才会复制并接收该信息帧,把其中的数据帧传递给对应的站点PC(将其中的令牌帧丢弃),然后原来的信息帧继续沿着逻辑令牌环传递,直到回到发送数据的源站点。当发送数据帧的站点收到接收数据帧的站点的响应后就可得知该次数据发送成功,随即释放自己所控制的令牌,按照逻辑令牌环的顺序把令牌依次传递到它的后继站点。

3.总线拓扑结构的主要优缺点

总线拓扑结构的优点与环形拓扑结构差不多,主要有如下几点。

(1)网络结构简单,易于布线

因为总线型网络与环形网络一样都是共享传输介质,也通常无需另外的网络设备,所以整个网络结构比较简单,布线比较容易。

(2)扩展较容易

这是总线型网络相对同样是采用同轴电缆(或光纤)作为传输介质的环形网络结构的最大的一个优点。因为总线型结构网络中,各站点与总线的连接是通过并行连接(环形网络中连接器与电缆的连接是串行的)实现的,所以站点的扩展无需断开网络,扩展容易了许多。而且还可通过中继设备扩展连接到其他网络中,进一步提高了可扩展性能。

(3)维护容易

总线型网络中的连接器与总线电缆是并行连接的,这给整个网络的维护带来了极大的便利,因为一个站点的故障不会影响其他站点,更不影响整个网络,所以故障点的查找就容易了许多。这与星型拓扑结构类似。

尽管有以上一些优点,但是它与环形拓扑结构网络一样,缺点仍是主要的,这些缺点也决定了它在当前网络应用中也极少使用的命运。总线型结构的主要缺点表现在以下几个方面。

(1)传输速率低

IEEE 802.5令牌环网中的最高传输速率可达16Mbps,但IEEE 802.4标准下的令牌总线网络标准最高传输速率仅为10Mbps。所以它虽然在扩展性方面较令牌环网络有一些优势,但它同样摆脱不了被淘汰的命运。

(2)故障诊断困难

虽然总线拓扑结构简单、可靠性高,而且是互不影响的并行连接,但故障的检测仍然很不容易。这是因为这种网络不是集中式连接,故障诊断需要在网络中各站点计算机上分别进行。另外,在这种结构中,如果故障发生在各个计算机内部,只需要将计算机从总线上去掉,比较容易实现。但是如果是总线传输介质发生故障,则需要更换全部相应段传输介质了。

(3)难以实现大规模扩展

虽然相对环形网络来说,总线型网络在扩展性方面有了一定的改善,可以在不断开网络的情况下添加设备,还可添加中继器之类的设备予以扩展,但受到传输性能的限制,其扩展性仍然远不如星型网络,难以实现大规模的扩展。

综上所述,单纯总线型结构网络目前也已基本不用,因为传输性能太低(只有10Mbps),可扩展性也受到性能的限制。目前总线型结构就是在后面将要介绍的混合型网络中才会用到的。在这些混合型网络中使用总线型结构的目的就是用来连接两个(如两栋建筑物),或多个(如多楼层)相距超过100m的局域网,细同轴电缆连接的距离可达185m,粗同轴电缆可达500m。如果超过这两个标准,就需要用到光纤了。但无论采用哪种传输介质的总线型结构,传输速率都只有10Mbps,实用性极低,还不如直接采用光纤星型拓扑结构。

2.3.5 树形拓扑结构

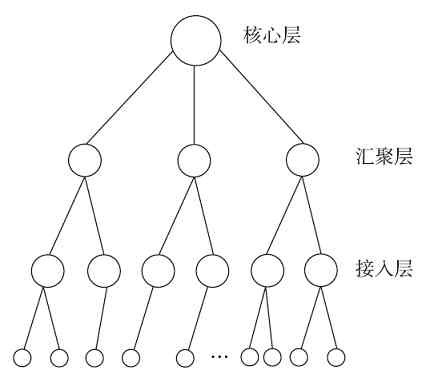

关于树形拓扑结构(Tree Topology)的描述,目前有多种版本,有的说是总线型拓扑结构的扩展,有的说是星型拓扑结构的扩展,其实两者均有道理。之所以认为是星型拓扑结构的扩展,是因为其中的每个集线设备(如交换机)所连接的就是一个个星型拓扑结构单元。之所以认为是总线型拓扑结构的扩展,是因为树形拓扑结构中各设备间是通过类似的“总线”(交换机级联电脑)进行互连的,一个星型结构单元的节点与另一个星型结构单元的节点之间的通信都是共享这一条“总线”的。一般认为树形拓扑结构是星型拓扑结构的扩展。

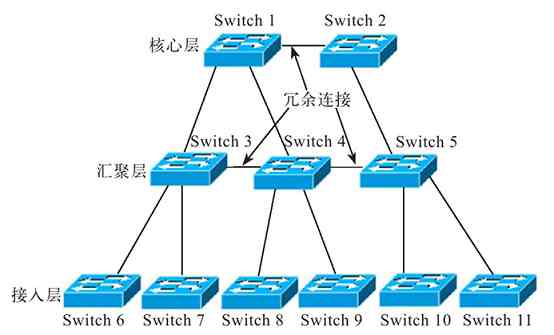

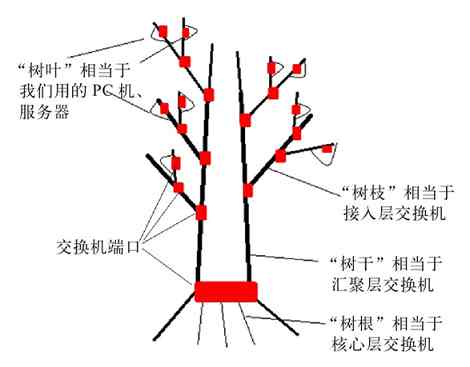

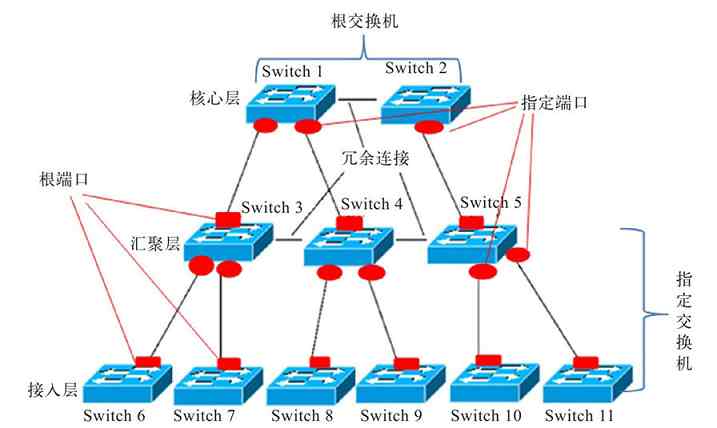

树形拓扑结构自上而下(从核心交换机(或骨干层)到汇聚层,再到边缘层)是自上而下依次分层扩展的,就像一棵倒放的“树”,这或许就是把它定义为“树形”拓扑结构的原因之一吧。树形拓扑结构的最顶层(也就是核心层)相当于树的“根”,中间层(汇聚层)相对于“树的枝”,而最下层(边缘层,或者接入层)则相当于树枝上的“细枝”和“树叶”。自上而下,所用的交换机数量是逐层增多的。简化的树形拓扑结构如图2-29所示(图中每一个大圆圈代表一台交换机,最下面的每个小圆圈代表一台所连接的主机)。

图 2-29 树形拓扑结构示意图

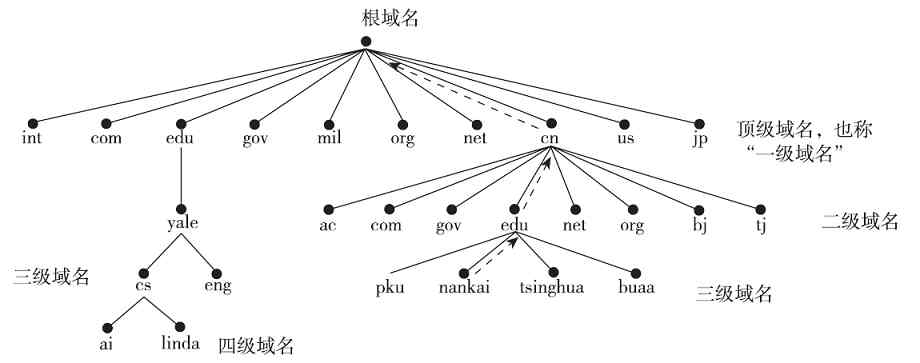

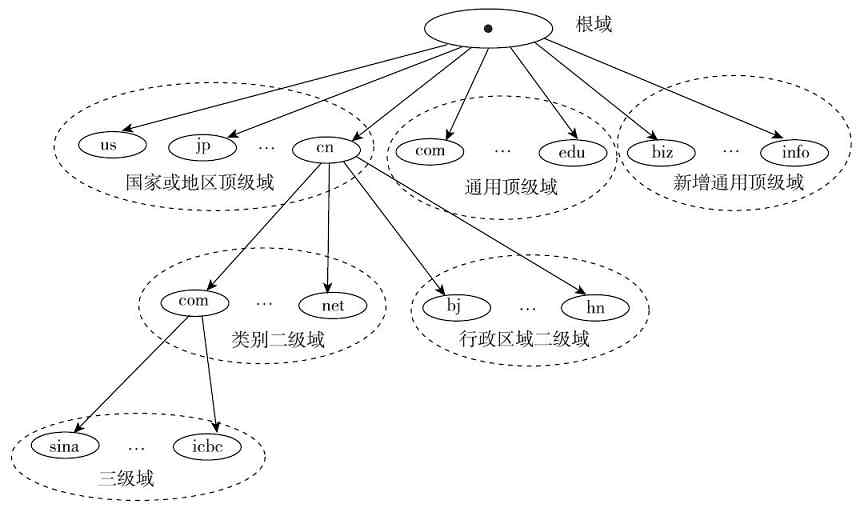

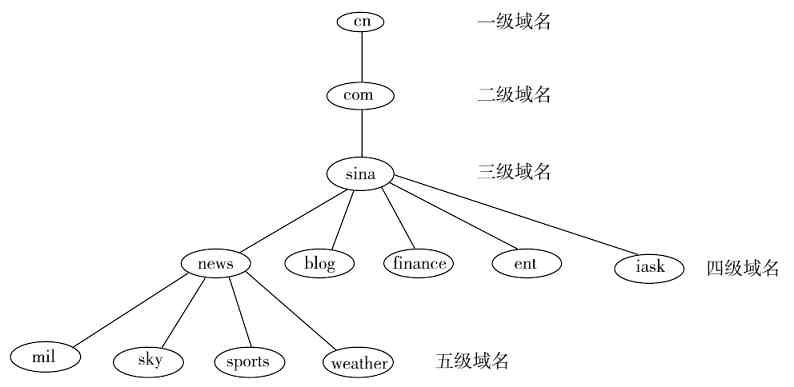

经验之谈 其实还有许多类似“树”形状的实例,如各公司的组织结构也是自上而下依次展开的(最上面只有董事长一人,下面是各级董事,再下面是总经理、部门经理、科室主任等),还有我们所用的Internet网站域名也是自上而下展开的(分为根域名、顶级域名(一级域名)、二级域名、三级域名等,如图2-30所示),这部分将在第11章具体介绍。

图 2-30 域名结构

在计算机网络技术中,还有一种技术同样引用了“树”的概念,那就是将在第6章介绍的生成树协议(STP)。它形象地利用了“树”中树根、树干、树枝、树叶之间这种无交叉的逻辑关系,以实现交换网络中无二层环路。

图2-31所示的就是一个典型的树形拓扑结构。它采用分级的集中控制方式,其传输介质可有多条分支,但不形成闭合回路,每条通信线路都必须支持双向传输。

图 2-31 典型树形拓扑结构示例

从以上介绍可以得知,树形拓扑结构的主要优点还是扩展性方面。星型拓扑结构便于扩展我们已经知道,只要在集线设备空余端口上拉出一条网线,就可以添加新的设备;而在树形拓扑结构中,是通过多级星型结构的级联,可以更方便地实现在连接距离和端口数据上的扩展,实现更大规模网络的扩展升级。

但树形拓扑结构自身也有一些不足,这主要体现在以下两个方面:一是对“根”设备(核心,或者骨干层)交换机的依赖性太大,如果“根”发生故障,则那些依赖“根”设备访问的服务器或外网则全部不可访问了,相当于总线型拓扑结构中总线中断后,所有用户网络都中断一样。另外,处于最顶端的核心层设备,因为下面连接了更多的级联设备和用户,负荷更重,需要配备性能更强的交换机和路由设备,成本比较高。但这些不足都可以通过配置冗余链路和选择高性能设备来弥补。树形拓扑结果是目前中小型以太局域网(如位于同一楼层,或者分布于少数几个楼层的局域网)中最主要的拓扑结构。

2.3.6 网状拓扑结构

网状拓扑结构(Mesh Topology)又称无规则型拓扑结构。在这种结构中,各节点之间通过传输介质彼此互连,构成一个网状结构。

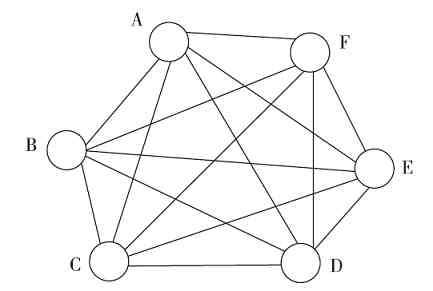

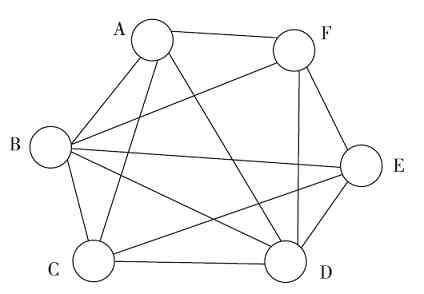

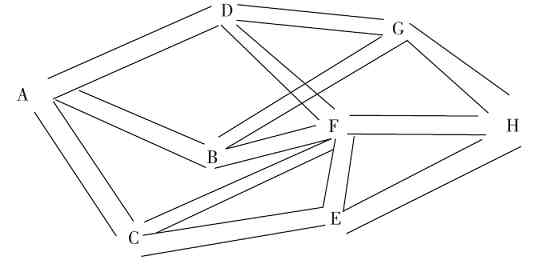

网状拓扑结构又有“全网状结构”和“半网状结构”两种。所谓“全网状结构”就是指网络中任何两个节点间都是相互连接的。假设一个网络中有n个节点,则任何一个节点就有n-1条与其他节点的连接。图2-32所示的就是一个全网状拓扑结构。而所谓的“半网状结构”是指网络中并不是每个节点都与网络的其他所有节点有连接,可能只是一部分节点间有互连,如图2-33所示,A节点就没有与E节点直接连接,C节点也没有与F节点直接连接。

图 2-32 全网状拓扑结构示例

图 2-33 半网关拓扑结构示例

从以上介绍可以知道,网状拓扑结构的布线是相当复杂的(中间没有集中连接设备,全靠电缆来互连),布线成本也非常高,因为每个节点要用多条电缆与其他节点依次连接。同样,由于中间没有集中连接设备,每个节点PC都需要安装多块网卡,当一个节点要互连的其他节点比较多时,这显然不可行。所以这种网状拓扑结构在局域网中是极少使用的,最多也只是极少数的节点采用了半网状拓扑结构。

网状拓扑结构主要用于广域网中,这时它们连接的不再是终端用户PC节点,而是网络设备结点,如网络中的交换机、路由器等设备。在广域网中采用网状拓扑结构可以实现多个网段,或者子网间的彼此互连。因为交换机和路由器这些设备本身就具有多个网络端口,所以进行网状连接也很简单,只是需要多拉几条线而已。

广域网中采用网状拓扑结构的主要目的就是通过实现链路或路由线路的冗余,提高网络的可靠性。当然,一般并不会在整个广域网中而只是在骨干网络中采用这种拓扑结构。

图2-34所示为一个广域骨干网全网状拓扑结构示例。示例中各个路由器之间彼此互连。但更多的是采用半网状拓扑结构,仅少数结点需要与网络中其他所有结点互连。如图2-35所示的就是广域骨干网中采用半网状拓扑结构的一个示例。示例中各路由器只与少数其他路由器互连,并不是全部互连。

图 2-34 广域骨干网中的全网状拓扑结构示例

图 2-35 广域骨干网中的半网状拓扑结构示例

网状拓扑结构具有较高的可靠性,因为这种拓扑结构中各节点的连接存在冗余线路,任何单一连接线路中断都不会影响网络的整体连接。同样是由于存在冗余线路,所以比较容易在多条线路上实现负载均衡。但其结构复杂,配置也很复杂,实现起来成本可能很高,特别是在广域网环境,也不易管理、维护和进行网络扩展;同样由于节点间存在多条冗余线路,导致容易出现路由环路,或者二层环路(如果连接的结点是交换机),路由配置复杂。

2.3.7 混合型拓扑结构

混合型网络结构是目前局域网,特别是分布型大中型局域网中应用最广泛的网络拓扑结构,它可以解决单一网络拓扑结构的传输距离和连接用户数扩展的双重限制。

1.混合型拓扑结构概述

混合型网络拓扑结构是指由多种结构(如星型拓扑结构、环形拓扑结构、总线型结构、网状结构)单元组成的拓扑结构,但常见的是由星型拓扑结构和总线型拓扑结构结合在一起组成的,如图2-36所示。

图 2-36 混合型拓扑结构示例

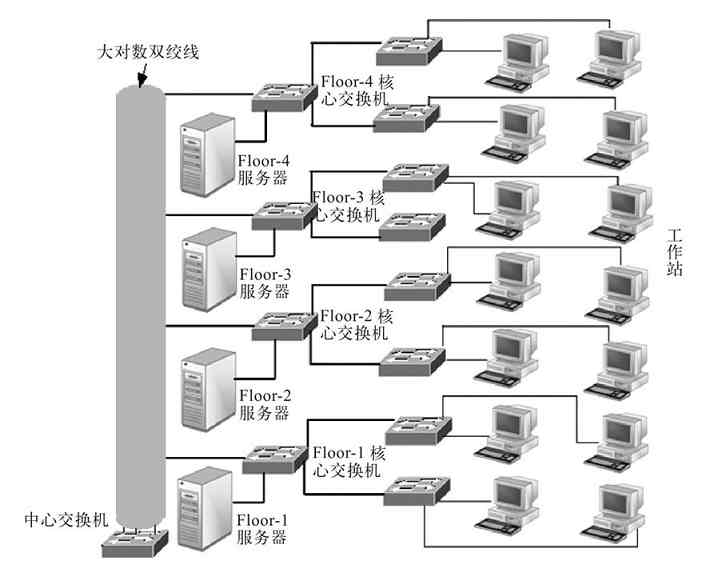

混合型拓扑结构更能满足较大网络的灵活扩展,解决星型网络在传输距离上的局限(因为双绞线的单段最大长度要远小于同轴电缆和光纤),同时又解决了总线型网络在连接用户数量的限制。图2-36所示只是一种简单的混合型网络结构,实际上的混合型拓扑结构主要应用于分布在多层或者多栋建筑物中的网络中。其中采用同轴电缆或光纤的“总线”用于垂直或横向干线,基本上不连接工作站,只是连接各楼层或各建筑物中各核心交换机,而其中的星型拓扑结构网络则体现在各楼层或各建筑物内部的各用户网络中,如图2-37所示。

图 2-37 多楼层的混合型网络结构示例

在实际的组网中,现在一般很少使用同轴电缆作为总线了,而是采用传输性能更好,更方便进行网络连接的大对数双绞线。因为在一般的20层以内的楼中,100m的双绞线就可以满足,如图2-38所示。

图 2-38 分层星型拓扑结构示例

如果距离过远,如高楼层或多建筑物之间的网络互连,则可以用光纤作为传输介质,无论哪一种,传输性能均要比总线型连接方式好许多。

2.混合型拓扑结构的主要特点

混合型拓扑结构主要有以下几个方面的特点。

(1)应用广泛

这主要是因混合型拓扑结构解决了星型和总线型拓扑结构的不足,满足了大公司组网的实际需求。目前在一些智能化的信息大厦中的应用非常普遍。在一幢大厦中,各楼层间采用光纤作为总线传输介质,一方面可以保证网络传输距离,另一方面,光纤的传输性能要远好于同轴电缆,在传输性能上也给予了充分保证。当然,这不仅关系到传输介质的选择问题,更重要的是涉及网卡和交换机端口类型的选择,光纤类型端口网卡和交换机要贵许多的。

(2)扩展灵活

这主要是因为混合型拓扑结构继承了星型拓扑结构的优点。但由于仍采用广播式的消息传送方式,因此在总线长度和节点数量上也会受到限制,不过在局域网中的影响不是很大。

(3)维护较为困难

这主要受到总线型网络拓扑结构的制约,如果总线中断,则互连的各部分网络也就中断了,特别是对于那些使用统一核心交换机的网络;但是如果是分支网段出了故障,则仍不影响整个网络的正常运作。

2.3.8 无线局域网的两种拓扑结构

在无线局域网(WLAN)中有Ad-Hoc和Infrastructure两种拓扑结构(其实可以理解为WLAN的两种管理模式),前者连接性能较差,连接用户较少(通常为5个以内),主要用于小型家庭和SOHO网络中;后者连接性能较好,主要用于较多用户的企业网络中,应用更为广泛。

1.无线AP的Ad-Hoc模式主要优缺点

Ad-Hoc对等WLAN模式采用的是点对点连接方式(如图2-39所示),只能单点通信,就像有线网络中对等网一样,所以连接性能较差,仅适用于较少数量的计算机无线互连(通常是在5台主机以内)。同时由于这一模式没有中心管理单元,因此这种网络在可管理性和扩展性方面受到一定的限制。而且各无线节点之间只能单点通信,不能实现交换连接。当然这一无线网络结构还是有它自身优点的,那就是网络结构简单,只要安装了无线网卡即可连接,无需其他网络设备,成本非常低。

图 2-39 Ad-Hoc对等无线局域网结构

2.基于无线AP的Infrastructure结构

这种基于无线AP的Infrastructure基础结构模式其实与有线网络中的星型交换模式差不多(如图2-40所示),除了各无线用户需要安装无线网卡外,还需要一个用于集中连接各无线用户的无线AP,它相当于有线网络中的集线器。无线AP都提供了一个有线以太网接口,用于与有线网络、工作站和路由设备的连接。这种网络结构模式主要优势表现在网络易于扩展、便于集中管理、能提供用户身份验证等方面上,另外数据传输性能也明显高于Ad-Hoc对等结构。

图 2-40 Infrastructure基础无线局域网结构

其实图2-40所示也只是一个Infrastructure基础结构单元,在实际的企业WLAN网络中,可能有许多台AP设备,而且还可能有WLAN天线、WLAN中继器、WLAN网桥、WLAN控制器等设备。WLAN天线和WLAN中继器可用于连接更远距离的WLAN用户,WLAN网桥可用于连接不同的WLAN网段,WLAN控制器则可对整个WLAN网络进行管理。这就涉及信道的分配和优化了,在一定范围内不能有信道的重叠,否则信号之间就可能产生冲突。

有关WLAN的主要技术将在第6章具体介绍。

第3章 计算机网络体系结构

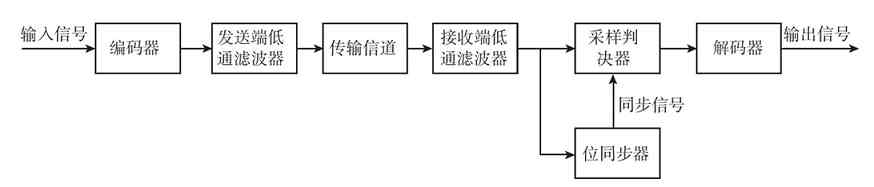

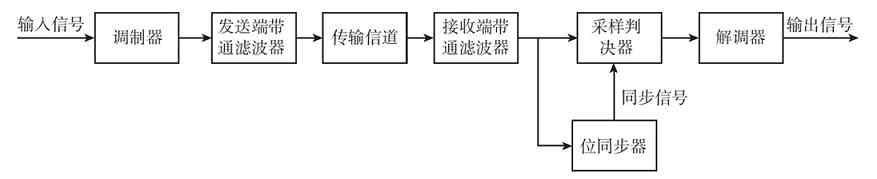

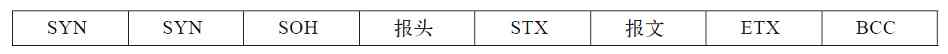

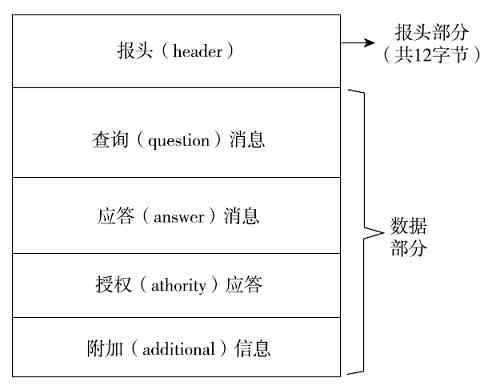

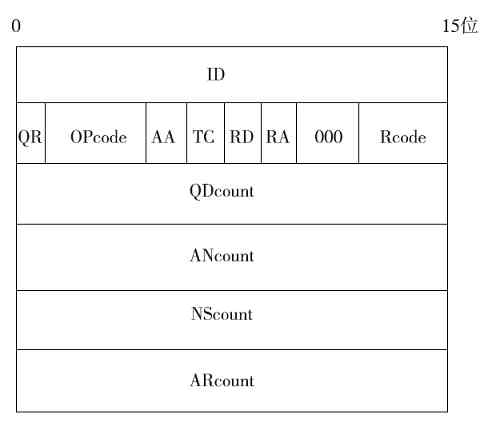

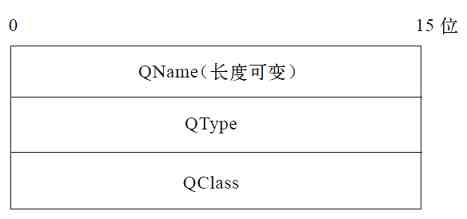

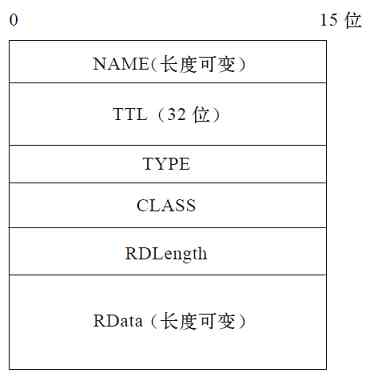

从本章起就开始正式介绍计算机网络体系结构(Computer Network Architecture)了。本章先从宏观角度介绍各种计算机网络体系结构。着重剖析了它们之间的联系、数据通信原理、各层的数据传输单元、各层数据封装原理以及各层主要功能,本书后面各章将具体介绍这些体系结构中各层主要功能实现原理、主要通信协议以及相关的计算机网络基础知识。

计算机网络体系结构是一个分层次的模块式结构,这样设计的目的一方面是便于我们从宏观上把握整个网络体系架构,实现快速分析与排除网络故障;另一方面是便于程序开发人员在进行网络系统开发时针对不同网络功能进行独立开发,无须考虑其他层的功能。

在计算机网络体系结构中,除了要介绍我们最熟悉的第一个标准化的计算机网络互连体系结构OSI/RM(Open System Interconnection Reference Model,开放系统互连参考模型)外,还要介绍局域网体系结构IEEE 802.1、TCP/IP协议体系结构(虽然至今都没有标准化,但已是事实上的标准,是否标准化已没什么关系了)和无线局域网(WLAN)体系结构的IEEE 802.11。以上所列的各种协议之间,在存在着一些差异的同时也有着密切的关系,事实上后面几个针对不同计算机网络类型的体系结构都是参照或基于OSI/RM来设计或者改进的。

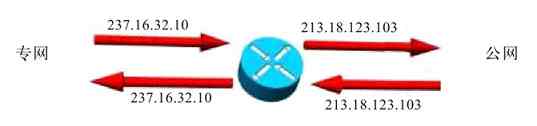

3.1 典型计算机网络体系结构

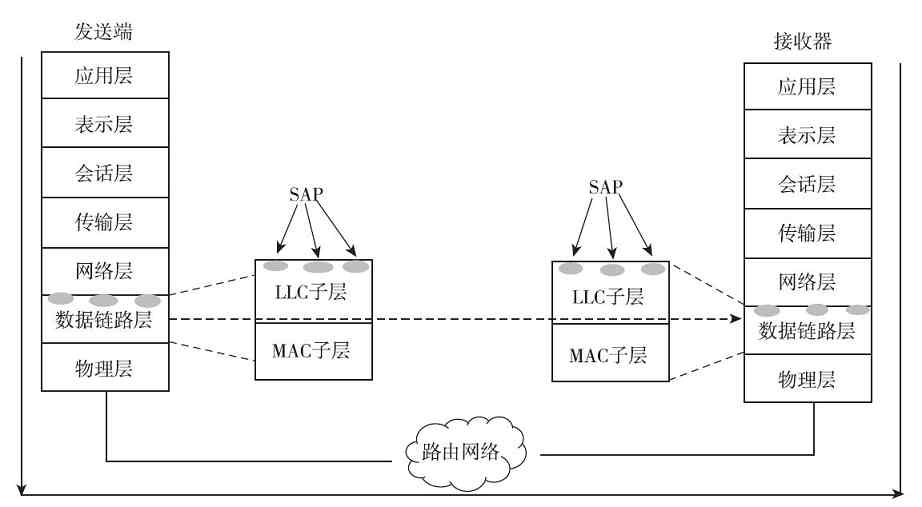

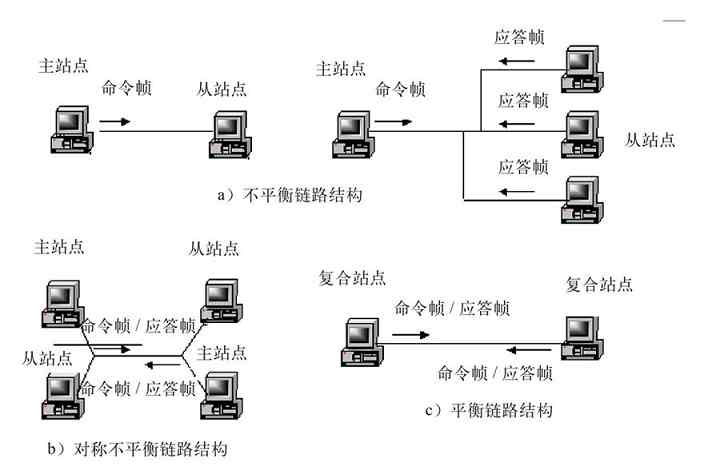

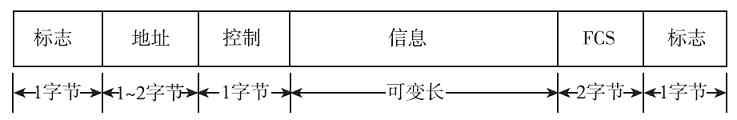

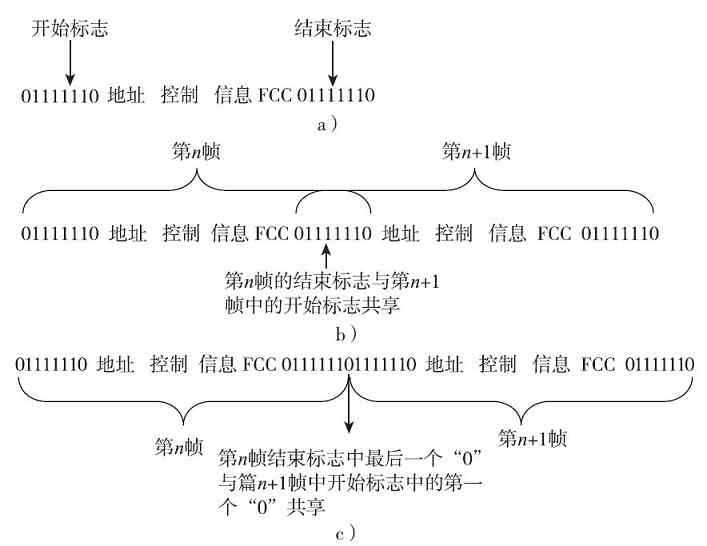

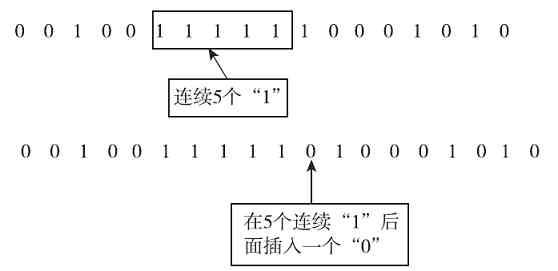

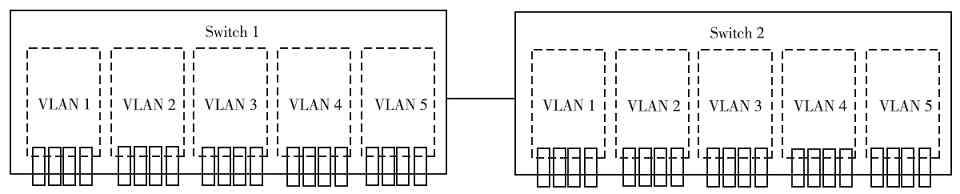

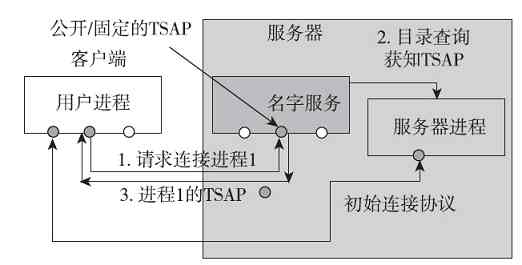

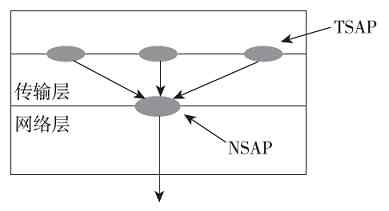

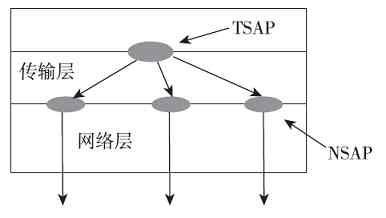

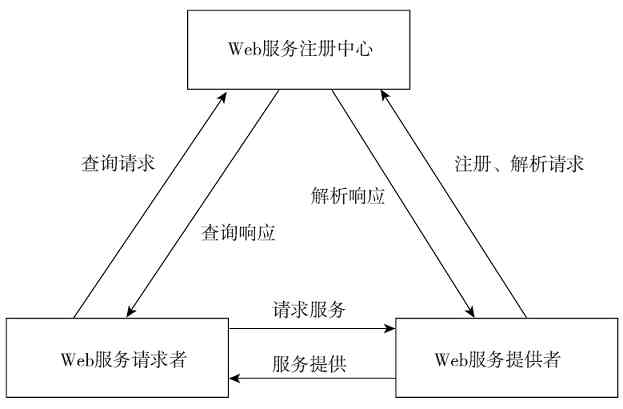

通过对2.1.2节的学习我们已经知道,早在20世纪60年代末,随着第二代分组交换式计算机网络(杰出代表就是美国的APPANET网络)的诞生,就已出现了计算机网络体系结构的雏形,那就是把整个计算机网络划分为“通信子网”和“资源子网”,如图3-1所示。随后在第三代计算机网络中,ISO推出了第一个标准化的计算机网络体系结构——OSI/RM(Open System Interconnection Reference Model,开放系统互连参考模型)。后面又有一些国际组织或公司先后推出了局域网体系结构IEEE 802.1、TCP/IP协议体系结构(虽然至今都没有标准化,但已是事实上的标准)和无线局域网(WLAN)体系结构的IEEE 802.11。本节先来认识这几种网络体系结构及其一些基本而又非常重要的原理。

图 3-1 APPANET的基本体系结构

3.1.1 OSI/RM体系结构

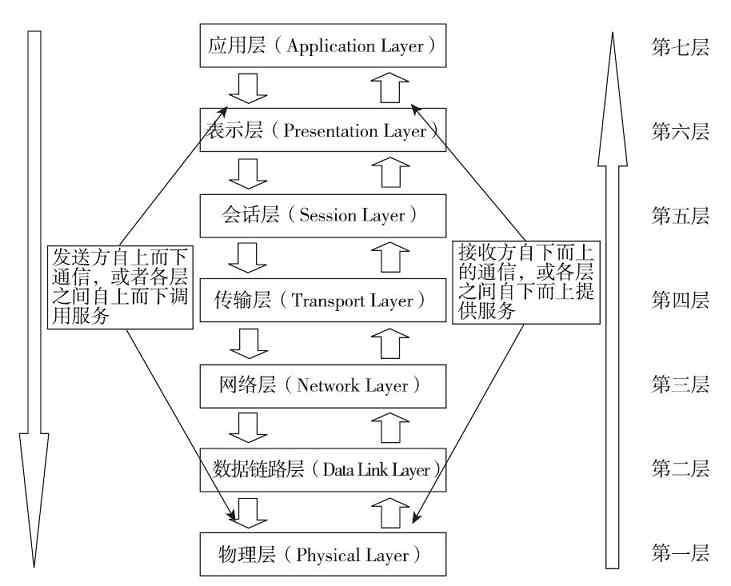

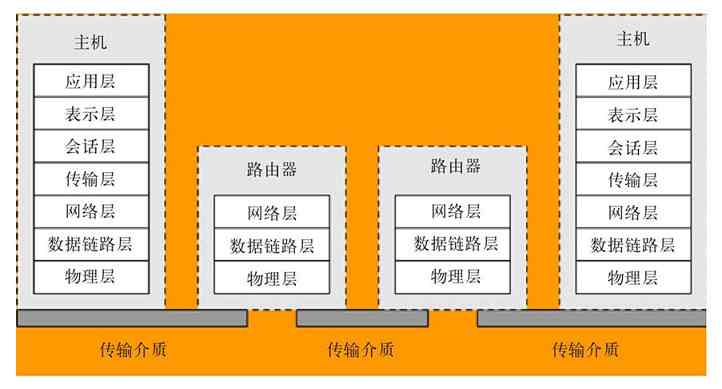

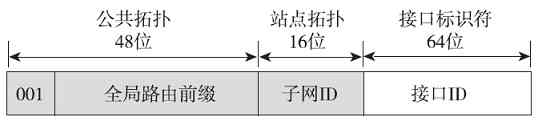

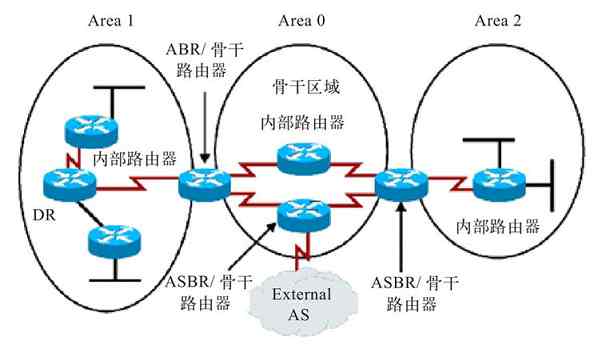

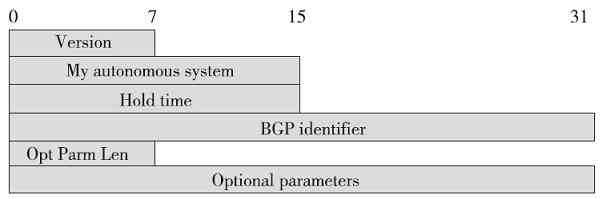

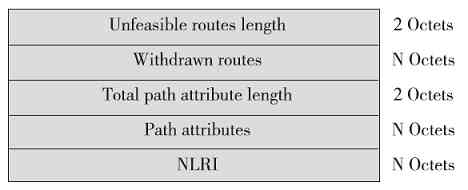

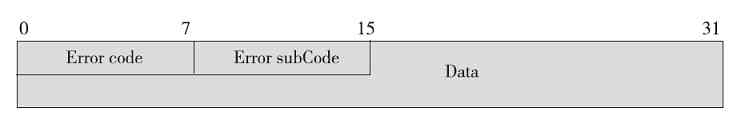

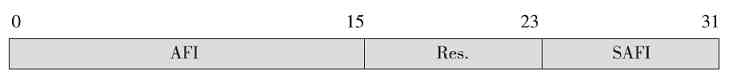

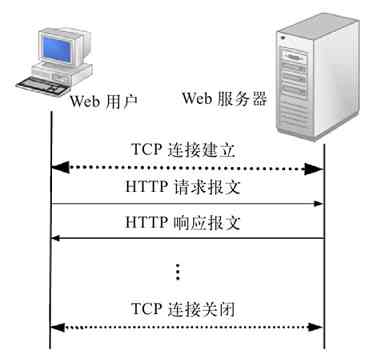

OSI/RM体系结构是第一个标准化的计算机网络体系结构。它是针对广域网通信(也就是不同网络之间的通信)进行设计的,将整个网络通信的功能划分为七个层次,由低到高分别是物理层(Physical Layer)、数据链路层(Data Link Layer)、网络层(Network Layer)、传输层(Transport Layer)、会话层(Session Layer)、表示层(Presentation Layer)、应用层(Application Layer),如图3-2所示。但任何广域网其实都是由多个远程局域网连接而成的,所以在OSI/RM中不仅包括了广域网中不同局域网间通信的功能层次(上面五层),也给出了局域网内部通信所必需的两个层次(最下面两层)。

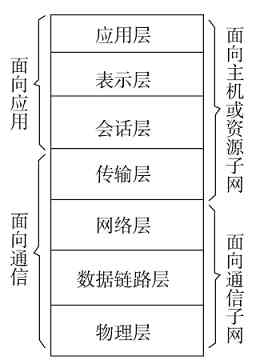

图 3-2 OSI/RM七层参考模型

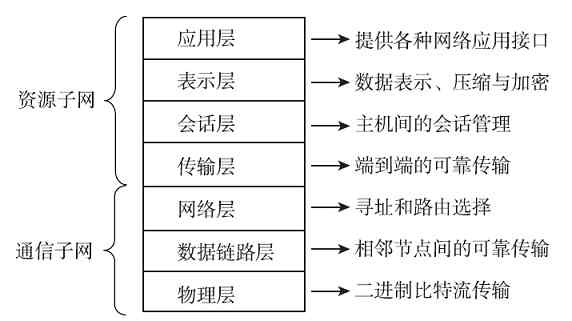

OSI/RM低四层(从物理层到传输层)定义了如何进行端到端的数据传输,也就是定义了如何通过网卡、物理电缆、交换机和路由器进行数据传输;而高三层(从会话层到应用层)定义了终端系统的应用程序和用户如何彼此通信,也即定义了如何重建从发送方到目的方的应用程序数据流。更多的是把OSI/RM的七层结构分成低三层和高四层的,低三层负责创建网络通信所需的网络连接(面向网络),属于“通信子网”部分,高四层具体负责端到端的用户数据通信(面向用户),属于“资源子网”部分。OSI/RM结构中各层功能如图3-3所示。

图 3-3 OSI/RM各层基本功能

经验之谈 在OSI/RM中,低三层有两方面的作用:首先是通过它们自己对应层的信息交换构建数据通信所需的网络平台,更通俗地说就是打通一条用于数据传输的网络通道;然后就是为来自上层的数据提供物理的传输通道。但低三层均不能识别和处理来自应用层的网络应用数据,仅用于为用户的网络应用数据通信提供通信线路、网络基础架构,或者说是网络通信平台。高四层上进行的才是真正面向用户的网络应用,为各种具体的网络应用提供应用平台和端对端的数据传输通道,对低三层所构建的网络平台可以说是“视而不见”。

我们经常听别人说,在局域网中仅可以通过数据链路层的MAC地址进行通信,很多人就认为网络应用也可以仅可以通过数据链路层进行。其实这是完全错误的。这里所说的“通信”其实是仅指两层设备之间的“网络通信”,用于构建数据通信所需的链路。它根本不能识别网络应用的用户数据(这涉及数据的封装次序,具体将在本章后面介绍),怎么可能进行网络应用通信?在局域网中进行具体的网络应用仍需要用到OSI/RM的网络层及以上各层,只是这些高层是由用户主机的操作系统来完成的。

无论是哪种划分方式,OSI/RM的每一层都要完成特定的功能,每层都直接为它的上层提供服务,同时又调用它的下层所提供的服务。所有层次都互相支持,在发送端网络通信是自上而下进行的(也就是自上而下调用服务),在接收端网络通信是自下而上(也就是自下而上提供服务)进行的,但双方必须在对等层次上进行通信(这就是对等通信原理,具体将在本章后面介绍)。当然并不是每一通信都需要经过OSI的全部七层,要视具体通信的类型而定,有的甚至只需要双方对应的某一层即可。如物理层中的物理接口之间的转接,以及中继器与中继器之间的连接就只需在物理层中进行即可。而网络层中的路由器与路由器之间连接则只需经过自网络层以下的三层即可。

经验之谈 无论哪一种计算机网络体系结构,也无论是体系结构中的哪一层,都不是针对具体的设备或者具体的软件而言的,而只是针对每层中所要实现的网络服务功能来划分的。因为每一层所代表的是一组网络功能,而实现某一个功能又可以有许多不同的软/硬件方案。如物理层上就可以有许多不同的传输介质(如同轴电缆、双绞线、光纤等)和网络设备(如集线器、中继器),当然还有许多对应的通信协议。其他各层也一样。计算机网络中的软/硬件是计算机网络通信和数据传输的实体,也就是网络任务的具体执行者。当然各层的实体都不一样,具体将在后面对应章节介绍。

有了这样一个结构模型,就把整个计算机网络软、硬件技术和设备串起起来了,所有软、硬件技术都围绕在这个中心周围。OSI/RM对各个层次的划分遵循下列原则:

❏同一层中的各网络节点都有相同的层次结构,具有同样的功能。

❏同一节点内相邻层之间通过接口(可以是逻辑接口)进行通信。

❏七层结构中的每一层使用下一层提供的服务,并向其上层提供服务。

❏不同节点的同等层按照协议实现对等层之间的通信。

❏网络设备(不包括计算机主机)间自身的通信仅需要低三层,用来构建数据通信的网络平台。网络平台构建好后,用户应用数据就可以利用这个平台进行各种网络应用通信,但所有网络应用通信都需要经过网络体系结构中的所有层次,其中最上面的四层用来为用户的网络应用通信提供各种服务支持,构建数据通信平台。

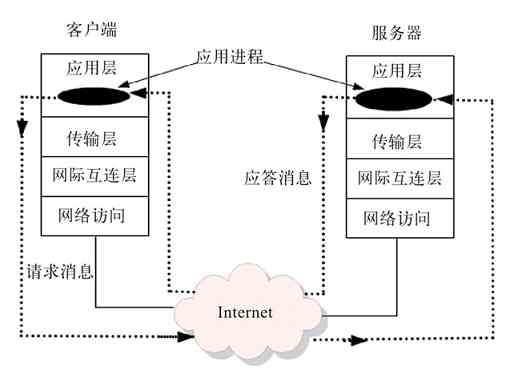

但是OSI/RM的七层结构划分从现在看来,并不是很科学,这主要表现在两方面:一是层次数方面还是多了些;二是在进行网络系统设计时仍然觉得比较麻烦。另外,像“会话层”和“表示层”单独划分的意义并不大,因为它们的用途并不像其他层那样明显。所以在后面的TCP/IP协议体系结构中,不再有这两层了。

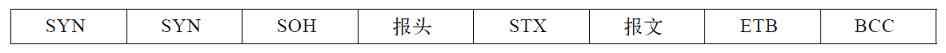

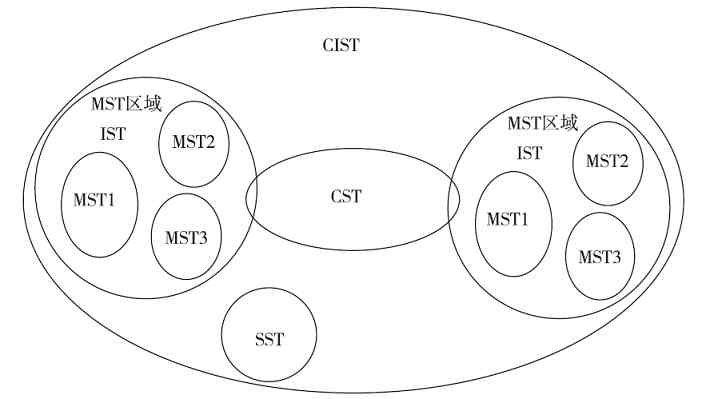

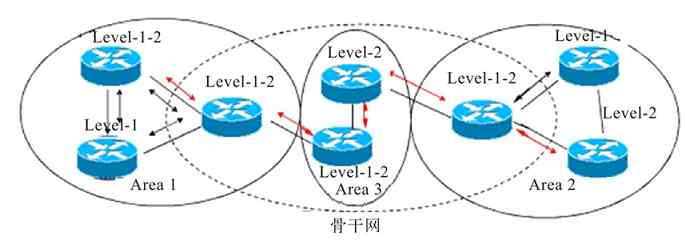

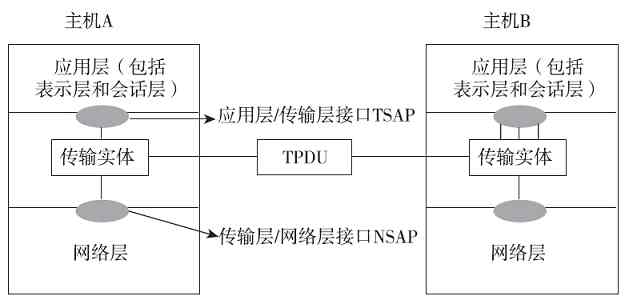

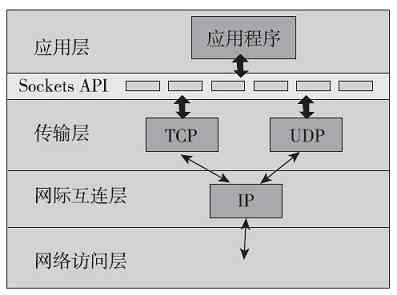

3.1.2 TCP/IP协议体系结构

TCP/IP协议体系结构(又称TCP/IP协议参考模型)是专门针对使用TCP/IP协议簇的广域计算机网络而开发的,可以说是OSI/RM的改进版本。但绝不能简单地认为是改进版,因为它与OSI/RM所针对的网络类型存在较大区别,所以这两种体系结构中各层所采用的通信协议,以及功能实现原理上都存在非常大的差异。这一点,在后面章节中都会有相应的体现。现在我们常用的通信协议,绝大多数都不是很适用于OSI/RM,而是适用于TCP/IP协议体系结构,因为它们都是应用于TCP/IP网络中。

TCP/IP协议体系结构起源于20世纪60年代末,首先由美国国防部高级研究规划署(Defense Advanced Research Projects Agency,DARPA)作为其研究的一部分,所以又称DARPA参考模型。不仅广域网鼻祖ARPANET使用的是TCP/IP协议体系结构,现在使用最广的Internet也是基于这一模型设计的,因为目前的Internet基本上都是采用TCP/IP协议簇的,包括我们企业内部局域网。

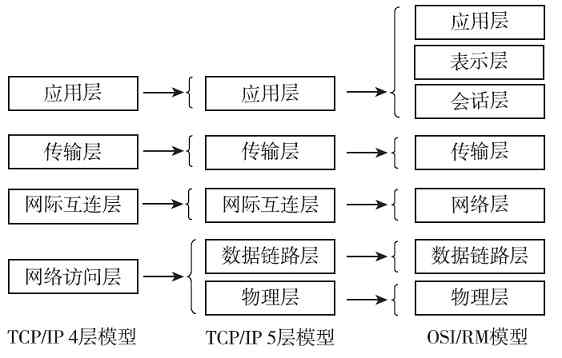

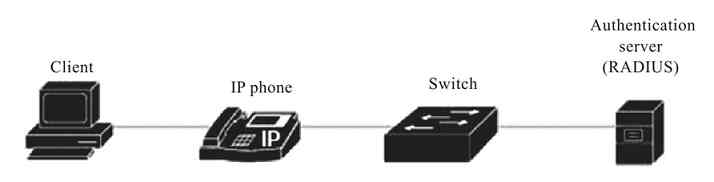

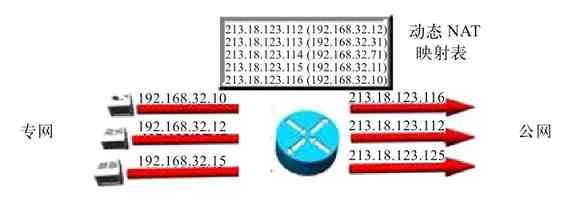

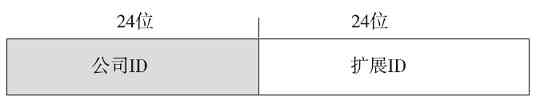

TCP/IP协议体系结构只划分了四层,从高到低分别是:应用层(Apllication Layer)、传输层(Transport Layer)、网际互连层(Internet Layer,又称互联网层)和网络访问层(Network Access Layer,又称网络接入层、网络接口层或者主机-网络层)。虽然只有四层,但它却包含了OSI/RM中的所有七层的功能,同样包括了局域网和广域网通信所需要的全部功能。图3-4描绘了TCP/IP协议体系结构与OSI/RM层次间的关系。

图 3-4 TCP/IP协议体系结构及与OSI/RM的比较

从图中可以看出,在TCP/IP协议体系结构中对原来OSI/RM的七层结构进行了进一步的简化,主要体现在以下两个方面:

❏把原来的“物理层”和“数据链路层”这两层结构合并为一层,即网络访问层,它提供局域网中的功能;

❏合并了原来OSI/RM中的最高的三层,成为新的应用层。因为事实上,在OSI/RM中会话层和表示层的功能都非常单一,完全可以合并到应用层之中。

其他两层,“传输层”与OSI/RM中的功能划分是一样的,而网际互连层也与OSI/RM的网络层实际上是一样的,只不过名称不一样而已。但要注意的是,这里仅是从功能划分上来说的,实际上这两个体系结构是存在相当大差异的。因为OSI/RM是开放型的标准,所以适用于所有类型网络设计参考,而TCP/IP协议体系结构是专门针对TCP/IP网络的,各种通信协议和功能实现原理更加具体。

总体而言,TCP/IP协议体系结构更加精简,更有利于网络系统的设计。但是其中网络访问层本身并不是实际的一层,包括了OSI/RM中的物理层和数据链路层这两层的功能,现在把它们其实合并不是很合理,所以现在通常认为如图3-5(其中与标准的TCP/IP协议四层模型和OSI/RM七层模型进行了对比)所示的五层网络体系结构才是最为科学、合理的。因为它综合了OSI/RM和TCP/IP协议两种体系结构的优点,同时克服了这两种体系结构的不足。本书也将以这种目前广泛建议的五层体系结构进行介绍。

图 3-5 广泛建议的五层网络体系结构

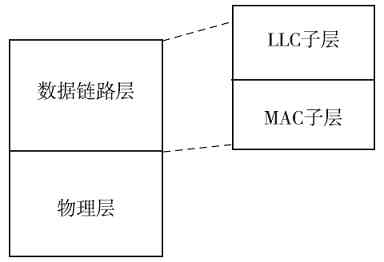

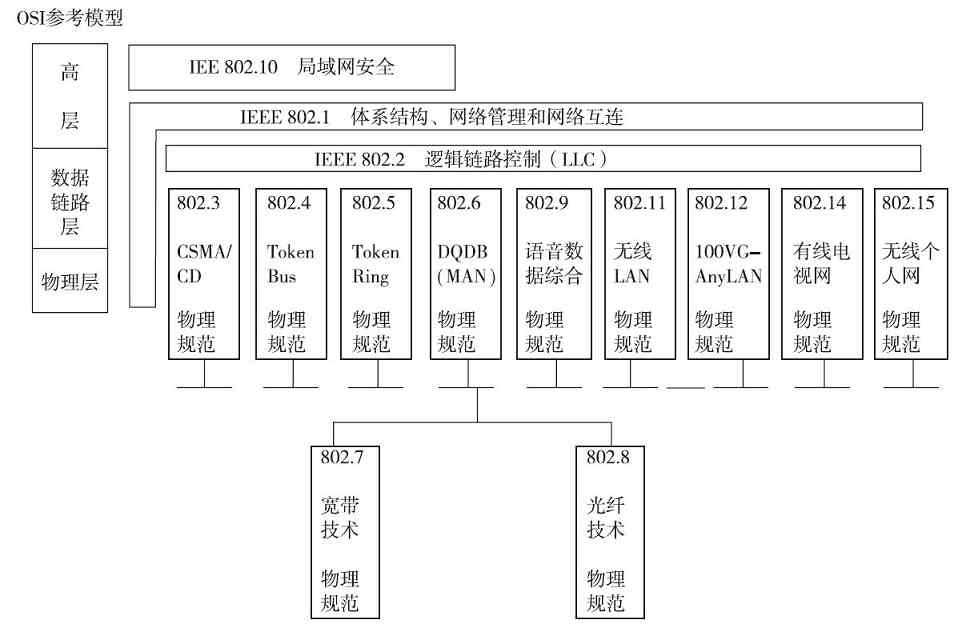

3.1.3 局域网体系结构

目前计算机局域网标准主要是由IEEE发布的,所以局域网体系结构也是由IEEE发布的。它针对有线以太网和WLAN无线局域网分别发布了体系结构,但IEEE也是参考了OSI/RM体系结构来设计局域网体系结构的,可以说是OSI/RM体系结构中专门描述局域网通信的最低两层,或者TCP/IP协议体系结构中专门描述局域网通信的最下面一层,针对以太网所进行的细化。当然其实这两种局域网体系结构从层次上来说是一样的,不同的只是其中各层的功能实现方法和所适用的通信协议不同。

1.有线以太局域网体系结构

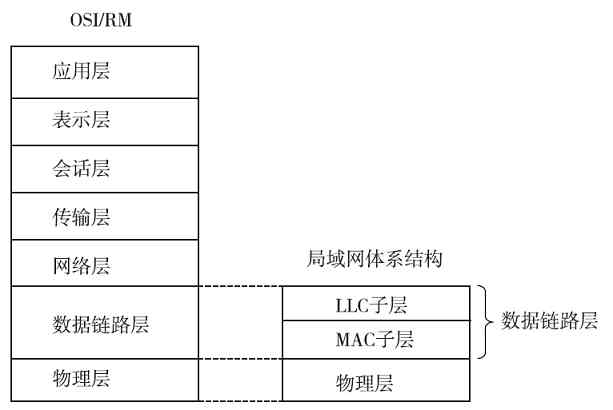

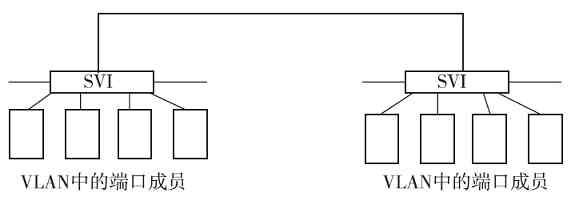

有线以太局域网体系结构是在IEEE 802.1A标准中定义的,如图3-6所示。从图中可以看出,它仅包括了OSI/RM的最低两层(物理层和数据链路层),因为局域网内部的通信只需要这两层。

图 3-6 IEEE 802.1A有线局域网体系结构

本节前面介绍的OSI/RM和TCP/IP协议体系结构可以说都是针广域网设计的,并不是局域网通信所全部需要的,这具体表现在两个方面:①在局域网中不需要路由寻址,所以也就不需要它们的网络层,或者说网际互连层;②传输层和应用层的功能是通过安装在计算机操作系统中的网络通信协议和一些具体网络应用软件来实现的,所以在局域网设备中也不需要这两层。

另外,又因为局域网(如以太网)通常是属于广播型网络,存在介质争用现象(广域网中通常是属于点对点网络,通常不存在介质争用),所以它在OSI/RM划分的物理层和数据链路层中又进一步对数据链路层进行了细分,将其分成了两个子层,即介质访问控制(Media Access Control,MAC)子层和逻辑链路控制(Logical Link Control,LLC)子层。其中的MAC子层就主要是用来解决介质争用和局域网内部寻址的。

IEEE 802.1A局域网体系结构中的物理层与OSI/RM和TCP/IP协议体系结构中的物理层功能是一样的,但仅支持IEEE 802系列局域网标准(如IEEE 802.3系列、IEEE 802.4、IEEE 802.5)中的物理层协议;MAC子层则主要是支持IEEE 802系列局域网标准中的载波监听多路访问(Carrier Sense Multiple Access,CSMA)、载波监听多路访问/冲突检测(Carrier Sense Multiple Access/Collision Detect,CSMA/CD)协议,以及把物理层的比特流封装成MAC子帧的功能;LLC子层主要支持IEEE 802系列局域网标准中的LLC子帧封装、链路控制和管理功能。这些都将在第6章具体介绍,在此不再赘述。

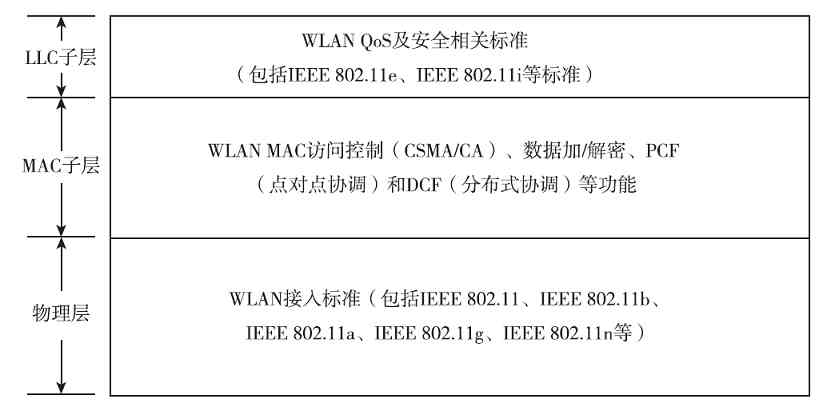

2.WLAN体系结构

WLAN也是局域网的一种,所以WLAN体系结构与上面介绍的IEEE 802.1A局域网体系结构是完全一样的(如图3-6所示),只不过因为两种局域网所用的物理层传输介质,以及相关数据链路层技术或协议不一样,所以在WLAN体系结构中的这两层中所包括的内容也不一样,具体如图3-7所示。有关的具体标准和技术将在第6章介绍。

图 3-7 WLAN体系结构中所支持的协议和标准

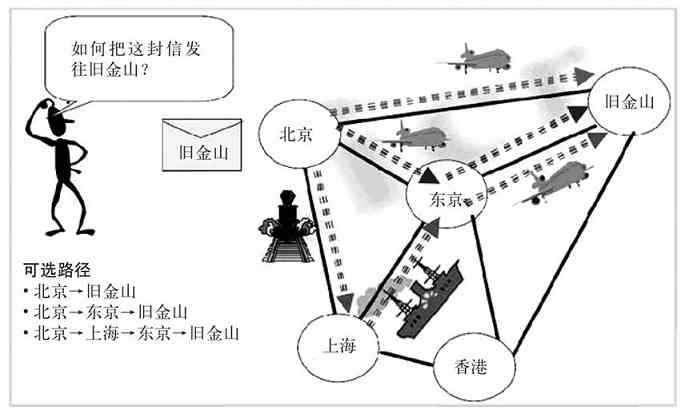

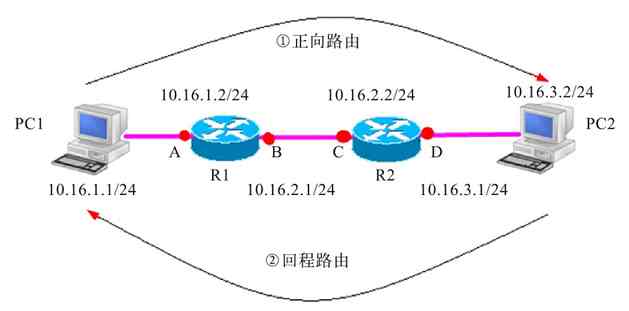

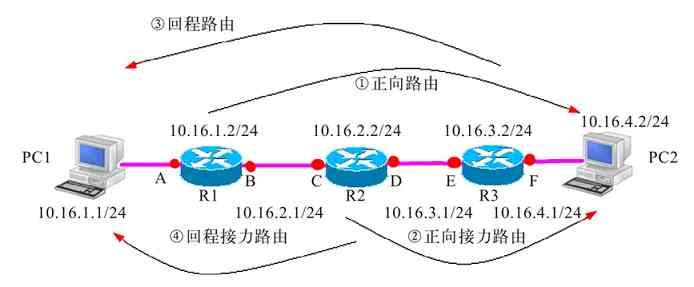

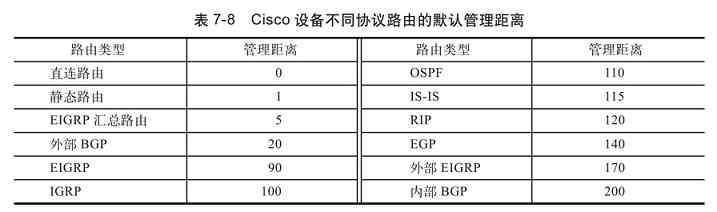

3.1.4 例说网络体系结构各层主要功能

本节将以最常见的生活事例来诠释OSI/RM计算机网络体系结构中各层的基本功能(其他体系结构对应层次的功能类似,参照即可),以便能使读者更加容易理解。当然或许里面有些比喻并不是很贴切,但只要对理解这些层次的功能有所帮助就达到目的了。

1.物理层

物理层是OSI/RM以及其他所有计算机网络体系结构的最底层,为所有网络/数据通信提供物理的通信线路。物理层是用来构建计算机网络通信和数据传输的通道的,相当于日常交通网络中的各种道路,如公路、铁路和航线,它们是我们出门旅行必须要依靠的基础设施。但物理层不是针对具体的传输介质、设备和通信协议的,因为它们可以有许多种选择(如传输介质中就可以有同轴电缆、双绞线和光纤等),只要能实现物理层的某种功能就行了。

不同的传输介质和设备选择,必须要有对应的通信协议支持,而且这也决定了不同的选择有不同的物理层性能。就像路有好多种一样,如有泥巴路、沙子路、水泥路、柏油马路、普通铁路、高速铁路等,这些不同的路可以承载的重量和速率都不一样。不同的路相连就形成了我们旅行途经的整条路径,同样,计算机网络中的不同物理层相连也构成了双方通信的整条路径。

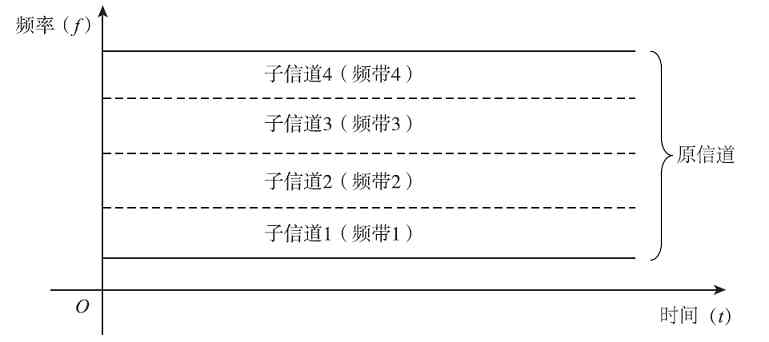

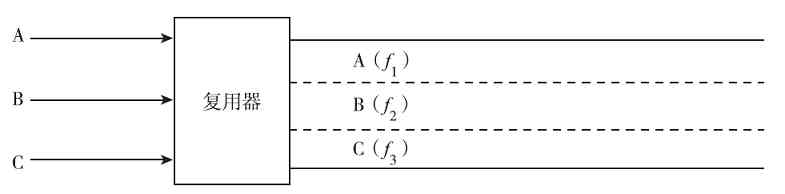

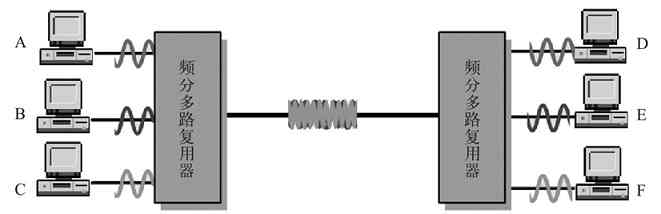

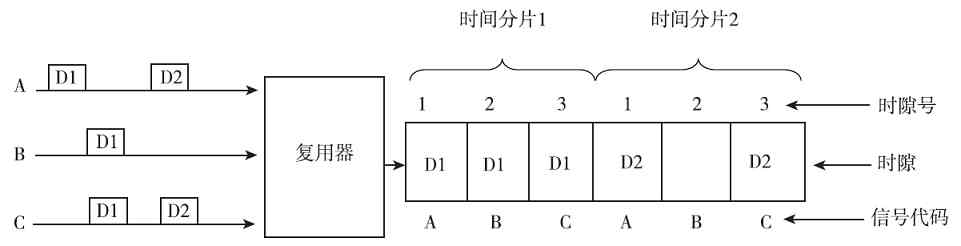

另外,我们知道在各种道路中都会划分许多车道的,在计算机网络体系结构中也有类似的“车道”,那就是我们通常所说的“信道”。信道的全称就是“信号传输通道”,默认情况下,一条物理线路就是一条信道,但也可以通过各种信道复用方式在一条物理线路中划分出多条信道。有关信道复用方式将在第4章介绍。

2.数据链路层

数据链路层为同一局域网内部的网络/数据通信提供点对点的数据传输通道,通过MAC地址寻址把数据转到目的节点,可以理解为我们的市内公路+交通法规。之所以只能理解为市内公路,是因为在各个网络中的数据链路层间的通信仅可以在同一网段内进行;之所以还要加上“交通法规”,是因为数据链路层所提供的不再是物理线路,而是在物理层的物理线路基础之上,通过数据链路层协议(相当于市内交通法规)构建的,可真正用于数据传输的虚拟数据传输通道,但这样的虚拟数据传输通道也只能在同一网段内进行数据转发。数据链路层仅为所到达数据在本网段内进行转发提供传输通道,要在不同网段间进行数据转发,还必须依靠下面将要介绍的网络层和传输层。

注意 链路可分为物理链路和逻辑链路。物理链路可以看成是在物理层中相邻结点间的那段线路,而数据链路则在物理链路基础上再封装上对应的数据链路层通信协议,是可以实现数据传输的逻辑链路。

3.网络层或网际互联层

OSI/RM中的网络层(或TCP/IP协议体系结构中的“网际互连层”)为不同网段之间的数据转发提供路径选择,通过IP地址(也可以是其他网络层地址,要视具体网络类型而定)把数据包转发到目的节点,可以理解为交通网络中的车站、机场、码头。这涉及一个选择下一站路径的问题,也就相当于我们要到某外地去旅行,到了车站、机场、码头后要选择乘坐哪趟车、哪趟飞机或轮船才能最快捷,成本最低。

网络层的这种寻址功能就是我们通常所说的“路由寻址”,就是选择哪条路径来到达下一个路由结点。通过不同的路径进行路由,在性能、成本上都可能不一样,就像我们选择不同的交通工具,或者不同线路旅行时的效率和成本都不同一样。网络层的功能就相当于连接不同网络的桥梁,仅起到在不同网络间转发数据包的作用,最终数据还是要在目的网络的数据链路层进行传输,在到达下一个网络结点设备(如路由器)时再进行路由、转发。

另外,就像我们到达另外一个城市又得遵照另外城市的交通法规一样,当我们的通信包到达另一个网络时,同时要遵照这个网络中的链路规则,也需要有相应的链路层协议来支持,以最终完成数据的传输。

4.传输层

“传输层”是在下面三层构建的网络平台基础上专门为通信双方构建端对端(不是点对点)的数据传输通道,使通信双方就像直接进行数据传输一样。这个端对端传输通道是可以跨网络的,这与数据链路层所构建的仅用于局域网内部的点对点传输通道是不同的。

传输层类似于国际航线,一条国际航线可能要经过几个国家,但国际航班飞机飞行时根本不用考虑经过了哪些国家的航线,因为这些事先在确立国际航线时就已处理好了,就像一条传输通道要经过几个网络不用管一样,因为网络层事先已准备好了通信路径。

5.会话层和表示层

这两层仅在OSI/RM中单独划分,而在TCP/IP协议体系结构中是没有这两层的,那是因为TCP/IP协议是专门针对TCP/IP协议类型网络而开发的体系结构,不存在其他网络类型,所以不需要表示层,会话层的作用因为太单一,所以合并到了应用层中。

会话层为具体的用户应用建立会话进程(每个应用都有一个会话进程),这个过程是一个用户网络应用的协商过程,相当于车站、机场或码头中总调度人员所从事的调度工作。

表示层是对用户网络应用数据的具体解释,包括在网络通信时可采用的信息格式、可采用的加密方式,相当于车站、机场、码头中发送每一班次汽车、火车、轮船的具体文件,包括所采用的车型、机型、船型,以及所负责的运输公司、交接人员名单等内容。

6.应用层

应用层是用户进行具体网络应用的层次,是具体网络应用的体现者。应用层负责接受用户的各种网络应用进程的调用,相当于车站、机场和码头的负责人负责接受乘客运输的调度,确定具体班次的发送时间和要完成的任务。负责人一声令下,下面的所有相关工作人员都得围绕他的指令进行准备。应用层也一样,只要网络用户有需要,通过相应的网络应用软件就可以发出相应的指令,然后通过应用层相关的通信协议来接收,并向它的下面各层依次传达并使其执行具体的网络应用指令,进而完成整个网络应用任务。

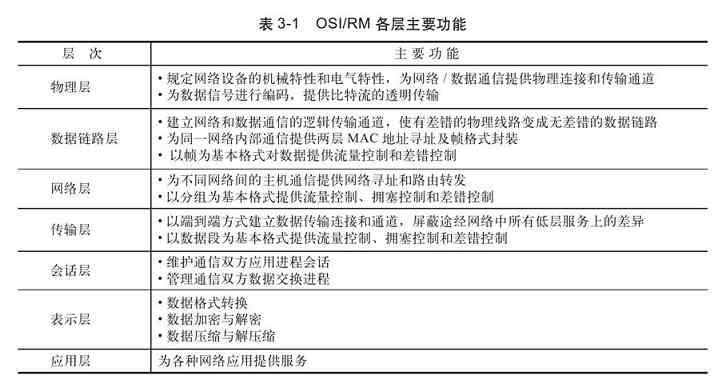

OSI/RM七层结构各层的主要功能如表3-1所示。

3.1.5 OSI/RM和TCP/IP协议体系结构的比较

TCP/IP协议体系结构是在OSI/RM基础上,专门针对TCP/IP网络而开发的体系结构,所以它既有OSI/RM的基本模型结构和层次划分思想,又针对了特定的TCP/IP网络,所以其更加具体化,更加具有可操作性。本节要具体介绍这两种体系结构的主要异同。

1.相同之处

总体而言,OSI/RM和TCP/IP协议体系结构主要具有以下几个方面的相同或相似点:

(1)层次结构划分思想相同

这两种体系结构都是以协议栈(不同协议形成的层次结构)为基础进行层次结构划分的,并且协议栈中的协议是彼此独立的。这样做的好处是,可以大大简化各种网络协议程序的设计,只需要为不同协议程序提供关联的程序接口即可。

(2)总体层次结构相似

在这两个体系结构中,虽然总的层数和对应层次名称都有所不同,但总体层次结构还是极其相似的。TCP/IP协议体系结构中的“网络访问层”对应了OSI/RM最低的“数据链路层”和“物理层”这两层,TCP/IP协议体系结构中的“应用层”对应了OSI/RM最高的“会话层”、“表示层”和“应用层”这三层,OSI/RM中间的“网络层”虽然与TCP/IP协议体系结构中的“网际互连层”在名称上不一样,但功能却是完全一样的,至于“传输层”,则两种结构都是完全一样的。而且在这两种结构中,“传输层”以下都属于“通信子网”部分,用来构建通信网络;而“传输层”及以上各层都提供了端到端的、与网络无关的服务,属于“资源子网”部分。

(3)核心组成一样

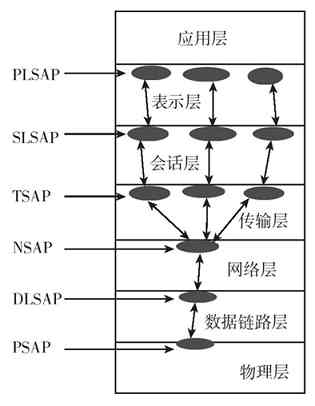

这两种体系结构中都定义了“服务”、“接口”和“协议”三个重要核心。

“服务”也就是后面各章所说的“服务原语”,定义了各层应该做些什么,要提供哪些功能,但没有定义本层该如何工作,以及上一层该如何访问本层。

“接口”也就是后面各章所说的SAP(服务访问点),为对应的上层提供了获取本层服务的逻辑接口,规定了有哪些参数可以使用,以及使用这些参数的结果是什么。

“协议”也就是标准中所说的“通信规程”,它是各层服务功能的具体实现者。当然同一服务在不同网络中可以用不同的协议来实现。各层中的协议各自实现自己的功能,并不影响其他层,任何的一层都只为相邻的上一层提供服务。

2.不同之处

在看到OSI/RM和TCP/IP协议体系结构的相似之处的同时,也要看到这两种体系结构的许多不同之处。两者的不同之处主要表现在:

(1)适用范围不同

OSI/RM在标准化协议发明之前就已产生了,所以OSI/RM不偏重于任何特定的网络类型,具有最广泛的理论上的参考性,是一个理想化的模型。而TCP/IP协议体系结构则相反,它是在TCP/IP协议簇先出来了(而且仅适用于TCP/IP类型网络)后,再针对这些协议进行功能分层和描述的,所以与协议的关系非常紧密,两者的吻合得非常好,最具实践性。

(2)层次结构不同

这两种网络体系结构在层次划分上的不同主要体现在:TCP/IP协议体系结构中没有“会话层”和“表示层”,因为事实已证明这两个层次并没有多大用途,即使在OSI/RM中也一样,所以最后取消了,它们的功能合并在“应用层”之中。

另外,OSI/RM中的“物理层”和“数据链路层”的功能在TCP/IP协议体系结构中合并到了“网络访问层”中,尽管实际上在TCP/IP协议体系结构中对这个层中的具体功能并没有明确规定,但实际上这层功能就是OSI/RM最低的这两层的功能。当然,这也是大家普遍认为TCP/IP协议体系结构层次划分中不科学的一个重要方面。

(3)支持的网络通信模式不同

OSI/RM的网络层同时支持无连接和面向连接的网络通信(它不仅支持TCP/IP协议网络中无连接的IP网络协议,同时支持NetWare SPX/IPX网络中的面向连接的SPX服务等);TCP/IP模型的网络层只提供无连接的服务(因为它只支持IP这种无连接的网络层协议)。

(4)所包括的通信协议不同

OSI/RM是一种开放型的,希望尽可能适用于所有类型计算机网络的理想化体系结构模型,所以它里面所包括的通信协议不仅非常多,且类型非常复杂,适用于各类网络的都有。但是,由于现在网络系统设计者通常不是参考OSI/RM,而是以目前占据了绝大部分市场的TCP/IP体系结构作为体系结构设计参考,所以现在OSI/RM中的许多通信协议都已过时。尽管TCP/IP网络也在OSI/RM的设计范围内,但现在TCP/IP网络中的通信协议是专门针对具体的TCP/IP协议体系结构而开发的,所以更具有TCP/IP协议体系结构的特点,而且这些通信协议在不断改进,非常适用于目前广泛应用的TCP/IP网络。

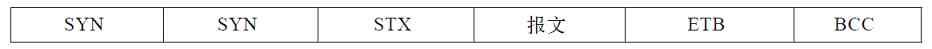

3.2 计算机网络体系结构通信原理

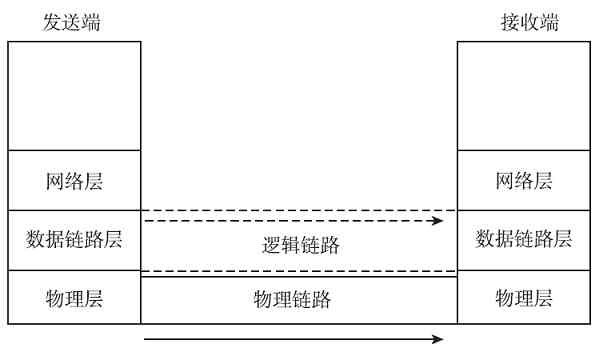

无论是以上哪种计算机网络体系结构,在通信原理上它们都有着两个相同的方面:一个是在网络连接和数据传输流程方面,发送端是自上而下(也就是从高层到低层),接收端是自下而上(也就是从低层到高层)进行的,也就是数据通信原理相同。另一个是通信会话方面,双方都必须是逻辑上的对等层次,也就是对等通信原理相同。如发送端的网络层只能与接收端的网络层通信,而不能直接与数据链路层或者与传输层进行交错通信。其他的层次也是一样的。下面分别予以介绍。

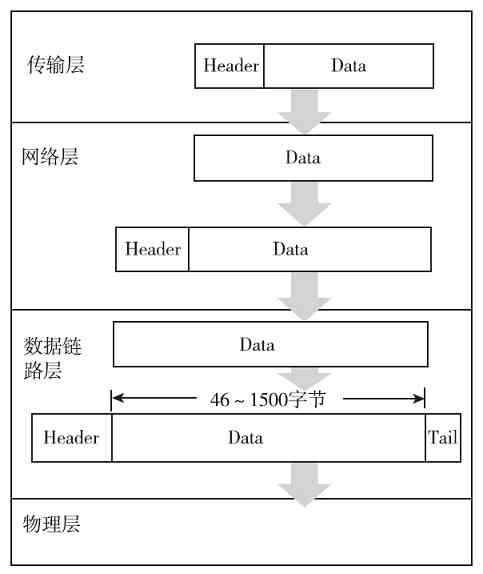

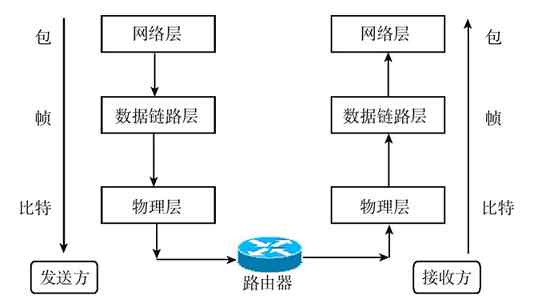

3.2.1 网络体系结构的数据通信原理

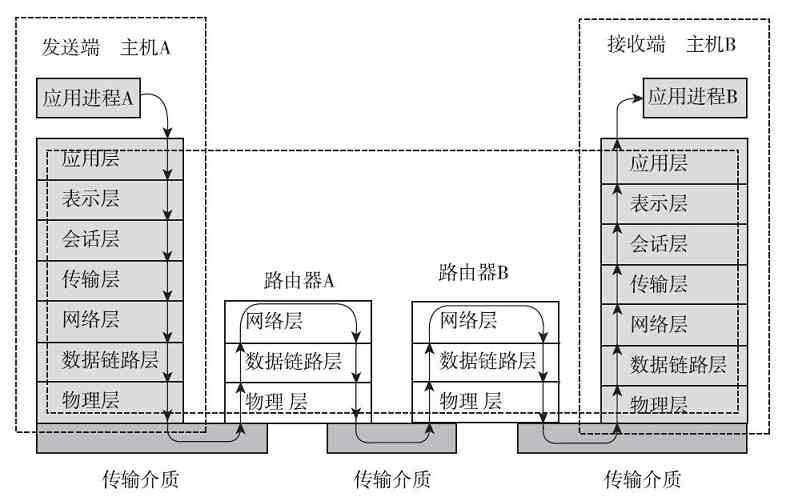

在各种计算机网络体系结构的网络连接建立和数据传输的流程中,发送端是把通信连接建立指令和用户应用数据从上层向下层传输的,直到最低的物理层;而接收端是把通信连接建立指令和用户应用数据从下层(从最低的物理层开始)向上层传输的,直到与发送端发起通信的对等层。图3-8所示的是OSI/RM情形下数据的传输流程,其他体系结构的数据传输流程与此类似,只是数据传输中流经的层次上有些区别。

图 3-8 OSI/RM数据通信原理示意图

其实这也很好理解,毕竟网络通信连接和数据传输都不能凭空建立或进行。它必须通过计算机网络中最基础、也是网络体系结构中的最低层——物理层,通过传输介质来传递各种通信连接建立信号和数据。但在进行具体的数据传输前,必须先建立好相应的连接。建立的连接可以是永久连接(如局域网中的连接和广域网中的各种专线连接),也可以是非永久连接(如各种拨号连接和串行线路)。就像我们上互联网都要拨号连接(专线连接的除外),打电话我们首先也要拨号一样。再如,当我们要运输货物到外地,首先得找好运输货物的路径,联系好接收货物的人,在对方确认可以收货后才可以发货,否则路都不知道怎么走,对方都不想要这批货物,怎么能发货呢?

计算机网络体系结构中的这种源端自上而下,目的端自下而上的通信连接建立和数据传输流程,与我们在公司中安排、完成一个具体任务的流程是一样的。

现假设A公司的总经理要与B公司的总经理签个协议,一般是按照按如下流程进行的:

1)A公司总经理把这个要求向他的某下级部门经理交代;

2)该部门经理又会把这项具体的任务交代他下面的某个负责这方面工作的员工,让其做好相应准备;

3)具体负责的员工与对方公司取得联系。

B公司的执行流程与A公司的正好相反,因为这个任务请求最先是由B公司下面负责具体联系工作的员工收到的。在他接收到A公司的这个请求后,会向他的直接上级部门经理反映,再后这个部门经理又会把这个请求向B公司总经理反映。B公司的总经理还可能要根据具体的工作任务安排具体的签协议日程,然后把这些信息依次向下反馈到公司中具体负责这方面的工作人员,再与A公司的具体工作人员沟通,A公司人员接到B公司的这些信息后,又要依次向上传达到A公司的总经理。在这个流程中可能要经过多次反复,最终完成A公司总经理与B公司总经理整个签协议事件的信息下达(在A公司)、上传(在B公司)任务。接下来的事,就是两家公司总经理之间的事了,剩下的事就相当于本节后面要介绍的通信会话原理。

3.2.2 网络体系结构的对等通信原理

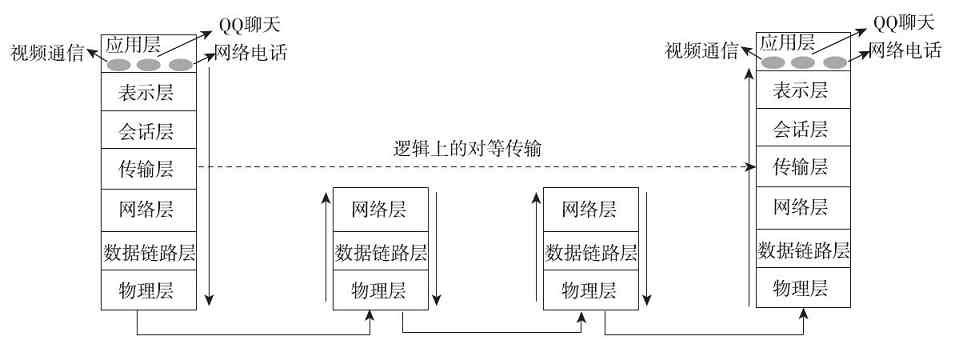

通信双方的网络连接建立好后,就可以进行各种具体的网络应用和网络通信了,但这时的通信是建立在双方对等层次上的,也就是我们通常所说的“对等层”(peer layers)通信原理。进行对等通信主要出于两方面的考虑:一方面是因为只有双方是对等层次的会话才可能使用相同类型的协议,彼此才能“听得懂”,才能有“共同语言”;另一方面是因为在网络体系结构中,每一层都是独立完成自己工作的,其他层都是不干预,不了解的。如一方的物理层只能与对方的物理层直接通信,不可能直接跳到与对方的“数据链路层”或其他层进行对话。同理,一方的网络层只能与对方的网络层通信,一方的传输层只能与对方的传输层通信,以此类推。只有“物理层”之间的会话才是直接的,其他各层之间的会话都是逻辑意义上的,如图3-9所示(注意其中的虚线)。

图 3-9 OSI/RM对等通信原理示意图

注意 尽管必须遵守对等通信原理,但最终的数据通信流程还是要经过发起会话通信的层次的下面所的其他层次的,只不过,在具体的通信过程中,对于用户来说,下面各层是透明的,在网络连接建立好后,我们并不需要了解下面各层的工作情况。所以我们在进行具体的网络应用(如文件传输)时,似乎是直接把文件传给了对方。

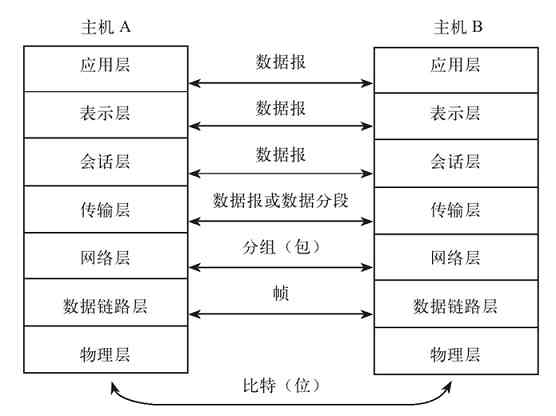

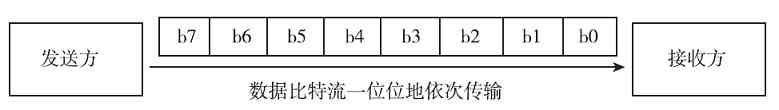

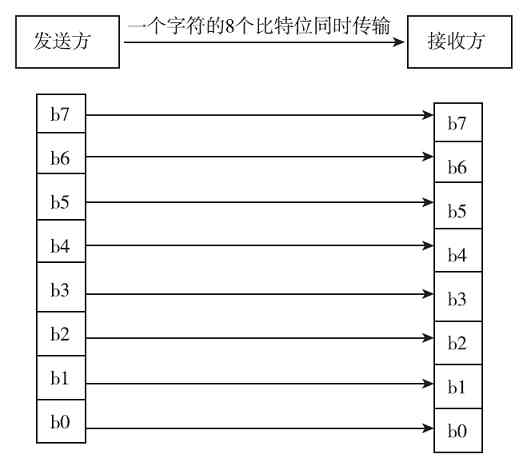

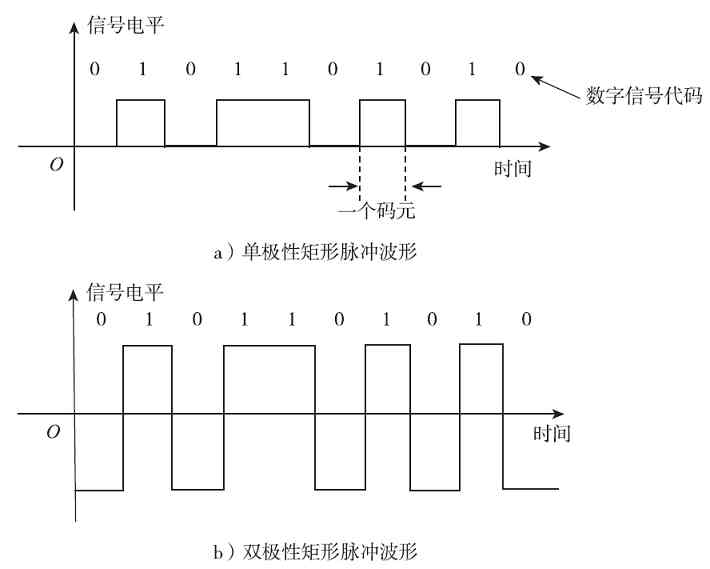

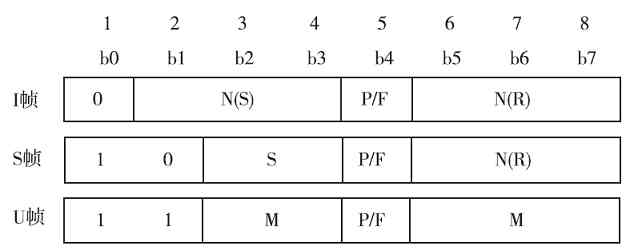

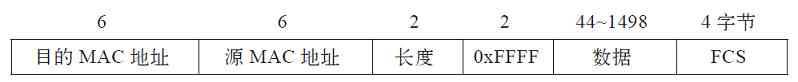

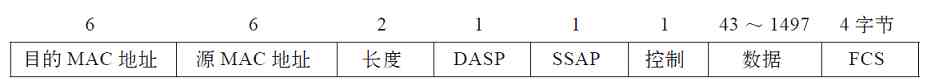

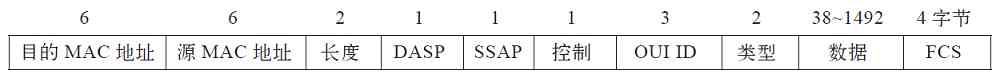

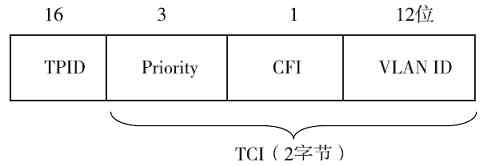

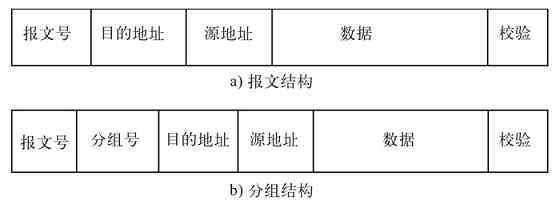

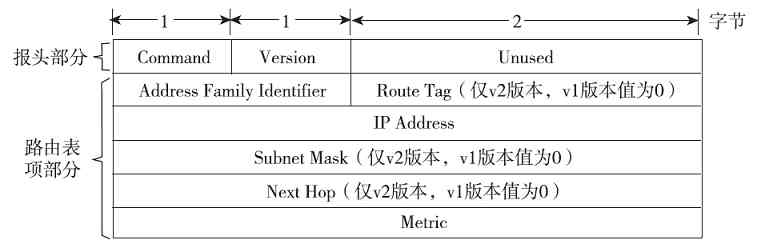

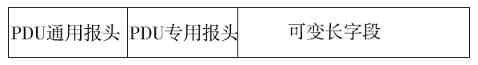

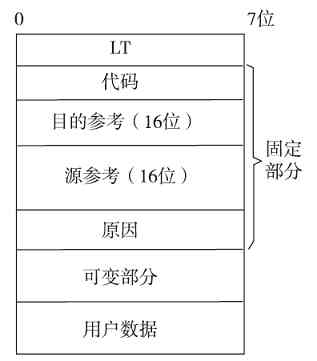

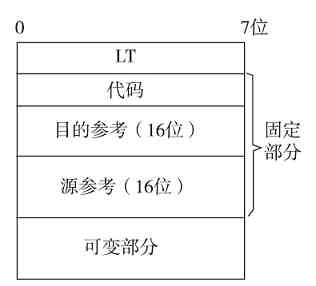

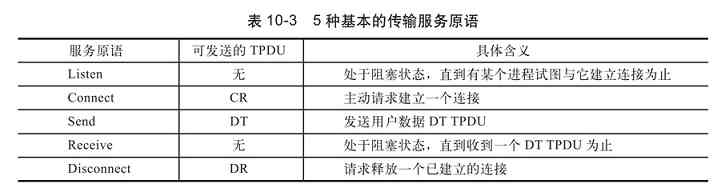

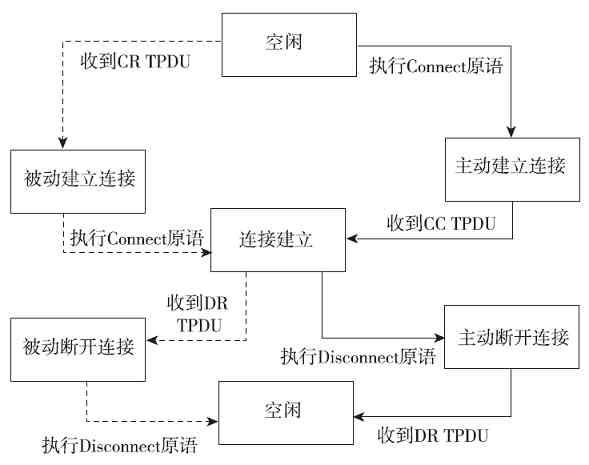

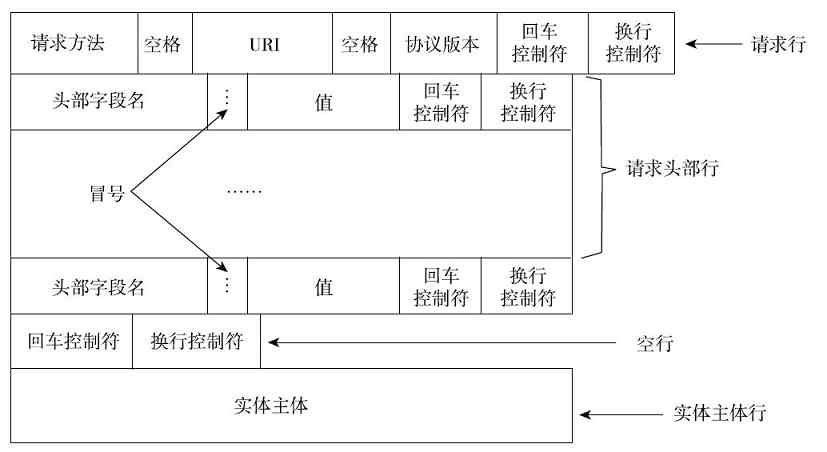

(1)各层上传输的数据格式

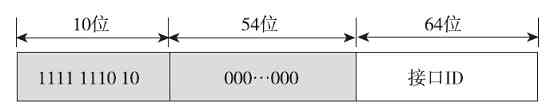

对等层之间传送的数据单位称为PDU(Protocol Data Unit,协议数据单元)。不同层的PDU所包括的内容和格式也不一样。这就要涉及各层传输的数据格式问题了。

在各种网络体系结构中的每一层传输的数据格式,或者说协议数据单元(PDU)是不一样的,具体如下:

❏“物理层”是以最原始的“比特”(bit)流格式传输的,或者说物理层的PDU就是“比特”。

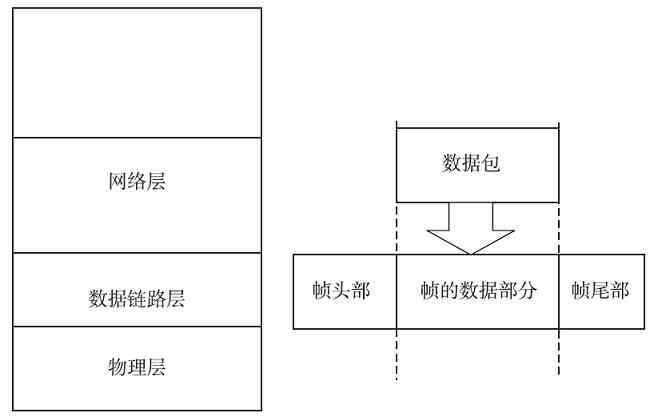

❏“数据链路层”的传输单位是“帧”(frame),一个帧包括多个比特,但一个帧的大小必须是一个整数字节。不同协议的帧大小也不一样。一个帧其实也就是一个DPDU(数据链路协议数据单元)。

❏“网络层”的传输单位是“分组”(或者“包”,paket),一个分组又可以包括多个帧,分组大小也要根据不同协议而定,一个分组其实也就是一个NPDU(网络协议数据单元);

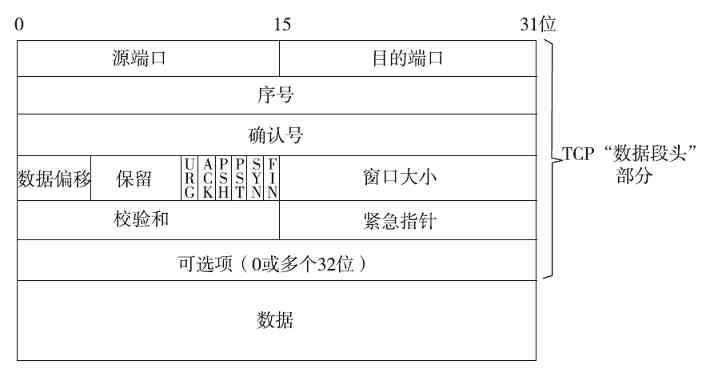

❏传输层比较特殊,OSI/RM体系结构中是直接以TPDU(传输协议数据单元)为单位的,而在TPC/IP协议体系结构中,TCP是以数据段(segment)为单位进行传输的,UDP是以数据报(datagram)为单位进行传输的。

❏在会话层、表示层和应用层中是以具体的数据报文为单位进行传输的。

以上各层的数据传输单位如图3-9所示。如果是其他网络体系结构(如TCP/IP协议体系结构、局域网体系结构),各层上传输的数据格式也是一样的,不同的只是少了一些层次而已。

(2)协议头和协议尾的封装

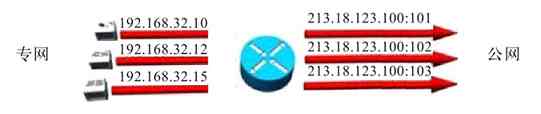

在整个数据传输过程中,数据在发送端时经过各层时都要附加上相应层的协议头和协议尾(仅数据链路层需要封装“协议尾”)部分,也就是要对数据进行协议封装,以标识对应层所用的通信协议。

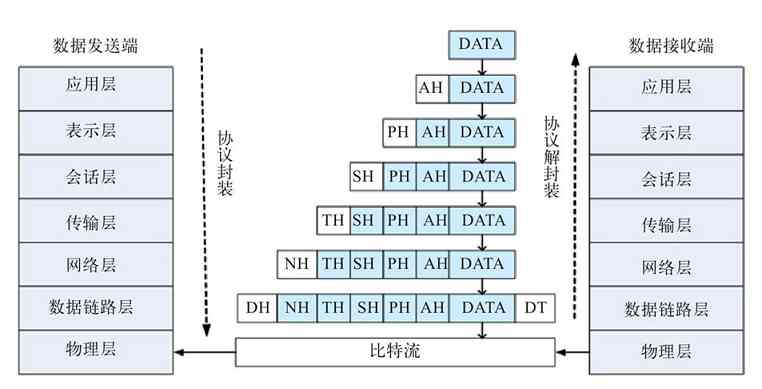

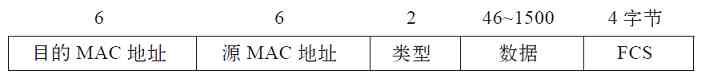

“协议头”是用来封装本层PDU的,“协议尾”则代表本层封装的结束。如在我们常见的以太局域网中传输的帧都会封装对应的数据链路层——以太网协议,其中就包括MAC子层协议头和LLC子层协议头,具体将在第6章介绍。图3-10中左边箭头所示的顺序就是OSI/RM各层的数据封装流程,其中的AH为应用层协议头,PH为表示层协议头,SH为会话协议头,TH为传输层协议头,NH为网络层协议头,DH为数据链路层协议头(物理层为最低层,传输的是最小单位的bit(比特),不需要再进行封装,所以没有“物理层头”),DT为数据链路层协议尾。

在数据的接收端,数据是由低层向高层传输的,这样当数据到达某一层后,就会去掉对应下层的协议头和协议尾部分,这个过程就是一个解封装的过程,是前面协议封装的逆过程,如图3-10中右边箭头所示的顺序。因为上层并不需要了解它的下层服务,所以当包或帧送到某一层时就会把用来标识它下一层的协议头和协议尾去掉,还原该包或帧在发送端对应层时的包或帧内容。其实加上协议头的作用可以理解为在发送端要一层层地加上一个指明到达下层地址的信封,而在接收端则要一层层地拆开信封,以获取向上层传输的地址信息,使数据能继续向上层传输。

图 3-10 OSI/RM各层数据封装流程

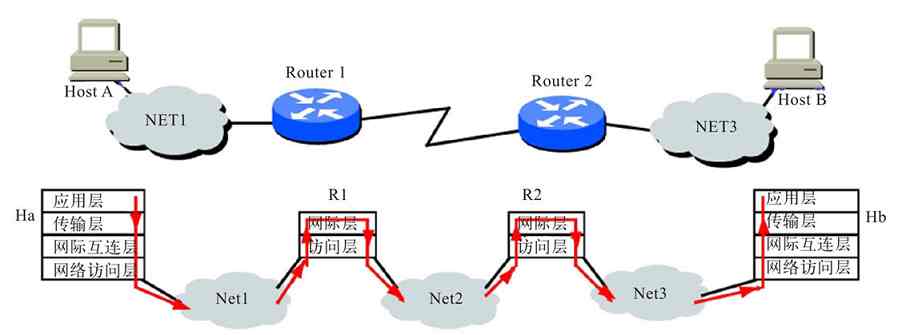

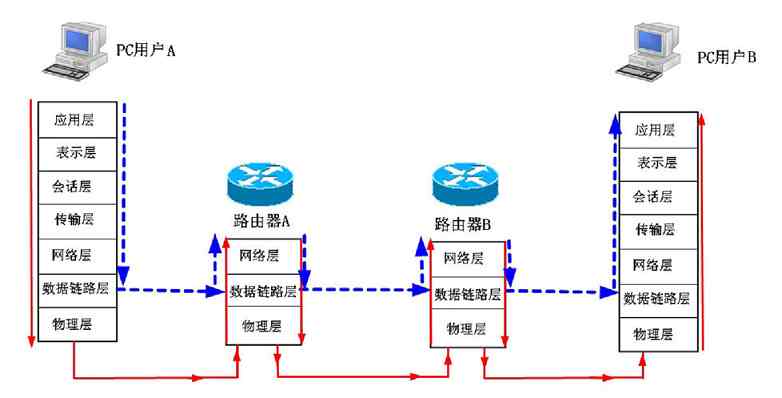

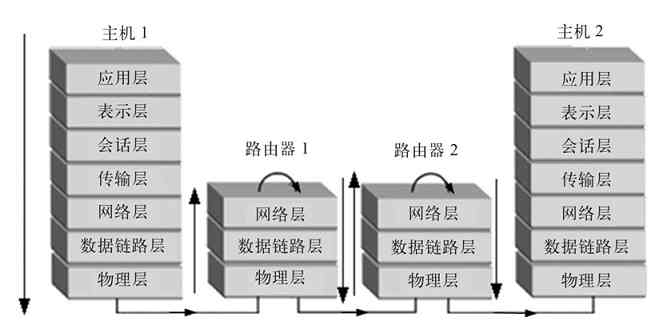

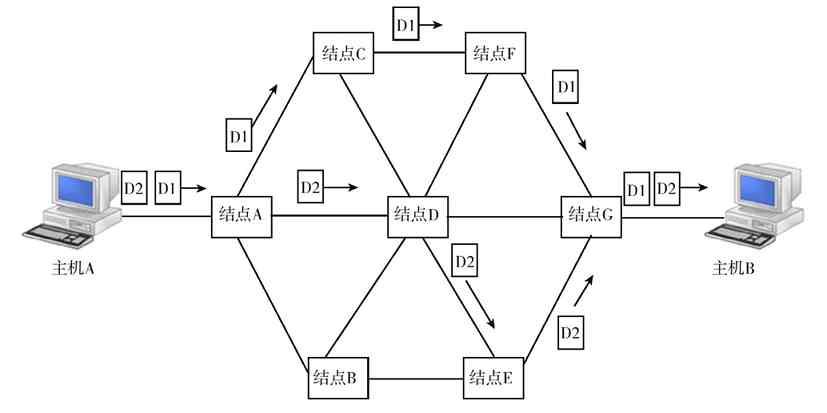

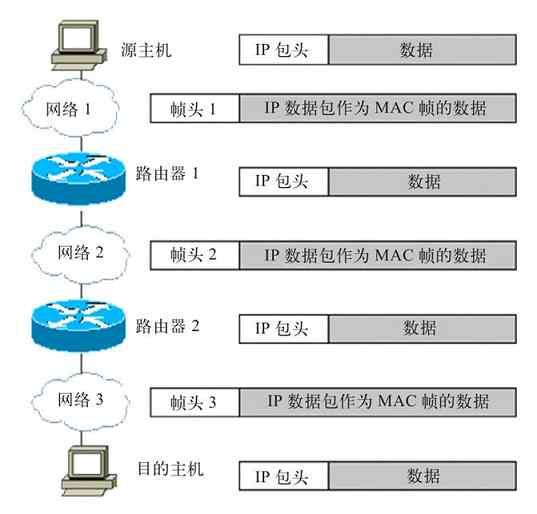

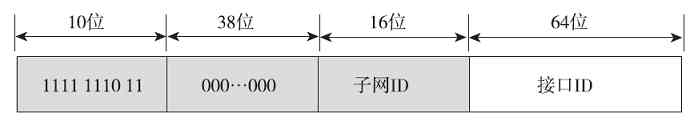

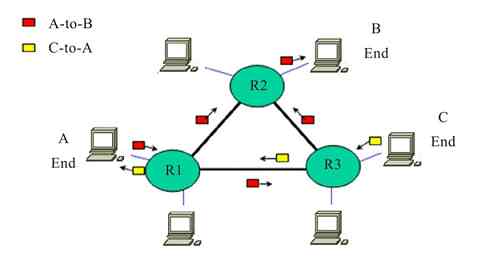

TCP/IP体系结构中的数据封装和通信原理与OSI/RM类似,只不过没有OSI/RM这么多层次。图3-11所示的是两个中间隔了两个网段的主机(Ha和Hb),在TCP/IP网络中的基本通信流程(注意箭头的方向,假设通信是由Ha主机发起的)。

图 3-11 TCP/IP网络中的数据通信流程示例

总体来说,在各计算机网络体系结构的基本通信过程中,数据在发送端是自上而下传输的,而在接收端是自下而上传输的,整个通信过程必须依次经过通信发起层及以下各层,且不能跨越。但是各层只能与对方的对应层进行通信,不能出现错位。

3.3 网络体系结构的设计考虑

无论哪种网络体系结构,在设计时都不是随意的,而是经过无数专家学者充分认证和谨慎考虑得出的。我们只有在理解了设计者的设计思想后,才能更好地理解并在实际的网络系统设计、网络故障排除中应用这些设计思想。

3.3.1 网络体系结构中的层次划分依据

“网络体系结构”是一种概念上的蓝图,描述了整个网络的层次结构和基本的数据通信规则。实际上就是描述了整个网络中两个节点间实现有效通信的所有过程,然后将这些过程划分为逻辑上的组,而这些组就是网络体系结构中所说的“层”。

1.网络体系结构的设计考虑

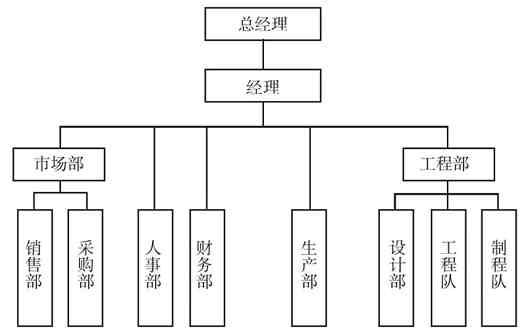

网络体系结构设计时的考虑其实与一个公司在设计组织架构时要考虑整个公司的生产、经营流程应该怎样更有效是一样的(图3-12所示的是一家小型生产企业的典型组织架构)。在为新公司设计组织架构时首先会考虑这家公司的经营性质,在经营过程中要完成哪些任务,而这些任务应该由谁来完成,按什么顺序完成。这里的“谁”不是指具体的人,而是后面要设计的各个职能部门。这里的部门就相当于我们所讲的网络体系结构中的“层”。在公司中,为了保证工作的顺利进行,每个部门内部的员工自然是紧密配合相互协调的,但任何一个部门都不可完全独立地工作,因为它们只是整个公司组织的一部分,必须要与其他部门协同工作。所以各部门都要有负责与上、下级部门之间沟通的负责人,这就相当于网络体系结构中的层与层之间相互通信的逻辑接口,称之为SAP(访问服务点)。

图 3-12 典型生产型企业的组织架构示例

既然计算机网络体系结构是分层的,那么不同层次之间必定有一个高低之分。注意,这里所讲的层次高低并不是从管理角度来理解的,可以说是仅从通信流程,或者说是服务调用关系上来划分的,主要是“谁先谁后”的问题。就像在设计公司组织架构时要考虑命令上传、下达执行部门的先后次序一样。在各种计算机网络体系结构中,不同层次之间并不存在管理与被管理,只有通信流程角度上的先后次序,当然下层是为上层服务的。这就与工厂生产流水线的各个工作岗位只有先后次序之分,没有管理与被管理之分的道理是一样的。

2.网络体系结构中的层次划分

为什么要划分层次?其实原因很简单的,就是想把一个难以实现的复杂问题分解成多个容易实现的小问题。这在我们学习时也一样,要真正把计算机网络专业学好不是件简单的事,要学的知识和技能太多,涉及面太广。如果没有一个全局的观念,不采取分模块学习方法,是很难学得系统、学得全面的。学习时,如果我们把要学的知识和技能分成一个个比较小的模块,然后采取“个个击破”的方式进行学习,就可以比较快地全面掌握计算机网络专业所需学习的知识和技能。

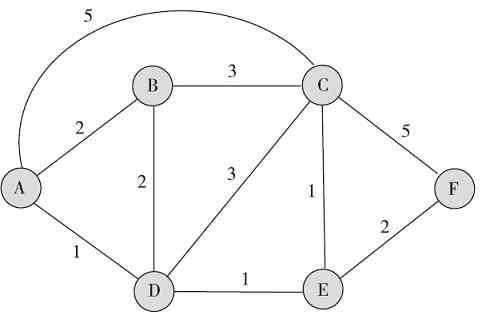

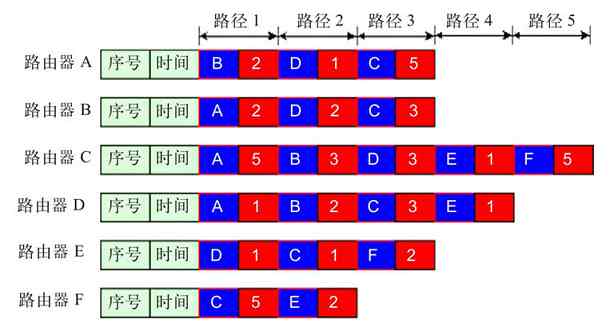

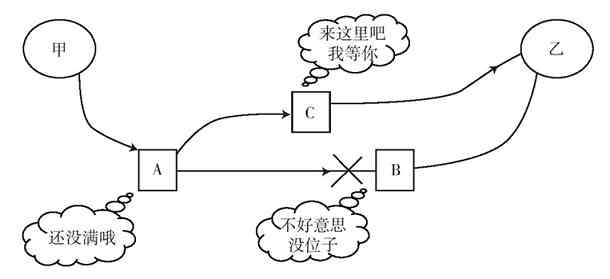

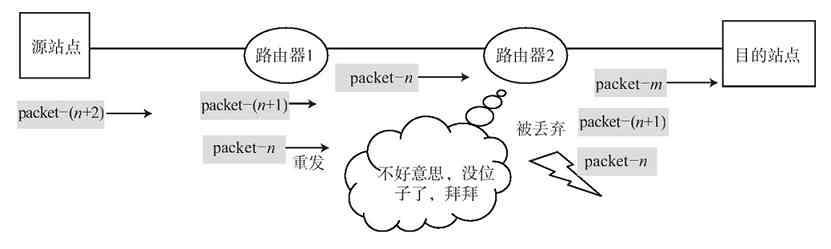

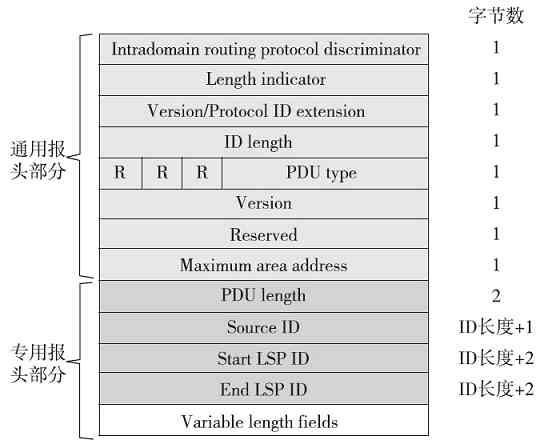

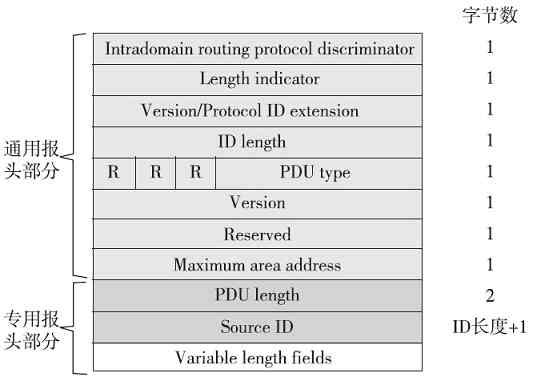

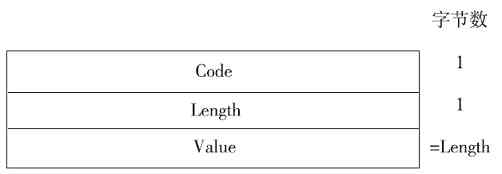

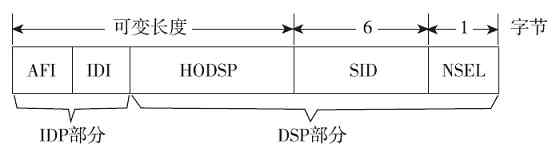

OSI/RM是第一个标准化的计算机网络体系结构,划分了七个层次;随后IEEE又在其颁布的IEEE 802.1标准中发布了专门针对局域网的体系结构,也有专门针对无线局域网(WLAN)而发布的IEEE 802.11标准又定义了WLAN的体系结构,它们都只划分了两个层次;而最开始应用于ARPANET,随后成为事实上的当前Internet体系结构标准的TCP/IP协议体系结构划分了四个层次。这些不同网络体系结构的具体层次将在本章后面具体介绍,但由此仍然可以看出,不同网络体系结构所包含的层数不一样,这主要是因为在不同网络中实现网络通信所需要的功能不一样。但无论是哪种体系结构,都直接或间接地包括了最低的两个层次,那就是“物理层”和“数据链路层”,因为这是所有网络通信的基石和物理通道。这些体系结构中的具体层次将在本章后面具体介绍。