译者序

Andrew S.Tanenbaum教授写作的《现代操作系统》,无论是英文版还是中文版都受到了中国读者的欢迎。究其原因,该书内容丰富,反映了当代操作系统的发展与动向。这次出版的第3版,无疑在保持原有特色的基础上,又有所发展。

第3版的一个很大变化是,大大加强了对操作系统中许多抽象概念的叙述,包括CPU到进程的抽象、物理内存到地址空间(虚拟内存)的抽象以及磁盘到文件的抽象等。Tanenbaum教授在《现代操作系统》前两版中,在这一方面确实着墨不多。译者在翻译该书前两版的内容时,就对此有些疑问,似乎Tanenbaum教授的讲授方法与众不同。这是因为,在国内许多院校的操作系统教学过程中,授课教师非常重视对这些抽象概念的讲解和分析。而且据译者所知,在美国不少大学的操作系统教学过程中,也很重视对这些抽象概念的引入。译者认为,Tanenbaum教授在第3版中对有关操作系统基本抽象概念叙述方式的重大修改,是对《现代操作系统》内在质量的提升,将使第3版受到更多中国教师和读者的欢迎。

第3版的另外一个重大变化是,第10章、第11章和第12章是由另外三位作者贡献的,他们分别是美国佐治亚理工学院的Ada Gavrilovska博士、Microsoft公司的Dave Probert博士以及Hope学院的Mike Jipping教授。

第10章的贡献者Ada Gavrilovska博士在美国佐治亚理工学院的计算学院从事教学和科研工作,她具有多年讲授高级操作系统等有关课程的经验,是一位造诣很高的研究科学家。

第11章的贡献者——Microsoft公司的Dave Probert博士是译者的老朋友了。我们在编写机械工业出版社出版的《Windows操作系统原理》以及《Windows内核实验教程》等书籍的过程中,有过密切的合作。Dave Probert博士是Microsoft公司Windows操作系统内核的主要设计人员之一,他对操作系统的把握以及以设计师身份对Windows操作系统内核深入和广泛的认识,几乎无人可以比拟。Dave Probert博士写作了第11章,并指出哪些地方Microsoft做对了,哪些地方Microsoft做错了。正如Tanenbaum教授在前言中指出的:“由于Dave的工作,本书的质量有了很大提高”。

Mike Jipping教授是Hope学院计算机系的主任,具有长期的教学与科研经验。他早在2002年就出版了专著《Symbian OS Communications Programming》,对用于智能手机的Symbian操作系统有着深刻的理解,由他来写作有关Symbian OS的第12章,当然是再合适不过了。

本书还增加了许多新的习题,有助于读者深入理解操作系统的精髓。

本书的出版得到了机械工业出版社华章分社的大力支持,在此表示由衷感谢。

参加本书翻译、审阅和校对的还有桂尼克、古亮、孔俊俊、孙剑、畅明、白光冬、刘晗、冯涛、张旦峰、陈子文、王刚、张琳、赵敬峰、张顺廷、张毅然、荀娜、张晓薇、周晓云、李昌术等。此外,赵霞博士对一些名词术语的翻译提出了宝贵意见。在此对他(她)们的贡献表示诚挚的感谢。

由于译者水平有限,本书的译文必定会存在一些不足或错误之处,欢迎各位专家和广大读者批评指正。

译者 2009年5月

前言

第3版与第2版有很大的不同。首先,重新安排了章节,把中心材料安排到了本书的开始部分。对于操作系统这一各种抽象的创建者,给予了更多的关注。对第1章进行了大量的更新,引入了所有的概念。第2章涉及从CPU到多进程的抽象。第3章是关于物理内存到地址空间(虚拟内存)的抽象。第4章是关于磁盘到文件的抽象。进程、虚拟地址空间以及文件是操作系统所呈现的关键概念,所以与以前版本相比将这些章节安排在更为靠前的位置。

第1章在很多地方都进行了大量的修改和更新。例如,为那些只熟悉Java语言的读者安排了对C程序设计语言和C运行时模式的介绍。

在第2章里,更新和扩充了有关线程的讨论,以反映它们的重要性。另外,还安排了一节关于IEEE标准Pthread的讨论。

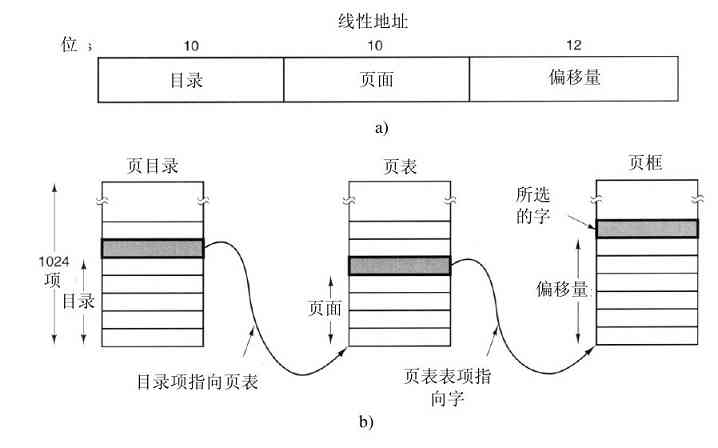

第3章讨论存储管理,已经重新进行了组织,用以强调操作系统的这一项关键功能,即为每个进程提供虚拟地址空间的抽象。有关批处理系统存储管理的陈旧材料已经删去,对有关分页实现的部分进行了更新,以便能够满足对已经很常见的大地址空间和速度方面管理的需要。

对第4章到第7章进行了更新,删去了陈旧材料,添加了一些新的材料。这些章中有关当前研究的小节是全部重新写作的。此外,还增加了许多新的习题和程序练习。

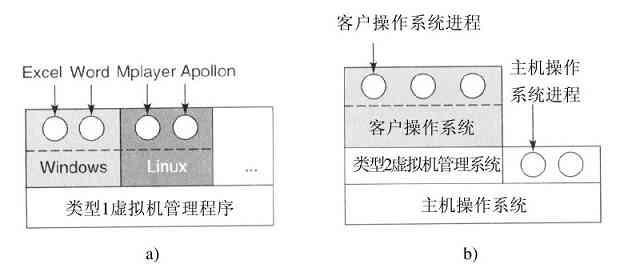

更新了包括多核系统的第8章,增加了关于虚拟技术、虚拟机管理程序和虚拟机一节,并以VMware为例。

对第9章进行了很大的修改和重新组织,纳入关于利用代码错误、恶意软件和对抗它们的大量新材料。

第10章介绍Linux,这是原先第10章(UNIX和Linux)的修改版。显然,本章重点是Linux,增加了大量的新材料。

涉及Windows Vista的第11章对原有的内容(关于Windows 2000)做了很大的修改,有关Windows的内容用最新的材料进行了更新。

第12章是全新的。作者认为,尽管嵌入式操作系统远比用于PC和笔记本电脑中的操作系统要多,但是,对于用于手机和PDA中的嵌入式操作系统,在很多教科书中还是被忽略了。本版弥补了这个缺憾,对普遍用于智能手机的Symbian OS进行了广泛的讨论。

第13章是关于操作系统设计的,第2版的内容多数都保留了。

本书为教师提供了大量的教学辅助材料,可以在如下网站得到:www.prenhall.com/tanenbaum。网站中包括PPT、学习操作系统的软件工具、学生实验、模拟程序,以及许多关于操作系统课程的材料。采用本书的教师有必要访问该网站。

这一版得到了许多人的帮助。首先最重要的是编辑Tracy Dunkelberger。Tracy对本书不仅尽责而且超出了其本职范围,如安排大量的评阅,协助处理所有的补充材料,处理合约,与出版社接洽,协调大量的并发事务,设法使工作按时完成等。她还使我遵守一个严格的时间表,以保证本书按时出版。谢谢Tracy。

佐治亚理工学院的Ada Gavrilovska是Linux内核技术专家,他更新了第10章,从UNIX(重点在FreeBSD)转向了Linux,当然该章的许多内容对所有的UNIX系统也适用。在学生中Linux比FreeBSD更普及,所以这是一个有意义的转变。

Microsoft公司的Dave Probert更新了第11章,从Windows 2000转向了Windows Vista,尽管两者存在着相似之处,但它们之间还是有很大差别的。Dave对Windows技术有深刻的认识,并足以指出哪些地方Microsoft做对了,哪些地方Microsoft做错了。由于Dave的工作,本书的质量有了很大提高。

Hope学院的Mike Jipping写作了有关Symbian OS这一章。如果缺乏关于嵌入式实时系统的内容,则会使本书存在重大缺憾,感谢Mike使本书免除了这个问题。在现实世界中,嵌入式实时系统变得越来越重要,本章对这方面的内容提供了出色的论述。

与Ada、Dave和Mike都各自专注一章不同,科罗拉多大学Boulder分校的Shivakant Mishra更像是一个分布式系统,他阅读和评述了许多章节,并为本书提供了大量的新习题和编程问题。

还值得提出的是Hugh Lauer。在我们询问他有关修改第2版的建议时,不曾想得到一份23页的报告。本书的许多修改,包括对进程、地址空间和文件等抽象的着重强调,都是源于他的意见。

对那些以各种方式(从新论题建议到封面,细心阅读文稿,提供补充材料,贡献新习题等)给予支持的其他人士,作者也不胜感激。这些人士是Steve Armstrong、Jeffrey Chastine、John Connelly、Mischa Geldermans、Paul Gray、James Griffioen、Jorrit Herder、Michael Howard、Suraj Kothari、Roger Kraft、Trudy Levine、John Masiyowski、Shivakant Mishra、Rudy Pait、Xiao Qin、Mark Russinovich、Krishna Sivalingam、Leendert van Doorn和Ken Wong。

Prentice Hall的员工总是友好和乐于助人的,特别是负责生产的Irwin Zucker和Scott Disanno,以及负责编辑的David Alick、ReeAnne Davies和Melinda Haggerty。

Barbara和Marvin像往常一样,保持着各自独特的美妙方式。当然,还要感谢付出了爱和耐心的Suzanne。

Andrew S.Tanenbaum

第1章 引论

现代计算机系统由一个或多个处理器、主存、磁盘、打印机、键盘、鼠标、显示器、网络接口以及各种其他输入/输出设备组成。一般而言,现代计算机系统是一个复杂的系统。如果每位应用程序员都不得不掌握系统所有的细节,那就不可能再编写代码了。而且,管理所有这些部件并加以优化使用,是一件挑战性极强的工作。所以,计算机安装了一层软件,称为操作系统,它的任务是为用户程序提供一个更好、更简单、更清晰的计算机模型,并管理刚才提到的所有这些设备。本书的主题就是操作系统。

多数读者都会对诸如Windows、Linux、FreeBSD或Mac OS X等某个操作系统有些体验,但表面现象是会骗人的。用户与之交互的程序,基于文本的通常称为shell,而基于图标的则称为图形用户界面(Graphical User Interface,GUI),它们实际上并不是操作系统的一部分,尽管这些程序使用操作系统来完成工作。

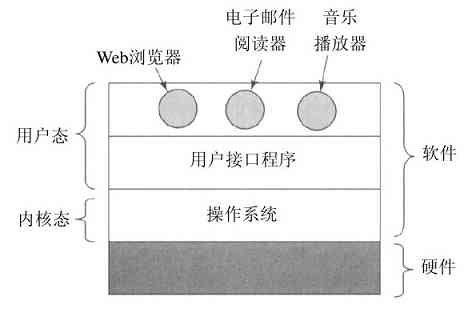

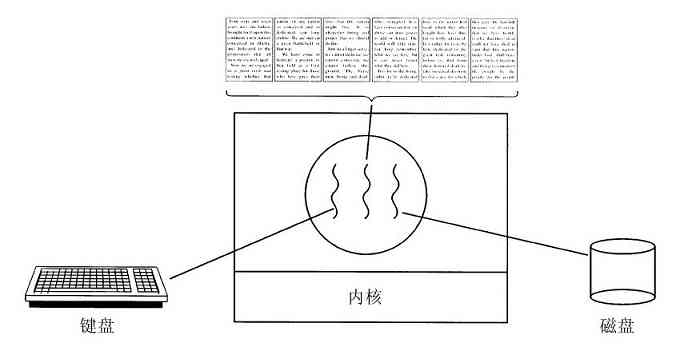

图1-1给出了在这里所讨论主要部件的一个简化视图。图的底部是硬件。硬件包括芯片、电路板、磁盘、键盘、显示器以及类似的设备。在硬件的顶部是软件。多数计算机有两种运行模式:内核态和用户态。软件中最基础的部分是操作系统,它运行在内核态(也称为管态、核心态)。在这个模式中,操作系统具有对所有硬件的完全访问权,可以执行机器能够运行的任何指令。软件的其余部分运行在用户态下。在用户态下,只使用了机器指令中的一个子集。特别地,那些会影响机器的控制或可进行I/O(输入/输出)操作的指令,在用户态中的程序里是禁止的。在本书中,我们会不断地讨论内核态和用户态之间的差别。

用户接口程序,shell或者GUI,处于用户态程序中的最低层次,允许用户运行其他程序,诸如Web浏览器、电子邮件阅读器或音乐播放器等。这些程序也大量使用操作系统。

操作系统所在的位置如图1-1所示。它运行在裸机之上,为所有其他软件提供基础的运行环境。

图 1-1 操作系统所处的位置

操作系统和普通软件(用户态)之间的主要区别是,如果用户不喜欢某个特定的电子邮件阅读器,他可以自由选择另一个,或者选择自己写一个,但是他不能自行写一个属于操作系统一部分的时钟中断处理程序。这个程序由硬件保护,防止用户试图对其进行修改。

然而,有时在嵌入式系统(该系统没有内核态)或解释系统(如基于Java的操作系统,它采用解释方式而非硬件方式区分组件)中,上述区别是模糊的。

另外,在许多系统中,一些在用户态下运行的程序协助操作系统完成特权功能。例如,经常有一个程序供用户修改其口令之用。但是这个程序不是操作系统的一部分,也不在内核态下运行,不过它明显地带有敏感的功能,并且必须以某种方式给予保护。在某些系统中,这种想法被推向了极致,一些传统上被认为是操作系统的部分(诸如文件系统)在用户空间中运行。在这类系统中,很难划分出一条明显的界限。在内核态中运行的当然是操作系统的一部分,但是一些在内核外运行的程序也有争议地被认为是操作系统的一部分,或者至少与操作系统密切相关。

操作系统与用户(即应用)程序的差异并不在于它们所处的地位。特别地,操作系统是大型、复杂和长寿命的程序。Linux或Windows操作系统的源代码有5百万行数量级。要理解这个数量的含义,请考虑具有5百万行的一套书,每页50行,每卷1000页(比本书厚)。为了以书的大小列出一个操作系统,需要有100卷书——基本上需要一整个书架来摆放。请设想一下有个维护操作系统的工作,第一天老板带你到装有代码的书架旁,说:“去读吧。”而这仅仅是运行在内核中的部分代码。用户程序,如GUI、库以及基本应用软件(类似于Windows Explorer)等,很容易就能达到这个代码数量的10倍或20倍之多。

至于为什么操作系统的寿命较长,读者现在应该清楚了——操作系统是很难编写的。一旦编写完成,操作系统的所有者当然不愿意把它扔掉,再写一个。相反,操作系统会在长时间内进行演化。基本上可以把Windows 95/98/Me看成是一个操作系统,而Windows NT/2000/XP/Vista则是另外一个操作系统。对于用户而言,它们看上去很相像,因为微软公司努力使Windows 2000/XP与被替代的系统,如Windows 98,两者的用户界面看起来十分相似。无论如何,微软公司要舍弃Windows 98是有非常正当的原因的,我们将在第11章涉及Windows细节时具体讨论这一内容。

贯穿本书的其他主要例子(除了Windows)还有UNIX,以及它的变体和克隆版。UNIX,当然也演化了多年,如System V版、Solaris以及FreeBSD等都是来源于UNIX的原始版;不过尽管Linux非常像依照UNIX模式而仿制,并且与UNIX高度兼容,但是Linux具有全新的代码基础。本书将采用来自UNIX中的示例,并在第10章中具体讨论Linux。

本章将简要叙述操作系统的若干重要部分,内容包括其含义、历史、分类、一些基本概念及其结构。在后面的章节中,我们将具体地讨论这些重要内容。

1.1 什么是操作系统

很难给出操作系统的准确定义。操作系统是一种运行在内核态的软件——尽管这个说法并不总是符合事实。部分原因是操作系统执行两个基本上独立的任务,为应用程序员(实际上是应用程序)提供一个资源集的清晰抽象,并管理这些硬件资源,而不仅仅是一堆硬件。另外,还取决于从什么角度看待操作系统。读者多半听说过其中一个或另一个的功能。下面我们逐项进行讨论。

1.1.1 作为扩展机器的操作系统

在机器语言一级上,多数计算机的体系结构(指令集、存储组织、I/O和总线结构)是很原始的,而且编程是很困难的,尤其是对输入/输出操作而言。要更细致地考察这一点,可以考虑如何用NEC PD765控制器芯片来进行软盘I/O操作,多数基于Intel的个人计算机中使用了该控制器兼容芯片。(在本书中,术语“软盘”和“磁盘”是可互换的。)我们之所以使用软盘作为例子,是因为它虽然已经很少见,但是与现代硬盘相比则简单得多。PD765有16条命令,每一条命令向一个设备寄存器装入长度从1字节到9字节的特定数据。这些命令用于读写数据、移动磁头臂、格式化磁道,以及初始化、检测状态、复位、校准控制器及设备等。

最基本的命令是read和write。它们均需要13个参数,所有这些参数封装在9个字节中。这些参数所指定的信息有:欲读取的磁盘块地址、磁道的扇区数、物理介质的记录格式、扇区间隙以及对已删除数据地址标识的处理方法等。如果读者不懂这些“故弄玄虚”的语言,请不要担心,因为这正是关键所在——它们太玄秘了。当操作结束时,控制器芯片在7个字节中返回23个状态及出错字段。这样似乎还不够,软盘程序员还要注意保持步进电机的开关状态。如果电机关闭着,则在读写数据前要先启动它(有一段较长的启动延迟时间)。而电机又不能长时间处于开启状态,否则软盘片就会被磨坏。程序员必须在较长的启动延迟和可能对软盘造成损坏(和丢失数据)之间做出权衡。

现在不用再叙述读操作的具体过程了,很清楚,一般程序员并不想涉足软盘(或硬盘,更复杂)编程的这些具体细节。相反,程序员需要的是一种简单的、高度抽象的处理。在磁盘的情况下,典型的抽象是包含了一组已命名文件的一个磁盘。每个文件可以打开进行读写操作,然后进行读写,最后关闭文件。诸如记录是否应该使用修正的调频记录方式,以及当前电机的状态等细节,不应该出现在提供给应用程序员的抽象描述中。

抽象是管理复杂性的一个关键。好的抽象可以把一个几乎不可能管理的任务划分为两个可管理的部分。其第一部分是有关抽象的定义和实现,第二部分是随时用这些抽象解决问题。几乎每个计算机用户都理解的一个抽象是文件。文件是一种有效的信息片段,诸如数码照片、保存的电子邮件信息或Web页面等。处理数码照片、电子邮件以及Web页面等,要比处理磁盘的细节容易,这些磁盘的具体细节与前面叙述过的软盘一样。操作系统的任务是创建好的抽象,并实现和管理它所创建的抽象对象。本书中,我们将研究许多关于抽象的内容,因为这是理解操作系统的关键。

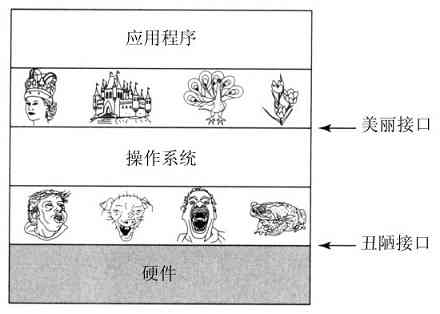

上述观点是非常重要的,所以值得用不同的表述语句来再次叙述。怀着对设计Macintosh机器的工业设计师的尊重,作者这里不得不说,硬件是丑陋的。真实的处理器、内存条、磁盘和其他装置都是非常复杂的,对于那些为使用某个硬件而不得不编写软件的人们而言,他们使用的是困难、可怕、特殊和不一致的接口。有时这是由于需要兼容旧的硬件,有时是为了节省成本,但是,有时硬件设计师们并没有意识到(或在意)他们给软件设计带来了多大的麻烦。操作系统的一个主要任务是隐藏硬件,呈现给程序(以及程序员)良好、清晰、优雅、一致的抽象。如图1-2所示,操作系统将丑陋转变为美丽。

图 1-2 操作系统将丑陋的硬件转变为美丽的抽象

需要指出,操作系统的实际客户是应用程序(当然是通过应用程序员)。它们直接与操作系统及其抽象打交道。相反,最终用户与用户接口所提供的抽象打交道,或者是命令行shell或者是图形接口。而用户接口的抽象可以与操作系统提供的抽象类似,但也不总是这样。为了更清晰地说明这一点,请读者考虑普通的Windows桌面以及面向行的命令提示符。两者都是运行在Windows操作系统上的程序,并使用了Windows提供的抽象,但是它们提供了非常不同的用户接口。类似地,运行Gnome或者KDE的Linux用户与直接在X Window系统(面向文本)顶部工作的Linux用户看到的是非常不同的界面,但是在这两种情形中,操作系统下面的抽象是相同的。

在本书中,我们将具体讨论提供给应用程序的抽象,不过很少涉及用户界面。尽管用户界面是一个巨大和重要的课题,但是它们毕竟只和操作系统的外围相关。

1.1.2 作为资源管理者的操作系统

把操作系统看作是向应用程序提供基本抽象的概念,是一种自顶向下的观点。按照另一种自底向上的观点,操作系统则用来管理一个复杂系统的各个部分。现代计算机包含处理器、存储器、时钟、磁盘、鼠标、网络接口、打印机以及许多其他设备。从这个角度看,操作系统的任务是在相互竞争的程序之间有序地控制对处理器、存储器以及其他I/O接口设备的分配。

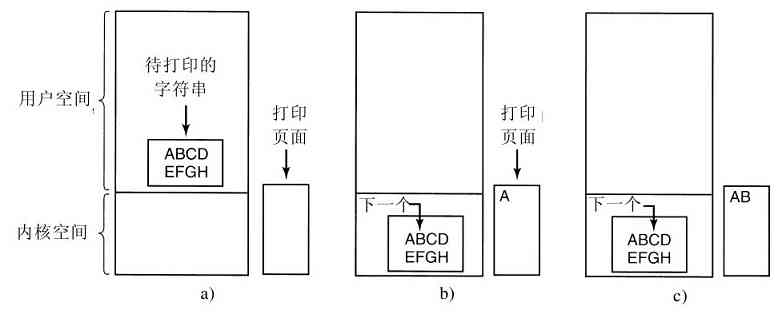

现代操作系统允许同时运行多道程序。假设在一台计算机上运行的三个程序试图同时在同一台打印机上输出计算结果,那么开始的几行可能是程序1的输出,接着几行是程序2的输出,然后又是程序3的输出等,最终结果将是一团糟。采用将打印结果送到磁盘上缓冲区的方法,操作系统可以把潜在的混乱有序化。在一个程序结束后,操作系统可以将暂存在磁盘上的文件送到打印机输出,同时其他程序可以继续产生更多的输出结果,很明显,这些程序的输出还没有真正送至打印机。

当一个计算机(或网络)有多个用户时,管理和保护存储器、I/O设备以及其他资源的需求变得强烈起来,因为用户间可能会互相干扰。另外,用户通常不仅共享硬件,还要共享信息(文件、数据库等)。简而言之,操作系统的这一种观点认为,操作系统的主要任务是记录哪个程序在使用什么资源,对资源请求进行分配,评估使用代价,并且为不同的程序和用户调解互相冲突的资源请求。

资源管理包括用以下两种不同方式实现多路复用(共享)资源:在时间上复用和在空间上复用。当一种资源在时间上复用时,不同的程序或用户轮流使用它。先是第一个获得资源的使用,然后下一个,以此类推。例如,若在系统中只有一个CPU,而多个程序需要在该CPU上运行,操作系统则首先把该CPU分配给某一个程序,在它运行了足够长的时间之后,另一个程序得到CPU,然后是下一个,如此进行下去,最终,轮到第一个程序再次运行。至于资源是如何实现时间复用的——谁应该是下一个以及运行多长时间等——则是操作系统的任务。还有一个有关时间复用的例子是打印机的共享。当多个打印作业在一台打印机上排队等待打印时,必须决定将轮到打印的是哪个作业。

另一类复用是空间复用。每个客户都得到资源的一部分,从而取代了客户排队。例如,通常在若干运行程序之间分割内存,这样每一个运行程序都可同时入住内存(例如,为了轮流使用CPU)。假设有足够的内存可以存放多个程序,那么在内存中同时存放若干个程序的效率,比把所有内存都分给一个程序的效率要高得多,特别是,如果一个程序只需要整个内存的一小部分时,结果更是这样。当然,如此的做法会引起公平、保护等问题,这有赖于操作系统解决它们。有关空间复用的其他资源还有磁盘。在许多系统中,一个磁盘同时为许多用户保存文件。分配磁盘空间并记录谁正在使用哪个磁盘块,是操作系统资源管理的典型任务。

1.2 操作系统的历史

操作系统已经存在许多年了。在下面的小节中,我们将简要地分析一些操作系统历史上的重要之处。操作系统与其所运行的计算机体系结构的联系非常密切。我们将分析连续几代的计算机,看看它们的操作系统是什么样的。把操作系统的分代映射到计算机的分代上有些粗糙,但是这样做确实有某些作用,否则还没有其他好办法能够说清楚操作系统的历史。

下面给出的有关操作系统的发展主要是按照时间线索叙述的,且在时间上是有重叠的。每个发展并不是等到先前一种发展完成后才开始。存在着大量的重叠,不用说还存在有不少虚假的开始和终结时间。请读者把这里的文字叙述看成是一种指引,而不是盖棺论定。

第一台真正的数字计算机是英国数学家Charles Babbage(1792-1871)设计的。尽管Babbage花费了他几乎一生的时间和财产,试图建造他的“分析机”,但是他始终未能让机器正常的运转,因为它是一台纯机械的数字计算机,他所在时代的技术不能生产出他所需要的高精度轮子、齿轮和轮牙。毫无疑问,这台分析机没有操作系统。

有一段有趣的历史花絮,Babbage认识到他的分析机需要软件,所以他雇佣了一个名为Ada Lovelace的年轻妇女,作为世界上第一个程序员,而她是著名的英国诗人Lord Byron的女儿。程序设计语言Ada则是以她命名的。

1.2.1 第一代(1945~1955):真空管和穿孔卡片

从Babbage失败之后一直到第二次世界大战,数字计算机的建造几乎没有什么进展,第二次世界大战刺激了有关计算机研究的爆炸性开展。Iowa州立大学的John Atanasoff教授和他的学生Clifford Berry建造了据认为是第一台可工作的数字计算机。该机器使用了300个真空管。大约在同时,Konrad Zuse在柏林用继电器构建了Z3计算机,英格兰布莱切利园的一个小组在1944年构建了Colossus,Howard Aiken在哈佛大学建造了Mark I,宾夕法尼亚大学的William Mauchley和他的学生J.Presper Eckert建造了ENIAC。这些机器有的是二进制的,有的使用真空管,有的是可编程的,但是都非常原始,甚至需要花费数秒时间才能完成最简单的运算。

在那个早期年代里,同一个小组的人(通常是工程师们)设计、建造、编程、操作并维护一台机器。所有的程序设计是用纯粹的机器语言编写的,甚至更糟糕,需要通过将上千根电缆接到插件板上连接成电路,以便控制机器的基本功能。没有程序设计语言(甚至汇编语言也没有),操作系统则从来没有听说过。使用机器的一般方式是,程序员在墙上的机时表上预约一段时间,然后到机房中将他的插件板接到计算机里,在接下来的几小时里,期盼正在运行中的两万多个真空管不会烧坏。那时,所有的计算问题实际都只是简单的数字运算,如制作正弦、余弦以及对数表等。

到了20世纪50年代早期有了改进,出现了穿孔卡片,这时就可以将程序写在卡片上,然后读入计算机而不用插件板,但其他过程则依然如旧。

1.2.2 第二代(1955~1965):晶体管和批处理系统

20世纪50年代晶体管的发明极大地改变了整个状况。计算机已经很可靠,厂商可以成批地生产并销售计算机给用户,用户可以指望计算机长时间运行,完成一些有用的工作。此时,设计人员、生产人员、操作人员、程序人员和维护人员之间第一次有了明确的分工。

这些机器,现在被称作大型机(mainframe),锁在有专用空调的房间中,由专业操作人员运行。只有少数大公司、重要的政府部门或大学才接受数百万美元的标价。要运行一个作业(job,即一个或一组程序),程序员首先将程序写在纸上(用FORTRAN语言或汇编语言),然后穿孔成卡片,再将卡片盒带到输入室,交给操作员,接着就喝咖啡直到输出完成。

计算机运行完当前的任务后,其计算结果从打印机上输出,操作员到打印机上撕下运算结果并送到输出室,程序员稍后就可取到结果。然后,操作员从已送到输入室的卡片盒中读入另一个任务。如果需要FORTRAN编译器,操作员还要从文件柜把它取来读入计算机。当操作员在机房里走来走去时许多机时被浪费掉了。

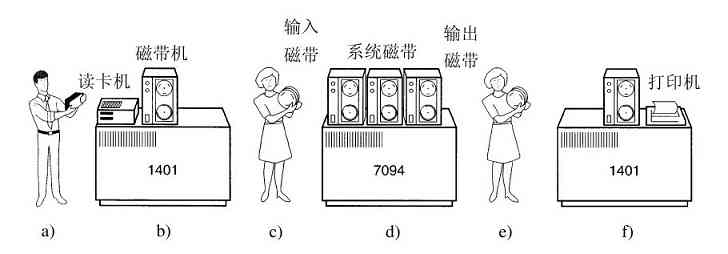

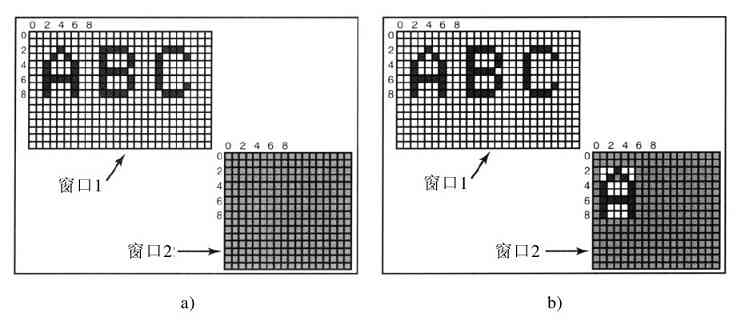

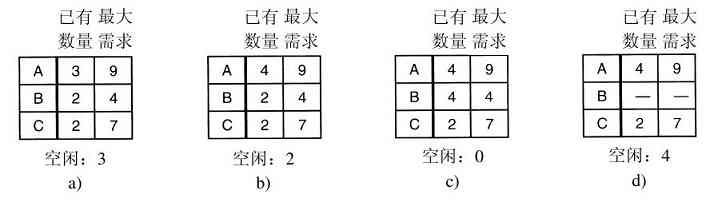

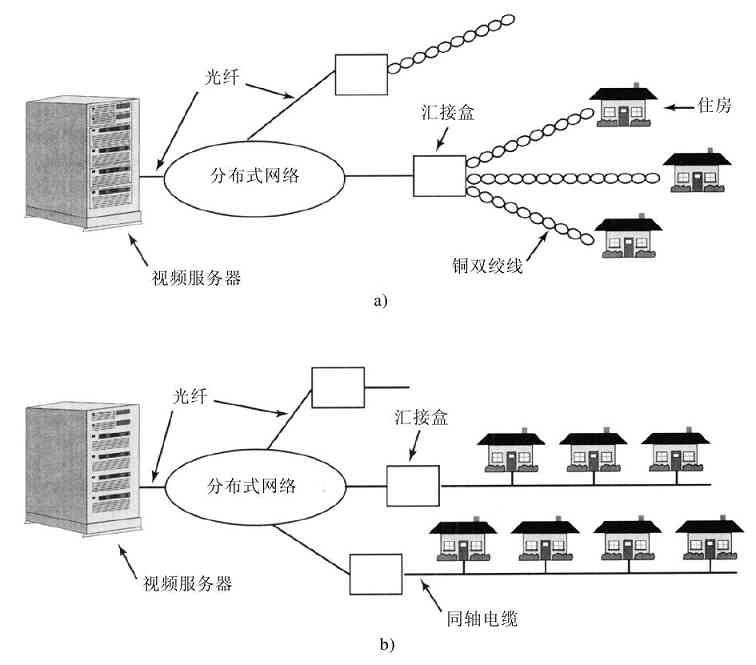

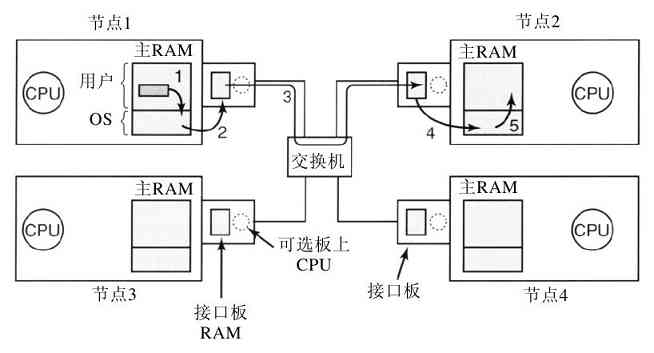

由于当时的计算机非常昂贵,人们很自然地要想办法减少机时的浪费。通常采用的解决方法就是批处理系统(batch system)。其思想是:在输入室收集全部的作业,然后用一台相对便宜的计算机,如IBM 1401计算机,将它们读到磁带上。IBM 1401计算机适用于读卡片、复制磁带和输出打印,但不适用于数值运算。另外用较昂贵的计算机,如IBM 7094来完成真正的计算。这些情况如图1-3所示。

图 1-3 一种早期的批处理系统:a)程序员将卡片拿到1401机处;b)1401机将批处理作业读到磁带上;c)操作员将输入带送至7094机;d)7094机进行计算;e)操作员将输出磁带送到1401机;f)1401机打印输出

在收集了大约一个小时的批量作业之后,这些卡片被读进磁带,然后磁带被送到机房里并装到磁带机上。随后,操作员装入一个特殊的程序(现代操作系统的前身),它从磁带上读入第一个作业并运行,其输出写到第二盘磁带上,而不打印。每个作业结束后,操作系统自动地从磁带上读入下一个作业并运行。当一批作业完全结束后,操作员取下输入和输出磁带,将输入磁带换成下一批作业,并把输出磁带拿到一台1401机器上进行脱机(不与主计算机联机)打印。

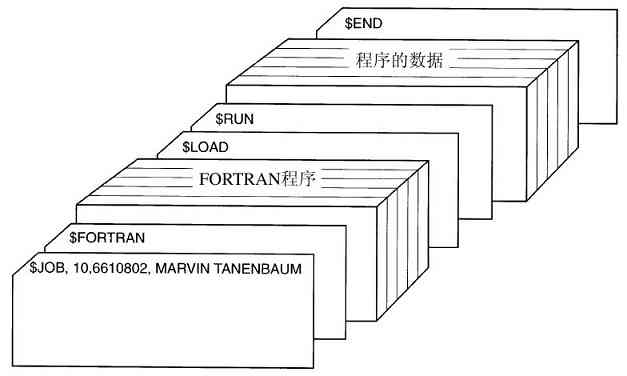

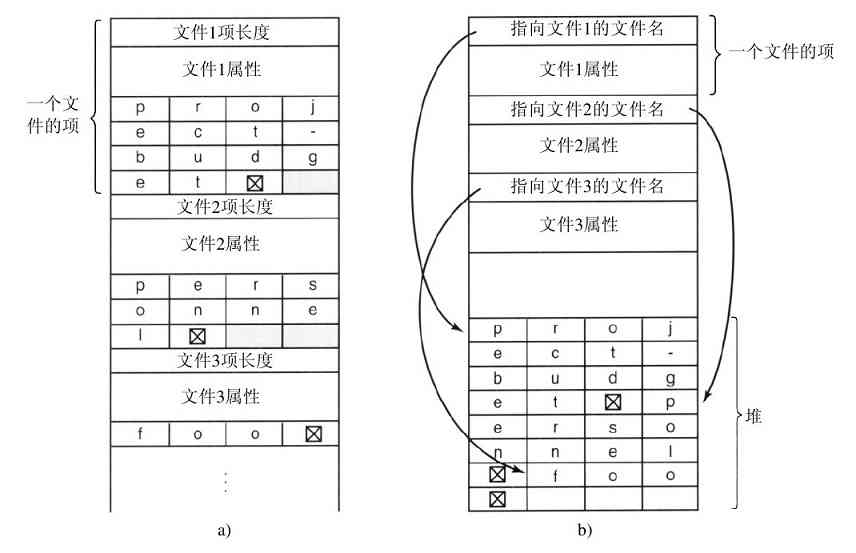

典型的输入作业结构如图1-4所示。一开始是张$JOB卡片,它标识出所需的最大运行时间(以分钟为单位)、计费账号以及程序员的名字。接着是$FORTRAN卡片,通知操作系统从系统磁带上装入FORTRAN语言编译器。之后就是待编译的源程序,然后是$LOAD卡片,通知操作系统装入编译好的目标程序。接着是$RUN卡片,告诉操作系统运行该程序并使用随后的数据。最后,$END卡片标识作业结束。这些基本的控制卡片是现代shell和命令解释器的先驱。

图 1-4 典型的FMS作业结构

第二代大型计算机主要用于科学与工程计算,例如,解偏微分方程。这些题目大多用FORTRAN语言和汇编语言编写。典型的操作系统是FMS(FORTRAN Monitor System,FORTRAN监控系统)和IBSYS(IBM为7094机配备的操作系统)。

1.2.3 第三代(1965~1980):集成电路芯片和多道程序设计

20世纪60年代初期,大多数计算机厂商都有两条不同并且完全不兼容的生产线。一条是面向字的、大型的科学用计算机,诸如IBM 7094,主要用于科学和工程计算。另一条是面向字符的、商用计算机,诸如IBM 1401,银行和保险公司主要用它从事磁带归档和打印服务。

开发和维护两种完全不同的产品,对厂商来说是昂贵的。另外,许多新的计算机用户一开始时只需要一台小计算机,后来可能又需要一台较大的计算机,而且希望能够更快地执行原有的程序。

IBM公司试图通过引入System/360来一次性地解决这两个问题。360是一个软件兼容的计算机系列,其低档机与1401相当,高档机则比7094功能强很多。这些计算机只在价格和性能(最大存储器容量、处理器速度、允许的I/O设备数量等)上有差异。由于所有的计算机都有相同的体系结构和指令集,因此,在理论上,为一种型号机器编写的程序可以在其他所有型号的机器上运行。而且360被设计成既可用于科学计算,又可用于商业计算,这样,一个系列的计算机便可以满足所有用户的要求。在随后的几年里,IBM使用更现代的技术陆续推出了360的后续机型,如著名的370、4300、3080和3090系列。zSeries是这个系列的最新机型,不过它与早期的机型相比变化非常之大。

360是第一个采用(小规模)芯片(集成电路)的主流机型,与采用分立晶体管制造的第二代计算机相比,其性能/价格比有很大提高。360很快就获得了成功,其他主要厂商也很快采纳了系列兼容机的思想。这些计算机的后代仍在大型的计算中心里使用。现在,这些计算机的后代经常用来管理大型数据库(如航班定票系统)或作为web站点的服务器,这些服务器每秒必须处理数千次的请求。

“单一家族”思想的最大优点同时也是其最大的缺点。原因在于所有的软件,包括操作系统OS/360,要能够在所有机器上运行。从小的代替1401把卡片复制到磁带上的机器,到用于代替7094进行气象预报及其他繁重计算的大型机;从只能带很少外部设备的机器到有很多外设的机器;从商业领域到科学计算领域等。总之,它要有效地适用于所有这些不同的用途。

IBM(或其他公司)无法写出同时满足这些相互冲突需要的软件。其结果是一个庞大的又极其复杂的操作系统,它比FMS大了约2~3个数量级规模。其中包含数千名程序员写的数百万行汇编语言代码,也包含成千上万处错误,这就导致IBM不断地发行新的版本试图更正这些错误。每个新版本在修正老错误的同时又引入了新错误,所以随着时间的流逝,错误的数量可能大致保持不变。

OS/360的设计者之一Fred Brooks后来写过一本既诙谐又尖锐的书(Brooks,1996),描述他在开发OS/360过程中的经验。我们不可能在这里复述该书的全部内容,不过其封面已经充分表述了Fred Brooks的观点,一群史前动物陷入泥潭而不能自拔。Silberschatz等人著作(2005)的封面也表达了操作系统如同恐龙一般的类似观点。

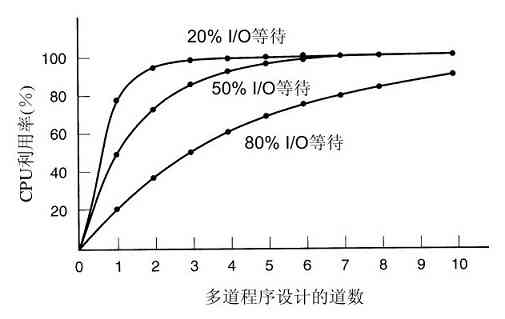

抛开OS/360的庞大和存在的问题,OS/360和其他公司类似的第三代操作系统的确合理地满足了大多数用户的要求。同时,它们也使第二代操作系统所缺乏的几项关键技术得到了广泛应用。其中最重要的应该是多道程序设计(multiprogramming)。在7094机上,若当前作业因等待磁带或其他I/O操作而暂停时,CPU就只能简单地踏步直至该I/O完成。对于CPU操作密集的科学计算问题,I/O操作较少,因此浪费的时间很少。然而,对于商业数据处理,I/O操作等待的时间通常占到80%~90%,所以必须采取某种措施减少(昂贵的)CPU空闲时间的浪费。

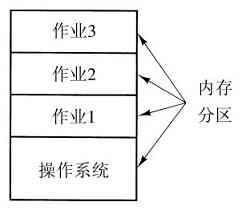

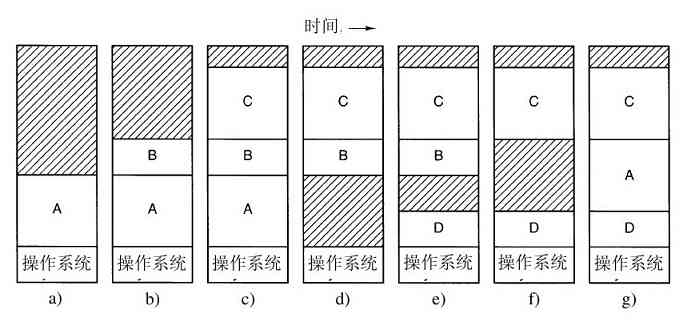

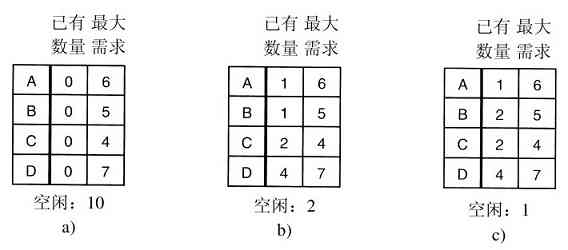

解决方案是将内存分几个部分,每一部分存放不同的作业,如图1-5所示。当一个作业等待I/O操作完成时,另一个作业可以使用CPU。如果内存中可以同时存放足够多的作业,则CPU利用率可以接近100%。在内存中同时驻留多个作业需要特殊的硬件来对其进行保护,以避免作业的信息被窃取或受到攻击。360及其他第三代计算机都配有此类硬件。

图 1-5 一个内存中有三个作业的多道程序系统

第三代计算机的另一个特性是,卡片被拿到机房后能够很快地将作业从卡片读入磁盘。于是,任何时刻当一个作业运行结束时,操作系统就能将一个新作业从磁盘读出,装进空出来的内存区域运行。这种技术叫做同时的外部设备联机操作(Simultaneous Peripheral Operation On Line,SPOOLing),该技术同时也用于输出。当采用了SPOOLing技术后,就不再需要IBM 1401机,也不必再将磁带搬来搬去了。

第三代操作系统很适于大型科学计算和繁忙的商务数据处理,但其实质上仍旧是批处理系统。许多程序员很怀念第一代计算机的使用方式。那时,他们可以几个小时地独占一台机器,可以即时地调试他们的程序。而对第三代计算机而言,从一个作业提交到运算结果取回往往长达数小时,更有甚者,一个逗号的误用就会导致编译失败,而可能浪费了程序员半天的时间。

程序员们的希望很快得到了响应,这种需求导致了分时系统(timesharing)的出现。它实际上是多道程序的一个变体,每个用户都有一个联机终端。在分时系统中,假设有20个用户登录,其中17个在思考、谈论或喝咖啡,则CPU可分配给其他三个需要的作业轮流执行。由于调试程序的用户常常只发出简短的命令(如编译一个五页的源文件),而很少有长的费时命令(如上百万条记录的文件排序),所以计算机能够为许多用户提供快速的交互式服务,同时在CPU空闲时还可能在后台运行一个大作业。第一个通用的分时系统,兼容分时系统(Compatible Time Sharing System,CTSS)是MIT(麻省理工学院)在一台改装过的7094机上开发成功的(Corbató等人,1962年)。但直到第三代计算机广泛采用了必需的保护硬件之后,分时系统才逐渐流行开来。

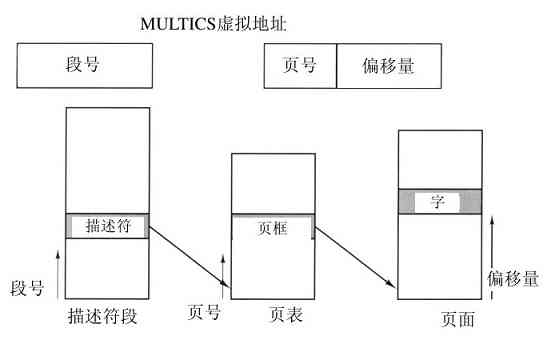

在CTSS成功研制之后,MIT、贝尔实验室和通用电气公司(GE,当时一个主要的计算机制造厂商)决定开发一种“公用计算服务系统”,能够同时支持数百名分时用户的一种机器。它的模型借鉴了供电系统——当需要电能时,只需将电气设备接到墙上的插座即可,于是,在合理范围内,所需要的电能随时可提供。该系统称作MULTICS(MULTiplexed Information and Computing Service),其设计者着眼于建造满足波士顿地区所有用户计算需求的一台机器。在当时看来,仅仅40年之后,就能成百万台地销售(价值不到1千美元)速度是GE-645主机10 000倍的计算机,完全是科学幻想。这种想法同现在关于穿越大西洋的超音速海底列车的想法一样,是幻想。

MULTICS得到一种混合式的成功。尽管这台机器具有较强的I/O能力,却要在一台仅仅比Intel 386 PC性能强一点的机器上支持数百个用户。可是这个想法并不像表面上那么荒唐,因为那时的人们已经知道如何编写精练的高效程序,而这种技巧随后逐渐丢失了。有许多原因造成MULTICS没有能够普及到全世界,至少它不应该采用PL/1编写,因为PL/1编译器推迟了好几年才完成,好不容易完成的编译器又极少能够成功运行。另外,当时的MULTICS有太大的野心,犹如19世纪中期Charles Babbage的分析机。

简要地说,MULTICS在计算机文献中播撒了许多原创的概念,但要将其造成一台真正的机器并想实现商业上的巨大成功的研制难度超出了所有人的预料。贝尔实验室退出了,通用电气公司也退出了计算机领域。但是M.I.T.坚持下来并且最终使MULTICS成功运行。MULTICS最后成为商业产品,由购买了通用电气公司计算机业务的公司(Honeywell)销售,并安装在世界各地80多个大型公司和大学中。尽管MULTICS的数量很小,但是MULTICS的用户们却非常忠诚,例如,通用汽车、福特和美国国家安全局直到20世纪90年代后期,在试图让Honeywell更新其硬件多年之后,才关闭了他们的MULTICS系统,而这已经是在MULTICS推出之后30年了。

目前,计算服务的概念已经被遗弃,但是这个概念是可以回归的,以大量的、附有相对简单用户机器的、集中式Internet服务器形式回归。在这种形式中,主要工作在大型服务器上完成。而回归的动机可能是多数人不愿意管理日益过分复杂的计算机系统,宁可让那些运行服务器公司的专业团队去做。电子商务已经向这个方向演化了,各种公司在多处理器的服务器上经营各自的电子商场,简单的客户端连接着多处理器服务器,这同MULTICS的设计精神非常类似。

尽管MULTICS在商业上失败了,但MULTICS对随后的操作系统却有着巨大的影响,详情请参阅有关文献和书籍(Corbató等人,1972;Corbató和Vyssotsky,1965;Daley和Dennis,1968;Organick,1972;Saltzer,1974)。还有一个曾经(现在仍然)活跃的Web站点www.multicians.org,上面有大量关于系统、设计人员以及其用户的信息资料。

另一个第三代计算机的主要进展是小型机的崛起,以1961年DEC的PDP-1作为起点。PDP-1计算机只有4K个18位的内存,每台售价120 000美元(不到IBM 7094的5%),该机型非常热销。对于某些非数值的计算,它和7094几乎一样快。PDP-1开辟了一个全新的产业。很快有了一系列PDP机型(与IBM系列机不同,它们互不兼容),其顶峰为PDP-11。

一位曾参加过MULTICS研制的贝尔实验室计算机科学家Ken Thompson,后来找到一台无人使用的PDP-7机器,并开始开发一个简化的、单用户版MULTICS。他的工作后来导致了UNIX操作系统的诞生。接着,UNIX在学术界,政府部门以及许多公司中流行。

有关UNIX的历史到处可以找到(例如Salus,1994)。这段故事的部分放在第10章中介绍。现在,有充分理由认为,由于到处可以得到源代码,各种机构发展了自己的(不兼容)版本,从而导致了混乱。UNIX有两个主要的版本,源自AT&T的System V,以及源自加州伯克利大学的BSD(Berkeley Software Distribution)。当然还有一些小的变种。为了使编写的程序能够在任何版本的UNIX上运行,IEEE提出了一个UNIX的标准,称作POSIX,目前大多数UNIX版本都支持它。POSIX定义了一个凡是UNIX必须支持的小型系统调用接口。事实上,某些其他操作系统也支持POSIX接口。

顺便值得一提的是,在1987年,本书作者发布了一个UNIX的小型克隆,称为MINIX,用于教学目的。在功能上,MINIX非常类似于UNIX,包括对POSIX的支持。从那时以后,MINIX的原始版本已经演化为MINIX 3,该系统是高度模块化的,并专注于高可靠性。它具有快速检测和替代有故障甚至已崩溃模块(如I/O设备驱动器)的能力,不用重启也不会干扰运行着的程序。有一本叙述其内部操作,并在附录中列出源代码的书(Tanenbaum和Woodhull,2006),该书现在仍然有售。在因特网的地址www.minix3.org上,MINIX3是免费使用的(包括了所有源代码)。

对UNIX版本免费产品(不同于教育目的)的愿望,导致芬兰学生Linus Torvalds编写了Linux。这个系统直接受到在MINIX开发的启示,而且原本支持各种MINIX的功能(例如MINIX文件系统)。尽管它已经通过多种方式扩展,但是该系统仍然保留了某些与MINIX和UNIX共同的低层结构。对Linux和开放源码运动具体历史感兴趣的读者可以阅读Glyn Moody的书籍(2001)。本书所叙述的有关UNIX的多数内容,也适用于System V、MINIX、Linux以及UNIX的其他版本和克隆。

1.2.4 第四代(1980年至今):个人计算机

随着LSI(大规模集成电路)的发展,在每平方厘米的硅片芯片上可以集成数千个晶体管,个人计算机时代到来了。从体系结构上看,个人计算机(最早称为微型计算机)与PDP-11并无二致,但就价格而言却相去甚远。以往,公司的一个部门或大学里的一个院系才配备一台小型机,而微处理器却使每个人都能拥有自己的计算机。

1974年,当Intel 8080,第一代通用8位CPU出现时,Intel希望有一个用于8080的操作系统,部分是为了测试目的。Intel请求其顾问Gary Kildall编写。Kildall和一位朋友首先为新推出的Shugart Associates 8英寸软盘构造了一个控制器,并把这个软磁盘同8080相连,从而制造了第一个配有磁盘的微型计算机。然后Kildall为它写了一个基于磁盘的操作系统,称为CP/M(Control Program for Microcomputer)。由于Intel不认为基于磁盘的微型计算机有什么未来前景,所以当Kildall要求CP/M的版权时,Intel同意了他的要求。Kildall于是组建了一家公司Digital Research,进一步开发和销售CP/M。

1977年,Digital Research重写了CP/M,使其可以在使用8080、Zilog Z80以及其他CPU芯片的多种微型计算机上运行,从而使得CP/M完全控制了微型计算机世界达5年之久。

在20世纪80年代的早期,IBM设计了IBM PC并寻找可在上面运行的软件。来自IBM的人员同Bill Gates联系有关他的BASIC解释器的许可证事宜,他们也询问是否他知道可在PC机上运行的操作系统。Gates建议IBM同Digital Research联系,即当时世界上主宰操作系统的公司。在做出毫无疑问是近代历史上最糟的商业决策后,Kildall拒绝与IBM会见,代替他的是一位次要人员。为了使事情更糟糕,他的律师甚至拒绝签署IBM的有关尚未公开的PC的保密协议。结果,IBM回头询问Gates可否提供他们一个操作系统。

在IBM返回时,Gates了解到一家本地计算机制造商,Seattle Computer Products,有合适的操作系统DOS(Disk Operating System)。他联系对方并提出购买(宣称75 000美元),对方接受了。然后Gates提供给IBM成套的DOS/BASIC,IBM也接受了。IBM希望做某些修改,于是Gates雇佣了那个写DOS的作者,Tim Paterson,作为Gates的微软公司早期的一个雇员,并开展工作。修改版称为MS-DOS(MicroSoft Disk Operating System),并且很快主导了IBM PC市场。同Kildall试图将CP/M每次卖给用户一个产品相比(至少开始是这样),这里一个关键因素是Gates(回顾起来,极其聪明)的决策,将MS-DOS与计算机公司的硬件捆绑在一起出售。在所有这一切烟消云散之后,Kildall突然不幸去世,其原因从来没有公布过。

1983年,IBM PC后续机型IBM PC/AT推出,配有Intel 80286 CPU。此时,MS-DOS已经确立了地位,而CP/M只剩下最后的支撑。MS-DOS后来在80386和80486中得到广泛的应用。尽管MS-DOS的早期版本是相当原始的,但是后期的版本提供了更多的先进功能,包括许多源自UNIX的功能。(微软对UNIX是如此娴熟,甚至在公司的早期销售过一个微型计算机版本,称为XENIX)。

用于早期微型计算机的CP/M、MS-DOS和其他操作系统,都是通过键盘输入命令的。由于Doug Engelbart于20世纪60年代在斯坦福研究院(Stanford Research Institute)工作,这种情况最终有了改变。Doug Engelbart发明了图形用户界面,包括窗口、图标、菜单以及鼠标。这些思想被Xerox PARC的研究人员采用,并用在了他们所研制的机器中。

一天,Steve Jobs(和其他人一起在汽车库里发明了苹果计算机)访问PARC,Jobs一看到GUI,立即意识到它的潜在价值,而Xerox管理层恰好没有认识到。这种战略失误的庞大比例,导致名为《摸索未来》一书的出版(Smith与Alexander,1988年)。Jobs随后着手设计了带有GUI的苹果计算机。这个项目导致了Lisa的推出,但是Lisa过于昂贵,所以它在商业上失败了。Jobs的第二次尝试,即苹果Macintosh,取得了巨大的成功,这不仅是因为它比Lisa便宜得多,而且它还是对用户友好的(user friendly),也就是说,它是为那些不仅没有计算机知识,而且也根本不打算学习计算机的用户们准备的。在图像设计、专业数码摄影,以及专业数字视频生产的创意世界里,Macintosh得到广泛的应用,这些用户对苹果公司及Macintosh有着极大的热情。

在微软决定构建MS-DOS的后继产品时,受到了Macintosh成功的巨大影响。微软开发了名为Windows的基于GUI的系统,早期它运行在MS-DOS上层(它更像shell而不像真正的操作系统)。在从1985年至1995年的10年之间,Windows只是在MS-DOS上层的一个图形环境。然而,到了1995年,一个独立的Windows版本,具有许多操作系统功能的Windows 95发布了。Windows 95仅仅把底层的MS-DOS作为启动和运行老的MS-DOS程序之用。1998年,一个稍做修改的系统,Windows 98发布。不过Windows 95和Windows 98仍然使用了大量16位Intel汇编语言。

另一个微软操作系统是Windows NT(NT表示新技术),它在一定的范围内同Windows 95兼容,但是内部是完全新编写的。它是一个32位系统。Windows NT的首席设计师是David Cutler,他也是VAX VMS操作系统的设计师之一,所以有些VMS的概念用在了NT上。事实上,NT中有太多的来自VMS的思想,所以VMS的所有者DEC公司控告了微软公司。法院对该案件判决的结果引出了一大笔需要用多位数字表达的金钱。微软公司期待NT的第一个版本可以消灭MS-DOS和其他的Windows版本,因为NT是一个巨大的超级系统,但是这个想法失败了。只有Windows NT 4.0踏上了成功之路,特别在企业网络方面取得了成功。1999年初,Windows NT 5.0改名为Windows 2000。微软期望它成为Windows 98和Windows NT 4.0的接替者。

不过这两个方面都不太成功,于是微软公司发布了Windows 98的另一个版本,名为Windows Me(千年版)。2001年,发布了Windows 2000的一个稍加升级的版本,称为Windows XP。这个版本的寿命比较长(6年),基本上替代了Windows所有原先版本。在2007年1月,微软公司发布了Windows XP的后继版,名为Vista。它有一个新的图形接口Aero,以及许多其他新的或升级的用户程序。微软公司希望Vista能够完全替代XP,但是这个过程可能需要将近十年的时间。

在个人计算机世界中,另一个主要竞争者是UNIX(和它的各种变体)。UNIX在网络和企业服务器等领域强大,在台式计算机上,特别是在诸如印度和中国这些发展中国家里,UNIX的使用也在增加。在基于Pentium的计算机上,Linux成为学生和不断增加的企业用户们代替Windows的通行选择。顺便提及,在本书中,我们使用“Pentium”这个名词代表Pentium I,II,III和4,以及它们的后继者,诸如Core 2 Duo等。术语x86有时仍旧用来表示Intel公司的包括8086的CPU,而“Pentium”则用于表示从Pentium I开始的所有CPU。很显然,这个术语并不完美,但是没有更好的方案。人们很奇怪,是Intel公司的哪个天才把半个世界都知晓和尊重的品牌名(Pentium)扔掉,并替代以“Core 2 Duo”这样一个几乎没有人立即理解的术语——“2”是什么意思,而“Duo”又是什么意思?也许“Pentium 5”(或者“Pentium 5 dual core”)太难于记忆吧。至于FreeBSD,一个源自于Berkeley的BSD项目,也是一个流行的UNIX变体。所有现代Macintosh计算机都运行着FreeBSD的一个修改版。在使用高性能RISC芯片的工作站上,诸如Hewlett-Packard公司和Sun Microsystems公司销售的那些机器上,UNIX系统也是一种标准配置。

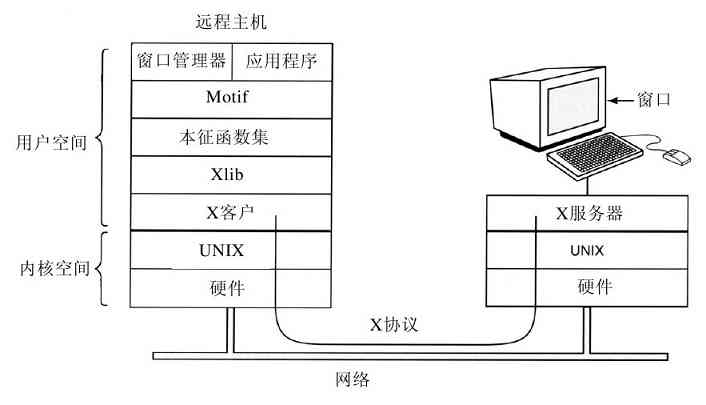

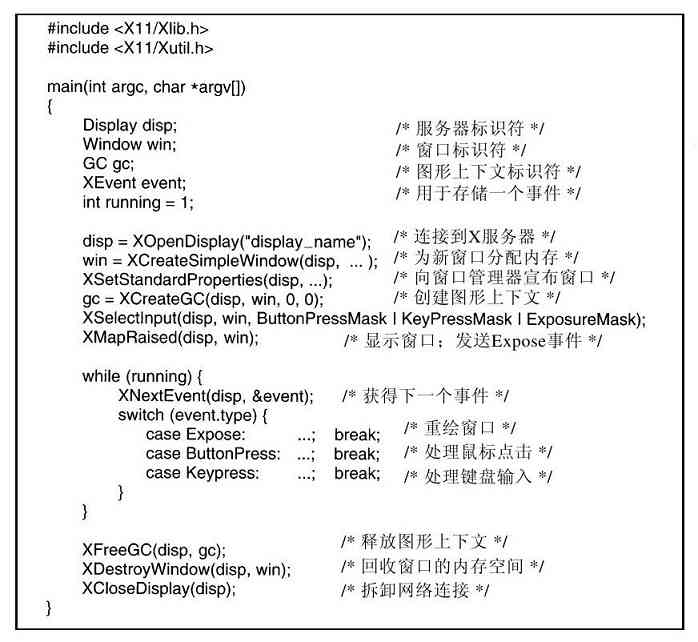

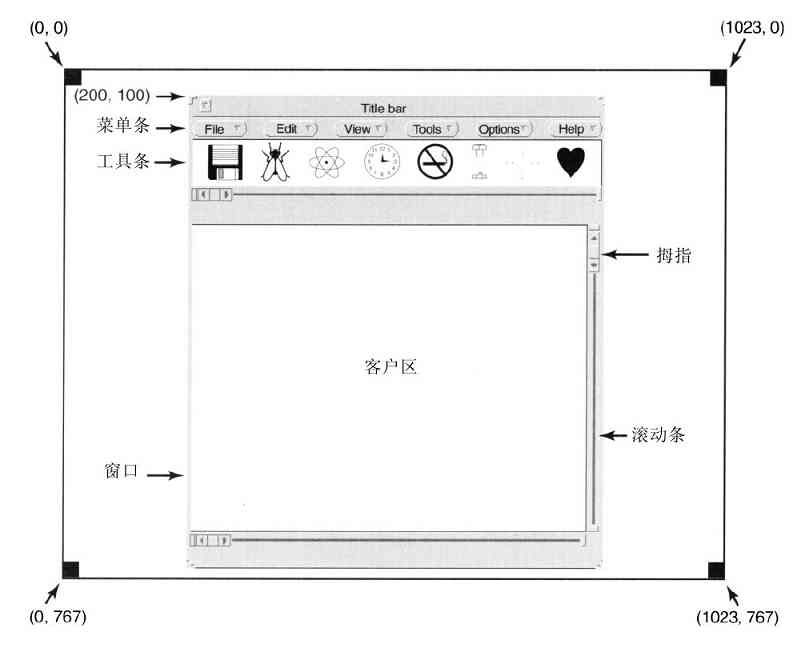

尽管许多UNIX用户,特别是富有经验的程序员们更偏好基于命令的界面而不是GUI,但是几乎所有的UNIX系统都支持由MIT开发的称为X Windows的视窗系统(如众所周知的X11)。这个系统处理基本的视窗管理功能,允许用户通过鼠标创建、删除、移动和变比视窗。对于那些希望有图形系统的UNIX用户,通常在X 11之上还提供一个完整的GUI,诸如Gnome或KDE,从而使得UNIX在外观和感觉上类似于Macintosh或Microsoft Windows。

另一个开始于20世纪80年代中期的有趣发展是,那些运行网络操作系统和分布式操作系统(Tanenbaum和Van Steen,2007)的个人计算机网络的增长。在网络操作系统中,用户知道多台计算机的存在,用户能够登录到一台远地机器上并将文件从一台机器复制到另一台机器,每台计算机都运行自己本地的操作系统,并有自己的本地用户(或多个用户)。

网络操作系统与单处理器的操作系统没有本质区别。很明显,它们需要一个网络接口控制器以及一些低层软件来驱动它,同时还需要一些程序来进行远程登录和远程文件访问,但这些附加成分并未改变操作系统的本质结构。

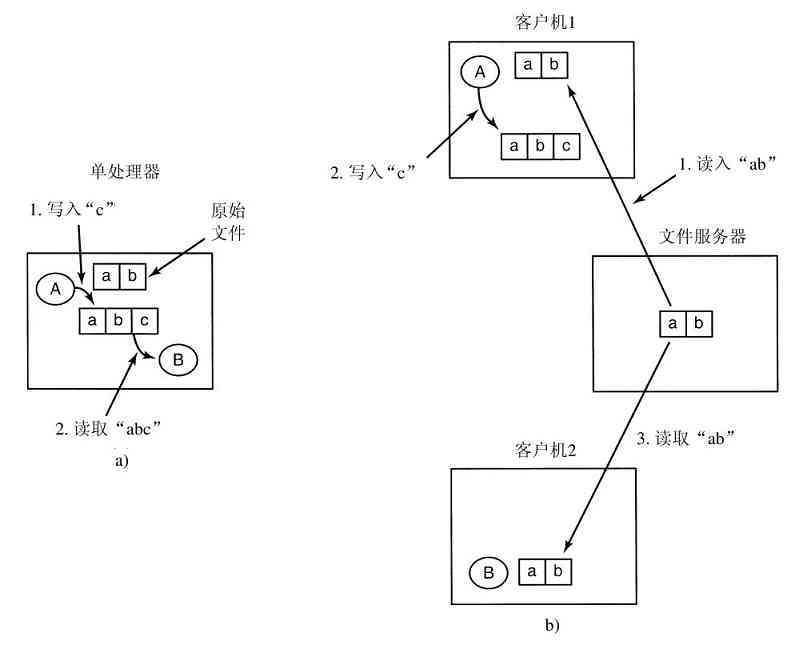

相反,分布式操作系统是以一种传统单处理器操作系统的形式出现在用户面前的,尽管它实际上是由多处理器组成的。用户应该不知晓他们的程序在何处运行或者他们的文件存放于何处,这些应该由操作系统自动和有效地处理。

真正的分布式操作系统不仅仅是在单机操作系统上增添一小段代码,因为分布式系统与集中式系统有本质的区别。例如,分布式系统通常允许一个应用在多台处理器上同时运行,因此,需要更复杂的处理器调度算法来获得最大的并行度优化。

网络中的通信延迟往往导致分布式算法必须能适应信息不完备、信息过时甚至信息不正确的环境。这与单机系统完全不同,对于后者,操作系统掌握着整个系统的完备信息。

1.3 计算机硬件介绍

操作系统与运行该操作系统的计算机硬件联系密切。操作系统扩展了计算机指令集并管理计算机的资源。为了能够工作,操作系统必须了解大量的硬件,至少需要了解硬件如何面对程序员。出于这个原因,这里我们先简要地介绍现代个人计算机中的计算机硬件,然后开始讨论操作系统的具体工作细节。

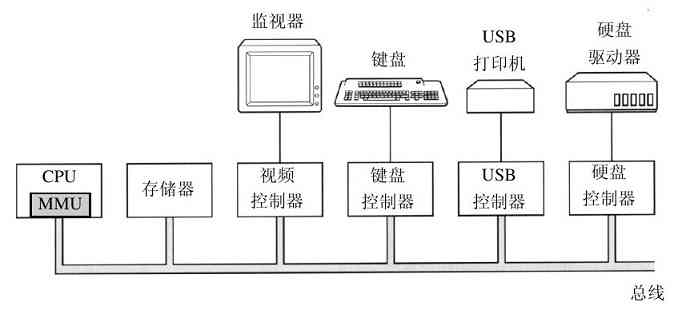

从概念上讲,一台简单的个人计算机可以抽象为类似于图1-6中的模型。CPU、内存以及I/O设备都由一条系统总线连接起来并通过总线与其他设备通信。现代个人计算机结构更加复杂,包含多重总线,我们将在后面讨论之。目前,这一模式还是够用的。在下面各小节中,我们将简要地介绍这些部件,并且讨论一些操作系统设计师们所考虑的硬件问题。毫无疑问,这是一个非常简要的概括介绍。现在有不少讨论计算机硬件和计算机组织的书籍。其中两本有名的书的作者分别是Tanenbaum(2006)和Patterson与Hennessy(2004)。

图 1-6 简单个人计算机中的一些部件

1.3.1 处理器

计算机的“大脑”是CPU,它从内存中取出指令并执行之。在每个CPU基本周期中,首先从内存中取出指令,解码以确定其类型和操作数,接着执行之,然后取指、解码并执行下一条指令。按照这一方式,程序被执行完成。

每个CPU都有其一套可执行的专门指令集。所以,Pentium不能执行SPARC程序,而SPARC也不能执行Pentium程序。由于用来访问内存以得到指令或数据的时间要比执行指令花费的时间长得多,因此,所有的CPU内都有一些用来保存关键变量和临时数据的寄存器。这样,通常在指令集中提供一些指令,用以将一个字从内存调入寄存器,以及将一个字从寄存器存入内存。其他的指令可以把来自寄存器、内存的操作数组合,或者用两者产生一个结果,诸如将两个字相加并把结果存在寄存器或内存中。

除了用来保存变量和临时结果的通用寄存器之外,多数计算机还有一些对程序员可见的专门寄存器。其中之一是程序计数器,它保存了将要取出的下一条指令的内存地址。在指令取出之后,程序计数器就被更新以便指向后继的指令。

另一个寄存器是堆栈指针,它指向内存中当前栈的顶端。该栈含有已经进入但是还没有退出的每个过程的一个框架。在一个过程的堆栈框架中保存了有关的输入参数、局部变量以及那些没有保存在寄存器中的临时变量。

当然还有程序状态字(Program Status Word,PSW)寄存器。这个寄存器包含了条件码位(由比较指令设置)、CPU优先级、模式(用户态或内核态),以及各种其他控制位。用户程序通常读入整个PSW,但是,只对其中的少量字段写入。在系统调用和I/O中,PSW的作用很重要。

操作系统必须知晓所有的寄存器。在时间多路复用(time multiplexing)CPU中,操作系统经常会中止正在运行的某个程序并启动(或再启动)另一个程序。每次停止一个运行着的程序时,操作系统必须保存所有的寄存器,这样在稍后该程序被再次运行时,可以把这些寄存器重新装入。

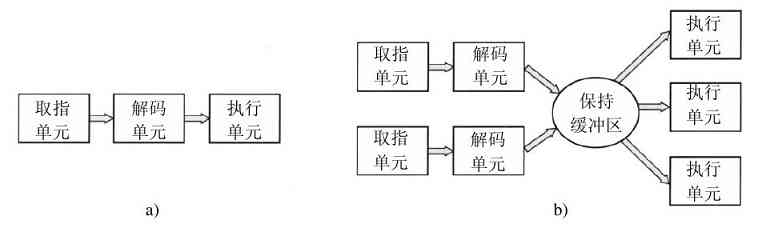

为了改善性能,CPU设计师早就放弃了同时读取、解码和执行一条指令的简单模型。许多现代CPU具有同时取出多条指令的机制。例如,一个CPU可以有分开的取指单元、解码单元和执行单元,于是当它执行指令n时,它还可以对指令n+1解码,并且读取指令n+2。这样一种机制称为流水线(pipeline),在图1-7a中是一个有着三个阶段的流水线示意图。更长的流水线也是常见的。在多数的流水线设计中,一旦一条指令被取进流水线中,它就必须被执行完毕,即便前一条取出的指令是条件转移,它也必须被执行完毕。流水线使得编译器和操作系统的编写者很头疼,因为它造成了在机器中实现这些软件的复杂性问题。

图 1-7 a)有三个阶段的流水线;b)一个超标量CPU

比流水线更先进的设计是一种超标量CPU,如图1-7b所示。在这种设计中,有多个执行单元,例如,一个CPU用于整数算术运算,一个CPU用于浮点算术运算,而另一个用于布尔运算。两个或更多的指令被同时取出、解码并装入一个保持缓冲区中,直至它们执行完毕。只要有一个执行单元空闲,就检查保持缓冲区中是否还有可处理的指令,如果有,就把指令从缓冲区中移出并执行之。这种设计存在一种隐含的作用,即程序的指令经常不按顺序执行。在多数情况下,硬件负责保证这种运算的结果与顺序执行指令时的结果相同,但是,仍然有部分令人烦恼的复杂情形被强加给操作系统处理,我们在后面会讨论这种情况。

除了用在嵌入式系统中的非常简单的CPU之外,多数CPU都有两种模式,即前面已经提及的内核态和用户态。通常,在PSW中有一个二进制位控制这两种模式。当在内核态运行时,CPU可以执行指令集中的每一条指令,并且使用硬件的每种功能。操作系统在内核态下运行,从而可以访问整个硬件。

相反,用户程序在用户态下运行,仅允许执行整个指令集的一个子集和访问所有功能的一个子集。一般而言,在用户态中有关I/O和内存保护的所有指令是禁止的。当然,将PSW中的模式位设置成内核态也是禁止的。

为了从操作系统中获得服务,用户程序必须使用系统调用(system call)系统调用陷入内核并调用操作系统。TRAP指令把用户态切换成内核态,并启用操作系统。当有关工作完成之后,在系统调用后面的指令把控制权返回给用户程序。在本章的后面我们将具体解释系统调用过程,但是在这里,请读者把它看成是一个特别的过程调用指令,该指令具有从用户态切换到内核态的特别能力。作为排印上的说明,我们在行文中使用小写的Helvetica字体,表示系统调用,比如read。

有必要指出,计算机使用陷阱而不是一条指令来执行系统调用。其他的多数陷阱是由硬件引起的,用于警告有异常情况发生,诸如试图被零除或浮点下溢等。在所有的情况下,操作系统都得到控制权并决定如何处理异常情况。有时,由于出错的原因程序不得不停止。在其他情况下可以忽略出错(如下溢数可以被置为零)。最后,若程序已经提前宣布它希望处理某类条件时,那么控制权还必须返回给该程序,让其处理相关的问题。

多线程和多核芯片

Moore定律指出,芯片中晶体管的数量每18个月翻一番。这个“定律”并不是物理学上的某种规律,诸如动量守恒定律等,它是Intel公司的共同创始人Gordon Moore对半导体公司如何能快速缩小晶体管能力上的一个观察结果。Moore定律已经保持了30年,有希望至少再保持10年。

使用大量的晶体管引发了一个问题:如何处理它们呢?这里我们可以看到一种处理方式:具有多个功能部件的超标量体系结构。但是,随着晶体管数量的增加,再多晶体管也是可能的。一件由此而来的必然结果是,在CPU芯片中加入了更大的缓存,人们肯定会这样做,然而,原先获得的有用效果将最终消失掉。

显然,下一步不仅是有多个功能部件,某些控制逻辑也会出现多个。Pentium 4和其他一些CPU芯片就是这样做的,称为多线程(multithreading)或超线程(hyperthreading,这是Intel公司给出的名称)。近似地说,多线程允许CPU保持两个不同的线程状态,然后在纳秒级的时间尺度内来回切换。(线程是一种轻量级进程,也即一个运行中的程序。我们将在第2章中具体讨论)。例如,如果某个进程需要从内存中读出一个字(需要花费多个时钟周期),多线程CPU则可以切换至另一个线程。多线程不提供真正的并行处理。在一个时刻只有一个进程在运行,但是线程的切换时间则减少到纳秒数量级。

多线程对操作系统而言是有意义的,因为每个线程在操作系统看来就像是单个的CPU。考虑一个实际有两个CPU的系统,每个CPU有两个线程。这样操作系统将把它看成是4个CPU。如果在某个时间的特定点上,只有能够维持两个CPU忙碌的工作量,那么在同一个CPU上调度两个线程,而让另一个CPU完全空转,就没有优势了。这种选择远远不如在每个CPU上运行一个线程的效率高。Pentium 4的后继者,Core(还有Core 2)的体系结构并不支持超线程,但是Intel公司已经宣布,Core的后继者会具有超线程能力。

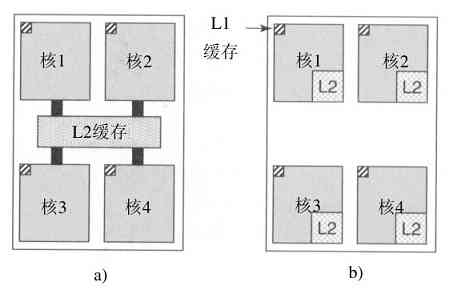

除了多线程,还出现了包含2个或4个完整处理器或内核的CPU芯片。图1-8中的多核芯片上有效地装有4个小芯片,每个小芯片都是一个独立的CPU。(后面将解释缓存。)要使用这类多核芯片肯定需要多处理器操作系统。

图 1-8 a)带有共享L2缓存的4核芯片;b)带有分离L2缓存的4核芯片

1.3.2 存储器

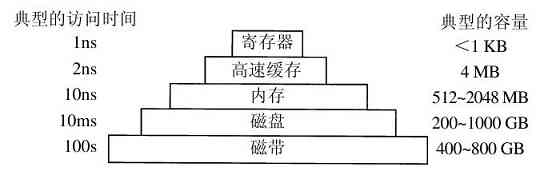

在任何一种计算机中的第二种主要部件都是存储器。在理想情形下,存储器应该极为迅速(快于执行一条指令,这样CPU不会受到存储器的限制),充分大,并且非常便宜。但是目前的技术无法同时满足这三个目标,于是出现了不同的处理方式。存储器系统采用一种分层次的结构,如图1-9所示。顶层的存储器速度较高,容量较小,与底层的存储器相比每位成本较高,其差别往往是十亿数量级。

图 1-9 典型的存储层次结构,图中的数据是非常粗略的估计

存储器系统的顶层是CPU中的寄存器。它们用与CPU相同的材料制成,所以和CPU一样快。显然,访问它们是没有时延的。其典型的存储容量是,在32位CPU中为32×32位,而在64位CPU中为64×64位。在这两种情形下,其存储容量都小于1 KB。程序必须在软件中自行管理这些寄存器(即决定如何使用它们)。

下一层是高速缓存,它多数由硬件控制。主存被分割成高速缓存行(cache line),其典型大小为64个字节,地址0至63对应高速缓存行0,地址64至127对应高速缓存行1,以此类推。最常用的高速缓存行放置在CPU内部或者非常接近CPU的高速缓存中。当某个程序需要读一个存储字时,高速缓存硬件检查所需要的高速缓存行是否在高速缓存中。如果是,称为高速缓存命中,缓存满足了请求,就不需要通过总线把访问请求送往主存。高速缓存命中通常需要两个时钟周期。高速缓存未命中就必须访问内存,这要付出大量的时间代价。由于高速缓存的价格昂贵,所以其大小有限。有些机器具有两级甚至三级高速缓存,每一级高速缓存比前一级慢且容量更大。

缓存在计算机科学的许多领域中起着重要的作用,并不仅仅只是RAM的缓存行。只要存在大量的资源可以划分为小的部分,那么,这些资源中的某些部分就会比其他部分更频繁地得到使用,通常缓存的使用会带来性能上的改善。操作系统一直在使用缓存。例如,多数操作系统在内存中保留频繁使用的文件(的一部分),以避免从磁盘中重复地调取这些文件。相似地,类似于

/home/ast/projects/minix3/src/kernel/clock.c

的长路径名转换成文件所在的磁盘地址的结果,也可以放入缓存,以避免重复寻找地址。还有,当一个Web页面(URL)的地址转换为网络地址(IP地址)后,这个转换结果也可以缓存起来以供将来使用。还有许多其他的类似的应用。

在任何缓存系统中,都有若干需要尽快考虑的问题,包括:

1)何时把一个新的内容放入缓存。

2)把新内容放在缓存的哪一行上。

3)在需要时,应该把哪个内容从缓存中移走。

4)应该把新移走的内容放在某个较大存储器的何处。

并不是每个问题的解决方案都符合每种缓存处理。对于CPU缓存中的主存缓存行,每当有缓存未命中时,就会调入新的内容。通常通过所引用内存地址的高位计算应该使用的缓存行。例如,对于64字节的4096缓存行,以及32位地址,其中6~17位用来定位缓存行,而0~5位则用来确定缓存行中的字节。在这个例子中,被移走内容的位置就是新数据要进入的位置,但是在有的系统中未必是这样。最后,当将一个缓存行的内容重写进主存时(该内容被缓存后,可能会被修改),通过该地址来惟一确定需重写的主存位置。

缓存是一种好方法,所以现代CPU中设计了两个缓存。第一级或称为L1缓存总是在CPU中,通常用来将已解码的指令调入CPU的执行引擎。对于那些频繁使用的数据字,多数芯片安排有第二个L1缓存。典型的L1缓存大小为16KB。另外,往往还设计有二级缓存,称为L2缓存,用来存放近来所使用过若干兆字节的内存字。L1和L2缓存之间的差别在于时序。对L1缓存的访问,不存在任何延时;而对L2缓存的访问,则会延时1或2个时钟周期。

在多核芯片中。设计师必须确定缓存的位置。在图1-8a中,一个L2缓存被所有的核共享。Intel多核芯片采用了这个方法。相反,在图1-8b中,每个核有其自己的L2缓存。AMD采用这个方法。不过每种策略都有自己的优缺点。例如,Intel的共享L2缓存需要有一种更复杂的缓存控制器,而AMD的方式在设法保持L2缓存一致性上存在困难。

在图1-9的层次结构中,再往下一层是主存。这是存储器系统的主力。主存通常称为随机访问存储器(Random Access Memory,RAM)。过去有时称之为磁芯存储器,因为在20世纪50年代和60年代,使用很小的可磁化的铁磁体制作主存。目前,存储器的容量在几百兆字节到若干吉字节之间,并且其容量正在迅速增长。所有不能在高速缓存中得到满足的访问请求都会转往主存。

除了主存之外,许多计算机已经在使用少量的非易失性随机访问存储器。它们与RAM不同,在电源切断之后,非易失性随机访问存储器并不丢失其内容。只读存储器(Read Only Memory,ROM)在工厂中就被编程完毕,然后再也不能被修改。ROM速度快且便宜。在有些计算机中,用于启动计算机的引导加载模块就存放在ROM中。另外,一些I/O卡也采用ROM处理底层设备控制。

EEPROM(Electrically Erasable PROM,电可擦除可编程ROM)和闪存(flash memory)也是非易失性的,但是与ROM相反,它们可以擦除和重写。不过重写它们需要比写入RAM更高数量级的时间,所以它们的使用方式与ROM相同,而其与众不同的特点使它们有可能通过字段重写的方式纠正所保存程序中的错误。

在便携式电子设备中,闪存通常作为存储媒介。闪存是数码相机中的胶卷,是便携式音乐播放器的磁盘,这仅仅是闪存用途中的两项。闪存在速度上介于RAM和磁盘之间。另外,与磁盘存储器不同,如果闪存擦除的次数过多,就被磨损了。

还有一类存储器是CMOS,它是易失性的。许多计算机利用CMOS存储器保持当前时间和日期。CMOS存储器和递增时间的时钟电路由一块小电池驱动,所以,即使计算机没有上电,时间也仍然可以正确地更新。CMOS存储器还可以保存配置参数,诸如,哪一个是启动磁盘等。之所以采用CMOS是因为它消耗的电能非常少,一块工厂原装的电池往往就能使用若干年。但是,当电池开始失效时,计算机就会出现“Alzheimer病症” [1] 计算机会忘记掉记忆多年的事物,比如应该由哪个磁盘启动等。

[1] 一种病因未明的原发退行性大脑疾病,以记忆受损为主要特征,是老年性痴呆中最常见的一种类型。——译者注

1.3.3 磁盘

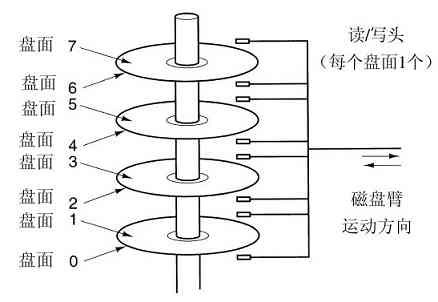

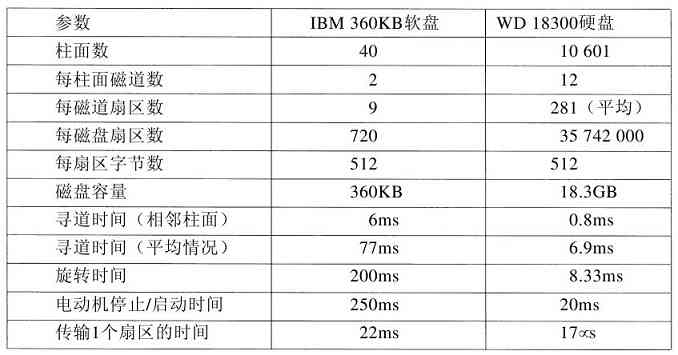

下一个层次是磁盘(硬盘)。磁盘同RAM相比,每个二进制位的成本低了两个数量级,而且经常也有两个数量级大的容量。磁盘惟一的问题是随机访问数据时间大约慢了三个数量级。其低速的原因是因为磁盘是一种机械装置,如图1-10所示。

图 1-10 磁盘驱动器的构造

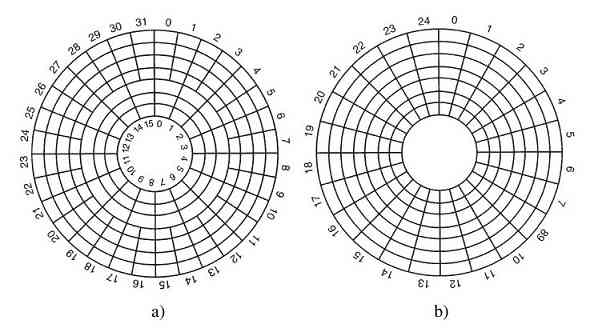

在一个磁盘中有一个或多个金属盘片,它们以5400,7200或10 800rpm的速度旋转。从边缘开始有一个机械臂悬横在盘面上,这类似于老式播放塑料唱片33转唱机上的拾音臂。信息写在磁盘上的一系列同心圆上。在任意一个给定臂的位置,每个磁头可以读取一段环形区域,称为磁道(track)。把一个给定臂的位置上的所有磁道合并起来,组成了一个柱面(cylinder)。

每个磁道划分为若干扇区,扇区的典型值是512字节。在现代磁盘中,较外面的柱面比较内部的柱面有更多的扇区。机械臂从一个柱面移到相邻的柱面大约需要1ms。而随机移到一个柱面的典型时间为5ms至10ms,其具体时间取决于驱动器。一旦磁臂到达正确的磁道上,驱动器必须等待所需的扇区旋转到磁头之下,这就增加了5ms至10ms的时延,其具体延时取决于驱动器的转速。一旦所需要的扇区移到磁头之下,就开始读写,低端硬盘的速率是5MB/s,而高速磁盘的速率是160 MB/s。

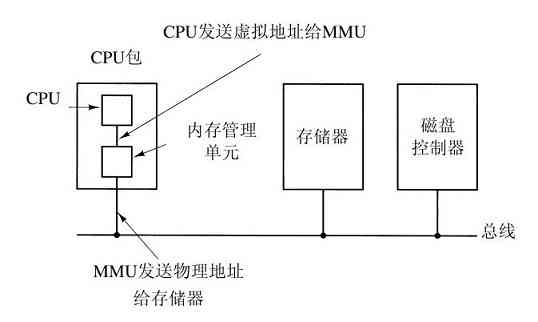

许多计算机支持一种著名的虚拟内存机制,这将在第3章中讨论。这种机制使得期望运行大于物理内存的程序成为可能,其方法是将程序放在磁盘上,而将主存作为一种缓存,用来保存最频繁使用的部分程序。这种机制需要快速地映像内存地址,以便把程序生成的地址转换为有关字节在RAM中的物理地址。这种映像由CPU中的一个部件,称为存储器管理单元(Memory Management Unit,MMU)来完成,如图1-6所示。

缓存和MMU的出现对系统的性能有着重要的影响。在多道程序系统中,从一个程序切换到另一个程序,有时称为上下文切换(context switch),有必要对缓存中来的所有修改过的块进行写回磁盘操作,并修改MMU中的映像寄存器。但是这两种操作的代价很昂贵,所以程序员们努力避免使用这些操作。我们稍后将看到这些操作产生的影响。

1.3.4 磁带

在存储器体系中的最后一层是磁带。这种介质经常用于磁盘的备份,并且可以保存非常大量的数据集。在访问磁带前,首先要把磁带装到磁带机上,可以人工安装也可用机器人安装(在大型数据库中通常安装有自动磁带处理设备)。然后,磁带可能还需要向前绕转以便读取所请求的数据块。总之,这一切工作要花费几分钟。磁带的最大特点是每个二进制位的成本极其便宜,并且是可移动的,这对于为了能在火灾、洪水、地震等灾害中存活下来,必须离线存储的备份磁带而言,是非常重要的。

我们已经讨论过的存储器体系结构是典型的,但是有的安装系统并不具备所有这些层次,或者有所差别(诸如光盘)。不过,在所有的系统中,当层次下降时,其随机访问时间则明显地增加,容量也同样明显地增加,而每个二进制位的成本则大幅度下降。其结果是,这种存储器体系结构似乎还要伴随我们多年。

1.3.5 I/O设备

CPU和存储器不是操作系统惟一需要管理的资源。I/O设备也与操作系统有密切的相互影响。如图1-6所示,I/O设备一般包括两个部分:设备控制器和设备本身。控制器是插在电路板上的一块芯片或一组芯片,这块电路板物理地控制设备。它从操作系统接收命令,例如,从设备读数据,并且完成数据的处理。

在许多情形下,对这些设备的控制是非常复杂和具体的,所以,控制器的任务是为操作系统提供一个简单的接口(不过还是很复杂的)。例如,磁盘控制器可以接受一个命令从磁盘2读出11206号扇区,然后,控制器把这个线性扇区号转化为柱面、扇区和磁头。由于外柱面比内柱面有较多的扇区,而且一些坏扇区已经被映射到磁盘的其他地方,所以这种转换将是很复杂的。磁盘控制器必须确定磁头臂应该在哪个柱面上,并对磁头臂发出一串脉冲使其前后移动到所要求的柱面号上,接着必须等待对应的扇区转动到磁头下面并开始读出数据,随着数据从驱动器读出,要消去引导块并计算校验和。最后,还得把输入的二进制位组成字并存放到存储器中。为了要完成这些工作,在控制器中经常安装一个小的嵌入式计算机,该嵌入式计算机运行为执行这些工作而专门编好的程序。

I/O设备的另一个部分是实际设备的自身。设备本身有个相对简单的接口,这是因为接口既不能做很多工作,又已经被标准化了。标准化是有必要的,这样任何一个IDE磁盘控制器就可以适应任一种IDE磁盘,例如,IDE表示集成驱动器电子设备(Integrated Drive Electronics),是许多计算机的磁盘标准。由于实际的设备接口隐藏在控制器中,所以,操作系统看到的是对控制器的接口,这个接口可能和设备接口有很大的差别。

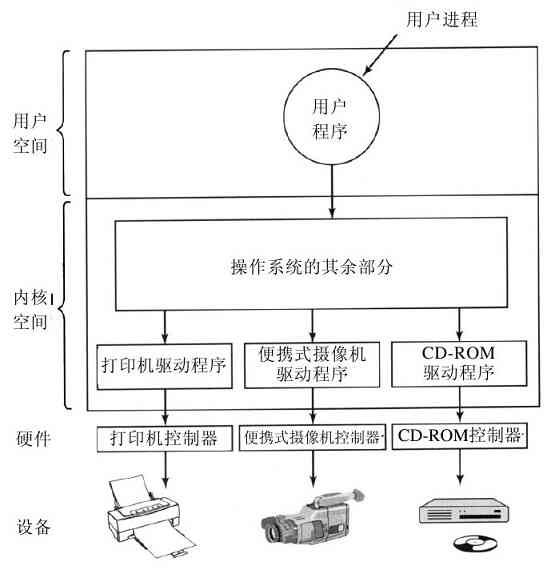

每类设备控制器都是不同的,所以,需要不同的软件进行控制。专门与控制器对话,发出命令并接收响应的软件,称为设备驱动程序(device driver)。每个控制器厂家必须为所支持的操作系统提供相应的设备驱动程序。例如,一台扫描仪会配有用于Windows 2000、Windows XP、Vista以及Linux的设备驱动程序。

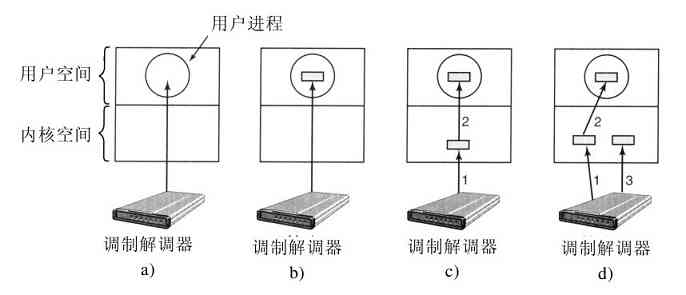

为了能够使用设备驱动程序,必须把设备驱动程序装入到操作系统中,这样它可在核心态中运行。理论上,设备驱动程序可以在内核外运行,但是几乎没有系统支持这种可能的方式,因为它要求允许在用户空间的设备驱动程序能够以控制的方式访问设备,这是一种极少得到支持的功能。要将设备驱动程序装入操作系统,有三个途径。第一个途径是将内核与设备驱动程序重新链接,然后重启动系统。许多UNIX系统以这种方式工作。第二个途径是在一个操作系统文件中设置一个入口,并通知该文件需要一个设备驱动程序,然后重启动系统。在系统启动时,操作系统去找寻所需的设备驱动程序并装载之。Windows就是以这种方式工作。第三种途径是,操作系统能够在运行时接受新的设备驱动程序并且立即将其安装好,无须重启动系统。这种方式采用的较少,但是这种方式正在变得普及起来。热插拔设备,诸如USB和IEEE1394设备(后面会讨论)都需要动态可装载设备驱动程序。

每个设备控制器都有少量的用于通信的寄存器。例如,一个最小的磁盘控制器也会有用于指定磁盘地址、内存地址、扇区计数和方向(读或写)的寄存器。要激活控制器,设备驱动程序从操作系统获得一条命令,然后翻译成对应的值,并写进设备寄存器中。所有设备寄存器的集合构成了I/O端口空间,我们将在第5章讨论有关内容。

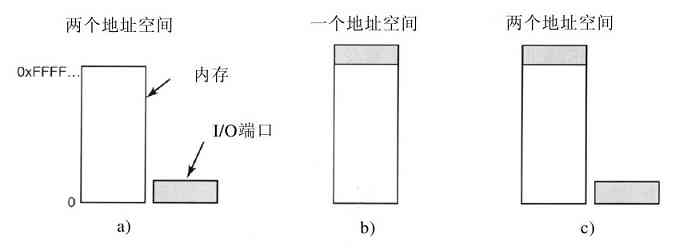

在有些计算机中,设备寄存器被映射到操作系统的地址空间(操作系统可使用的地址),这样,它们就可以像普通存储字一样读出和写入。在这种计算机中,不需要专门的I/O指令,用户程序可以被硬件阻挡在外,防止其接触这些存储器地址(例如,采用基址和界限寄存器)。在另外一些计算机中,设备寄存器被放入一个专门的I/O端口空间中,每个寄存器都有一个端口地址。在这些机器中,提供在内核态中可使用的专门IN和OUT指令,供设备驱动程序读写这些寄存器用。前一种方式不需要专门的I/O指令,但是占用了一些地址空间。后者不占用地址空间,但是需要专门的指令。这两种方式的应用都很广泛。

实现输入和输出的方式有三种。在最简单的方式中,用户程序发出一个系统调用,内核将其翻译成一个对应设备驱动程序的过程调用。然后设备驱动程序启动I/O并在一个连续不断的循环中检查该设备,看该设备是否完成了工作(一般有一些二进制位用来指示设备仍在忙碌中)。当I/O结束后,设备驱动程序把数据送到指定的地方(若有此需要),并返回。然后操作系统将控制返回给调用者。这种方式称为忙等待(busy waiting),其缺点是要占据CPU,CPU一直轮询设备直到对应的I/O操作完成。

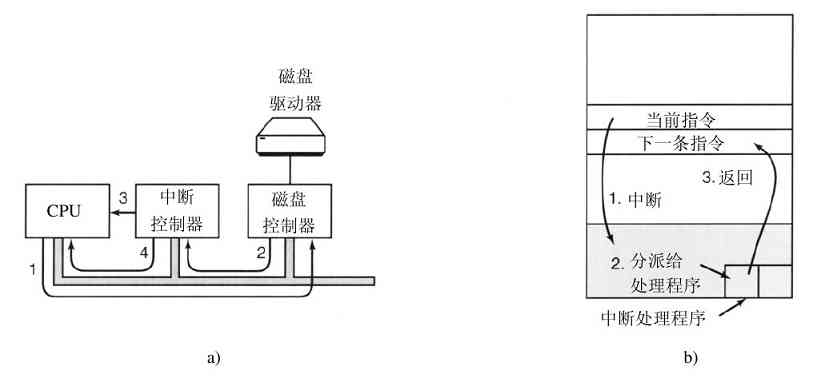

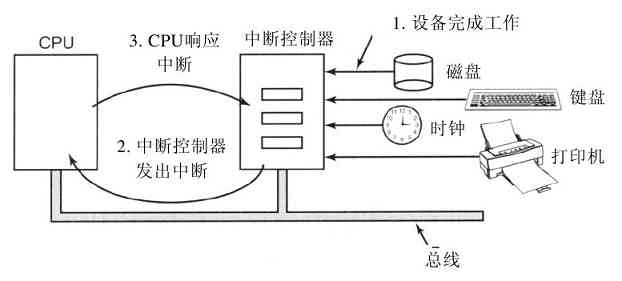

第二种方式是设备驱动程序启动设备并且让该设备在操作完成时发出一个中断。设备驱动程序在这个时刻返回。操作系统接着在需要时阻塞调用者并安排其他工作进行。当设备驱动程序检测到该设备的操作完毕时,它发出一个中断通知操作完成。

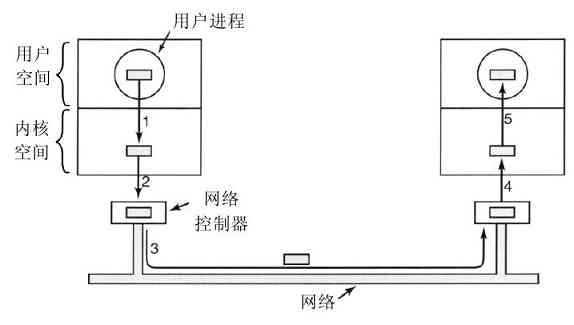

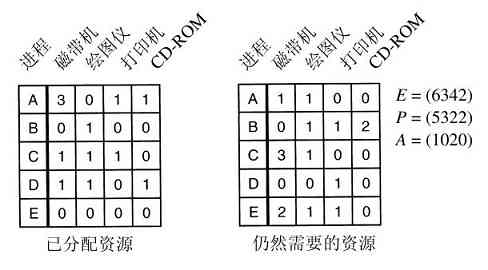

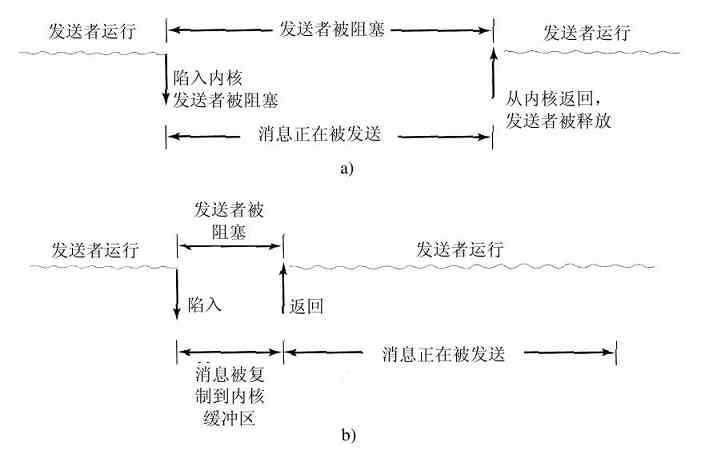

在操作系统中,中断是非常重要的,所以需要更具体地讨论。在图1-11a中,有一个I/O的三步过程。在第1步,设备驱动程序通过写设备寄存器通知设备控制器做什么。然后,设备控制器启动该设备。当设备控制器传送完毕被告知的要进行读写的字节数量后,它在第2步中使用特定的总线发信号给中断控制器芯片。如果中断控制器已经准备接收中断(如果正忙于一个更高级的中断,也可能不接收),它会在CPU芯片的一个管脚上声明,这就是第3步。在第4步中,中断控制器把该设备的编号放到总线上,这样CPU可以读总线,并且知道哪个设备刚刚完成了操作(可能同时有许多设备在运行)。

图 1-11 a)启动一个I/O设备并发出中断的过程;b)中断处理过程包括取中断、运行中断处理程序和返回到用户程序

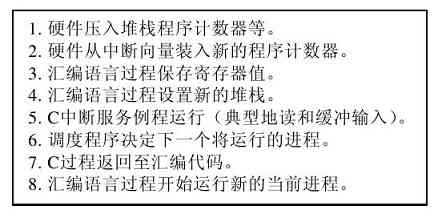

一旦CPU决定取中断,通常程序计数器和PSW就被压入当前堆栈中,并且CPU被切换到用户态。设备编号可以成为部分内存的一个引用,用于寻找该设备中断处理程序的地址。这部分内存称为中断向量(interrupt vector)。当中断处理程序(中断设备的设备驱动程序的一部分)开始后,它取走已入栈的程序计数器和PSW,并保存之,然后查询设备的状态。在中断处理程序全部完成之后,它返回到先前运行的用户程序中尚未执行的头一条指令。这些步骤如图1-11b所示。

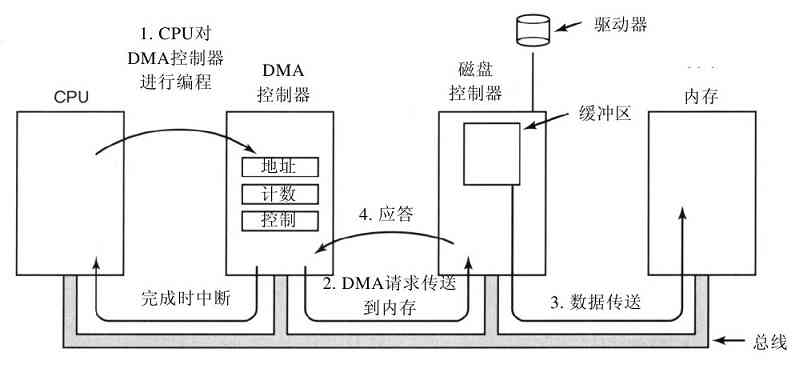

第三种方式是,为I/O使用一种特殊的直接存储器访问(Direct Memory Access,DMA)芯片,它可以控制在内存和某些控制器之间的位流,而无须持续的CPU干预。CPU对DMA芯片进行设置,说明需要传送的字节数、有关的设备和内存地址以及操作方向,接着启动DMA。当DMA芯片完成时,它引发一个中断,其处理方式如前所述。有关DMA和I/O硬件会在第5章中具体讨论。

中断经常会在非常不合适的时刻发生,比如,在另一个中断程序正在运行时发生。正由于此,CPU有办法关闭中断并在稍后再开启中断。在中断关闭时,任何已经发出中断的设备,可以继续保持其中断信号,但是CPU不会被中断,直至中断再次启用为止。如果在中断关闭时,已有多个设备发出了中断,中断控制器将决定先处理哪个中断,通常这取决于事先赋予每个设备的静态优先级。最高优先级的设备赢得竞争。

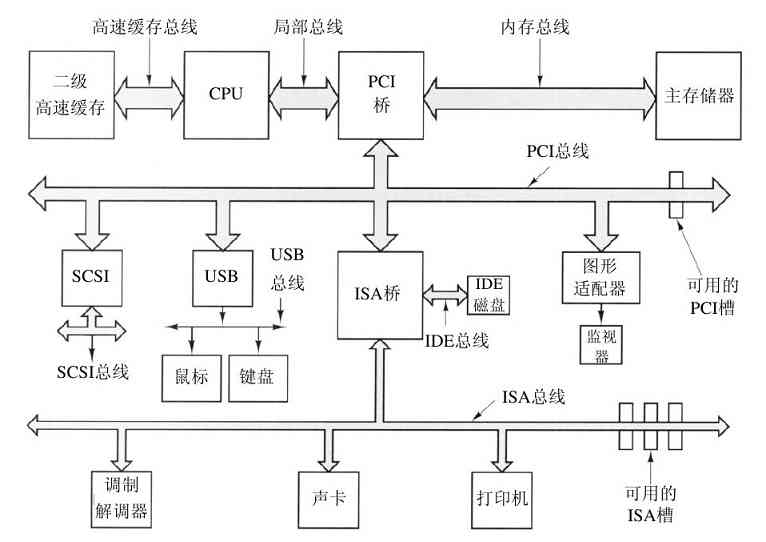

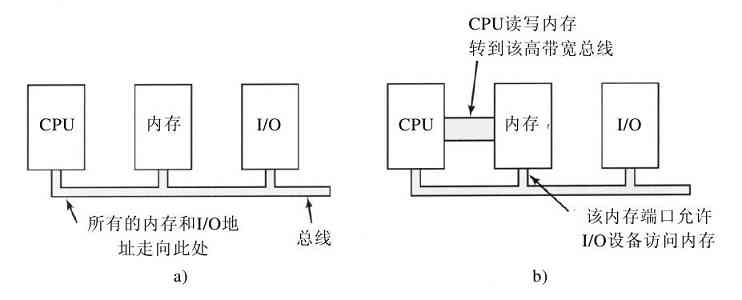

1.3.6 总线

图1-6中的结构在小型计算机中使用了多年,并也用在早期的IBM PC中。但是,随着处理器和存储器速度越来越快,到了某个转折点时,单总线(当然还有IBM PC总线)就很难处理总线的交通流量了,只有放弃。其结果是导致其他的总线出现,它们处理I/O设备以及CPU到存储器的速度都更快。这种演化的结果是,目前一台较大的Pentium系统的结构如图1-12所示。

图 1-12 大型Pentium系统的结构

图中的系统有8个总线(高速缓存、局部、内存、PCI、SCSI、USB、IDE和ISA),每个总线传输速度和功能都不同。操作系统必须了解所有总线的配置和管理。有两个主要的总线,即早期的IBM PC ISA(Industry Standard Architecture)总线和它的后继者PCI(Peripheral Component Interconnect)总线。ISA总线就是原先的IBM PC/AT总线,以8.33MHz频率运行,可并行传送2字节,最大速率为16.67MB/s。它还可与老式的慢速I/O卡向后兼容。PCI总线作为ISA总线的后继者由Intel公司发布。它可在66MHz频率运行,可并行传送8字节,数据速率为528MB/s。目前多数高速I/O设备采用PCI总线。由于有大量的I/O卡采用PCI总线,甚至许多非Intel计算机也使用PCI总线。现在,使用称为PCI Express的PCI总线升级版的新计算机已经出现。

在这种配置中,CPU通过局部总线与PCI桥芯片对话,而PCI桥芯片通过专门的存储总线与存储器对话,一般速率为100MHz。Pentium系统在芯片上有1级高速缓存,在芯片外有一个非常大的2级高速缓存,它通过高速缓存总线与CPU连接。

另外,在这个系统中有三个专门的总线:IDE、USB和SCSI。IDE总线将诸如磁盘和CD-ROM一类的外部设备与系统相连接。IDE总线是PC/AT的磁盘控制器接口的副产品,现在几乎成了所有基于Pentium系统的硬盘的标准,对于CD-ROM也经常是这样。

通用串行总线(Universal Serial Bus,USB)是用来将所有慢速I/O设备,诸如键盘和鼠标,与计算机连接。它采用一种小型四针连接器,其中两针为USB设备提供电源。USB是一种集中式总线,其根设备每1ms轮询一次I/O设备,看是否有信息收发。USB1.0可以处理总计为1.5MB/s的负载,而较新的USB2.0总线可以有60MB/s的速率。所有的USB设备共享一个USB设备驱动器,于是就不需要为新的USB设备安装新设备驱动器了。这样,无须重新启动就可以给计算机添加USB设备。

SCSI(Small Computer System Interface)总线是一种高速总线,用在高速硬盘、扫描仪和其他需要较大带宽的设备上。它最高可达320MB/s。自从其发布以来,SCSI总线一直用在Macintosh系统上,在UNIX和一些基于Intel的系统中也很流行。

还有一种总线(图1-12中没有展示)是IEEE 1394。有时,它称为火线(FireWire),严格来说,火线是苹果公司具体实现1394的名称。与USB一样,IEEE 1394是位串行总线,设计用于最快可达100MB/s的包传送中,它适合于将数码相机和类似的多媒体设备连接到计算机上。IEEE 1394与USB不同,不需要集中式控制器。

要在如图1-12展示的环境下工作,操作系统必须了解有些什么外部设备连接到计算机上,并对它们进行配置。这种需求导致Intel和微软设计了一种名为即插即用(plug and play)的I/O系统,这是基于一种首先被苹果Macintosh实现的类似概念。在即插即用之前,每块I/O卡有一个固定的中断请求级别和用于其I/O寄存器的固定地址,例如,键盘的中断级别是1,并使用0x60至0x64的I/O地址,软盘控制器是中断6级并使用0x3F0至0x3F7的I/O地址,而打印机是中断7级并使用0x378至0x37A的I/O地址等。

到目前为止,一切正常。比如,用户买了一块声卡和调制解调卡,并且它们都是可以使用中断4的,但此时,问题发生了,两块卡互相冲突,结果不能在一起工作。解决方案是在每块I/O卡上提供DIP开关或跳接器,并指导用户对其进行设置以选择中断级别和I/O地址,使其不会与用户系统的任何其他部件冲突。那些热衷于复杂PC硬件的十几岁的青少年们有时可以不出差错地做这类工作。但是,没有人能够不出错。

即插即用所做的工作是,系统自动地收集有关I/O设备的信息,集中赋予中断级别和I/O地址,然后通知每块卡所使用的数值。这项工作与计算机的启动密切相关,所以下面我们开始讨论计算机的启动。不过这不是件轻松的工作。

1.3.7 启动计算机

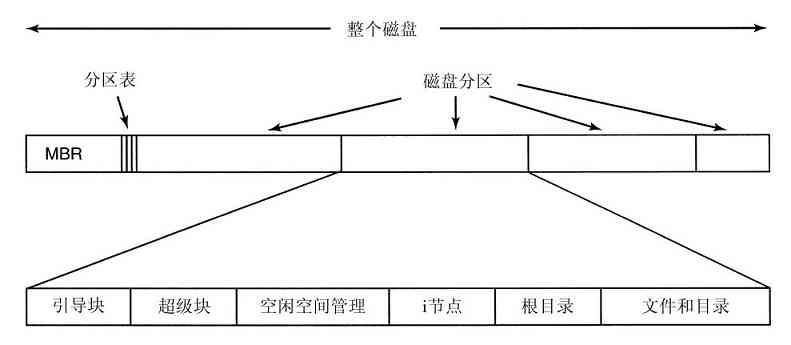

Pentium的简要启动过程如下。在每个Pentium上有一块双亲板(在政治上的纠正影响到计算机产业之前,它们曾称为“母板”)。在双亲板上有一个称为基本输入输出系统(Basic Input Output System,BIOS)的程序。在BIOS内有底层I/O软件,包括读键盘、写屏幕、进行磁盘I/O以及其他过程。现在这个程序存放在一块闪速RAM中,它是非可易失性的,但是在发现BIOS中有错时可以通过操作系统对它进行更新。

在计算机启动时,BIOS开始运行。它首先检查所安装的RAM数量,键盘和其他基本设备是否已安装并正常响应。接着,它开始扫描ISA和PCI总线并找出连在上面的所有设备。其中有些设备是典型的遗留设备(即在即插即用发明之前设计的),并且有固定的中断级别和I/O地址(也许能用在I/O卡上的开关和跳接器设置,但是不能被操作系统修改)。这些设备被记录下来。即插即用设备也被记录下来。如果现有的设备和系统上一次启动时的设备不同,则配置新的设备。

然后,BIOS通过尝试存储在CMOS存储器中的设备清单决定启动设备。用户可以在系统刚启动之后进入一个BIOS配置程序,对设备清单进行修改。典型地,如果存在软盘,则系统试图从软盘启动。如果失败则试用CD-ROM,看看是否有可启动CD-ROM存在。如果软盘和CD-ROM都没有,系统从硬盘启动。启动设备上的第一个扇区被读入内存并执行。这个扇面中包含一个对保存在启动扇面末尾的分区表检查的程序,以确定哪个分区是活动的。然后,从该分区读入第二个启动装载模块。来自活动分区的这个装载模块被读入操作系统,并启动之。

然后,操作系统询问BIOS,以获得配置信息。对于每种设备,系统检查对应的设备驱动程序是否存在。如果没有,系统要求用户插入含有该设备驱动程序的CD-ROM(由设备供应商提供)。一旦有了全部的设备驱动程序,操作系统就将它们调入内核。然后初始化有关表格,创建需要的任何背景进程,并在每个终端上启动登录程序或GUI。

1.4 操作系统大观园

操作系统已经存在了半个多世纪。在这段时期内,出现了各种类型的操作系统,并不是所有这些操作系统都很知名。本节中,我们将简要地介绍其中的9个。在本书的后面,我们还将回顾这些系统。

1.4.1 大型机操作系统

在操作系统的高端是用于大型机的操作系统,这些房间般大小的计算机仍然可以在一些大型公司的数据中心中见到。这些计算机与个人计算机的主要差别是其I/O处理能力。一台拥有1000个磁盘和上百万吉字节数据的大型机是很正常的;如果有这样的特性的一台个人计算机会使朋友们很羡慕。大型机也在高端的Web服务器、大型电子商务服务站点和事务-事务交易服务器上有某种程度的复活。

用于大型机的操作系统主要用于面向多个作业的同时处理,多数这样的作业需要巨大的I/O能力。系统主要提供三类服务:批处理、事务处理和分时处理。批处理系统处理不需要交互式用户干预的周期性作业。保险公司的索赔处理或连锁商店的销售报告通常就是以批处理方式完成的。事务处理系统负责大量小的请求,例如,银行的支票处理或航班预订。每个业务量都很小,但是系统必须每秒处理成百上千个业务。分时系统允许多个远程用户同时在计算机上运行作业,诸如在大型数据库上的查询。这些功能是密切相关的,大型机操作系统通常完成所有这些功能。大型机操作系统的一个例子是OS/390(OS/360的后继版本)。但是,大型机操作系统正在逐渐被诸如Linux这类UNIX的变体所替代。

1.4.2 服务器操作系统

下一个层次是服务器操作系统。它们在服务器上运行,服务器可以是大型的个人计算机、工作站,甚至是大型机。它们通过网络同时为若干个用户服务,并且允许用户共享硬件和软件资源。服务器可提供打印服务、文件服务或Web服务。Internet服务商们运行着许多台服务器机器,以支持他们的用户,使Web站点保存Web页面并处理进来的请求。典型的服务器操作系统有Solaris、FreeBSD、Linux和Windows Server 200x。

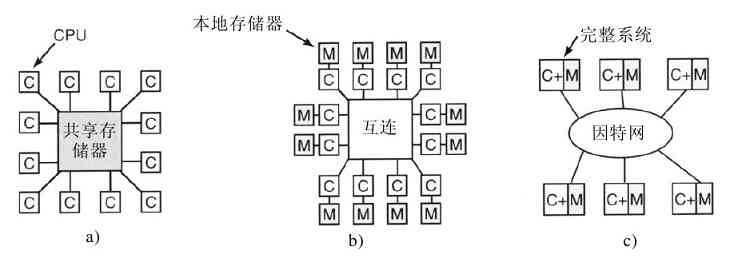

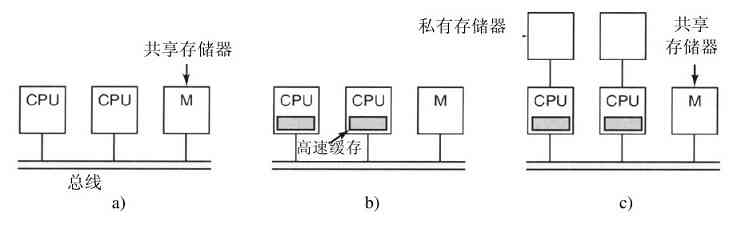

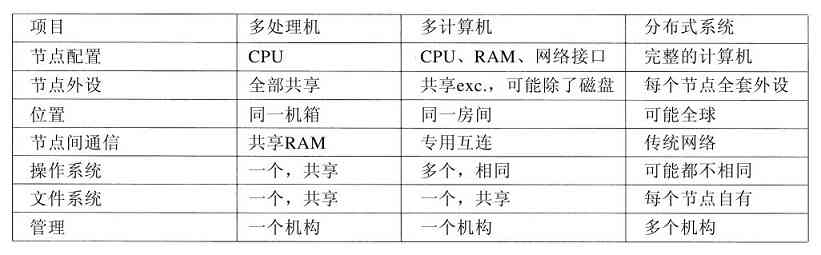

1.4.3 多处理器操作系统

一种获得大量联合计算能力的操作系统,其越来越常用的方式是将多个CPU连接成单个的系统。依据连接和共享方式的不同,这些系统称为并行计算机、多计算机或多处理器。它们需要专门的操作系统,不过通常采用的操作系统是配有通信、连接和一致性等专门功能的服务器操作系统的变体。

个人计算机中近来出现了多核芯片,所以常规的台式机和笔记本电脑操作系统也开始与小规模的多处理器打交道,而核的数量正在与时俱进。幸运的是,由于先前多年的研究,已经具备不少关于多处理器操作系统的知识,将这些知识运用到多核处理器系统中应该不存在困难。难点在于要有能够运用所有这些计算能力的应用。许多主流操作系统,包括Windows和Linux,都可以运行在多核处理器上。

1.4.4 个人计算机操作系统

接着一类是个人计算机操作系统。现代个人计算机操作系统都支持多道程序处理,在启动时,通常有十多个程序开始运行。它们的功能是为单个用户提供良好的支持。这类系统广泛用于字处理、电子表格、游戏和Internet访问。常见的例子是Linux、FreeBSD、Windows Vista和Macintosh操作系统。个人计算机操作系统是如此地广为人知,所以不需要再做介绍了。事实上,许多人甚至不知道还有其他的操作系统存在。

1.4.5 掌上计算机操作系统

随着系统越来越小型化,我们看到了掌上计算机。掌上计算机或者个人数字助理(Personal Digital Assistant,PDA)是一种可以装进衬衫口袋的小型计算机,它们可以实现少量的功能,诸如电子地址簿和记事本之类。而且,除了键盘和屏幕之外,许多移动电话与PDA几乎没有差别。在实际效果上,PDA和移动电话已经在逐渐融合,其差别主要在于大小、重量以及用户界面等方面。这些设备几乎都是基于带有保护模式的32位CPU,并且运行最尖端的操作系统。

运行在这些掌上设备上的操作系统正在变得越来越复杂,它们有能力处理移动电话、数码照相以及其他功能。多数设备还能运行第三方的应用。事实上,其中有些设备开始采用十年前的个人操作系统。掌上设备和PC机之间的主要差别是,前者没有若干GB的、不断变化的硬盘。在掌上设备上最主要的两个操作系统是Symbian OS和Plam OS。

1.4.6 嵌入式操作系统

嵌入式系统在用来控制设备的计算机中运行,这种设备不是一般意义上的计算机,并且不允许用户安装软件。典型的例子有微波炉、电视机、汽车、DVD刻录机、移动电话以及MP3播放器一类的设备。区别嵌入式系统与掌上设备的主要特征是,不可信的软件肯定不能在嵌入式系统上运行。用户不能给自己的微波炉下载新的应用程序——所有的软件都保存在ROM中。这意味着在应用程序之间不存在保护,这样系统就获得了某种简化。在这个领域中,主要的嵌入式操作系统有QNX和VxWorks等。

1.4.7 传感器节点操作系统

有许多用途需要配置微小传感器节点网络。这些节点是一种可以彼此通信并且使用无线通信基站的微型计算机。这类传感器网络可以用于建筑物周边保护、国土边界保卫、森林火灾探测、气象预测用的温度和降水测量、战场上敌方运动的信息收集等。

传感器是一种内建有无线电的电池驱动的小型计算机。它们能源有限,必须长时间工作在无人的户外环境中,通常是恶劣的环境条件下。其网络必须足够健壮,以允许个别节点失效。随着电池开始耗尽,这种失效节点会不断增加。

每个传感器节点是一个配有CPU、RAM、ROM以及一个或多个环境传感器的实实在在的计算机。节点上运行一个小型但是真实的操作系统,通常这个操作系统是事件驱动的,可以响应外部事件,或者基于内部时钟进行周期性的测量。该操作系统必须小且简单,因为这些节点的RAM很小,而且电池寿命是一个重要问题。另外,和嵌入式系统一样,所有的程序是预先装载的,用户不会突然启动从Internet上下载的程序,这样就使得设计大为简化。TinyOS是一个用于传感器节点的知名操作系统。

1.4.8 实时操作系统

另一类操作系统是实时操作系统。这些系统的特征是将时间作为关键参数。例如,在工业过程控制系统中,工厂中的实时计算机必须收集生产过程的数据并用有关数据控制机器。通常,系统还必须满足严格的最终时限。例如,汽车在装配线上移动时,必须在限定的时间内进行规定的操作。如果焊接机器人焊接得太早或太迟,都会毁坏汽车。如果某个动作必须绝对地在规定的时刻(或规定的时间范围)发生,这就是硬实时系统。可以在工业过程控制、民用航空、军事以及类似应用中看到很多这样的系统。这些系统必须提供绝对保证,让某个特定的动作在给定的时间内完成。

另一类实时系统是软实时系统,在这种系统中,偶尔违反最终时限是不希望的,但可以接受,并且不会引起任何永久性的损害。数字音频或多媒体系统就是这类系统。数字电话也是软实时系统。

由于在(硬)实时系统中满足严格的时限是关键,所以操作系统就是一个简单的与应用程序链接的库,各个部分必须紧密耦合并且彼此之间没有保护。这种类型的实时系统的例子有e-Cos。

掌上、嵌入式以及实时系统的分类之间有不少是彼此重叠的。几乎所有这些系统至少存在某种软实时情景。嵌入式和实时系统只运行系统设计师安装的软件用户不能添加自己的软件,这样就使得保护工作很容易。掌上和嵌入式系统是为普通消费者使用的,而实时系统则更多用于工业领域。无论怎样,这些系统确实存在一些共同点。

1.4.9 智能卡操作系统

最小的操作系统运行在智能卡上。智能卡是一种包含有一块CPU芯片的信用卡。它有非常严格的运行能耗和存储空间的限制。其中,有些智能卡只具有单项功能,诸如电子支付,但是其他的智能卡则可在同一块卡中拥有多项功能。它们是专用的操作系统。

有些智能卡是面向Java的。其含义是在智能卡的ROM中有一个Java虚拟机(Java Virtual Machine,JVM)解释器。Java小程序被下载到卡中并由JVM解释器解释。有些卡可以同时处理多个Java小程序,这就是多道程序,并且需要对它们进行调度。在两个或多个小程序同时运行时,资源管理和保护就成为突出的问题。这些问题必须由卡上的操作系统(通常是非常原始的)处理。

1.5 操作系统概念

多数操作系统都使用某些基本概念和抽象,诸如进程、地址空间以及文件等,它们是需要理解的中心。作为引论,在下面的几节中,我们将较为简要地分析这些基本概念中的一些成分。在本书的后面,我们将详细地讨论它们。为了说明这些概念,我们有时将使用示例,这些示例通常源自UNIX。不过,类似的例子在其他的操作系统中也明显地存在,进而,我们将在第11章中具体讨论Windows Vista。

1.5.1 进程

在所有操作系统中,一个重要的概念是进程(process)。进程本质上是正在执行的一个程序。与每个进程相关的是进程的地址空间(address space),这是从某个最小值的存储位置(通常是零)到某个最大值存储位置的列表。在这个地址空间中,进程可以进行读写。该地址空间中存放有可执行程序、程序的数据以及程序的堆栈。与每个进程相关的还有资源集,通常包括寄存器(含有程序计数器和堆栈指针)、打开文件的清单、突出的报警、有关进程清单,以及运行该程序所需要的所有其他信息。进程基本上是容纳运行一个程序所需要所有信息的容器。

进程的概念将在第2章详细讨论,不过,对进程建立一种直观感觉的最便利方式是分析一个分时系统。用户会启动一个视频编辑程序,并指令它按照某个格式转换一小时的视频(有时会花费数小时),然后离开去Web上冲浪。同时,一个被周期性唤醒,用来检查进来的e-mail的后台进程会开始运行。这样,我们就有了(至少)三个活动进程:视频编辑器、Web浏览器以及e-mail接收器。操作系统周期性地挂起一个进程然后启动运行另一个进程。例如,在过去的一秒钟内,第一个进程已使用完分配给它的时间片。

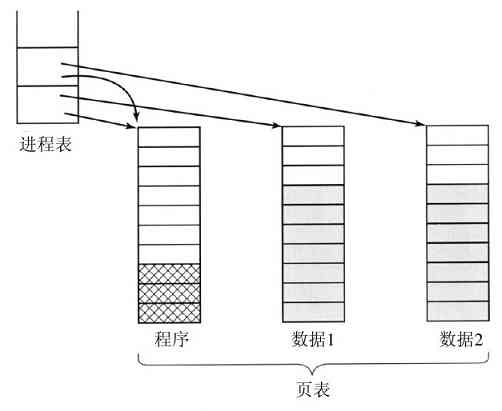

一个进程暂时被这样挂起后,在随后的某个时刻里,该进程再次启动时的状态必须与先前暂停时完全相同,这就意味着在挂起时该进程的所有信息都要保存下来。例如,为了同时读入信息,进程打开了若干文件。同每个被打开文件有关的是指向当前位置的指针(即下一个将读出的字节或记录)。在一个进程暂时被挂起时,所有这些指针都必须保存起来,这样在该进程重新启动之后,所执行的读调用才能读到正确的数据。在许多操作系统中,与一个进程有关的所有信息,除了该进程自身地址空间的内容以外,均存放在操作系统的一张表中,称为进程表(process table),进程表是数组(或链表)结构,当前存在的每个进程都要占用其中一项。

所以,一个(挂起的)进程包括:进程的地址空间,往往称作磁芯映像(core image,纪念过去年代中使用的磁芯存储器),以及对应的进程表项,其中包括寄存器以及稍后重启动该进程所需要的许多其他信息。

与进程管理有关的最关键的系统调用是那些进行进程创建和进程终止的系统调用。考虑一个典型的例子。有一个称为命令解释器(command interpreter)或shell的进程从终端上读命令。此时,用户刚键入一条命令要求编译一个程序。shell必须先创建一个新进程来执行编译程序。当执行编译的进程结束时,它执行一条系统调用来终止自己。

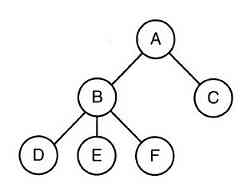

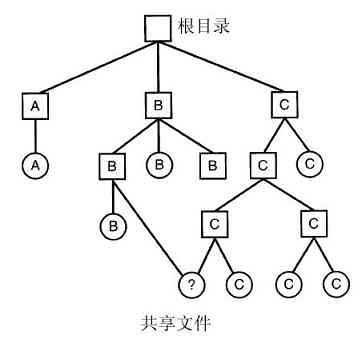

若一个进程能够创建一个或多个进程(称为子进程),而且这些进程又可以创建子进程,则很容易得到进程树,如图1-13所示。合作完成某些作业的相关进程经常需要彼此通信以便同步它们的行为。这种通信称为进程间通信(interprocess communication),将在第2章中详细讨论。

图 1-13 一个进程树。进程A创建两个子进程B和C,进程B创建三个子进程D、E和F

其他可用的进程系统调用包括:申请更多的内存(或释放不再需要的内存)、等待一个子进程结束、用另一个程序覆盖该程序等。

有时,需要向一个正在运行的进程传送信息,而该进程并没有等待接收信息。例如,一个进程通过网络向另一台机器上的进程发送消息进行通信。为了保证一条消息或消息的应答不会丢失,发送者要求它所在的操作系统在指定的若干秒后给一个通知,这样如果对方尚未收到确认消息就可以进行重发。在设定该定时器后,程序可以继续做其他工作。

在限定的秒数流逝之后,操作系统向该进程发送一个警告信号(alarm signal)。此信号引起该进程暂时挂起,无论该进程正在做什么,系统将其寄存器的值保存到堆栈,并开始运行一个特别的信号处理过程,比如重新发送可能丢失的消息。这些信号是软件模拟的硬件中断,除了定时器到期之外,该信号可以由各种原因产生。许多由硬件检测出来的陷阱,诸如执行了非法指令或使用了无效地址等,也被转换成该信号并交给这个进程。

系统管理器授权每个进程使用一个给定的UID标识(User IDentification)。每个被启动的进程都有一个启动该进程的用户UID。子进程拥有与父进程一样的UID。用户可以是某个组的成员,每个组也有一个GID标识(Group IDentification)。

在UNIX中,有一个UID称为超级用户(superuser),具有特殊的权利,可以违背一些保护规则。在大型系统中,只有系统管理员掌握着成为超级用户的密码,但是许多普通用户(特别是学生)们做出可观的努力试图找出系统的缺陷,从而使他们不用密码就可以成为超级用户。

在第2章中,我们将讨论进程、进程间通信以及有关的内容。

1.5.2 地址空间

每台计算机都有一些主存,用来保存正在执行的程序。在非常简单的操作系统中,内存中一次只能有一个程序。如果要运行第二个程序,第一个程序就必须被移出内存,再把第二个程序装入内存。

较复杂的操作系统允许在内存中同时运行多道程序。为了避免它们彼此互相干扰(包括操作系统),需要有某种保护机制。虽然这种机制必然是硬件形式的,但是它由操作系统掌控。

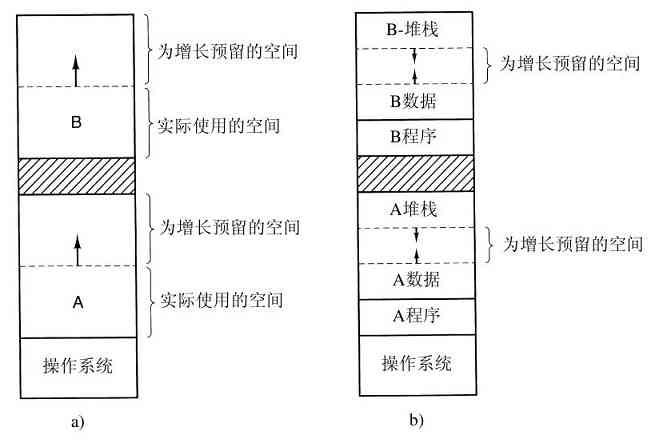

上述的观点涉及对计算机主存的管理和保护。另一种不同的但是同样重要并与存储器有关的内容,是管理进程的地址空间。通常,每个进程有一些可以使用的地址集合,典型值从0开始直到某个最大值。在最简单的情形下,一个进程可拥有的最大地址空间小于主存。在这种方式下,进程可以用满其地址空间,而且内存中也有足够的空间容纳该进程。

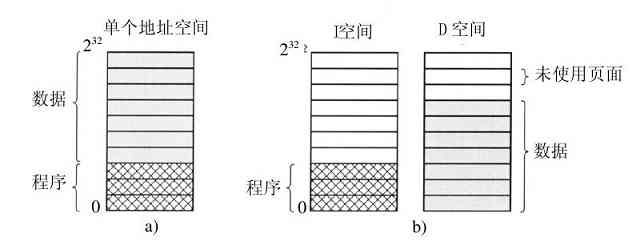

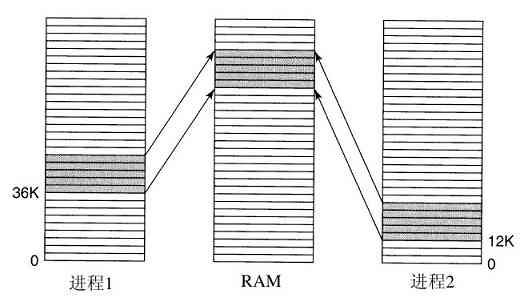

但是,在许多32位或64位地址的计算机中,分别有232 或264 字节的地址空间。如果一个进程有比计算机拥有的主存还大的地址空间,而且该进程希望使用全部的内存,那怎么办呢?在早期的计算机中,这个进程只好承认坏运气了。现在,有了一种称为虚拟内存的技术,正如前面已经介绍过的,操作系统可以把部分地址空间装入主存,部分留在磁盘上,并且在需要时穿梭交换它们。在本质上,操作系统创建了一个地址空间的抽象,作为进程可以引用地址的集合。该地址空间与机器的物理内存解耦,可能大于也可能小于该物理空间。对地址空间和物理空间的管理组成了操作系统功能的一个重要部分,本书中整个第3章都与这个主题有关。

1.5.3 文件

实际上,支持操作系统的另一个关键概念是文件系统。如前所述,操作系统的一项主要功能是隐藏磁盘和其他I/O设备的细节特性,并提供给程序员一个良好、清晰的独立于设备的抽象文件模型。显然,创建文件、删除文件、读文件和写文件等都需要系统调用。在文件可以读取之前,必须先在磁盘上定位和打开文件,在文件读过之后应该关闭该文件,有关的系统调用则用于完成这类操作。

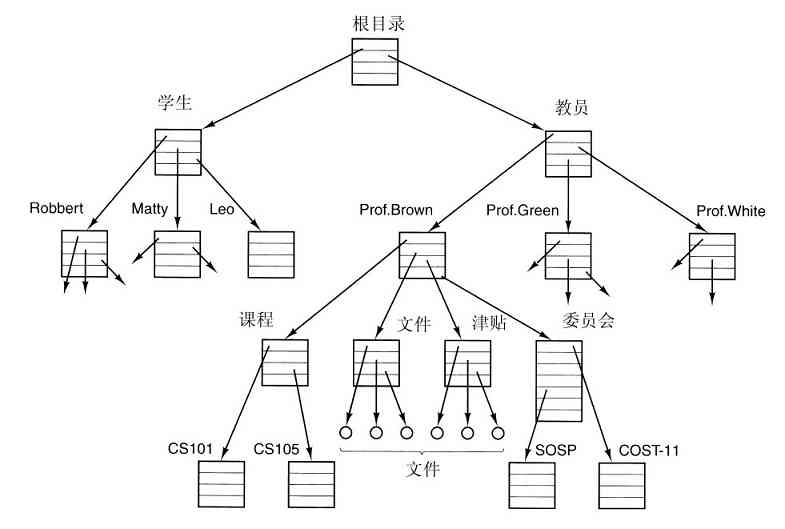

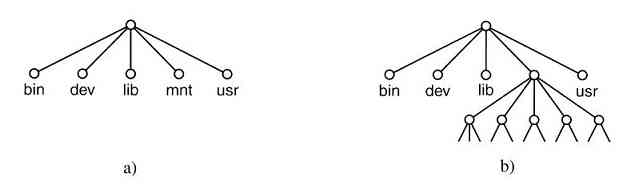

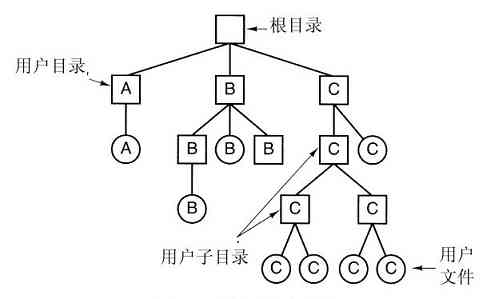

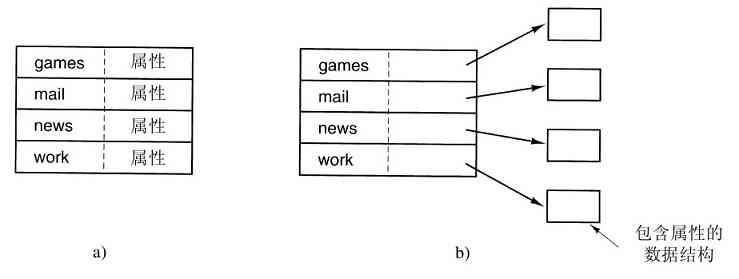

为了提供保存文件的地方,大多数操作系统支持目录(directory)的概念,从而可把文件分类成组。比如,学生可给所选的每个课程创建一个目录(用于保存该课程所需的程序),另设一个目录存放电子邮件,再有一个目录用于保存万维网主页。这就需要系统调用创建和删除目录、将已有的文件放入目录中、从目录中删除文件等。目录项可以是文件或者目录,这样就产生了层次结构——文件系统,如图1-14所示。

图 1-14 大学院系的文件系统

进程和文件层次都可以组织成树状结构,但这两种树状结构有不少不同之处。一般进程的树状结构层次不深(很少超过三层),而文件树状结构的层次常常多达四层、五层或更多层。进程树层次结构是暂时的,通常最多存在几分钟,而目录层次则可能存在数年之久。进程和文件在所有权及保护方面也是有区别的。典型地,只有父进程能控制和访问子进程,而在文件和目录中通常存在一种机制,使文件所有者之外的其他用户也可以访问该文件。

目录层结构中的每一个文件都可以通过从目录的顶部,即根目录(root directory)开始的路径名(path name)来确定。绝对路径名包含了从根目录到该文件的所有目录清单,它们之间用正斜线隔开。如在图1-14中,文件CS101路径名是/Faculty/Prof.Brown/Courses/CS101。最开始的正斜线表示这是从根目录开始的绝对路径。顺便提及,在MS-DOS和Windows中,用反斜线(\)字符作为分隔符,替代了正斜线(/),这样,上面给出的文件路径会写为\Faculty\Prof.Brown\Courses\CS101。在本书中,我们一般使用路径的UNIX惯例。

在实例中,每个进程有一个工作目录(working directory),其中,路径名不以斜线开始。如在图1-14中的例子,如果/Faculty/Prof.Brown是工作目录,那么Courses/CS101与上面给定的绝对路径名表示的是同一个文件。进程可以通过使用系统调用指定新的工作目录,从而变更其工作目录。

在读写文件之前,首先要打开文件,检查其访问权限。若权限许可,系统将返回一个小整数,称作文件描述符(file descriptor),供后续操作使用。若禁止访问,系统则返回一个错误码。

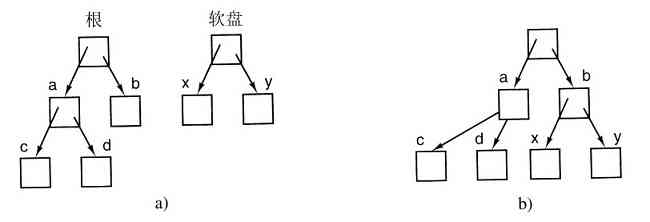

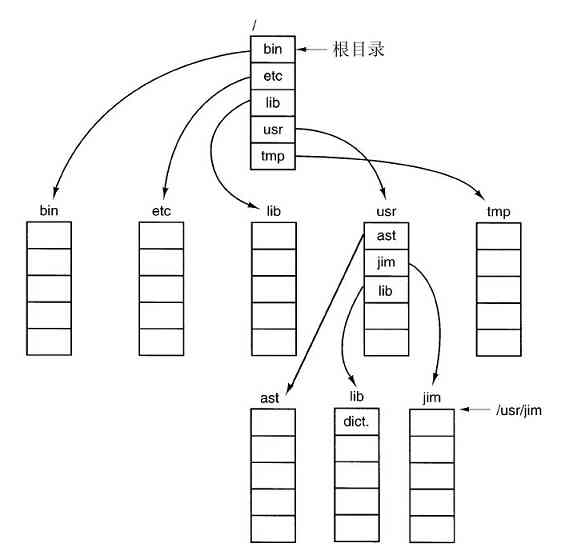

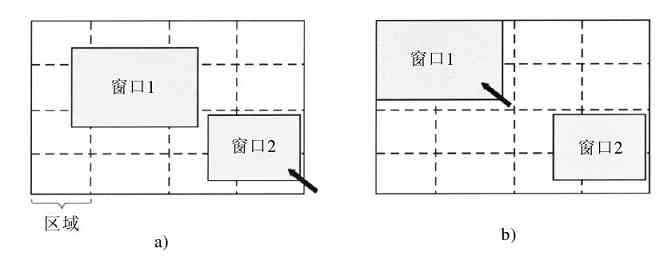

在UNIX中的另一个重要概念是安装文件系统。几乎所有的个人计算机都有一个或多个光盘驱动器,可以插入CD-ROM和DVD。它们几乎都有USB接口,可以插入USB存储棒(实际是固态磁盘驱动器)。为了提供一个出色的方式处理可移动介质,UNIX允许把在CD-ROM或DVD上的文件系统接入到主文件树上。考虑图1-15a的情形。在mount调用之前,根文件系统在硬盘上,而第二个文件系统在CD-ROM上,它们是分离的和无关的。

图 1-15 a)在安装前,驱动器0上的文件不可访问;b)在安装后,它们成了文件层次的一部分

然而,不能使用在CD-ROM上的文件系统,因为上面没有可指定的路径。UNIX不允许在路径前面加上驱动器名称或代码,那样做就完全成了设备相关类型了,这是操作系统应该消除的。代替的方法是,mount系统调用允许把在CD-ROM上的文件系统连接到程序所希望的根文件系统上。在图1-15b中,CD-ROM上的文件系统安装到了目录b上,这样就允许访问文件/b/x以及/b/y。如果当CD-ROM安装好,目录b中有任何不能访问的文件,则是因为/b指向了CD-ROM的根目录。(在开始时,不能访问这些文件似乎并不是一个严重问题:文件系统几乎总是安装在空目录上。)如果系统有多个硬盘,它们也可以都安装在单个树上。

在UNIX中,另一个重要的概念是特殊文件(special file)。提供特殊文件是为了使I/O设备看起来像文件一般。这样,就像使用系统调用读写文件一样,I/O设备也可通过同样的系统调用进行读写。有两类特殊文件:块特殊文件(block special file)和字符特殊文件(character special file)。块特殊文件指那些由可随机存取的块组成的设备,如磁盘等。比如打开一个块特殊文件,然后读第4块,程序可以直接访问设备的第4块而不必考虑存放该文件的文件系统结构。类似地,字符特殊文件用于打印机、调制解调器和其他接收或输出字符流的设备。按照惯例,特殊文件保存在/dev目录中。例如,/dev/lp是打印机(曾经称为行式打印机)。

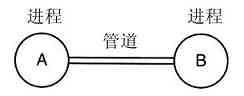

在本节中讨论的最后一个特性既与进程有关也与文件有关:管道。管道(pipe)是一种虚文件,它可连接两个进程,如图1-16所示。如果进程A和B希望通过管道对话,它们必须提前设置该管道。当进程A想对进程B发送数据时,它把数据写到管道上,仿佛管道就是输出文件一样。进程B可以通过读该管道而得到数据,仿佛该管道就是一个输入文件一样。这样,在UNIX中两个进程之间的通信就很类似于普通文件的读写了。更为强大的是,若进程要想发现它所写入的输出文件不是真正的文件而是管道,则需要使用特殊的系统调用。文件系统是非常重要的。我们将在第6章,以及第10章和第11章中具体讨论它们。

图 1-16 由管道连接的两个进程

1.5.4 输入/输出

所有的计算机都有用来获取输入和产生输出的物理设备。毕竟,如果用户不能告诉计算机该做什么,而在计算机完成了所要求的工作之后竟不能得到结果,那么计算机还有什么用处呢?有各种类型的输入和输出设备,包括键盘、显示器、打印机等。对这些设备的管理全然依靠操作系统。

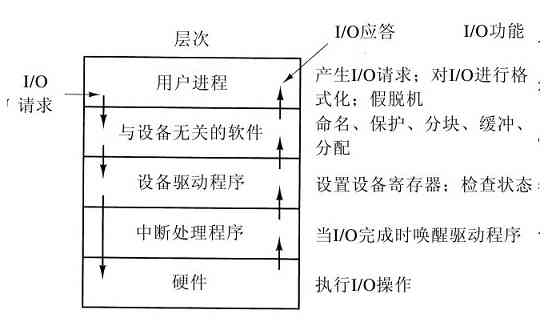

所以,每个操作系统都有管理其I/O设备的I/O子系统。某些I/O软件是设备独立的,即这些I/O软件部分可以同样应用于许多或者全部的I/O设备上。I/O软件的其他部分,如设备驱动程序,是专门为特定的I/O设备设计的。在第5章中,我们将讨论I/O软件。

1.5.5 保护

计算机中有大量的信息,用户经常希望对其进行保护,并保守秘密。这些信息可包括电子邮件、商业计划、退税等诸多内容。管理系统的安全性完全依靠操作系统,例如,文件仅供授权用户访问。

作为一个简单的例子,以便读者对如何实现安全有一个概念,请考察UNIX。UNIX操作系统通过对每个文件赋予一个9位的二进制保护代码,对UNIX中的文件实现保护。该保护代码有三个3位字段,一个用于所有者,一个用于所有者同组(用户被系统管理员划分成组)中的其他成员,而另一个用于其他人。每个字段中有一位用于读访问,一位用于写访问,一位用于执行访问。这些位就是知名的rwx位。例如,保护代码rwxr-x–x的含义是所有者可以读、写或执行该文件,其他的组成员可以读或执行(但不能写)该文件,而其他人可以执行(但不能读和写)该文件。对一个目录而言,x的含义是允许查询。一条短横线的含义是,不存在对应的许可。

除了文件保护之外,还有很多有关安全的问题存在。保护系统不被人类或非人类(如病毒)入侵,则是其中之一。我们将在第9章中研究各种安全性问题。

1.5.6 shell

操作系统是进行系统调用的代码。编辑器、编译器、汇编程序、链接程序以及命令解释器等,尽管非常重要,也非常有用,但是它们确实不是操作系统的组成部分。为了避免可能发生的混淆,本节将大致介绍一下UNIX的命令解释器,称为shell。尽管shell本身不是操作系统的一部分,但它体现了许多操作系统的特性,并很好地说明了系统调用的具体用法。shell同时也是终端用户与操作系统之间的界面,除非用户使用的是一个图形用户界面。有许多种类的shell,如sh、csh、ksh以及bash等。它们全部支持下面所介绍的功能,这些功能可追溯到早期的shell(即sh)。

用户登录时,同时启动了一个shell。它以终端作为标准输入和标准输出。首先显示提示符(prompt),它可能是一个美元符号,提示用户shell正在等待接收命令。假如用户键入

date

于是shell创建一个子进程,并运行date程序作为子进程。在该子进程运行期间,shell等待它结束。在子进程结束后,shell再次显示提示符,并等待下一行输入。

用户可以将标准输出重定向到一个文件,如键入:

date>file

同样地,也可以将标准输入重定向,如:

sort<file1>file2

该命令调用sort程序,从file1中取得输入,输出送到file2。

可以将一个程序的输出通过管道作为另一程序的输入,因此有

cat file1 file2 file3|sort>/dev/lp

所调用的cat程序将这三个文件合并,其结果送出到sort程序并按字典排序。sort的输出又被重定向到文件/dev/lp中,显然,这是打印机。

如果用户在命令后加上一个“&”符号,则shell将不等待其结束,而直接显示出提示符。所以

cat file1 file2 file3|sort>/dev/lp&

将启动sort程序作为后台任务执行,这样就可以允许用户继续工作,而sort命令也继续进行。shell还有许多其他有用的特性,由于篇幅有限而不能在这里讨论。有许多UNIX的书籍具体地讨论了shell(例如,Kernighan和Pike,1984;Kochan和Wood,1990;Medinets,1999;Newham和Rosenblatt,1998;Robbins,1999)。

现在,许多个人计算机使用GUI。事实上,GUI与shell类似,GUI只是一个运行在操作系统顶部的程序。在Linux系统中,这个事实更加明显,因为用户(至少)可以在两个GUI中选择一个:Gnome和KDE,或者干脆不用(使用X11上的终端视窗)。在Windows中也有可能用不同的程序代替标准的GUI桌面(Windows Explorer),这可以通过修改注册表中的某些数值实现,不过极少有人这样做。

1.5.7 个体重复系统发育

在达尔文的《物种起源》(On the Origin of the Species)一书出版之后,德国动物学家Ernst Haeckel论述了“个体重复系统发育”(ontogeny recapitulates phylogeny)。他这句话的含义是,一个个体重复着物种的演化过程。换句话说,在一个卵子受精之后,成为人体之前,这个卵子要经过是鱼、是猪等阶段。现代生物学家认为这是一种粗略的简化,不过这种观点仍旧包含了真理的内核部分。

在计算机的历史中,类似情形依稀发生。每个新物种(大型机、小型计算机、个人计算机、掌上、嵌入式计算机、智能卡等),无论是硬件还是软件,似乎都要经过它们前辈的发展阶段。计算机科学和许多领域一样,主要是由技术驱动的。古罗马人缺少汽车的原因不是因为他们非常喜欢步行,是因为他们不知道如何造汽车。个人计算机的存在,不是因为成百万的人们有几个世纪被压抑的拥有一台计算机的愿望,而是因为现在可以很便宜地制造它们。我们常常忘了技术是如何影响着我们对各种系统的观点,所以有时值得再仔细考虑它们。

特别地,技术的变化会导致某些思想过时并迅速消失,这种情形经常发生。但是,技术的另一种变化还可能再次复活某些思想。在技术的变化影响了某个系统不同部分之间的相对性能时,情况就会是这样。例如,当CPU远快于存储器时,为了加速“慢速”的存储器,高速缓存是很重要的。某一天,如果新的存储器技术使得存储器远快于CPU时,高速缓存就会消失。而如果新的CPU技术又使CPU远快于存储器时,高速缓存就会再次出现。在生物学上,消失是永远的,但是在计算机科学中,这一种消失有时不过只有几年时间。

在本书中,暂时消失的结果会造成我们有时需要反复考察一些“过时”的概念,即那些在当代技术中并不理想的思想。而技术的变化会把一些“过时概念”带回来。正由于此,更重要的是要理解为什么一个概念会过时,而什么样环境的变化又会启用“过时概念”。

为了把这个观点叙述得更透彻,我们考虑一些例子。早期计算机采用了硬连线指令集。这种指令可由硬件直接执行,且不能改变。然后出现了微程序设计(首先在IBM 360上大规模引入),其中的解释器执行软件中的指令。于是硬连线执行过时了,因为不够灵活。接着发明了RISC计算机,微程序设计(即解释执行)过时了,这是因为直接执行更快。而在通过Internet发送并且到达时才解释的Java小程序形式中,我们又看到了解释执行的复苏。执行速度并不总是关键因素,但由于网络的时间延迟是如此之大,以至于它成了主要因素。这样,钟摆在直接执行和解释之间已经晃动了好几个周期,也许在未来还会再次晃动。

1.大型内存

现在来分析硬件的某些历史发展过程,并看看硬件是如何重复地影响软件的。第一代大型机内存有限。在1959年至1964年之间,称为“山寨王”的IBM 7090或7094满载也只有128KB多的内存。该机器多数用汇编语言编程,为了节省内存,其操作系统用汇编语言编写。

随着时代的前进,在汇编语言宣告过时时,FORTRAN和COBOL一类语言的编译器已经足够好了。但是在第一个商用小型计算机(PDP-1)发布时,却只有4096个18位字的内存,而且令人吃惊的是,汇编语言又回来了。最终,小型计算机获得了更多的内存,而且高级语言也在小型机上盛行起来。

在20世纪80年代早期,微型计算机出现时,第一批机器只有4 KB内存,汇编语言又复活了。嵌入式计算机经常使用和微型计算机一样的CPU芯片(8080、Z80、后来的8086)而且一开始也使用汇编编程。现在,它们的后代,个人计算机拥有大量的内存,使用C、C++、Java和其他高级语言编程。智能卡正在走着类似的发展道路,而且除了确定的大小之外,智能卡通常使用Java解释器,解释执行Java程序,而不是将Java编译成为智能卡的机器语言。

2.保护硬件

早期的IBM 7090/7094一类大型机,没有保护硬件,所以这些机器一次只运行一个程序。一个有问题的程序就可能毁掉操作系统,并且很容易使机器崩溃。在IBM 360发布时,提供了保护硬件的原型,这些机器可以在内存中同时保持若干程序,并让它们轮流运行(多道程序处理)。于是单道程序处理宣告过时。

至少是到了第一个小型计算机出现时——还没有保护硬件——所以多道程序处理也不可能有。尽管PDP-1和PDP-8没有保护硬件,但是PDP-11型机器有了保护硬件,这一特点导致了多道程序处理的应用,并且最终导致UNIX操作系统的诞生。

在建造第一代微型计算机时,使用了Intel 8080 CPU芯片,但是没有保护硬件,这样我们又回到了单道程序处理。直到Intel 80286才增加了保护硬件,于是有了多道程序处理。直到现在,许多嵌入式系统仍旧没有保护硬件,而且只运行单个程序。

现在来考察操作系统。第一代大型机原本没有保护硬件,也不支持多道程序处理,所以这些机器只运行简单的操作系统,一次手工只能装载一个程序。后来,大型机有了保护硬件,操作系统可以同时支持运行多个程序,接着系统拥有了全功能的分时能力。

在小型计算机刚出现时,也没有保护硬件,一次只运行一个手工装载的程序。逐渐地,小型机有了保护硬件,有了同时运行两个或更多程序的能力。第一代微型计算机也只有一次运行一个程序的能力,但是随后具有了多道程序的能力。掌上计算机和智能卡也走着类似的发展之路。

在所有这些案例中,软件的发展是受制于技术的。例如,第一代微型计算机有约4KB内存,没有保护硬件。高级语言和多道程序处理对于这种小系统而言,无法获得支持。随着微型计算机演化成为现代个人计算机,拥有了必要的硬件,从而有了必须的软件处理以支持多种先进的功能。这种演化过程看来还要继续多年。其他的领域也有类似的这种轮回现象,但是在计算机行业中,这种轮回现象似乎变化得更快。

3.硬盘

早期大型机主要是基于磁带的。机器从磁带上读入程序、编译、运行,并把结果写到另一个磁带上。那时没有磁盘也没有文件系统的概念。在IBM于1956年引入第一个磁盘——RAMAC(RAndoM ACcess)之后,事情开始变化。这个磁盘占据4平方米空间,可以存储5百万7位长的字符,这足够存储一张中等分辨率的数字照片。但是其年租金高达35 000美元,比存储占据同样空间数量的胶卷还要贵。不过这个磁盘的价格终于还是下降了,并开始出现了原始的文件系统。

拥有这些新技术的典型机器是CDC 6600,该机器于1964年发布,在多年之内始终是世界上最快的计算机。用户可以通过指定名称的方式创建所谓“永久文件”,希望这个名称还没有被别人使用,比如“data”就是一个适合于文件的名称。这个系统使用单层目录。后来在大型机上开发出了复杂的多层文件系统,MULTICS文件系统可以算是多层文件系统的顶峰。

接着小型计算机投入使用,该机型最后也有了硬盘。1970年在PDP-11上引入了标准硬盘,RK05磁盘,容量为2.5MB,只有IBM RAMAC一半的容量,但是这个磁盘的直径只有40厘米,5厘米高。不过,其原型也只有单层目录。随着微型计算机的出现,CP/M开始成为操作系统的主流,但是它也只是在(软)盘上支持单目录。

4.虚拟内存

虚拟内存(安排在第3章中讨论),通过在RAM和磁盘中反复移动信息块的方式,提供了运行比机器物理内存大的程序能力。虚拟内存也经历了类似的历程,首先出现在大型机上,然后是小型机和微型机。虚拟内存还使得程序可以在运行时动态地链接库,而不是必须在编译时链接。MULTICS是第一个可以做到这点的系统。最终,这个思想传播到所有的机型上,现在广泛用于多数UNIX和Windows系统中。

在所有这些发展过程中,我们看到,在一种环境中出现的思想,随着环境的变化被抛弃(汇编语言设计,单道程序处理,单层目录等),通常在十年之后,该思想在另一种环境下又重现了。由于这个原因,本书中,我们将不时回顾那些在今日的G字节PC机中过时的思想和算法,因为这些思想和算法可能会在嵌入式计算机和智能卡中再现。

1.6 系统调用

我们已经看到操作系统具有两种功能:为用户程序提供抽象和管理计算机资源。在多数情形下,用户程序和操作系统之间的交互处理的是前者,例如,创建、写入、读出和删除文件。对用户而言,资源管理部分主要是透明和自动完成的。这样,用户程序和操作系统之间的交互主要就是处理抽象。为了真正理解操作系统的行为,我们必须仔细地分析这个接口。接口中所提供的调用随着操作系统的不同而变化(尽管基于的概念是类似的)。

这样我们不得不在如下的可能方式中进行选择:(1)含混不清的一般性叙述(“操作系统提供读取文件的系统调用”);(2)某个特定的系统(“UNIX提供一个有三个参数的read系统调用:一个参数指定文件,一个说明数据应存放的位置,另一个说明应读出多少个字节”)。

我们选择后一种方式。这种方式需要更多的努力,但是它能更多地洞察操作系统具体在做什么。尽管这样的讨论会涉及专门的POSIX(International Standard 9945-1),以及UNIX、System V、BSD、Linux、MINIX3等,但是多数现代操作系统都有实现相同功能的系统调用,尽管它们在细节上差别很大。由于引发系统调用的实际机制是非常依赖于机器的,而且必须用汇编代码表达,所以,通过提供过程库使C程序中能够使用系统调用,当然也包括其他语言。

记住下列事项是有益的。任何单CPU计算机一次只能执行一条指令。如果一个进程正在用户态中运行一个用户程序,并且需要一个系统服务,比如从一个文件读数据,那么它就必须执行一个陷阱或系统调用指令,将控制转移到操作系统。操作系统接着通过参数检查,找出所需要的调用进程。然后,它执行系统调用,并把控制返回给在系统调用后面跟随着的指令。在某种意义上,进行系统调用就像进行一个特殊的过程调用,但是只有系统调用可以进入内核,而过程调用则不能。

为了使系统调用机制更清晰,让我们简要地考察read系统调用。如上所述,它有三个参数:第一个参数指定文件,第二个指向缓冲区,第三个说明要读出的字节数。几乎与所有的系统调用一样,它的调用由C程序完成,方法是调用一个与该系统调用名称相同的库过程:read。由C程序进行的调用可有如下形式:

count=read(fd,buffer,nbytes);

系统调用(以及库过程)在count中返回实际读出的字节数。这个值通常和nbytes相同,但也可能更小,例如,如果在读过程中遇到了文件尾的情形就是如此。

如果系统调用不能执行,不论是因为无效的参数还是磁盘错误,count都会被置为-1,而在全局变量errno中放入错误号。程序应该经常检查系统调用的结果,以了解是否出错。

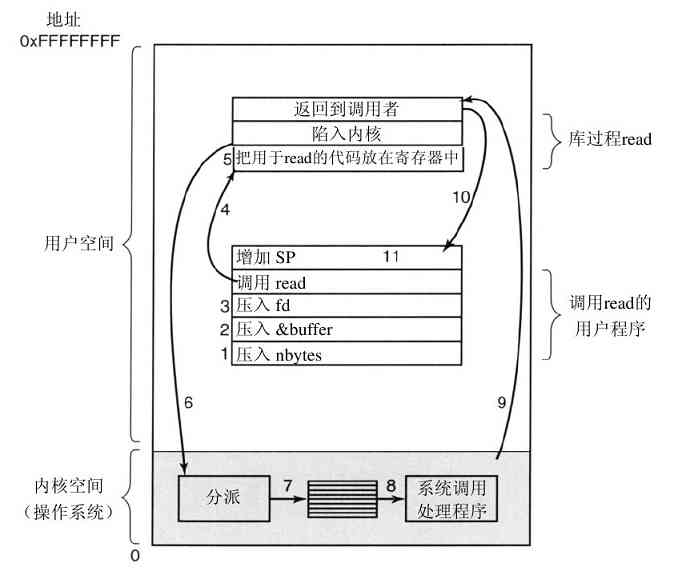

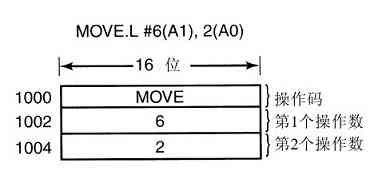

系统调用是通过一系列的步骤实现的。为了更清楚地说明这个概念,考察上面的read调用。在准备调用这个实际用来进行read系统调用的read库过程时,调用程序首先把参数压进堆栈,如图1-17中步骤1~步骤3所示。

图 1-17 完成系统调用read的11个步骤

由于历史的原因,C以及C++编译器使用逆序(必须把第一个参数赋给printf(格式字串),放在堆栈的顶部)。第一个和第三个参数是值调用,但是第二个参数通过引用传递,即传递的是缓冲区的地址(由&指示),而不是缓冲区的内容。接着是对库过程的实际调用(第4步)。这个指令是用来调用所有过程的正常过程调用指令。

在可能是由汇编语言写成的库过程中,一般把系统调用的编号放在操作系统所期望的地方,如寄存器中(第5步)。然后执行一个TRAP指令,将用户态切换到内核态,并在内核中的一个固定地址开始执行(第6步)。TRAP指令实际上与过程调用指令相当类似,它们后面都跟随一个来自远地位置的指令,以及供以后使用的一个保存在栈中的返回地址。

然而,TRAP指令与过程指令存在两个方面的差别。首先,它的副作用是,切换到内核态。而过程调用指令并不改变模式。其次,不像给定过程所在的相对或绝对地址那样,TRAP指令不能跳转到任意地址上。根据机器的体系结构,或者跳转到一个单固定地址上,或者指令中有一8位长的字段,它给定了内存中一张表格的索引,这张表格中含有跳转地址。

跟随在TRAP指令后的内核代码开始检查系统调用编号,然后发出正确的系统调用处理命令,这通常是通过一张由系统调用编号所引用的、指向系统调用处理器的指针表来完成(第7步)。此时,系统调用句柄运行(第8步)。一旦系统调用句柄完成其工作,控制可能会在跟随TRAP指令后面的指令中返回给用户空间库过程(第9步)。这个过程接着以通常的过程调用返回的方式,返回到用户程序(第10步)。

为了完成整个工作,用户程序还必须清除堆栈,如同它在进行任何过程调用之后一样(第11步)。假设堆栈向下增长,如经常所做的那样,编译后的代码准确地增加堆栈指针值,以便清除调用read之前压入的参数。在这之后,原来的程序就可以随意执行了。

在前面第9步中,我们提到“控制可能会在跟随TRAP指令后面的指令中返回给用户空间库过程”,这是有原因的。系统调用可能堵塞调用者,避免它继续执行。例如,如果试图读键盘,但是并没有任何键入,那么调用者就必须被阻塞。在这种情形下,操作系统会查看是否有其他可以运行的进程。稍后,当需要的输入出现时,进程会提醒系统注意,然后步骤9~步骤11会接着进行。

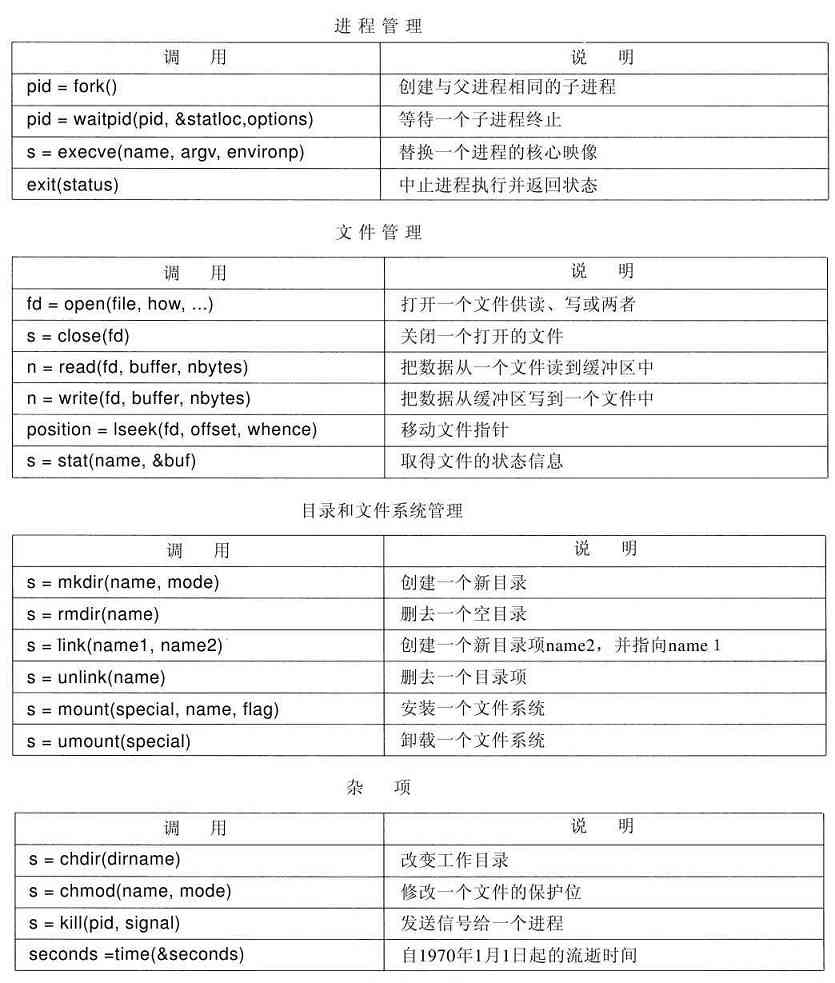

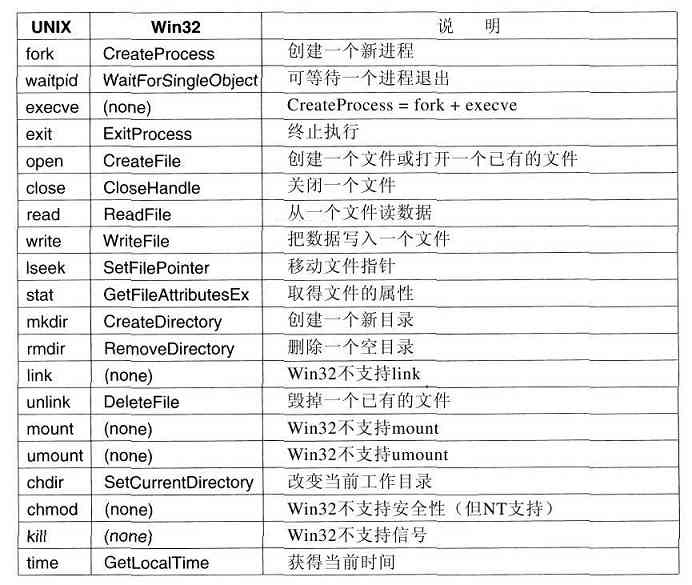

下面几节中,我们将考察一些常用的POSIX系统调用,或者用更专业的说法,考察进行这些系统调用的库过程。POSIX大约有100个过程调用,它们中最重要的过程调用列在图1-18中。为方便起见,它们被分成4类。我们用文字简要地叙述其作用。

图 1-18 一些重要的POSIX系统调用。若出错则返回代码s为-1。返回代码如下:pid是进程的id,fd是文件描述符,n是字节数,position是在文件中的偏移量,而seconds是流逝时间。参数在表中解释

从广义上看,由这些调用所提供的服务确定了多数操作系统应该具有的功能,而在个人计算机上,资源管理功能是较弱的(至少与多用户的大型机相比较是这样)。所包含的服务有创建与终止进程,创建、删除、读出和写入文件,目录管理以及完成输入输出。

有必要指出,将POSIX过程映射到系统调用并不是一对一的。POSIX标准定义了构造系统所必须提供的一套过程,但是并没有规定它们是系统调用,是库调用还是其他的形式。如果不通过系统调用就可以执行一个过程(即无须陷入内核),那么从性能方面考虑,它通常会在用户空间中完成。不过,多数POSIX过程确实进行系统调用,通常是一个过程直接映射到一个系统调用上。在有一些情形下,特别是所需要的过程仅仅是某个调用的变体时,此时一个系统调用会对应若干个库调用。

1.6.1 用于进程管理的系统调用

在图1-18中的第一组调用处理进程管理。将有关fork(派生)的讨论作为本节的开始是较为合适的。在UNIX中,fork是惟一可以在POSIX创建进程的途径。它创建一个原有进程的精确副本,包括所有的文件描述符,寄存器等全部内容。在fork之后,原有的进程及其副本(父与子)就分开了。在fork时,所有的变量具有一样的值,虽然父进程的数据被复制用以创建子进程,但是其中一个的后续变化并不会影响到另一个。(由父进程和子进程共享的程序正文,是不可改变的。)fork调用返回一个值,在子进程中该值为零,并且等于子进程的进程标识符,或等于父进程中的PID。使用被返回的PID,就可以在两个进程中看出哪一个是父进程,哪一个是子进程。

多数情形下,在fork之后,子进程需要执行与父进程不同的代码。这里考虑shell的情形。它从终端读取命令,创建一个子进程,等待该子进程执行命令,在该子进程终止时,读入下一条命令。为了等待子进程结束,父进程执行一个waitpid系统调用,它只是等待,直至子进程终止(若有多个子进程存在的话,则直至任何一个子进程终止)。waitpid可以等待一个特定的子进程,或者通过将第一个参数设为-1的方式,从而等待任何一个老的子进程。在waitpid完成之后,将把第二个参数statloc所指向的地址设置为子进程的退出状态(正常或异常终止以及退出值)。有各种可使用的选项,它们由第三个参数确定。

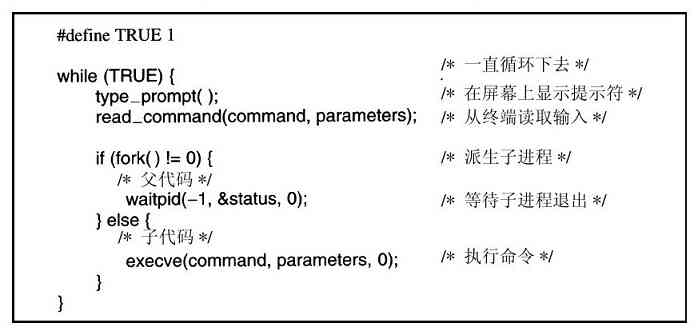

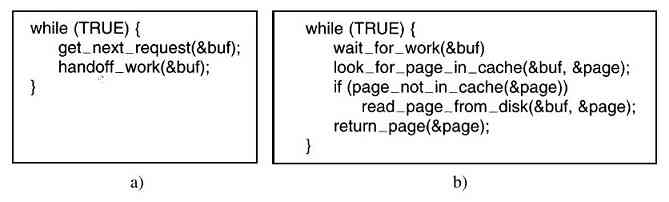

现在考虑shell如何使用fork。在键入一条命令后,shell创建一个新的进程。这个子进程必须执行用户的命令。通过使用execve系统调用可以实现这一点,这个系统调用会引起其整个核心映像被一个文件所替代,该文件由第一个参数给定。(实际上,该系统调用自身是exec系统调用,但是若干个不同的库过程使用不同的参数和稍有差别的名称调用该系统调用。在这里,我们都把它们视为系统调用。)在图1-19中,用一个高度简化的shell说明fork、waitpid以及execve的使用。

图 1-19 一条shell(在本书中,TRUE都被定义为1)

在最一般情形下,execve有三个参数:将要执行的文件名称,一个指向变量数组的指针,以及一个指向环境数组的指针。这里对这些参数做一个简要的说明。各种库例程,包括execl、execv、execle以及execve,可以允许略掉参数或以各种不同的方式给定。在本书中,我们在所有涉及的地方使用exec描述系统调用。

下面考虑诸如

cp file1 file2

的命令,该命令将file1复制到file2。在shell创建进程之后,该子进程定位和执行文件cp,并将源文件名和目标文件名传递给它。

cp主程序(以及多数其他C程序的主程序)都有声明

main(argc,argv,envp)

其中argc是该命令行内有关参数数目的计数器,包括程序名称。例如,上面的例子中,argc为3。

第二个参数argv是一个指向数组的指针。该数组的元素i是指向该命令行第i个字串的指针。在本例中,argv[0]指向字串“cp”,argv[1]指向字符串“file1”,argv[2]指向字符串“file2”。

main的第三个参数envp指向环境的一个指针,该环境是一个数组,含有name=value的赋值形式,用以将诸如终端类型以及根目录等信息传送给程序。还有供程序可以调用的库过程,用来取得环境变量,这些变量通常用来确定用户希望如何完成特定的任务(例如,使用默认打印机)。在图1-19中,没有环境参数传递给子进程,所以execve的第三个参数为零。

如果读者认为exec过于复杂,那么也不要失望。这是在POSIX的全部(语义上)系统调用中最复杂的一个,其他的都非常简单。作为一个简单例子,考虑exit,这是在进程完成执行后应执行的系统调用。这个系统调用有一个参数,退出状态(0至255),该参数通过waitpid系统调用中的statloc返回给父进程。

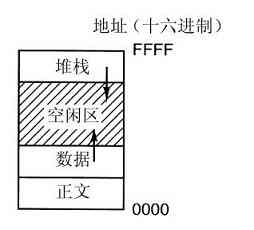

在UNIX中的进程将其存储空间划分为三段:正文段(如程序代码)、数据段(如变量)以及堆栈段。数据段向上增长而堆栈向下增长,如图1-20所示。夹在中间的是未使用的地址空间。堆栈在需要时自动地向中间增长,不过数据段的扩展是显式地通过系统调用brk进行的,在数据段扩充后,该系统调用指定一个新地址。但是,这个调用不是POSIX标准中定义的调用,对于存储器的动态分配,我们鼓励程序员使用malloc库过程,而malloc的内部实现则不是一个适合标准化的主题,因为几乎没有程序员直接使用它,我们有理由怀疑,会有什么人注意到brk实际不是属于POSIX的。

图 1-20 进程有三段:正文段、数据段和堆栈段

1.6.2 用于文件管理的系统调用

许多系统调用与文件系统有关。本小节讨论在单个文件上的操作,1.6.3节将讨论与目录和整个文件系统有关的内容。

要读写一个文件,先要使用open打开该文件。这个系统调用通过绝对路径名或指向工作目录的相对路径名指定要打开文件的名称,而代码O_RDONLY、O_WRONLY或O_RDWR的含义分别是读、写或两者。为了创建一个新文件,使用O_CREAT参数。然后可使用返回的文件描述符进行读写操作。接着,可以用close关闭文件,这个调用使得该文件描述符在后续的open中被再次使用。

毫无疑问,最常用的调用是read和write。我们在前面已经讨论过read。write具有与read相同的参数。

尽管多数程序频繁地读写文件,但是仍有一些应用程序需要能够随机访问一个文件的任意部分。与每个文件相关的是一个指向文件当前位置的指针。在顺序读(写)时,该指针通常指向要读出(写入)的下一个字节。lseek调用可以改变该位置指针的值,这样后续的read或write调用就可以在文件的任何地方开始。

lseek有三个参数:第一个是文件的描述符,第二个是文件位置,第三个说明该文件位置是相对于文件起始位置、当前位置,还是文件的结尾。在修改了指针之后,lseek所返回的值是文件中的绝对位置。

UNIX为每个文件保存了该文件的类型(普通文件、特殊文件、目录等),大小,最后修改时间以及其他信息。程序可以通过stat系统调用查看这些信息。第一个参数指定了要被检查的文件;第二个参数是一个指针,该指针指向用来存放这些信息的结构。对于一个打开的文件而言,fstat调用完成同样的工作。

1.6.3 用于目录管理的系统调用

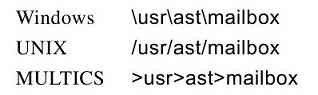

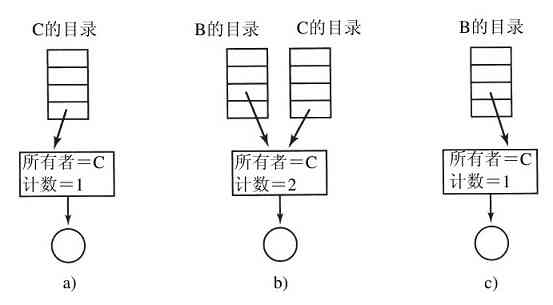

本节我们讨论与目录或整个文件系统有关的某些系统调用,而不是1.6.2节中与一个特定文件有关的系统调用。mkdir和rmdir分别用于创建和删除空目录。下一个调用是link。它的作用是允许同一个文件以两个或多个名称出现,多数情形下是在不同的目录中这样做。它的典型应用是,在同一个开发团队中允许若干个成员共享一个共同的文件,他们之中的每个人都在自己的目录中有该文件,但可能采用的是不同的名称。共享一个文件,与每个团队成员都有一个私用副本并不是同一件事,因为共享文件意味着,任何成员所做的修改都立即为其他成员所见——只有一个文件存在。而在复制了一个文件的多个副本之后,对其中一个副本所进行的修改并不会影响到其他的副本。

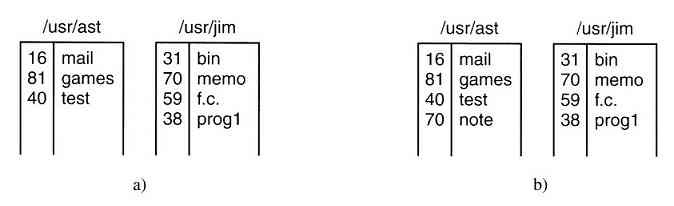

为了考察link是如何工作的,考虑图1-21a中的情形。有两个用户,ast和jim,每个用户都有一些文件的目录。若ast现在执行一个含有系统调用的程序

link("/usr/jim/memo",“usr/ast/note”);

在jim目录中的文件memo,以文件名note进入ast的目录。之后,/usr/jim/memo和/usr/ast/note都引用相同的文件。顺便提及,用户是将目录保存在/usr、/user、/home还是其他地方,则完全取决于本地系统管理员的决定。

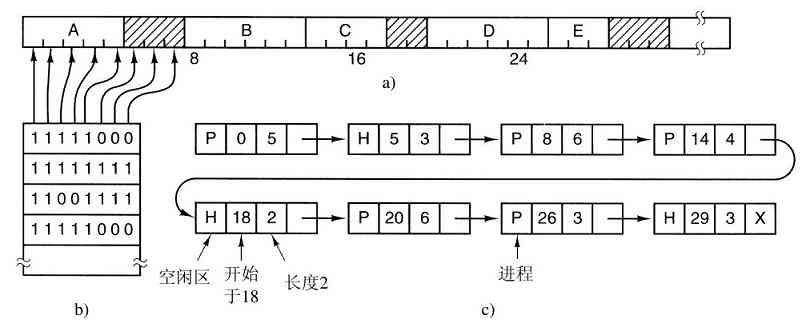

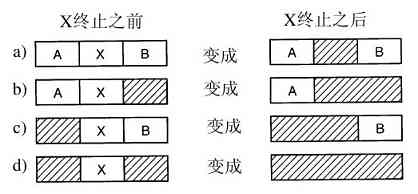

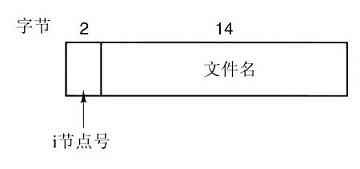

理解link是如何工作的也许有助于读者看清其作用。在UNIX中,每个文件都有惟一的编号,即i-编号,用以标识文件。该i-编号是对i-节点表格的一个引用,它们一一对应,说明该文件的拥有者,磁盘块的位置等。一个目录就是包含了(i-编号,ASCII名称)对集合的一个文件。在UNIX的第一个版本中,每个目录项有16个字节——2个字节用于i-编号,14个字节用于名称。现在为了支持长文件名,采用了更复杂的结构,但是,在概念上,目录仍然是(i-编号,ASCII名称)对的一个集合。在图1-21中,mail为i-编号16,等等。link所做的只是利用某个已有文件的i-编号,创建一个新目录项(也许用一个新名称)。在图1-21b中两个目录项有相同的i-编号(70),从而指向同一个文件。如果其中某一个文件后来被移走了,使用unlink系统调用,可以保留另一个。如果两个都被移走了,UNIX 00看到尚存在的文件没有目录项(i-节点中的一个域记录着指向该文件的目录项),就会把该文件从磁盘中移去。

图 1-21 a)将/usr/jim/memo链接到ast目录之前的两个目录;b)链接之后的两个目录

正如我们已经叙述过的,mount系统调用允许将两个文件系统合并成为一个。通常的情形是,在硬盘上的根文件系统含有常用命令的二进制(可执行)版和其他常用的文件。用户可在CD-ROM驱动器中插入包含有需要读入文件的CD-ROM盘。

通过执行mount系统调用,可以将一个CD-ROM文件系统添加到根文件系统中,如图1-22所示。完成安装操作的典型C语句为

mount("/dev/fd0","/mnt",0);

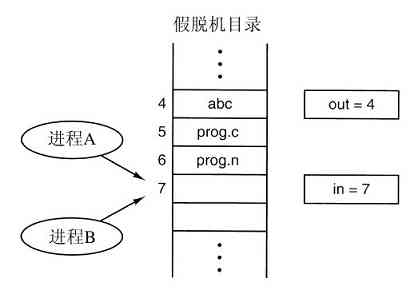

图 1-22 a)安装前的文件系统;b)安装后的文件系统

这里,第一个参数是驱动器0的块特殊文件名称,第二个参数是要被安装在树中的位置,第三个参数说明将要安装的文件系统是可读写的还是只读的。

在mount调用之后,驱动器0上的文件可以使用从根目录开始的路径或工作目录路径,而不用考虑文件在哪个驱动器上。事实上,第二个、第三个以及第四个驱动器也可安装在树上的任何地方。mount调用使得把可移动介质都集中到一个文件层次中成为可能,而不用考虑文件在哪个驱动器上。尽管这是个CD-ROM的例子,但是也可以用同样的方法安装硬盘或者硬盘的一部分(常称为分区或次级设备),外部硬盘和USB盘也一样。当不再需要一个文件系统时,可以用umount系统调用卸载之。

1.6.4 各种系统调用

有各种的系统调用。这里介绍系统调用中的一部分。chdir调用改变当前的工作目录。在调用

chdir("/usr/ast/test");

之后,打开xyz文件,会打开/usr/ast/test/xyz。工作目录的概念消除了总是键入(长)绝对路径名的需要。

在UNIX中,每个文件有一个保护模式。该模式包括针对所有者、组和其他用户的读-写-执行位。chmod系统调用可以改变文件的模式。例如,要使一个文件对除了所有者之外的用户只读,可以执行

chmod(“file”,0644);

kill系统调用供用户或用户进程发送信号用。若一个进程准备好捕捉一个特定的信号,那么,在信号到来时,运行一个信号处理程序。如果该进程没有准备好,那么信号的到来会杀掉该进程(此调用名称的由来)。

POSIX定义了若干处理时间的过程。例如,time以秒为单位返回当前时间,0对应着1970年1月1日午夜(从此日开始,没有结束)。在一台32位字的计算机中,time的最大值是232 -1秒(假设是无符号整数)。这个数字对应136年多一点。所以在2106年,32位的UNIX系统会发狂,与在2000年造成对世界计算机严重破坏的知名的Y2K问题是类似的。如果读者现在有32位UNIX系统,建议在2106年之前的某时刻更换为64位的系统。

1.6.5 Windows Win32 API

到目前为止,我们主要讨论的是UNIX系统。现在简要地考察Windows。Windows和UNIX的主要差别在于编程方式。一个UNIX程序包括做各种处理的代码以及从事完成特定服务的系统调用。相反,一个Windows程序通常是一个事件驱动程序。其中主程序等待某些事件发生,然后调用一个过程处理该事件。典型的事件包括被敲击的键、移动的鼠标、被按下的鼠标或插入的CD-ROM。调用事件处理程序处理事件,刷新屏幕,并更新内部程序状态。总之,这是与UNIX不同的程序设计风格,由于本书专注于操作系统的功能和结构,这些程序设计方式上的差异就不过多涉及了。

当然,在Windows中也有系统调用。在UNIX中,系统调用(如read)和系统调用所使用的库过程(如read)之间几乎是一一对应的关系。换句话说,对于每个系统调用,差不多就涉及一个被调用的库过程,如图1-17所示。此外,POSIX有约100个过程调用。

在Windows中,情况就大不相同了。首先,库调用和实际的系统调用是几乎不对应的。微软定义了一套过程,称为应用编程接口(Application Program Interface,Win32 API),程序员用这套过程获得操作系统的服务。从Windows 95开始的所有Windows版本都(或部分)支持这个接口。由于接口与实际的系统调用不对应,微软保留了随着时间(甚至随着版本到版本)改变实际系统调用的能力,防止使已有的程序失效。由于Windows 2000、Windows XP和Windows Vista中有许多过去没有的新调用,所以究竟Win32是由什么构成的,这个问题的答案仍然是含混不清的。在本节中,Win32表示所有Windows版本都支持的接口。

Win32 API调用的数量是非常大的,数量有数千个。此外,尽管其中许多确实涉及系统调用,但有一大批Win32 API完全是在用户空间进行。结果,在Windows中,不可能了解哪一个是系统调用(如由内核完成),哪一个只是用户空间中的库调用。事实上,在某个版本中的一个系统调用,会在另一个不同版本中的用户空间中执行,或者相反。当我们在本书中讨论Windows的系统调用时,将使用Win32过程(在合适之处),这是因为微软保证:随着时间流逝,Win32过程将保持稳定。但是读者有必要记住,它们并不全都是系统调用(即陷入到内核中)。

Win32 API中有大量的调用,用来管理视窗、几何图形、文本、字型、滚动条、对话框、菜单以及GUI的其他功能。为了使图形子系统在内核中运行(某些Windows版本中确实是这样,但不是所有的版本),需要系统调用,否则只有库调用。在本书中是否应该讨论这些调用呢?由于它们并不是同操作系统的功能相关,我们还是决定不讨论它们,尽管它们会在内核中运行。对Win32 API有兴趣的读者应该参阅一些书籍中的有关内容,(例如,Hart,1997;Rector和Newcomer,1997;Simon,1997)。

我们在这里介绍所有的Win32 API,不过这不是我们关心问题的所在,所以我们做了一些限制,只将那些与图1-18中UNIX系统调用大致对应的Windows调用列在图1-23中。

图 1-23 与图1-18中UNIX调用大致对应的Win32 API调用

下面简要地说明一下图1-23中表格的内容。CreateProcess为创建一个新进程,它把UNIX中的fork和execve结合起来。它有许多参数用来指定新创建进程的性质。Windows中没有类似UNIX中的进程层次,所以不存在父进程和子进程的概念。在进程创建之后,创建者和被创建者是平等的。WaitForSingleObject用于等待一个事件,等待的事件可以是多种可能的事件。如果有参数指定了某个进程,那么调用者等待所指定的进程退出,这通过使用ExitProcess完成。

接着的六个调用进行文件操作,在功能上和它们的UNIX对应调用类似,尽管在参数和细节上它们都是不同的。和在UNIX中一样,文件可被打开、关闭和写入。SetFilePointer以及GetFileAttributesEx调用设置文件的位置并取得文件的一些属性。

Windows中有目录,目录可以分别用CreateDirectory以及RemoveDirectory API调用创建和删去。也有对当前目录的标记,这可以通过SetCurrentDirectory来设置。使用GetLocalTime可获得当前时间。

Win32接口中没有文件的链接、文件系统的安装、安全属性或信号,所以对应于UNIX中的这些调用就不存在了。当然,Win32中也有大量的在UNIX中不存在的其他调用,特别是管理GUI的种种调用。不过在Windows Vista中有了精心设计的安全系统,而且也支持文件的链接。

也许有必要对Win32做一个最后的说明。Win32并不是非常统一的或有一致的接口。其主要原因是由于Win32需要与早期的在Windows 3.x中使用的16位接口向后兼容。

1.7 操作系统结构

我们已经分析了操作系统的外部(如,程序员接口),现在是分析其内部的时候了。在下面的小节中,为了对各种可能的方式有所了解,我们将考察已经尝试过的六种不同的结构设计。这样做并没有穷尽各种结构方式,但是至少给出了在实践中已经试验过的一些设计思想。这六种设计是,单体系统、层次系统、微内核、客户机-服务器系统、虚拟机和exokernels等。

1.7.1 单体系统

到目前为止,在多数常见的组织形式的处理方式中,全部操作系统在内核态中以单一程序的方式运行。整个操作系统以过程集合的方式编写,链接成一个大型可执行二进制程序。使用这种技术,系统中每个过程可以自由调用其他过程,只要后者提供了前者所需要的一些有用的计算工作。这些可以不受限制彼此调用的成千个过程,常常导致出现一个笨拙和难于理解的系统。

在使用这种处理方式构造实际的目标程序时,首先编译所有单个的过程,或者编译包含过程的文件,然后通过系统链接程序将它们链接成单一的目标文件。依靠对信息的隐藏处理,不过在这里实际上是不存在的,每个过程对其他过程都是可见的(相反的构造中有模块或包,其中多数信息隐藏在模块之中,而且只能通过正式设计的入口点实现模块的外部调用)。

但是,即使在单体系统中,也可能有一些结构存在。可以将参数放置在良好定义的位置(如,栈),通过这种方式,向操作系统请求所能提供的服务(系统调用),然后执行一个陷阱指令。这个指令将机器从用户态切换到内核态并把控制传递给操作系统,如图1-17中第6步所示。然后,操作系统取出参数并且确定应该执行哪一个系统调用。随后,它在一个表格中检索,在该表格的k槽中存放着指向执行系统调用k过程的指针(图1-17中第7步)。

对于这类操作系统的基本结构,有着如下结构上的建议:

1)需要一个主程序,用来处理服务过程请求。

2)需要一套服务过程,用来执行系统调用。

3)需要一套实用过程,用来辅助服务过程。在该模型中,每一个系统调用都通过一个服务过程为其工作并运行之。要有一组实用程序来完成一些服务过程所需要用到的功能,如从用户程序取数据等。可将各种过程划分为一个三层的模型,如图1-24所示。

图 1-24 简单的单体系统结构模型

除了在计算机初启时所装载的核心操作系统外,许多操作系统支持可装载的扩展,诸如I/O设备驱动和文件系统。这些部件可以按照需要载入。

1.7.2 层次式系统

把图1-24中的系统进一步通用化,就变成一个层次式结构的操作系统,它的上层软件都是在下一层软件的基础之上构建的。E.W.Dijkstra和他的学生在荷兰的Eindhoven技术学院所开发的THE系统(1968),是按此模型构造的第一个操作系统。THE系统是为荷兰的一种计算机,Electrologica X8,配备的一个简单的批处理系统,其内存只有32K个字,每字27位(二进制位在那时是很昂贵的)。

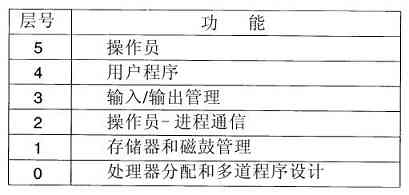

该系统共分为六层,如图1-25所示。处理器分配在第0层中进行,当中断发生或定时器到期时,由该层进行进程切换。在第0层之上,系统由一些连续的进程所组成,编写这些进程时不用再考虑在单处理器上多进程运行的细节。也就是说,在第0层中提供了基本的CPU多道程序功能。

图 1-25 THE操作系统的结构

内存管理在第1层中进行,它分配进程的主存空间,当内存用完时则在一个512K字的磁鼓上保留进程的一部分(页面)。在第1层上,进程不用考虑它是在磁鼓上还是在内存中运行。第1层软件保证一旦需要访问某一页面时,该页面必定已在内存中。

第2层处理进程与操作员控制台(即用户)之间的通信。在这层的上部,可以认为每个进程都有自己的操作员控制台。第3层管理I/O设备和相关的信息流缓冲区。在第3层上,每个进程都与有良好特性的抽象I/O设备打交道,而不必考虑外部设备的物理细节。第4层是用户程序层。用户程序不用考虑进程、内存、控制台或I/O设备管理等细节。系统操作员进程位于第5层中。

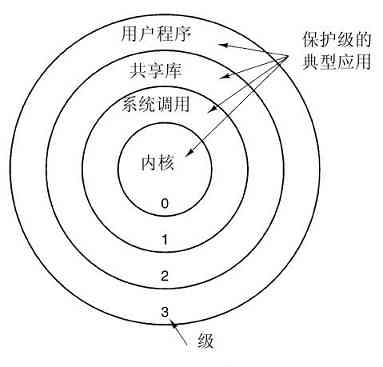

在MULTICS系统中采用了更进一步的通用层次化概念。MULTICS由许多的同心环构造而成,而不是采用层次化构造,内层环比外层环有更高的级别(它们实际上是一样的)。当外环的过程欲调用内环的过程时,它必须执行一条等价于系统调用的TRAP指令。在执行该TRAP指令前,要进行严格的参数合法性检查。在MULTICS中,尽管整个操作系统是各个用户进程的地址空间的一部分,但是硬件仍能对单个过程(实际是内存中的一个段)的读、写和执行进行保护。

实际上,THE分层方案只是为设计提供了一些方便,因为该系统的各个部分最终仍然被链接成了完整的单个目标程序。而在MULTICS里,环形机制在运行中是实际存在的,而且是由硬件实现的。环形机制的一个优点是很容易扩展,可用以构造用户子系统。例如,在一个MULTICS系统中,教授可以写一个程序检查学生们编写的程序并给他们打分,在第n个环中运行教授的程序,而在第n+1个环中运行学生的程序,这样学生们就无法篡改教授所给出的成绩。

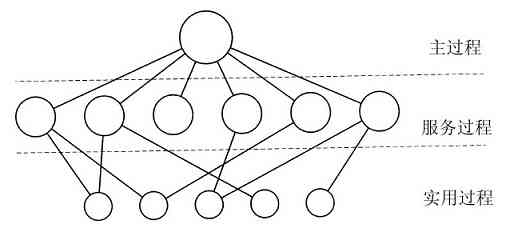

1.7.3 微内核

在分层方式中,设计者要确定在哪里划分内核-用户的边界。在传统上,所有的层都在内核中,但是这样做没有必要。事实上,尽可能减少内核态中功能的做法更好,因为内核中的错误会快速拖累系统。相反,可以把用户进程设置为具有较小的权限,这样,某一个错误的后果就不会是致命的。

有不少研究人员对每千行代码中错误的数量进行了分析(例如,Basilli和Perricone,1984;Ostrand和Weyuker,2002)。代码错误的密度取决于模块大小、模块寿命等,不过对一个实际工业系统而言,每千行代码中会有10个错误。这意味着在有5百万行代码的单体操作系统中,大约有50 000个内核错误。当然,并不是所有的错误都是致命的,诸如给出了不正确的故障信息之类的某些错误,实际是很少发生的。无论怎样看,操作系统中充满了错误,所以计算机制造商设置了复位按钮(通常在前面板上),而电视机、立体音响以及汽车的制造商们则不这样做,尽管在这些装置中也有大量的软件。

在微内核设计背后的思想是,为了实现高可靠性,将操作系统划分成小的、良好定义的模块,只有其中一个模块——微内核——运行在内核态上,其余的模块,由于功能相对弱些,则作为普通用户进程运行。特别地,由于把每个设备驱动和文件系统分别作为普通用户进程,这些模块中的错误虽然会使这些模块崩溃,但是不会使得整个系统死机。所以,在音频驱动中的错误会使声音断续或停止,但是不会使整个计算机垮掉。相反,在单体系统中,由于所有的设备驱动都在内核中,一个有故障的音频驱动会很容易引起对无效地址的引用,从而造成恼人的系统立即停机。

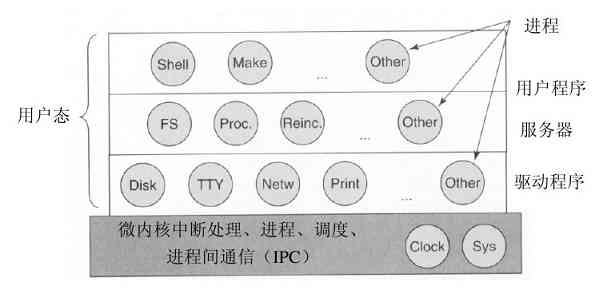

有许多微内核已经实现并投入应用(Accetta等人,1986;Kirsch等人,2005;Heiser等人,2006;Herder等人,2006;Hildebrand,1992;Haertig等人,1997;Liedtke,1993,1995,1996;Pike等人,1992;Zuberi等人,1999)。微内核在实时、工业、航空以及军事应用中特别流行,这些领域都是关键任务,需要有高度的可靠性。知名的微内核有Integrity、K42、L4、PikeOS、QNX、Symbian,以及MINIX 3等。这里对MINIX 3做一简单的介绍,该操作系统把模块化的思想推到了极致,它将大部分操作系统分解成许多独立的用户态进程。MINIX 3遵守POSIX,可在www.minix3.org(Herder等人,2006a;Herder等人,2006b)站点获得免费的开放源代码。

MINIX 3微内核只有3200行C语言代码和800行用于非常低层次功能的汇编语言代码,诸如捕捉中断、进程切换等。C代码管理和调度进程、处理进程间通信(在进程之间传送信息)、提供大约35个内核调用,它们使得操作系统的其余部分可以完成其工作。这些调用完成诸如连接中断句柄、在地址空间中移动数据以及为新创建的进程安装新的内存映像等。MINIX 3的进程结构如图1-26所示,其中内核调用的句柄用Sys标记。时钟设备驱动也在内核中,因为这个驱动与调度器交互密切。所有的其他设备驱动都作为单独的用户进程运行。

图 1-26 MINIX 3系统的结构

在内核的外部,系统的构造有三层进程,它们都在用户态中运行。最底层中包含设备驱动器。由于它们在用户态中运行,所以不能物理地访问I/O端口空间,也不能直接发出I/O命令。相反,为了能够对I/O设备编程,驱动器构建了一个结构,指明哪个参数值写到哪个I/O端口,并生成一个内核调用,通知内核完成写操作。这个处理意味着内核可以检查驱动正在对I/O的读(或写)是否是得到授权使用的。这样,(与单体设计不同),一个有错误的音频驱动器就不能够偶发性地在硬盘上进行写操作。

在驱动器上面是另一用户态层,包含有服务器,它们完成操作系统多数的工作。有一个或多个文件服务器管理着文件系统,进程管理器创建、破坏和管理进程等。通过给服务器发送短消息请求POSIX系统调用的方式,用户程序获得操作系统的服务。例如,一个需要调用read的进程发送一个消息给某个文件服务器,告知它需要读什么内容。

有一个有趣的服务器,称为再生服务器(reincarnation server),其任务是检查其他服务器和驱动器的功能是否正确。一旦检查出一个错误,它自动取代之,无须任何用户的干预。这种方式使得系统具有自修复能力,并且获得了较高的可靠性。

系统对每个进程的权限有着许多限制。正如已经提及的,设备驱动器只能与授权的I/O端口接触,对内核调用的访问也是按单个进程进行控制的,这是考虑到进程具有向其他多个进程发送消息的能力。进程也可获得有限的许可,让在内核的其他进程访问其地址空间。例如,一个文件系统可以为磁盘驱动器获得一种允许,让内核在该文件系统的地址空间内的特定地址上进行对盘块的一个新读操作。总体来说,所有这些限制是让每个驱动和服务器只拥有完成其工作所需要的权限,别无其他,这样就极大地限制了故障部件可能造成的危害。

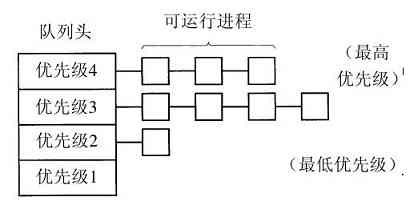

一个与小内核相关联的思想是在内核中的机制与策略分离的原则。为了更清晰地说明这一点,让我们考虑进程调度。一个比较简单的调度算法是,对每个进程赋予一个优先级,并让内核执行在具有最高优先级进程中可以运行的某个进程。这里,机制(在内核中)就是寻找最高优先级的进程并运行之。而策略(赋予进程以优先级)可以由用户态中的进程完成。在这个方式中,机制和策略是分离的,从而使系统内核变得更小。

1.7.4 客户机-服务器模式

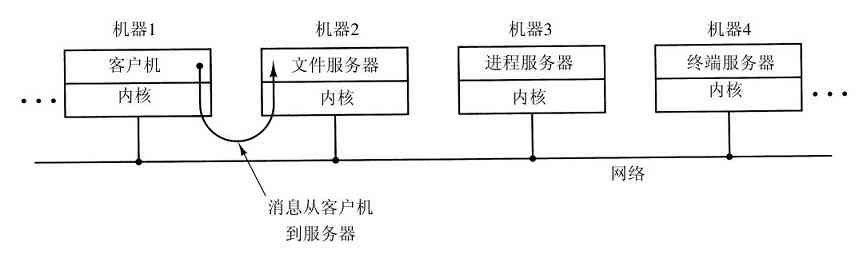

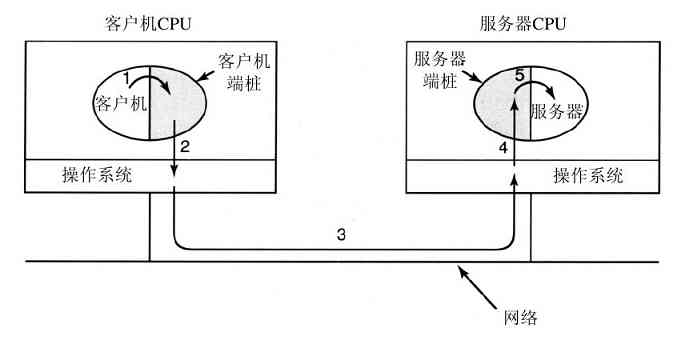

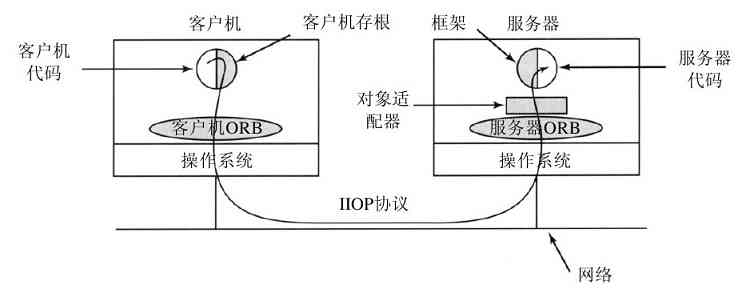

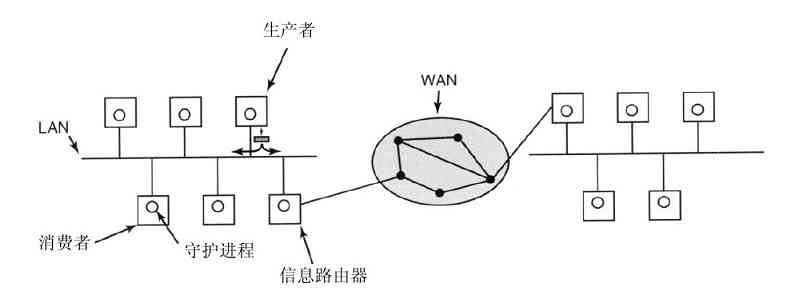

一个微内核思想的略微变体是将进程划分为两类:服务器,每个服务器提供某种服务;客户端,使用这些服务。这个模式就是所谓的客户机-服务器模式。通常,在系统最底层是微内核,但并不是必须这样的。这个模式的本质是存在客户端进程和服务器进程。

一般地,在客户端和服务器之间的通信是消息传递。为了获得一个服务,客户端进程构造一段消息,说明所需要的服务,并将其发给合适的服务器。该服务完成工作,发送回应。如果客户端和服务器运行在同一个机器上,则有可能进行某种优化,但是从概念上看,在这里讨论的是消息传递。

这个思想的一个显然的、普遍方式是,客户端和服务器运行在不同的计算机上,它们通过局域或广域网连接,如图1-27所示。由于客户端通过发送消息与服务器通信,客户端并不需要知道这些消息是在它们的本地机器上处理,还是通过网络被送到远程机器上处理。对于客户端而言,这两种情形是一样的:都是发送请求并得到回应。所以,客户机-服务器模式是一种可以应用在单机或者网络机器上的抽象。

图 1-27 在网络上的客户机-服务器模型

越来越多的系统,包括用户家里的PC机,都成为了客户端,而在某地运行的大型机器则成为服务器。事实上,许多Web就是以这个方式运行的。一台PC机向某个服务器请求一个Web页面,而后,该Web页面回送。这就是网络中客户机-服务器的典型应用方式。

1.7.5 虚拟机

OS/360的最早版本是纯粹的批处理系统。然而,有许多360用户希望能够在终端上交互工作,于是在IBM公司内外的一些研究小组决定为它编写一个分时系统。在后来推出了正式的IBM分时系统,TSS/360。但是它非常庞大,运行缓慢,于是在花费了约五千万美元的研制费用后,该系统最后被弃之不用(Graham,1970)。但是在麻省剑桥的一个IBM研究中心开发了另一个完全不同的系统,这个系统被IBM最终用作为产品。它的直接后续,称为z/VM,目前在IBM的现有大型机上广泛使用,zSeries则在大型公司的数据中心中广泛应用,例如,作为e-commerce服务器,它们每秒可以处理成百上千个事务,并使用达数百万G字节的数据库。

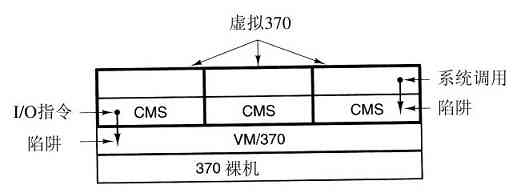

1.VM/370

这个系统最初被命名为CP/CMS,后来改名为VM/370(Seawright和MacKinnon,1979)。它是源于如下一种机敏的观察。分时系统应该提供这些功能:(1)多道程序,(2)一个比裸机更方便的、有扩展界面的计算机。VM/370存在的目的是将二者彻底地隔离开来。

这个系统的核心称为虚拟机监控程序(virtual machine monitor),它在裸机上运行并且具备了多道程序功能。该系统向上层提供了若干台虚拟机,如图1-28所示。它不同于其他操作系统的地方是:这些虚拟机不是那种具有文件等优良特征的扩展计算机。与之相反,它们仅仅是裸机硬件的精确复制品。这个复制品包含了内核态/用户态、I/O功能、中断及其他真实硬件所应该具有的全部内容。

图 1-28 配有CMS的VM/370结构

由于每台虚拟机都与裸机相同,所以在每台虚拟机上都可以运行一台裸机所能够运行的任何类型的操作系统。不同的虚拟机可以运行不同的操作系统,而且实际上往往就是如此。在早期的VM/370系统上,有一些系统运行OS/360或其他大型批处理或事务处理操作系统中的某一个,而另一些虚拟机运行单用户、交互式系统供分时用户们使用,这个系统称为会话监控系统(Conversational Monitor System,CMS)。后者在程序员中很流行。

当一个CMS程序执行系统调用时,该调用被陷入到其虚拟机的操作系统上,而不是VM/370上,似乎它运行在实际的机器上,而不是在虚拟机上。CMS然后发出普通的硬件I/O指令读出虚拟磁盘或其他需要执行的调用。这些I/O指令由VM/370陷入,然后,作为对实际硬件模拟的一部分,VM/370完成指令。通过对多道程序功能和提供扩展机器二者的完全分离,每个部分都变得非常简单,非常灵活且容易维护。

虚拟机的现代化身,z/VM,通常用于运行多个完整的操作系统,而不是简化成如CMS一样的单用户系统。例如,zSeries有能力随着传统的IBM操作系统一起,运行一个或多个Linux虚拟机。

2.虚拟机的再次发现

IBM拥有虚拟机产品已经有四十年了,而有少数公司,包括Sun Microsystems公司和Hewlett-Packard等公司,近来也在他们的高端企业服务器上增加对虚拟机的支持,在PC机上,直到最近之前,虚拟化的思想在很大程度上被忽略了。不过近年来,新的需求,新的软件和新的技术的结合已经使得虚拟机成为一个热点。

首先看需求。传统上,许多公司在不同的计算机上,有时还在不同的操作系统上,运行其邮件服务器、Web服务器、FTP服务器以及其他服务器。他们看到虚拟化可以使他们在同一台机器上运行所有的服务器,而不会由于一个服务器崩溃,就影响其余的系统。

虚拟化在Web托管世界里也很流行。没有虚拟化,Web托管客户端只能共享托管(在Web服务器上给客户端一个账号,但是不能控制整个服务器软件)以及独占托管(提供客户端整个机器,这样虽然很灵活,但是对于小型或中型Web站点而言,成本效益比不高)。当Web托管公司提供租用虚拟机时,一台物理机器就可以运行许多虚拟机,每个虚拟机看起来都是一台完全的机器。租用虚拟机的客户端可以运行自己想使用的操作系统和软件,但是只要支付独占一台机器的几分之一的费用(因为同一台物理机器可以同时支持多台虚拟机)。

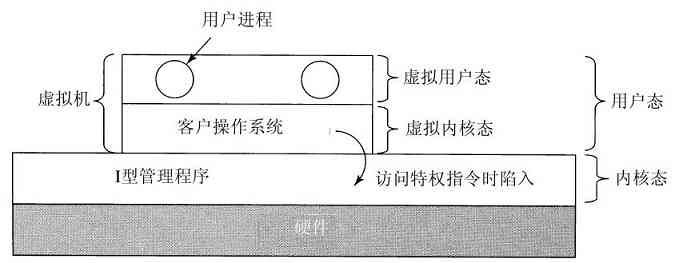

虚拟化的另外一个用途是,为希望同时运行两个或多个操作系统,比如Windows和Linux的最终用户服务,某个偏好的应用程序可运行在一个操作系统上,而其他的应用程序可运行在不同的操作系统上。如图1-29a所示的情形,而术语“虚拟机监控程序”近年来已经变化成类型1虚拟机管理程序(type 1 hypervisor)。

图 1-29 a)类型1虚拟机管理程序;b)类型2虚拟机管理程序

现在考察软件。虚拟机的吸引力是没有争议的,问题在于实现。为了在一台计算机上运行虚拟机软件,其CPU必须被虚拟化(Popek和Goldberg,1974)。不过在外壳中,存在一些问题。当运行虚拟机(在用户态中)的操作系统执行某个特权指令时,比如修改PSW或进行I/O操作,硬件实际上陷入到了虚拟机中,这样有关指令就可以在软件中模拟。在某些CPU上(特别是Pentium和它的后继者,以及其克隆版中)试图在用户态中执行特权指令时,会被忽略掉。这样一种特性,使得在这类硬件中无法实现虚拟机,这也解释了PC机世界中,缺乏对虚拟机兴趣的原因。当然,对于Pentium而言,还有解释器可以运行在Pentium上,但是其性能丧失了5~10倍,这样对于要求高的工作来说,就没有意义了。

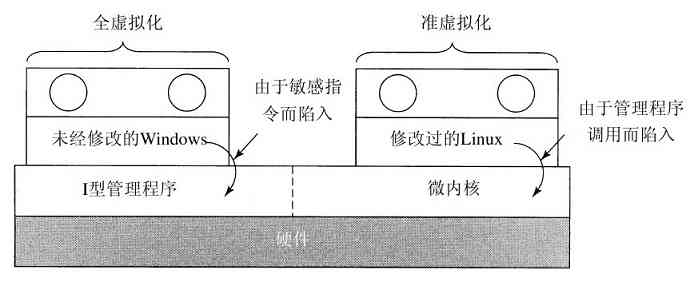

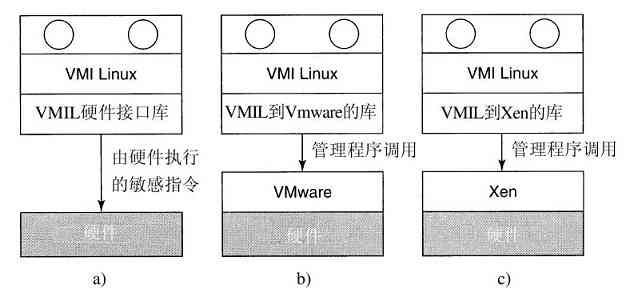

由于20世纪90年代若干学术研究小组的努力,特别是斯坦福大学的Disco(Bugnion等人,1997),实现了商业化产品(例如VMware工作站),人们对虚拟机的热情复兴了。VMware工作站是类型2虚拟机管理程序,如图1-29b所示。与运行在裸机上的类型1虚拟机管理程序不同,类型2虚拟机管理程序作为一个应用程序运行在Windows、Linux或其他操作系统上,这些系统称为宿主机操作系统。在类型2管理程序启动后,它从CD-ROM安装盘中读入供选择的客体操作系统,并安装在一个虚拟盘上,该盘实际只是宿主机操作系统文件系统中的一个大文件。

在客户端操作系统启动时,它完成在真实硬件上相同的工作,如启动一些后台进程,然后是GUI。某些管理程序一块一块地翻译客户端操作系统的二进制程序,代替含有管理程序调用的特定控制指令。翻译后的块可以立即执行,或者缓存起来供后续使用。

处理控制指令的一种不同方式是,修改操作系统,删掉它们。这种方式不是真正虚拟化,而是准虚拟化(paravirtualization)。我们将在第8章具体讨论虚拟化。

3.Java虚拟机

1.7.6 外核

与虚拟机克隆真实机器不同,另一种策略是对机器进行分区,换句话说,给每个用户整个资源的一个子集。这样,某一个虚拟机可能得到磁盘的0至1023盘块,而另一台虚拟机会得到1024至2047盘块,等等。

在底层中,一种称为外核(exokernel,Engler等人,1995)的程序在内核态中运行。它的任务是为虚拟机分配资源,并检查试图使用这些资源的企图,以确保没有机器会使用他人的资源。每个用户层的虚拟机可以运行自己的操作系统,如VM/370和Pentium虚拟8086等,但限制在只能使用已经申请并且获得分配的那部分资源。

外核机制的优点是,它减少了映像层。在其他的设计中,每个虚拟机都认为它有自己的磁盘,其盘块号从0到最大编号,这样虚拟机监控程序必须维护一张表格用以重映像磁盘地址(以及其他资源)。有了外核这个重映像处理就不需要了。外核只需要记录已经分配给各个虚拟机的有关资源即可。这个方法还有一个优点,它将多道程序(在外核内)与用户操作系统代码(在用户空间内)加以分离,而且相应负载并不重,这是因为外核所做的一切,只是保持多个虚拟机彼此不发生冲突。

1.8 依靠C的世界

操作系统通常是由许多程序员写成的,包括很多部分的大型C(有时是C++)程序。用于开发操作系统的环境,与个人(如学生)用于编写小型Java程序的环境是非常不同的。本节试图为那些有时编写Jave的程序员简要地介绍编写操作系统的环境。

1.8.1 C语言

本部分不是C语言的指南,而是一个有关C和Java之间的关键差别的简要介绍。Java是基于C的,所以两者之间有许多类似之处。两者都是命令式的语言,例如,有数据类型、变量和控制语句等。在C中基本数据类型是整数(包括短整数和长整数)、字符和浮点数等。使用数组、结构体和联合,可以构造组合数据类型。C语言中的控制语句与Java类似,包括if、switch、for以及while等语句。在这两个语言中,函数和参数大致相同。

一项C语言中有的而Java中没有的特点是显式指针(explicit pointer)。指针是一种指向(即包含对象的地址)一个变量或数据结构的变量。考虑下面的语句

char c1,c2,*p;

c1=‘c’;

p=&c1;

c2=*p;

这些语句声明c1和c2是字符变量,而p是指向一个字符的变量(即包含字符的地址)。第一个赋值语句将字符c的ASCII代码存到变量c1中。第二个语句将c1的地址赋给指针变量p。第三个语句将由p指向变量的内容赋给变量c2,这样,在这些语句执行之后,c2也含有c的ASCII代码。在理论上,指针是输入类型,所以不能将浮点数地址赋给一个字符指针,但是在实践中,编译器接受这种赋值,尽管有时给出一个警告。指针是一种非常强大的结构,但是如果不仔细使用,也会是造成大量错误的一个原因。

C语言中没有的包括内建字符串、线程、包、类、对象、类型安全(type safety)以及垃圾回收(garbage collection)等。最后这一个是操作系统的一个“淋浴器塞子”。在C中分配的存储空间或者是静态的,或者是程序员明确分配和释放的,通常使用malloc以及free库函数。正是由于后面这个性质——全部由程序员控制所有内存——而且是用明确的指针,使得C语言对编写操作系统而言非常有吸引力。操作系统从一定程度上来说,实际上是个实时系统,即便通用系统也是实时系统。当中断发生时,操作系统可能只有若干微秒去完成特定的操作,否则就会丢失关键的信息。在任意时刻启动垃圾回收功能是不可接受的。

1.8.2 头文件

一个操作系统项目通常包括多个目录,每个目录都含有许多.c文件,这些文件中存有系统某个部分的代码,而一些.h头文件则包含供一个或多个代码文件使用的声明以及定义。头文件还可以包括简单的宏,诸如

#define BUFFER_SIZE 4096

宏允许程序员命名常数,这样在代码中出现的BUFFER_SIZE,在编译时该常数就被数值4096所替代。良好的C程序设计实践应该除了0,1和-1之外命名所有的常数,有时把这三个数也进行命名。宏可以附带参数,例如

#define max(a,b)(a>b?a:b)

这个宏允许程序员编写

i=max(j,k+1)

从而得到

i=(j>k+1?j:k+1)

将j与k+1之间的较大者存储在i中。头文件还可以包含条件编译,例如

#ifdef PENTIUM

intel_int_ack();

#endif

如果宏PENTIUM有定义,而不是其他,则编译进对intel_int_ack函数的调用。为了分割与结构有关的代码,大量使用了条件编译,这样只有当系统在Pentium上编译时,一些特定的代码才会被插入,其他的代码仅当系统在SPARC等机器上编译时才会插入。通过使用#include指令,一个.c文件体可以含有零个或多个头文件。

1.8.3 大型编程项目

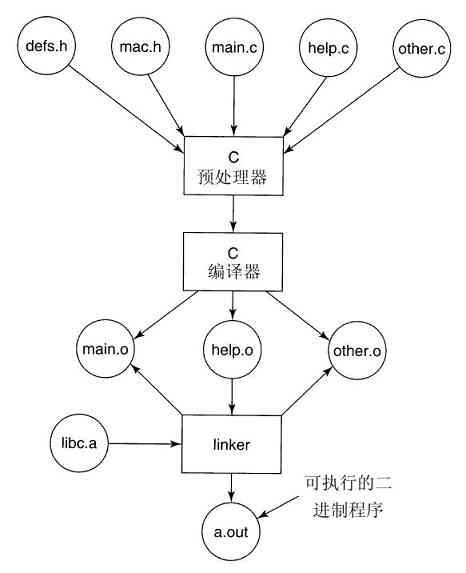

为了构建操作系统,每个.c被C编译器编译成一个目标文件。目标文件使用后缀.o,含有目标机器的二进制代码。它们可以随后直接在CPU上运行。在C的世界里,没有类似于Java字节代码的东西。

C编译器的第一道称为C预处理器。在它读入每个.c文件时,每当遇到一个#include指令,它就取来该名称的头文件,并加以处理、扩展宏、处理条件编译(以及其他事务),然后将结果传递给编译器的下一道,仿佛它们原先就包含在该文件中一样。

由于操作系统非常大(五百万行代码是很寻常的),每当文件修改后就重新编译是不能忍受的。另一方面,改变了用在成千个文件中的一个关键头文件,确实需要重新编译这些文件。没有一定的协助,要想记录哪个目标文件与哪个头文件相关是完全不可行的。

幸运的是,计算机非常善于处理事务分类。在UNIX系统中,有个名为make的程序(其大量的变体如gmake、pmake等),它读入Makefile,该Makefile说明哪个文件与哪个文件相关。make的作用是,在构建操作系统二进制码时,检查此刻需要哪个目标文件,而且对于每个文件,检查自从上次目标文件创建之后,是否有任何它依赖(代码和头文件)的文件已经被修改了。如果有,目标文件需要重新编译。在make确定了哪个.o文件需要重新编译之后,它调用C编译器重新编译这些文件,这样,就把编译的次数减少到最低限度。在大型项目中,创建Makefile是一件容易出错的工作,所以出现了一些工具使该工作能够自动完成。

一旦所有的.o文件都已经就绪,这些文件被传递给称为linker的程序,将其组合成一个单个可执行的二进制文件。此时,任何被调用的库函数都已经包含在内,函数之间的引用都已经解决,而机器地址也都按需要分配完毕。在linker完成之后,得到一个可执行程序,在UNIX中传统上称为a.out文件。这个过程中的各种部分如图1-30所示,图中的一个程序包含三个C文件,两个头文件。这里虽然讨论的是有关操作系统的开发,但是所有内容对开发任何大型程序而言都是适用的。

图 1-30 编译C和头文件,构建可执行文件的过程

1.8.4 运行模型

在操作系统二进制代码链接完成后,计算机就可以重新启动,新的操作系统开始运行。一旦运行,系统会动态调入那些没有静态包括在二进制代码中的模块,诸如设备驱动和文件系统。在运行过程中,操作系统可能由若干段组成,有文本段(程序代码)、数据段和堆栈段。文本段通常是不可改变的,在运行过程中不可修改。数据段开始时有一定的大小,并用确定的值进行初始化,但是随后就被修改了,其大小随需要增长。堆栈段被初始化为空,但是随着对函数的调用和从函数返回,堆栈段时时刻刻在增长和缩小。通常文本段放置在接近内存底部的位置,数据段在其上面,这样可以向上增长。而堆栈段处在高位的虚拟地址,具有向下增长的能力,不过不同系统的工作方式各有差别。

在所有情形下,操作系统代码都是直接在硬件上执行的,不用解释器,也不是即时编译,如Java通常做的那样。

1.9 有关操作系统的研究

计算机科学是快速发展的领域,很难预测其下一步的发展方向。在大学和产业研究实验室中的研究人员们始终在思考新的思想,这些新思想中的某一些内容并没有什么用处,但是有些新思想会成为未来产品的基石,并对产业界和用户产生广泛的影响。当然,事后解说什么是什么要比在当时说明容易得多。将小麦从稗子中分离出来是非常困难的,因为一种思想从出现到形成影响常常需要20~30年。

例如,当艾森豪威尔总统在1958年建立国防部高级研究项目署(ARPA)时,他试图通过五角大楼的研究预算来削弱海军和空军并维护陆军的地位。他并不是想要发明Internet。但是ARPA做的一件事是给予一些大学资助,用以研究模糊不清的包交换概念,这个研究很快导致了第一个实验包交换网的建立,即ARPANET。该网在1969年启用。没有多久,其他被ARPA资助的研究网络也连接到ARPANET上,于是Internet诞生了。Internet愉快地为学术研究人员们互相发送了20年的电子邮件。到了20世纪90年代早期,Tim Berners-Lee在日内瓦的CERN研究所发明了万维网(World Wide Web),而Marc Andreesen在伊利诺伊大学为万维网写了一个图形浏览器。突然地,Internet上充满了年青人的聊天活动。在知道了这一切之后,艾森豪威尔总统可能气得在他的坟墓中打滚呢。

对操作系统的研究也导致了实际操作系统的戏剧性变化。正如我们较早所讨论的,第一代商用计算机系统都是批处理系统,直到20世纪60年代早期M.I.T.发明了交互式分时系统为止。20世纪60年代后期,即在Doug Engelbart于斯坦福研究院发明鼠标和图形用户接口之前,所有的计算机都是基于文本的。有谁会知道下一个发明将会是什么呢?

在本小节和本书中相关的其他章节中,我们会简要地介绍一些在过去5至10年中操作系统的研究工作,这是为了让读者了解可能会出现什么。这个介绍当然不全面,而且主要依据在高水平的期刊和会议上已经发表的文章,因为这些文章为了得以发表至少需要通过严格的同行评估过程。在有关研究内容一节中所引用的多数文章,它们或者发表在ACM刊物、IEEE计算机协会刊物或者USENIX刊物上,并对这些组织的(学生)成员们在Internet上开放。有关这些组织的更多信息以及它们的数字图书馆,可以访问:

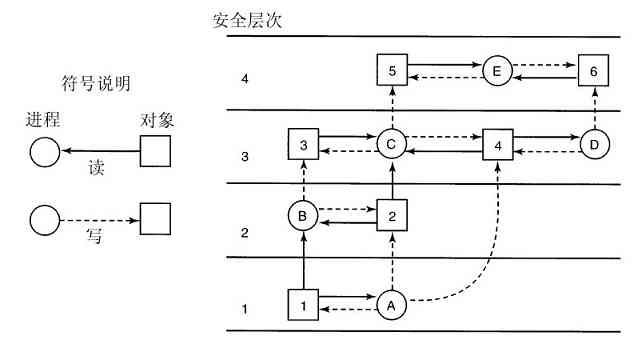

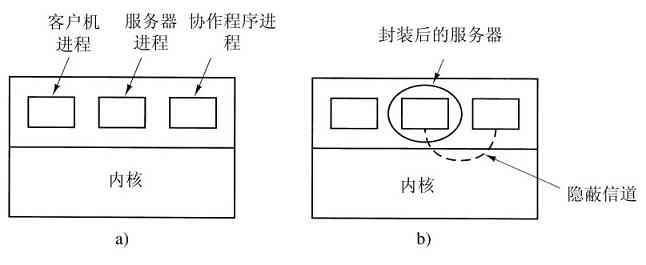

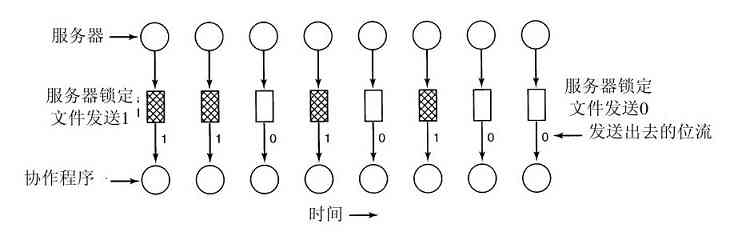

实际上,所有的操作系统研究人员都认识到,目前的操作系统是一个大的、不灵活、不可靠、不安全和带有错误的系统,而且特定的某个操作系统较其他的系统有更多的错误(这里略去了名称以避免责任)。所带来的结果是,大量的研究集中于如何构造更好的操作系统。近来出版的文献有如下一些,关于新操作系统(Krieger等人,2006),操作系统结构(Fassino等人,2002),操作系统正确性(Elphinstone等人,2007;Kumar和Li,2002;Yang等人,2006),操作系统可靠性(Swift等人,2006;LeVasseur等人,2004),虚拟机(Barham等人,2003;Garfinkel等人,2003;King等人,2003;Whitaker等人,2002),病毒和蠕虫(Costa等人,2005;Portokalidis等人,2006;Tucek等人,2007;Vrable等人,2005),错误和排错(Chou等人,2001;King等人,2005),超线程与多线程(Fedorova,2005;Bulpin和Pratt,2005),用户行为(Yu等人,2006),以及许多其他课题。

1.10 本书其他部分概要

我们已经叙述完毕引论,并且描绘了鸟瞰式的操作系统图景。现在是进入具体细节的时候了。正如前面已经叙述的,从程序员的观点来看,操作系统的基本目的是提供一些关键的抽象,其中最重要的是进程和线程、地址空间以及文件。所以后面三章都是有关这些关键主题的。

第2章讨论进程与线程,包括它们的性质以及它们之间如何通信。这一章还给出了大量关于进程间如何通信的例子以及如何避免某些错误。

第3章具体讨论地址空间以及关联的内存管理。讨论虚拟内存等重要课题,以及相关的概念,如页面处理和分段等。

第4章里,我们会讨论有关文件系统的所有重要内容。在某种程度上,用户大量看到的是文件系统。我们将研究文件系统接口和文件系统的实现。

输入/输出是第5章的内容。这一章介绍设备独立性和设备依赖性的概念。将把若干重要的设备,包括磁盘、键盘以及显示设备作为示例讲解。

第6章讨论死锁。在这一章中我们概要地说明什么是死锁,不过这章里有大量的内容需要介绍。还讨论了避免死锁的方法。

到此,我们完成了对单CPU操作系统基本原理的学习。不过,还有更多的高级内容要叙述。在第7章里,我们将了解多媒体系统,这类系统的大量特性和要求与传统的操作系统存在着差别。而在其他的篇幅里,我们会讨论多媒体的本质对调度处理和文件系统的影响。另一个高级课题是多处理器系统,包括多处理器、并行计算机以及分布式系统。这些内容放在第8章中讨论。

有一个非常重要的主题,就是操作系统安全,它是第9章的内容。在这一章中讨论的内容涉及威胁(例如,病毒和蠕虫)、保护机制以及安全模型。

随后,我们安排了一些实际操作系统的案例。它们是Linux(第10章)、Windows Vista(第11章)以及Symbian(第12章)。本书以第13章关于操作系统设计的一些思考作为结束。

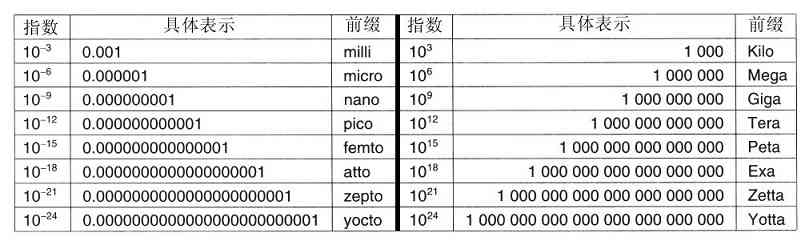

1.11 公制单位

为了避免混乱,有必要在本书中特别指出,考虑到计算机科学的通用性,所以我们采用公制以代替传统的英制。在图1-31中列出了主要的公制前缀。前缀用首字缩写而成,凡是单位大于1的首字母均大写。这样,一个1TB的数据库占据了1012 字节的存储空间,而100 psec(或100ps)的时钟每隔10-10 s的时间滴答一次。由于milli和micro均以字母“m”开头,所以必须作出区分两者的选择。通常,用“m”表示milli,而用“µ”(希腊字母mu)表示micro。

图 1-31 主要的公制前缀

这里需要说明的还有关于存储器容量的度量,在通常的工业实践中,各个单位的含义稍有不同。这里Kilo表示210 (1024)而不是103 (1000),因为存储器总是2的幂。这样1KB存储器就有1024个字节,而不是1000个字节。类似地,1MB存储器有220 (1 048 576)个字节,1GB存储器有230 (1 073 741 824)个字节。但是,1Kbps的通信线路每秒传送1000个位,而10Mbps的局域网在10 000 000位/秒的速率上运行,因为这里的速率不是2的幂。很不幸,许多人倾向于将这两个系统混淆,特别是混淆关于磁盘容量的度量。在本书中,为了避免含糊,我们使用KB、MB和GB分别表示210 字节220 字节和230 字节,而用符号Kbps、Mbps和Gbps分别表示103 bps、106 bps和109 bps。

1.12 小结

考察操作系统有两种观点:资源管理观点和扩展的机器观点。在资源管理的观点中,操作系统的任务是有效地管理系统的各个部分。在扩展的机器观点中,系统的任务是为用户提供比实际机器更便于运用的抽象。这些抽象包括进程、地址空间以及文件。

操作系统的历史很长,从操作系统开始替代操作人员的那天开始,到现代多道程序系统,主要包括早期批处理系统、多道程序系统以及个人计算机系统。

由于操作系统同硬件的交互密切,掌握一些硬件知识对于理解它们是有益的。计算机由处理器、存储器以及I/O设备组成。这些部件通过总线连接。

所有操作系统构建所依赖的基本概念是进程、存储管理、I/O管理、文件管理和安全。这些内容都将用后续的一章来讲述。

任何操作系统的核心是它可处理的系统调用集。这些系统调用真实地说明了操作系统所做的工作。对于UNIX,我们已经考察了四组系统调用。第一组系统调用同进程的创建和终结有关;第二组用于读写文件;第三组用于目录管理;第四组包括各种杂项调用。

操作系统构建方式有多种。最常见的有单体系统、层次化系统、微内核系统、客户机-服务器系统、虚拟机系统和外核系统。

习题

1.什么是多道程序设计?

2.什么是SPOOLing?读者是否认为将来的高级个人计算机会把SPOOLing作为标准功能?

3.在早期计算机中,每个字节的读写直接由CPU处理(即没有DMA)。对于多道程序而言这种组织方式有什么含义?

4.系列计算机的思想在20世纪60年代由IBM引入进System/360大型机。现在这种思想已经消亡了还是继续活跃着?

5.缓慢采用GUI的一个原因是支持它的硬件的成本(高昂)。为了支持25行80列字符的单色文本屏幕应该需要多少视频RAM?对于1024×768像素24位色彩位图需要多少视频RAM?在1980年($5/KB)这些RAM的成本是多少?现在它的成本是多少?

6.在建立一个操作系统时有几个设计目的,例如资源利用、及时性、健壮性等。请列举两个可能互相矛盾的设计目的。

7.下面的哪一条指令只能在内核态中使用?

a)禁止所有的中断。

b)读日期-时间时钟。

c)设置日期-时间时钟。

d)改变存储器映像。

8.考虑一个有两个CPU的系统,并且每一个CPU有两个线程(超线程)。假设有三个程序P0,P1,P2,分别以运行时间5ms,10ms,20ms开始。运行这些程序需要多少时间?假设这三个程序都是100%限于CPU,在运行时无阻塞,并且一旦设定就不改变CPU。

9.一台计算机有一个四级流水线,每一级都花费相同的时间执行其工作,即1ns。这台机器每秒可执行多少条指令?

10.假设一个计算机系统有高速缓存、内存(RAM)以及磁盘,操作系统用虚拟内存。读取缓存中的一个词需要2ns,RAM需要10ns,磁盘需要10ms。如果缓存的命中率是95%,内存的是(缓存失效时)99%,读取一个词的平均时间是多少?

11.一位校对人员注意到在一部将要出版的操作系统教科书手稿中有一个多次出现的拼写错误。这本书大致有700页。每页50行,一行80个字符。若把文稿用电子扫描,那么,主副本进入图1-9中的每个存储系统的层次要花费多少时间?对于内存储方式,考虑所给定的存取时间是每次一个字符,对于磁盘设备,假定存取时间是每次一个1024字符的盘块,而对于磁带,假设给定开始时间后的存取时间和磁盘存取时间相同。

12.在用户程序进行一个系统调用,以读写磁盘文件时,该程序提供指示说明了所需要的文件,一个指向数据缓冲区的指针以及计数。然后,控制权转给操作系统,它调用相关的驱动程序。假设驱动程序启动磁盘并且直到中断发生才终止。在从磁盘读的情况下,很明显,调用者会被阻塞(因为文件中没有数据)。在向磁盘写时会发生什么情况?需要把调用者阻塞一直等到磁盘传送完成为止吗?

13.什么是陷阱指令?在操作系统中解释它的用途。

14.陷阱和中断的主要差别是什么?

15.在分时系统中为什么需要进程表?在只有一个进程存在的个人计算机系统中,该进程控制整个机器直到进程结束,这种机器也需要进程表吗?

16.说明有没有理由要在一个非空的目录中安装一个文件系统?如果要这样做,如何做?

17.在一个操作系统中系统调用的目的是什么?

18.对于下列系统调用,给出引起失败的条件:fork、exec以及unlink。

19.在

count=write(fd,buffer,nbytes);

调用中,能在count中而不是nbytes中返回值吗?如果能,为什么?

20.有一个文件,其文件描述符是fd,内含下列字节序列:3,1,4,1,5,9,2,6,5,3,5。有如下系统调用:

lseek(fd,3,SEEK_SET);

read(fd,&buffer,4);

其中lseek调用寻找文件中的字节3。在读操作完成之后,buffer中的内容是什么?

21.假设一个10MB的文件存在磁盘连续扇区的同一个轨道上(轨道号:50)。磁盘的磁头臂此时位于第100号轨道。要想从磁盘上找回这个文件,需要多长时间?假设磁头臂从一个柱面移动到下一个柱面需要1ms,当文件的开始部分存储在的扇区旋转到磁头下需要5ms,并且读的速率是100MB/s。

22.块特殊文件和字符特殊文件的基本差别是什么?

23.在图1-17的例子中库调用称为read,而系统调用自身称为read。这两者都有相同的名字是正常的吗?如果不是,哪一个更重要?

24.在分布式系统中,客户机-服务器模式很普遍。这种模式能用在单个计算机的系统中吗?

25.对程序员而言,系统调用就像对其他库过程的调用一样。有无必要让程序员了解哪一个库过程导致了系统调用?在什么情形下,为什么?

26.图1-23说明有一批UNIX的系统调用没有与之相等价的Win32 API。对于所列出的每一个没有Win32等价的调用,若程序员要把一个UNIX程序转换到Windows下运行,会有什么后果?

27.可移植的操作系统是能从一个系统体系结构到另一个体系结构的移动不需要任何修改的操作系统。请解释为什么建立一个完全可移植性的操作系统是不可行的。描述一下在设计一个高度可移植的操作系统时你设计的高级的两层是什么样的。

28.请解释在建立基于微内核的操作系统时策略与机制的分离带来的好处。

29.下面是单位转换的练习:

a)一微年是多少秒?

b)微米常称为micron。那么gigamicron是多长?

c)1TB存储器中有多少字节?

d)地球的质量是6000 yottagram,换算成kilogram是多少?

30.写一个和图1-19类似的shell,但是包含足够的实际可工作的代码,这样读者可测试它。读者还可以添加某些功能,如输入输出重定向、管道以及后台作业等。

31.如果读者拥有一个个人UNIX类操作系统(Linux、MINIX、Free BSD等),可以安全地崩溃和再启动,请写一个可以试图创建一个无限制数量子进程的shell脚本并观察所发生的事。在运行实验之前,通过shell键入sync,在磁盘上备好文件缓冲区以避免毁坏文件系统。注意:在没有得到系统管理员的允许之前,不要在分时系统上进行这一尝试。其后果将会立即发生,尝试者可能会被抓住并受到惩罚。

32.用一个类似于UNIX od或MS-DOS DEBUG的程序考察并尝试解释UNIX类系统或Windows的目录。提示:如何进行取决于OS允许做什么。一个有益的技巧是在一个有某个操作系统的软盘上创建一个目录,然后使用一个允许进行此类访问的不同的操作系统读盘上的原始数据。

第2章 进程与线程

从本章开始我们将深入考察操作系统是如何设计和构造的。操作系统中最核心的概念是进程:这是对正在运行程序的一个抽象。操作系统的其他所有内容都是围绕着进程的概念展开的,所以,让操作系统的设计者(及学生)尽早并透彻地理解进程是非常重要的。

进程是操作系统提供的最古老的也是最重要的抽象概念之一。即使可以利用的CPU只有一个,但它们也支持(伪)并发操作的能力。它们将一个单独的CPU变换成多个虚拟的CPU。没有进程的抽象,现代计算将不复存在。在本章里我们会通过大量的细节去探究进程,以及它们的第一个亲戚——线程。

2.1 进程

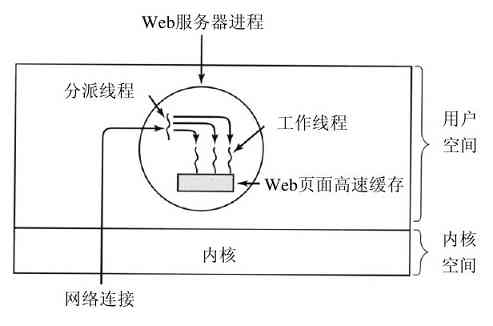

所有现代的计算机经常会在同一时间做许多件事。习惯于在个人计算机上工作的人们也许不会十分注意这个事实,因此列举一些例子可以更清楚地说明这一问题。先考虑一个网络服务器。从各处进入一些网页请求。当一个请求进入时,服务器检查是否其需要的网页在缓存中。如果是,则把网页发送回去;如果不是,则启动一个磁盘请求以获取网页。然而,从CPU的角度来看,磁盘请求需要漫长的时间。当等待磁盘请求完成时,其他更多的请求将会进入。如果有多个磁盘存在,会在满足第一个请求之前就接二连三地对其他的磁盘发出一些或所有的请求。很明显,需要一些方法去模拟并控制这种并发。进程(特别是线程)在这里就可以产生作用。

现在考虑只有一个用户的PC。一般用户不知道,当启动系统时,会秘密启动许多进程。例如,启动一个进程用来等待进入的电子邮件;或者启动另一个防病毒进程周期性地检查是否有新的有效的病毒定义。另外,某个用户进程也许会在所有用户上网的时候打印文件以及烧录CD-ROM。所有的这些活动需要管理,于是一个支持多进程的多道程序系统在这里就显得很有用了。

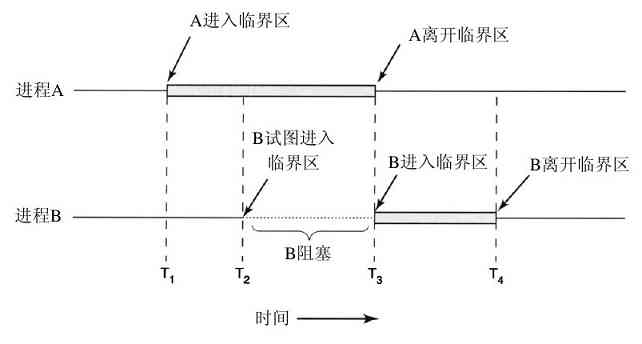

在任何多道程序设计系统中,CPU由一个进程快速切换至另一个进程,使每个进程各运行几十或几百个毫秒。严格地说,在某一个瞬间,CPU只能运行一个进程。但在1秒钟期间,它可能运行多个进程,这样就产生并行的错觉。有时人们所说的伪并行就是指这种情形,以此来区分多处理器系统(该系统有两个或多个CPU共享同一个物理内存)的真正硬件并行。人们很难对多个并行活动进行跟踪。因此,经过多年的努力,操作系统的设计者发展了用于描述并行的一种概念模型(顺序进程),使得并行更容易处理。有关该模型、它的使用以及它的影响正是本章的主题。

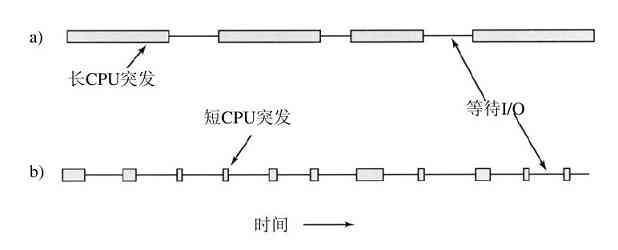

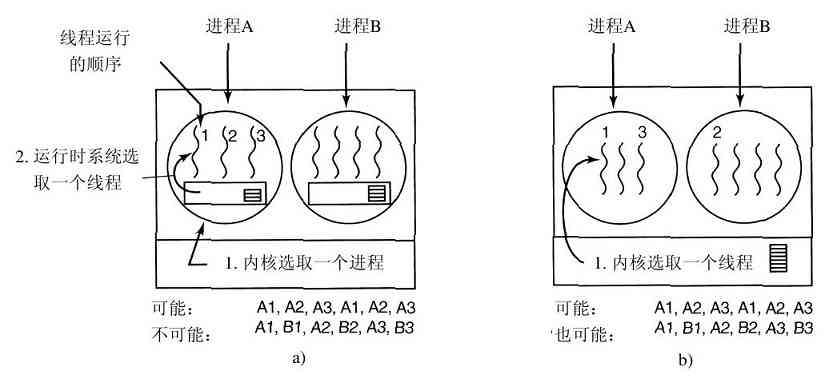

2.1.1 进程模型

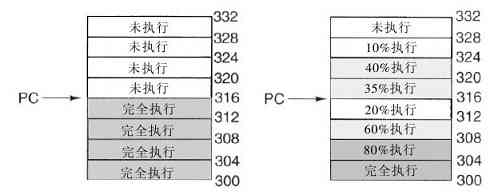

在进程模型中,计算机上所有可运行的软件,通常也包括操作系统,被组织成若干顺序进程(sequential process),简称进程(process)。一个进程就是一个正在执行程序的实例,包括程序计数器、寄存器和变量的当前值。从概念上说,每个进程拥有它自己的虚拟CPU。当然,实际上真正的CPU在各进程之间来回切换。但为了理解这种系统,考虑在(伪)并行情况下运行的进程集,要比我们试图跟踪CPU如何在程序间来回切换简单得多。正如在第1章所看到的,这种快速的切换称作多道程序设计。

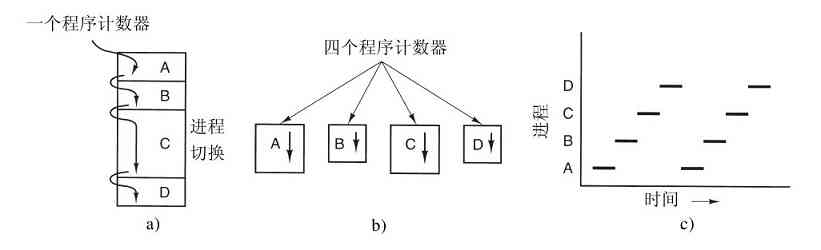

在图2-1a中我们看到,在一台多道程序计算机的内存中有4道程序。在图2-1b中,这4道程序被抽象为4个各自拥有自己控制流程(即每个程序自己的逻辑程序计数器)的进程,并且每个程序都独立地运行。当然,实际上只有一个物理程序计数器,所以在每个程序运行时,它的逻辑程序计数器被装入实际的程序计数器中。当该程序执行结束(或暂停执行)时,物理程序计数器被保存在内存中该进程的逻辑程序计数器中。在图2-1c中我们看到,在观察足够长的一段时间后,所有的进程都运行了,但在任何一个给定的瞬间仅有一个进程真正在运行。

图 2-1 a)含有4道程序的多道程序;b)4个独立的顺序进程的概念模型;c)在任意时刻仅有一个程序是活跃的

在本章,我们假设只有一个CPU。然而,逐渐这个假设就不为真了,因为新的芯片经常是多核的,包含2个、4个或更多的CPU。我们将会在第8章介绍多核芯片以及多处理器,但是在现在,一次只考虑一个CPU会更简单一些。因此,当我们说一个CPU只能真正一次运行一个进程的时候,即使有2个核(或CPU),每一个核也只能一次运行一个进程。

由于CPU在各进程之间来回快速切换,所以每个进程执行其运算的速度是不确定的。而且当同一进程再次运行时,其运算速度通常也不可再现。所以,在对进程编程时决不能对时序做任何确定的假设。例如,考虑一个I/O进程,它用流式磁带机恢复备份的文件,它执行一个10 000次的空循环以等待磁带机达到正常速度,然后发出命令读取第一个记录。如果CPU决定在空循环期间切换到其他进程,则磁带机进程可能在第一条记录通过磁头之后还未被再次运行。当一个进程具有此类严格的实时要求时,也就是一些特定事件一定要在所指定的若干毫秒内发生,那么必须采取特殊措施以保证它们一定在这段时间中发生。然而,通常大多数进程并不受CPU多道程序设计或其他进程相对速度的影响。

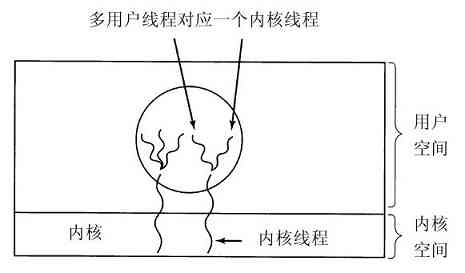

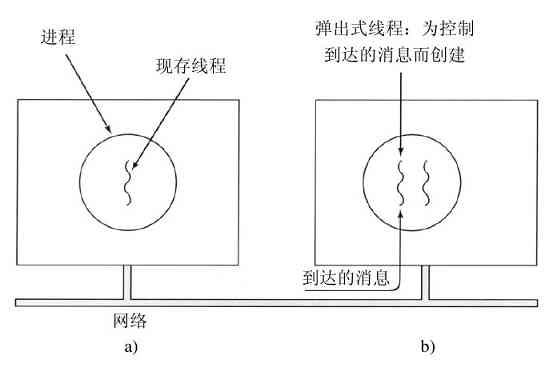

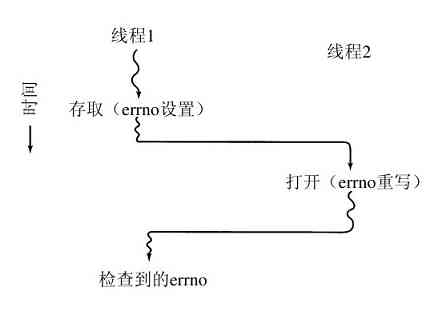

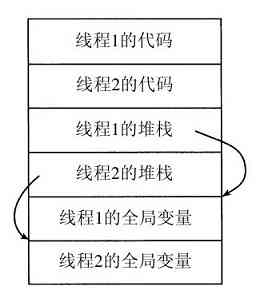

进程和程序间的区别是很微妙的,但非常重要。用一个比喻可以使我们更容易理解这一点。想象一位有一手好厨艺的计算机科学家正在为他的女儿烘制生日蛋糕。他有做生日蛋糕的食谱,厨房里有所需的原料:面粉、鸡蛋、糖、香草汁等。在这个比喻中,做蛋糕的食谱就是程序(即用适当形式描述的算法),计算机科学家就是处理器(CPU),而做蛋糕的各种原料就是输入数据。进程就是厨师阅读食谱、取来各种原料以及烘制蛋糕等一系列动作的总和。